Openshift AI系列3-基于vLLM的模型部署

由于社区的vllm镜像:vllm-openai:v0.6.6.post1启动需要特别的权限,所以需要添加scc anyuid到项目的default SA中。请参考以下步骤进行模型的部署,注意在使用data connection时,可选择使用位于s3或URI类型的模型数据。以下操作在项目中操作,在模型部署前必须先建立data connection来访问模型文件。在minio UI中上传本地镜像目录及

上传模型到s3存储

在minio UI中上传本地镜像目录及文件到对应的bucket中

访问Openshift AI Console

给项目添加权限

由于社区的vllm镜像:vllm-openai:v0.6.6.post1启动需要特别的权限,所以需要添加scc anyuid到项目的default SA中。

如果使用红帽官方的镜像,不需要添加特别的权限scc权限。

|

oc new-project test-ai oc adm policy add-scc-to-user anyuid -z default -n test-ai |

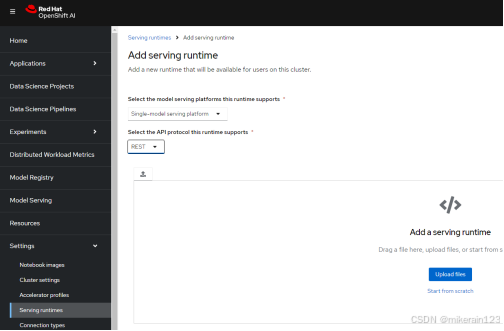

创建vLLM ServingRuntime

此步骤可由集群管理员创建,一般不需要项目组进行频繁操作。

使用以下的yaml文件

|

apiVersion: serving.kserve.io/v1alpha1 kind: ServingRuntime labels: opendatahub.io/dashboard: "true" metadata: annotations: openshift.io/display-name: vLLM-0.6.6 name: vllm-0.6.6 spec: builtInAdapter: modelLoadingTimeoutMillis: 90000 containers: - args: - --model=/mnt/models/ - --download-dir=/models-cache - --port=8080 - --trust-remote-code - --disable-frontend-multiprocessing - --max-model-len=32000 - --served-model-name={{.Name}} - --gpu-memory-utilization=0.95 - --dtype=float16 - --tensor-parallel-size=2 - --quantization=gptq_marlin image: quay.io/qxu/vllm-openai:v0.6.6.post1 name: kserve-container ports: - containerPort: 8080 name: http1 protocol: TCP multiModel: false supportedModelFormats: - autoSelect: true name: pytorch |

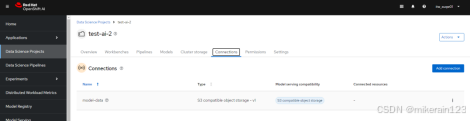

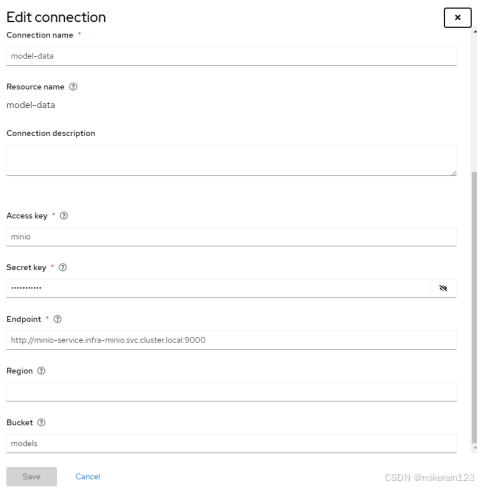

创建Data Connection

data connection用于建立推理环境与模型文件的关联。

以下操作在项目中操作,在模型部署前必须先建立data connection来访问模型文件。

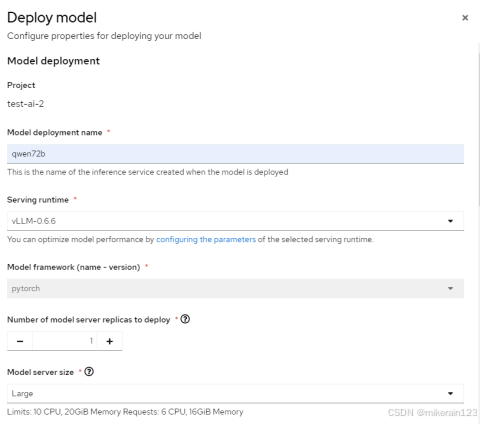

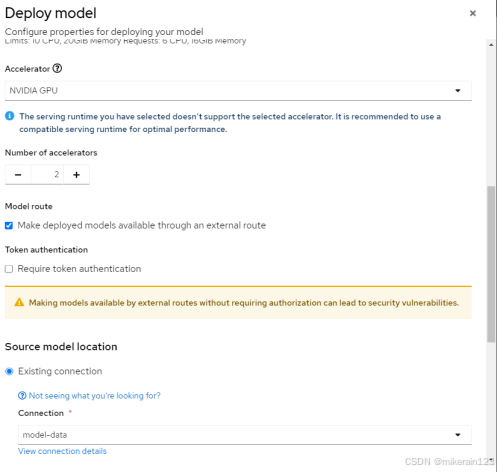

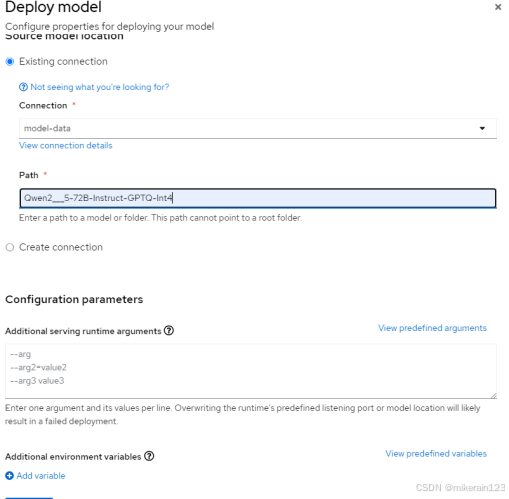

部署模型服务

请参考以下步骤进行模型的部署,注意在使用data connection时,可选择使用位于s3或URI类型的模型数据。

以下操作在项目中执行:

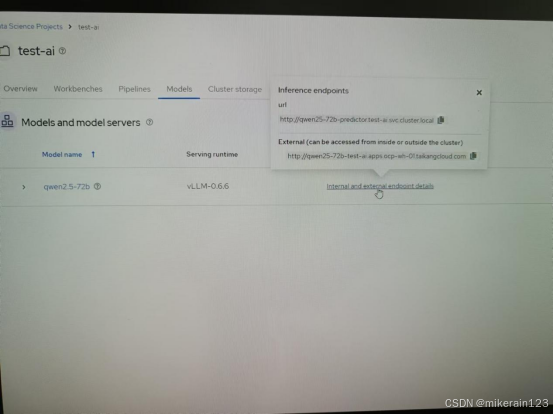

测试访问模型服务

访问模型的外部路由进行测试

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)