一文搞懂MCP协议|AI从单兵作战到团队协作的万能钥匙

MCP(模型上下文协议)是由AI公司Anthropic推出的开源协议,旨在统一大型语言模型(LLM)与外部数据源和工具之间的通信协议,标准化大型语言模型(LLM)与外部数据源、工具的交互方式。简言之,它像一套“交通规则”,让不同AI模型、工具和服务能用同一种“语言”对话,打破数据孤岛,实现动态协作。给大家举一个生活化的例子:想象你指挥一支乐队:小提琴手(语言模型)负责旋律,鼓手(图像模型)把控节奏

————深度解析MCP上下文协议如何重构AI协作生态

“你手机里装了多少个AI客户端?当它们各自为战时,你是否想过,如果这些AI能像团队一样协作,效率会提升多少倍?”

这不仅是开发者的困惑,更是AI技术走向通用智能的关键瓶颈。而今天,一个名为MCP(Model Context Protocol,模型上下文协议)正悄然掀起一场革命,它让AI从“单打独斗”迈向“群体协作”,甚至可能彻底改变我们与机器交互的方式。有人把它比作互联网时代的http协议,也有人说它是Agent领域的万能接口,AI世界的通用于语言。

一、什么是MCP?

MCP(模型上下文协议)是由AI公司Anthropic推出的开源协议,旨在统一大型语言模型(LLM)与外部数据源和工具之间的通信协议,标准化大型语言模型(LLM)与外部数据源、工具的交互方式。简言之,它像一套“交通规则”,让不同AI模型、工具和服务能用同一种“语言”对话,打破数据孤岛,实现动态协作。

给大家举一个生活化的例子:想象你指挥一支乐队:小提琴手(语言模型)负责旋律,鼓手(图像模型)把控节奏,钢琴师(数据分析模型)填充和弦。若没有乐谱和指挥,演奏将杂乱无章。MCP正是这支乐队指挥家手中的指挥棒+乐谱——它用来传递信息告诉大家 演奏什么、谁先演奏、旋律如何衔接等,最终奏响和谐乐章。

主要功能

-

上下文共享:应用程序可以通过 MCP 向模型提供所需的上下文信息(如文件内容、数据库记录等),增强模型的理解能力。

-

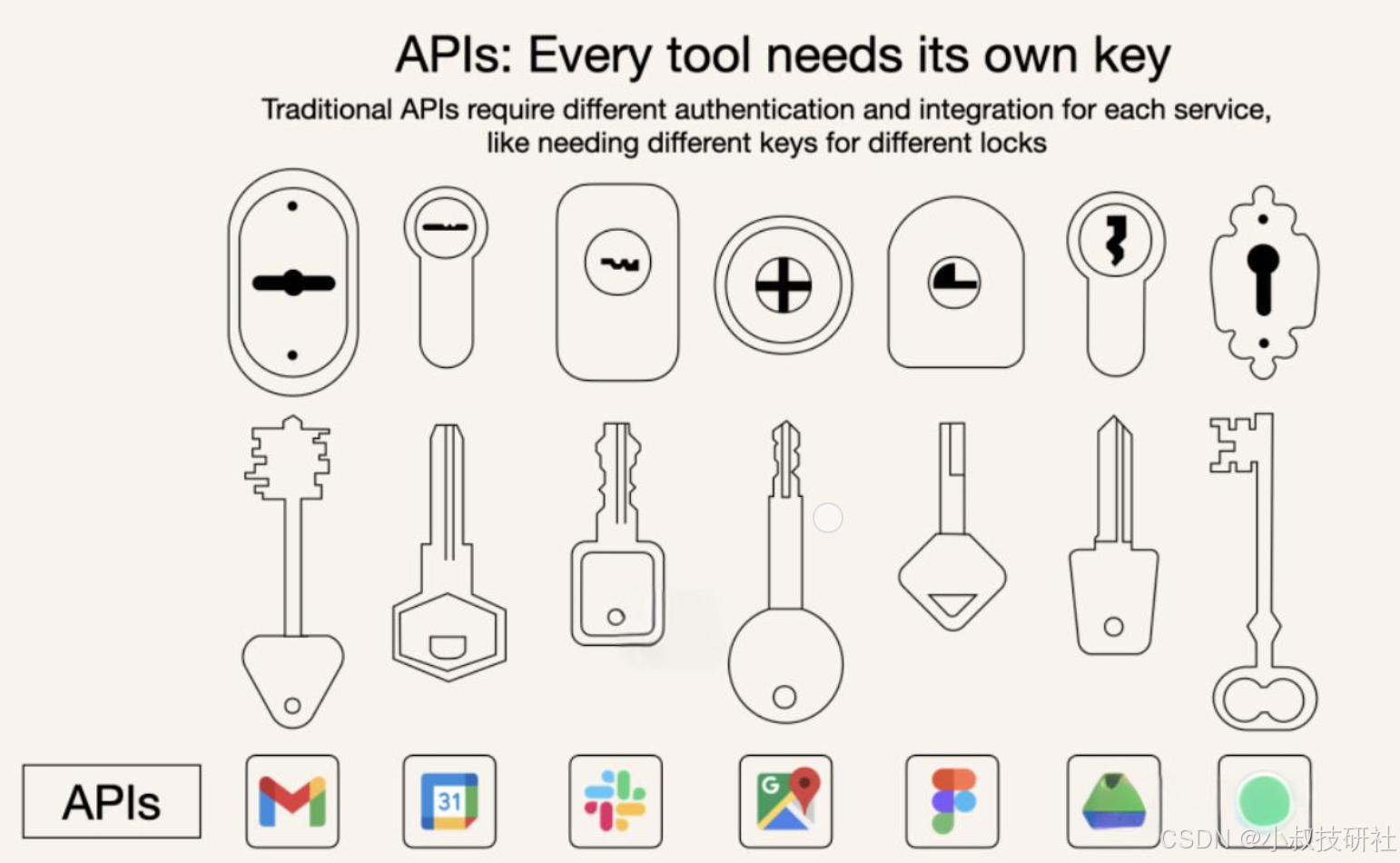

单一协议多工具访问:集成一个 MCP 协议,就可以访问多个工具和服务,而传统 API 需要为每个工具单独集成。

-

动态发现:MCP 允许 AI 模型动态发现和交互可用工具,无需提前知道每个工具的具体接口

-

实时双向通信:MCP 支持持久的实时双向通信,类似于 WebSockets。AI 模型既可以检索信息,也可以动态触发操作。

- 可组合的工作流:开发者可以利用 MCP 集成多个服务和组件,构建灵活、可扩展的 AI 工作流。

- 工具暴露:MCP 允许应用程序将功能(如文件读写、API 调用)暴露给模型,模型可以调用这些工具完成复杂任务。

- 安全性:通过本地服务器运行,MCP 避免将敏感数据上传至第三方平台,确保数据隐私。

MCP 与传统 API 的对比

传统 API 要求开发者为每个服务或数据源编写自定义集成

|

特性 |

MCP |

传统 API |

| 集成工作量 | 单一、标准化集成 | 每个 API 单独集成 |

| 实时通信 | ✅ 是 | ❌ 否 |

| 动态发现 | ✅ 是 | ❌ 否 |

| 可扩展性 |

容易(即插即用) |

需要额外集成 |

| 安全性和控制 | 工具间一致 | 因 API 而异 |

为什么选择 MCP?

- 简化开发:只需编写一次代码,即可集成多个工具和服务,无需为每个工具单独编写代码。

- 灵活性:轻松切换 AI 模型或工具,无需复杂的重新配置。

- 实时响应:MCP 连接始终保持活跃,支持实时上下文更新和交互。

- 安全性和合规性:内置访问控制和标准化的安全实践。

- 可扩展性:随着 AI 生态系统的增长,可以轻松添加新功能,只需连接另一个 MCP 服务器。

三、技术揭秘:MCP如何实现“万能接口”?

MCP架构

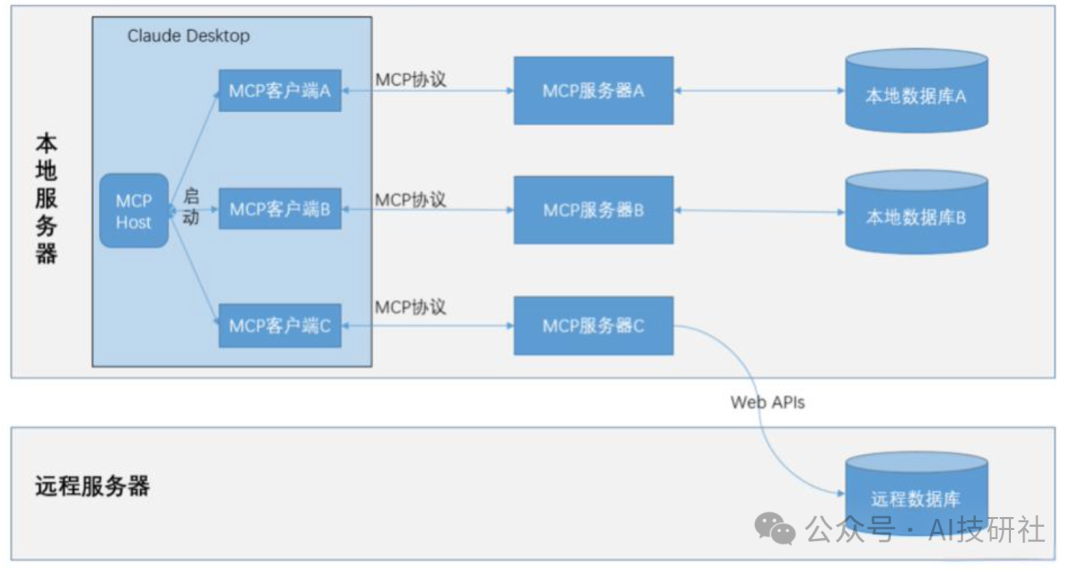

MCP 遵循客户端-服务器架构(client-server)

1. 核心组件

- MCP 主机(MCP Hosts):发起请求的 LLM 应用程序(例如 Claude Desktop、IDE 或 AI 工具)。

- MCP 客户端(MCP Clients):在主机程序内部,与 MCP server 保持 1:1 的连接,内置于模型中的组件,将请求转化为标准协议格式(如JSON-RPC 2.0)。

- MCP 服务器(MCP Servers):连接外部资源的“翻译官”,为 MCP client 提供上下文、工具和 prompt 信息。

- 本地资源(Local Resources):本地计算机中可供 MCP server 安全访问的资源(例如文件、数据库)。

- 远程资源(Remote Resources):MCP server 可以连接到的远程资源(例如通过 API)。

2. 通讯机制

- 本地交互:通过标准输入输出(stdio)直接调用本地服务(如读取文件)。

- 远程交互:基于服务器发送事件 SSE(Server-Sent Events) 实现低延迟通信,支持云端API调用。

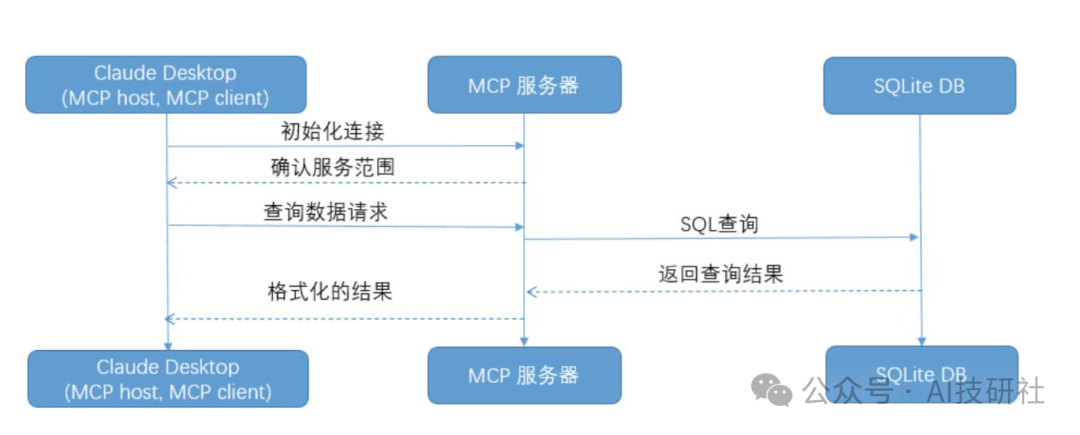

3.MCP 工作流程

- 初始化:主机应用程序启动并初始化客户端,每个客户端与一个服务器建立连接。

- 功能协商:客户端和服务器之间进行功能协商,确定它们可以相互提供哪些功能和服务。

- 请求处理:客户端根据用户请求或AI模型的需要,向服务器发送请求。服务器处理这些请求,并可能与本地或远程资源进行交互。

- 响应返回:服务器将处理结果返回给客户端,客户端再将信息传递回主机应用程序。

三、MCP的实际效果:从理论到生产力的跨越

1. 效率飞跃

-

任务耗时降低:某企业使用MCP集成Claude与内部CRM系统,客户数据分析周期从2小时压缩至10分钟。

-

开发成本锐减:开发者无需为每个模型重复编写API适配代码,资源整合效率提升300%。

2. 跨模态协作典范

以“生成旅游海报”为例:

-

语言模型撰写文案 → 图像模型生成配图 → 设计模型排版合成。

MCP自动传递上下文(如“文案需保留关键词‘浪漫’供配图参考”),避免人工干预导致的信息失真。

3. 生态扩展性

已有超过10种官方MCP Server支持主流服务(GitHub、Google Drive等),社区开发者更贡献了天气查询、股票分析等个性化插件。未来,MCP或将成为AI领域的“应用商店”,实现即插即用

四、挑战与未来:协议之争与生态博弈

尽管MCP潜力巨大,但挑战同样显著:

-

标准化之争:OpenAI、Google、DeepSeek等巨头是否跟进将决定MCP能否成为行业通用协议。

-

性能损耗:上下文传递与动态调度可能增加延迟,需优化底层架构。

-

安全边界:如何平衡开放性与隐私保护,仍是长期议题。

“未来的AI竞争,不再是模型参数的军备竞赛,而是生态协议的合纵连横。” MCP的诞生,标志着AI从“单体智能”迈向“群体智能”的关键一步。无论你是开发者、创业者还是技术爱好者,尽早理解并拥抱这一协议,或许就能在下一轮AI浪潮中抢占先机。

延伸思考:如果HTTP协议奠定了互联网的基石,MCP是否会成为AI世界的“新TCP/IP”?答案,或许就在你我手中。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)