DeepSeek本地部署过程记录

本地部署deepseek,记录在此。且将Ollama安装到D盘,或迁移到D盘。

文章目录

说明1:本文,基于笔者自身的部署过程,可被理解为笔者自己的一个DeepSeek本地部署过程记录

说明2:如果文章有误,欢迎大家指出、讨论,笔者也会积极改正,希望大家一起进步!

背景

- 新年期间,DeepSeek横空出世,一时间热度火爆。

- 处于办公需要,一直使用网页版,但总是显示“服务器繁忙,请稍后再试。”,搞得很恼火

- 除了DeepSeek,笔者也使用了Kimi,但可能是心理作祟,感觉差了点意思。

- 遂决定,本地部署DeepSeek。

一、安装Ollama工具

1.1 ··· Ollama

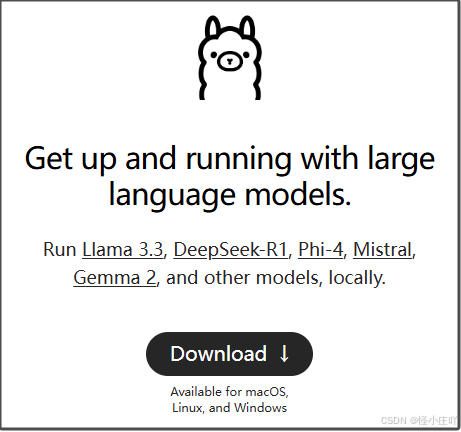

- Ollama 是一个开源框架,专为在本地计算机上便捷地构建、运行和管理大型语言模型(LLM)而设计。

- Ollama 允许用户在本地机器上运行大型语言模型,无需依赖云端服务,从而保护数据隐私。

- 支持 macOS、Windows、Linux 以及通过 Docker 容器运行,且支持多种流行的 LLM 模型,如 Llama、Falcon、DeepSeek-R1、Phi-4、Mistral、Gemma 2 等。

1.2 ··· Ollama的安装

1.2.1 ··· Ollama官网:

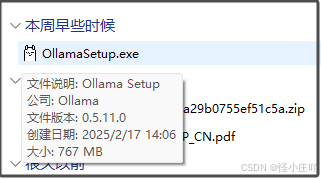

1.2.2 ··· 下载、安装

- 1、进入官网,点击“Download”按钮。

- 2、根据电脑的操作系统下载对应的软件版本。

- 3、下载完成后,运行安装程序即可开始安装,等待安装过程结束即可。

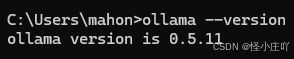

- 4、安装完成后,在电脑上打开cmd窗口,输入查询安装ollama版本的代码,即可验证安装,如下图。

ollama --version

二、关于将安装的Ollama从C盘迁移到D盘上的操作

2.1 ··· 说明

说明3:上述1.2中的安装过程,默认是将ollama安装到了C盘中。

说明4:笔者不喜欢往C盘塞入太多数据,且C盘的空间有限,故需要将安装的ollama从C盘迁移到D盘。。

说明5:如果道友觉得安装在C盘无伤大雅,那也可以自动跳过1.3这节内容。

2.2 ··· 将安装的ollama从C盘迁移到D盘

-

1、将Ollama的安装目录从默认的C盘移动到D盘。

将C:\Users\用户名\AppData\Local\Programs\Ollama这个文件夹下的内容移动到D盘,

放在D:\Application\Ollama\Ollama路径下。 -

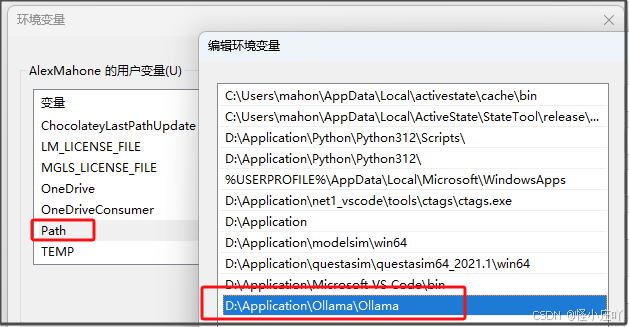

2、修改系统的环境变量,以便Ollama能够正确找到新的安装位置。

-

将原来的C:\Users\用户名\AppData\Local\Programs\Ollama路径更新为新的位置,即D:\Application\Ollama\Ollama。

- 3、完成Ollama安装目录的迁移后,可以使用“ollama --version”命令验证下,或者运行ollama app.exe也是可以的。

- 3、完成Ollama安装目录的迁移后,可以使用“ollama --version”命令验证下,或者运行ollama app.exe也是可以的。 -

4、迁移模型文件

说明6:如果还没在Ollama中部署过任何模型,那目前可以自动跳过这步内容,等部署了模型再操作。

4、1 :模型文件的目录在:C:\Users\用户名\.ollama下;

也迁移到D盘,D:\Application\Ollama\.ollama。

4、2 :要在系统变量中新建一个名为 OLLAMA_MODELS 的变量;

设置其值为模型文件的新位置,D:\Application\Ollama\.ollama\models。 -

5、完成Ollama模型文件的迁移后,可以使用ollama list来列出已下载的模型进行验证。

三、下载并运行deepseek模型

3.1 ··· 选择DeepSeek模型

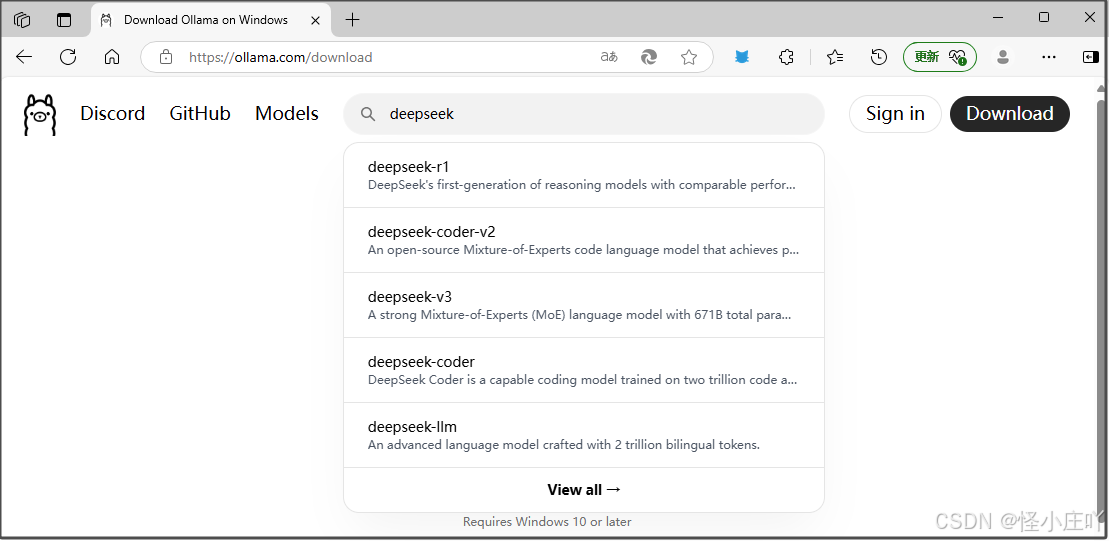

- 1、在Ollama的官网https://ollama.com,搜索框里搜索deepseek,选择要安装的deepseek模型。

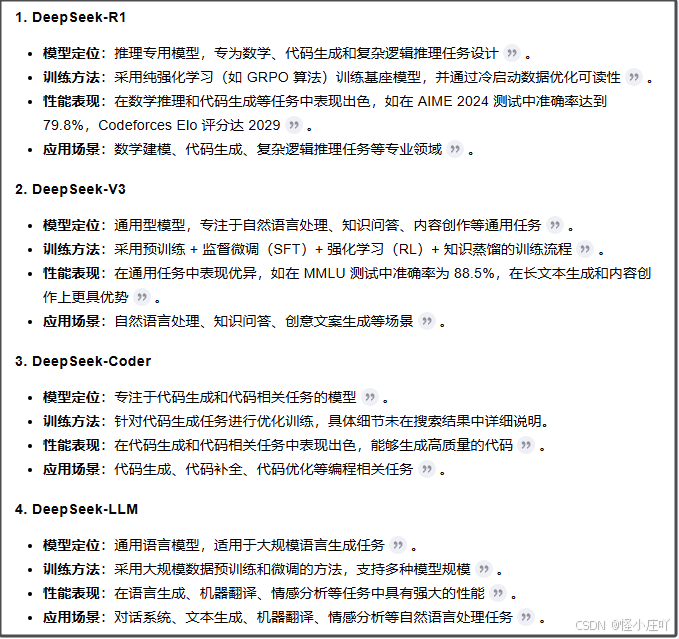

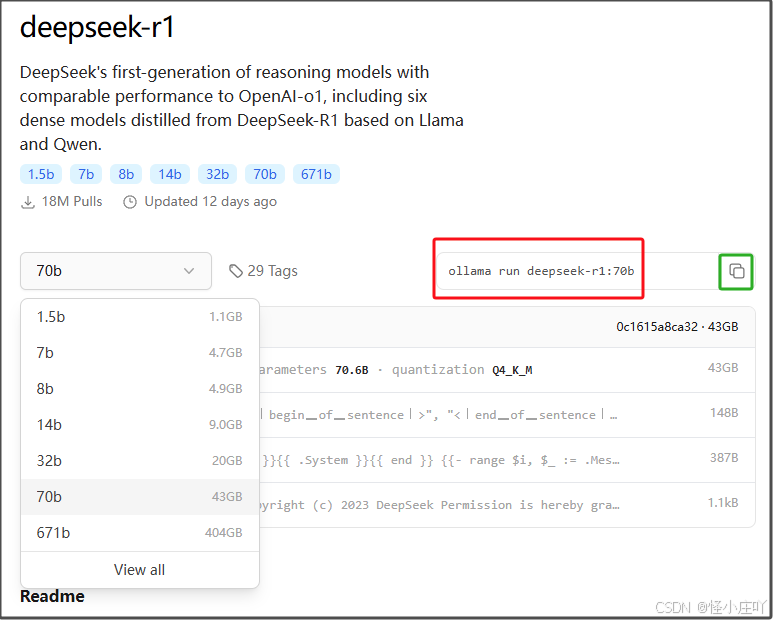

- 2、请根据自身的需求来选择对应的deepseek模型,如下图所示。

PS:这是笔者用Kimi生成的。

2、1:笔者选择的是deepseek-r1,通过下拉选框,可以看到多个deepseek-r1版本;名称里面的数字越大,则参数越多、性能就越强,但也对计算机的性能要求越高。

2、2:最好是根据自己的电脑配置来选择对应的具体版本,笔者选择的是deepseek-r1的70b版本。

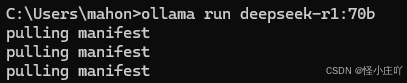

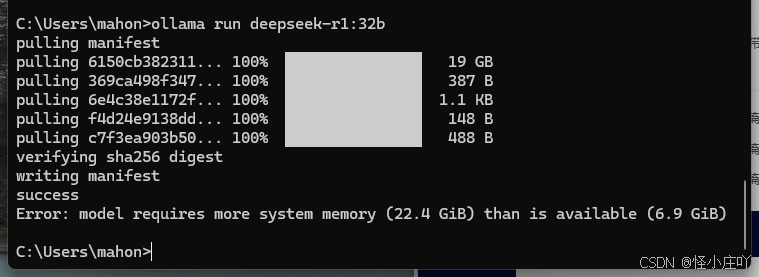

2、3:点击绿色框内的复制动作,将红色框内的deepseek-r1的70b版本的安装命令复制到cmd命令框中,并执行,如下图所示。

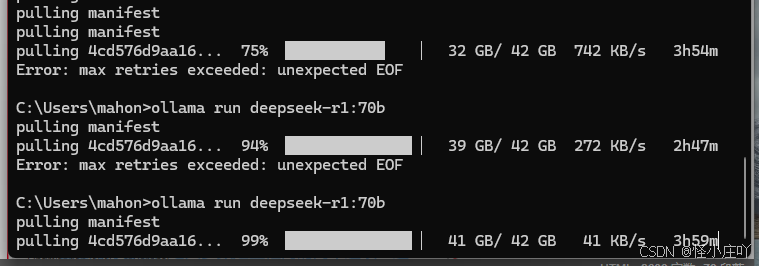

2、4:如果发生如下图所示的下载中断,重新在cmd中执行该命令即可,如下图所示。

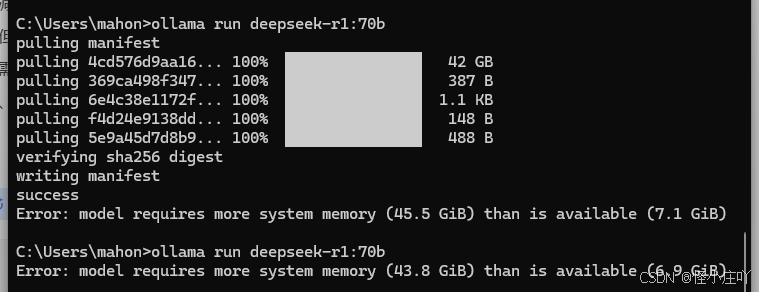

- 3、安装完成后,如下图所示。

笔者在办公电脑上先后部署了70b、32b、14b,均因为资源不足而失败告终,最终是8b。

笔者在私人电脑上部署了14b,能用,但没网页版的那个聪明(不过,网页版太不稳定了。)。

要根据自己的电脑配置选择适当的版本,

不然,会在显示安装成功后报错:配置资源不够用。

3.2 ··· 关于迁移deepseek-r1的模型文件

- 正如前文所描述,如果不想往C盘太满,可往D盘进行迁移模型文件。

- 具体操作,见前文<2.2 ··· 将安装的ollama从C盘迁移到D盘>步骤描述。

说明7:笔者部署完模型后,感觉电脑配置所对应的模型用起来一般般,后面就直接使用命令行把部署的模型remove掉了,就没有迁移模型文件这一操作。

四、下载并安装可视化工具: Chatbox

-

很多人不喜欢黑乎乎的命令行界面,我们可以安装一个图形界面可视化软件Chatbox。

-

chatbox官网:https://chatboxai.app/zh。

-

1、点击「免费下载」后,双击开始安装。

-

2、笔者不太喜欢把数据放C盘,因此,自定义安装路径。

-

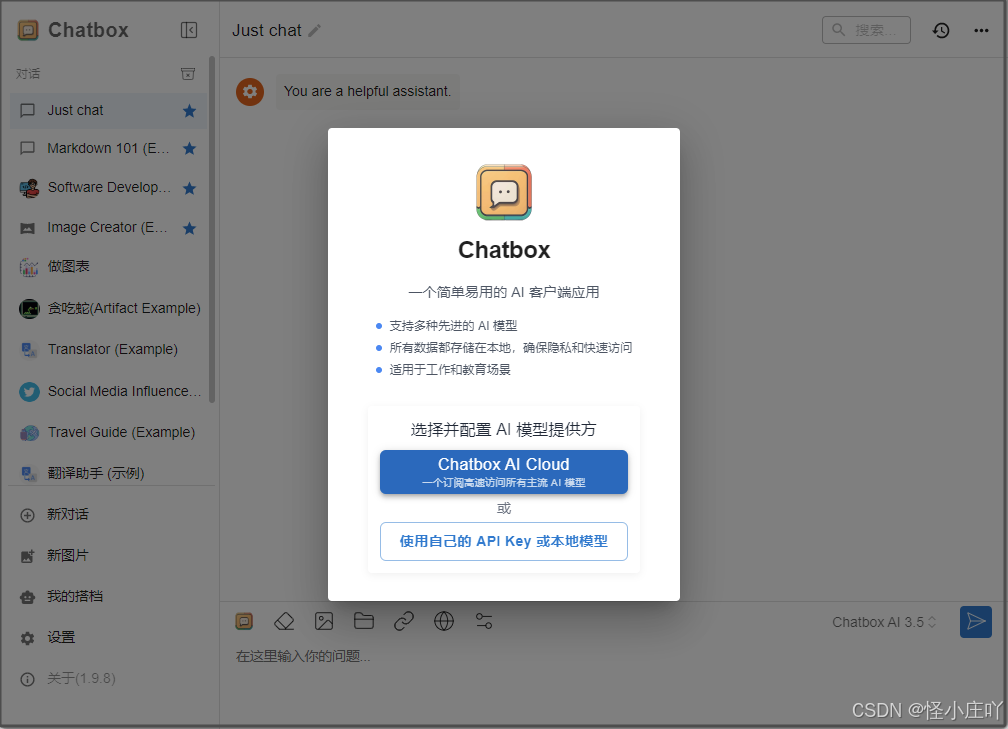

3、安装完成后,打开chatbox,并选择“使用自己的 API Key 或本地模型”

-

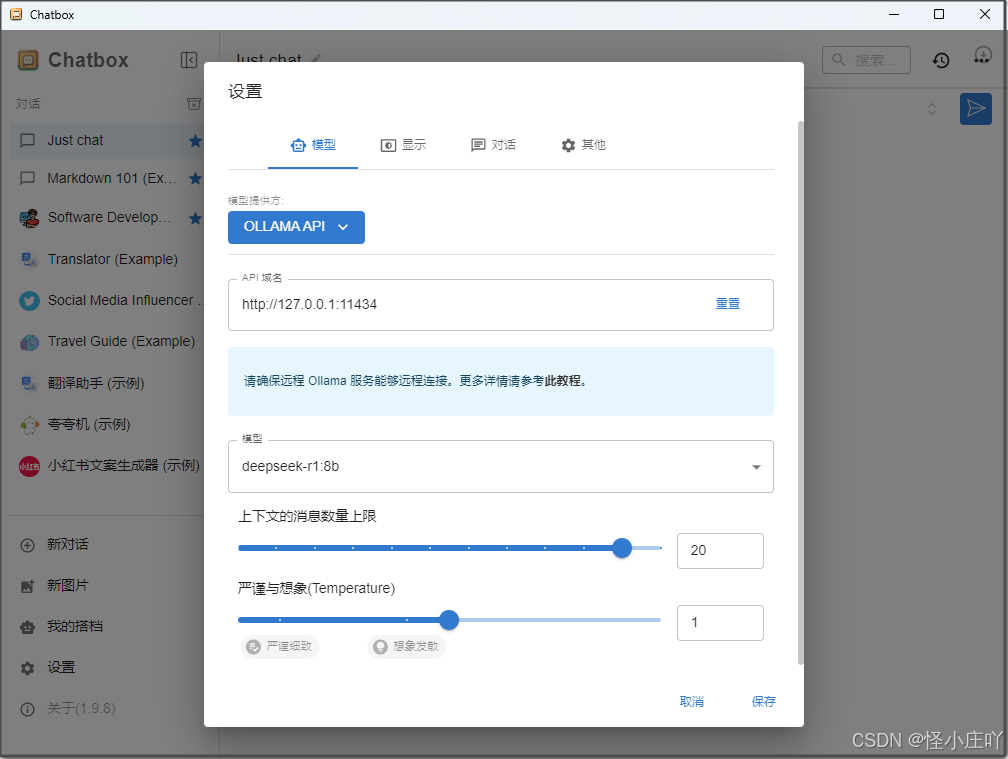

4、选择模型提供方为:Ollama API,选择安装的deepseek-r1:8b(当前电脑本地部署的版本),保存即可在新建对话中使用。(这个界面可以通过左下方的的“设置”按钮来进入。)

-

5、完成上述操作后,可以得到Chatbox的对话界面:

五、尾声

-

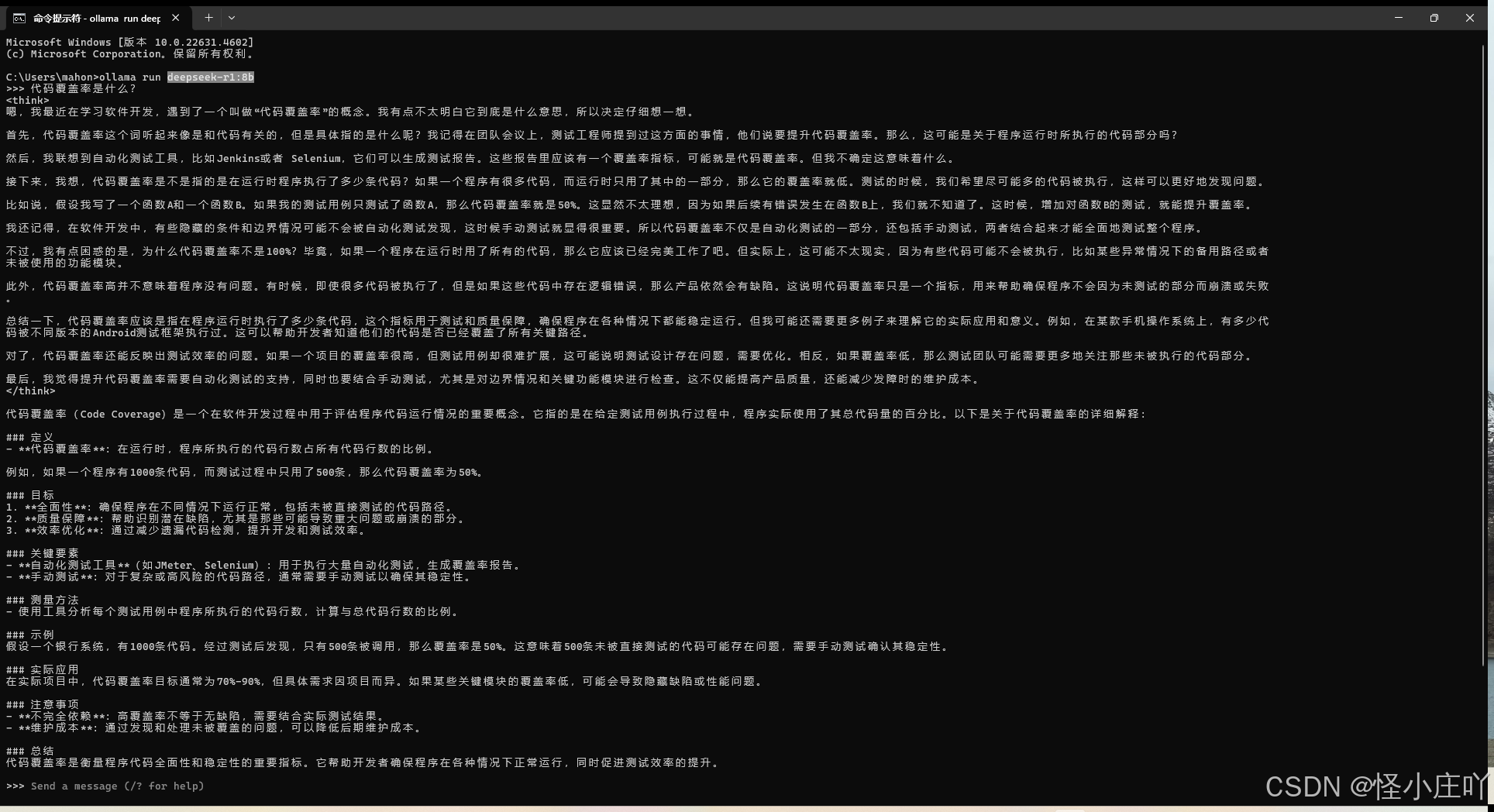

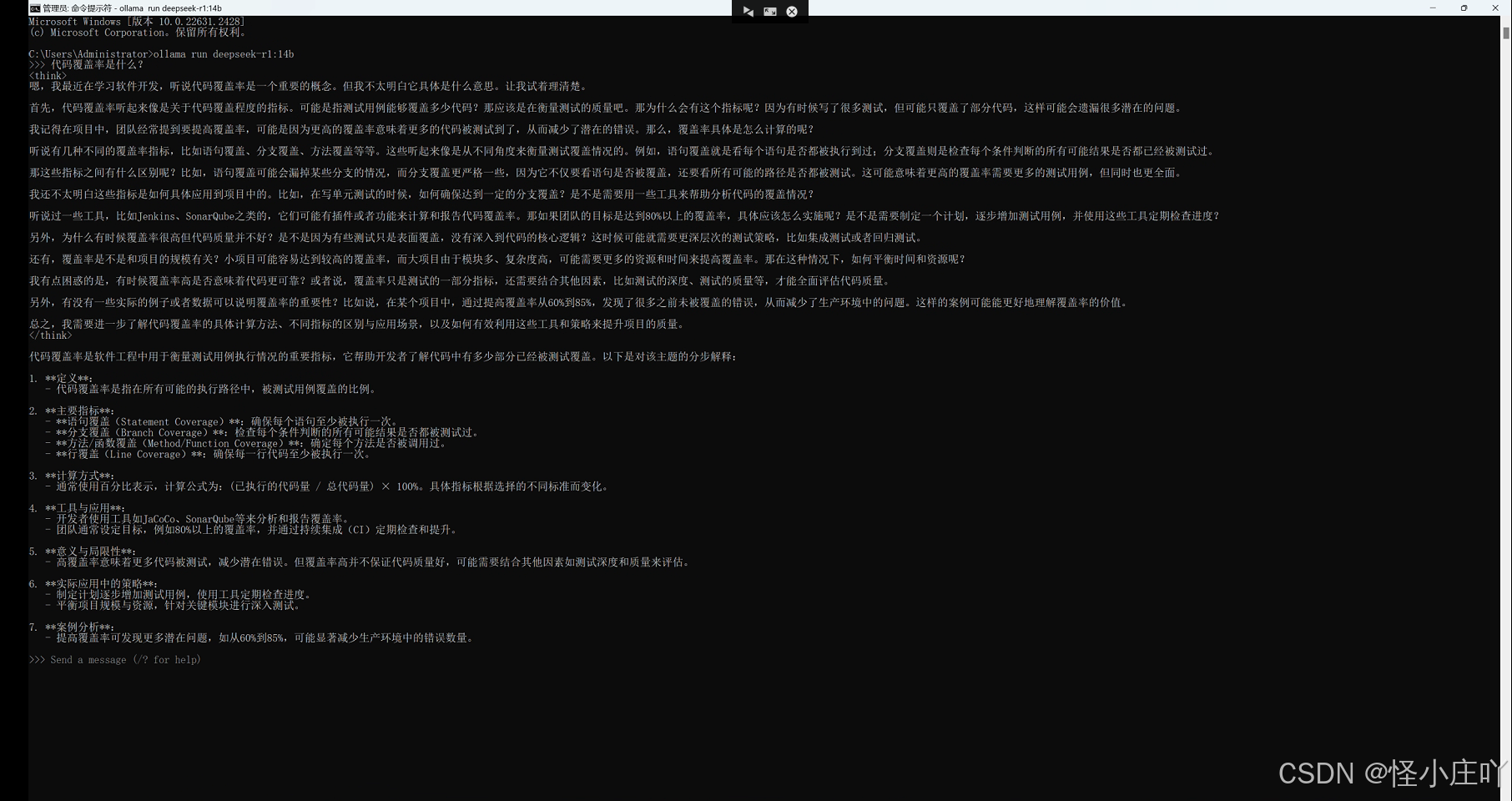

deepseek-r1:8b和deepseek-r1:14b,

对于问题“代码覆盖率是什么?”的回答,放在下面,给诸位道友感受下。 -

deepseek-r1:8b

-

deepseek-r1:14b

总感觉deepseek-r1:8b有点不太聪明的样子,嗯,deepseek-r1:14b要稍微好一点,但感觉也聪明不到哪里去。想要更好的效果,还是部署更好的模型靠谱点,但这样,电脑配置的问题就来了。

总感觉deepseek-r1:8b有点不太聪明的样子,嗯,deepseek-r1:14b要稍微好一点,但感觉也聪明不到哪里去。想要更好的效果,还是部署更好的模型靠谱点,但这样,电脑配置的问题就来了。 -

参考文献:

1、《十分钟搞定! DeepSeek本地部署详细指南!》

2、《十分钟本地部署DeepSeek》

3、《在Windows中将Ollama安装到其他盘(例如D盘)的步骤如下》

4、《Ollama全面指南:安装、使用与高级定制》

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)