DeepSeek局域网部署

本地部署的教程很多,安装在本地都会用到ollama,网页上使用的方案有多种,包括:Chatbox、docker+Open WebUI等,这些坑我踩过了,本地部署本地访问可行,修改成目标IP后无法获取到模型选项。在deepseek的热潮下,本地部署有很多教程了,我这里细化一下,重点讲下在一台电脑上部署,局域网下的电脑都能够使用。总结:可视化界面请使用page-assist扩展。

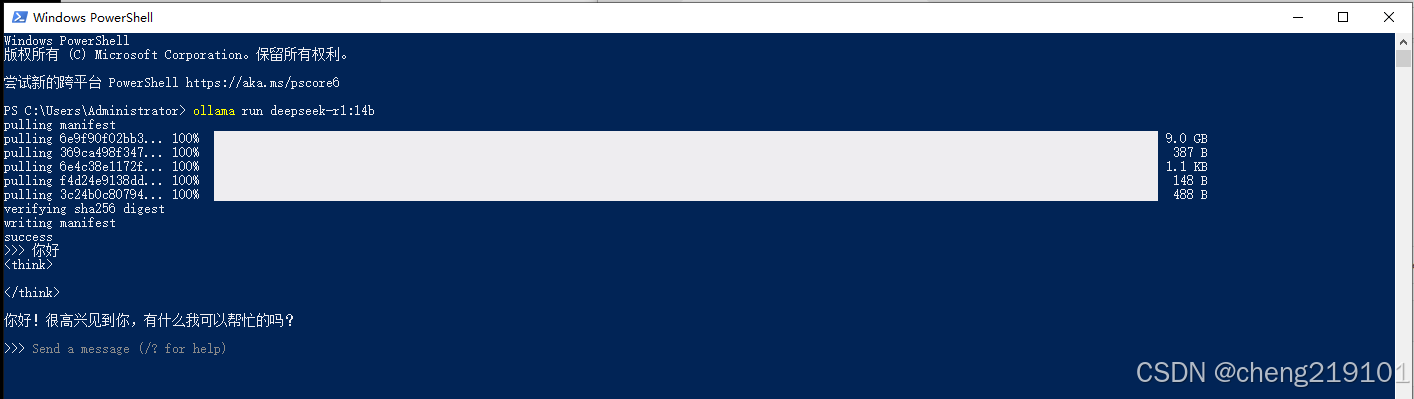

在deepseek的热潮下,本地部署有很多教程了,我就不详细介绍了。安装ollama后输入一个命令行即可完成部署。

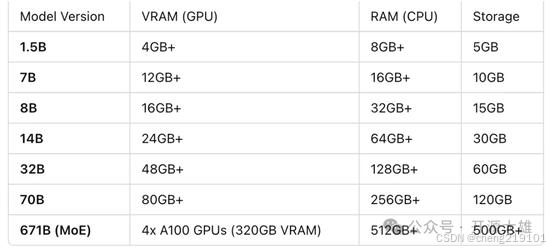

下面重点讲下在一台电脑上部署,局域网下的电脑都能够使用。deepseek还是很吃硬件配置的,办公室的电脑不是每台都能达标,也没有必要每人都部署一遍。配置要求如下:

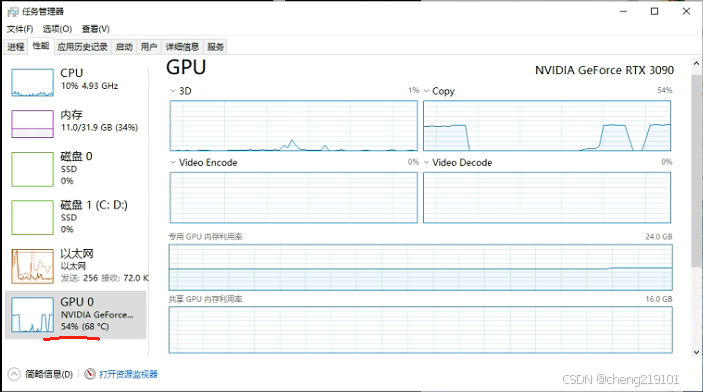

我这里用到是一台配备RTX3090Ti(24G)显卡的电脑,部署的是14b的模型,当输入一千字的文本时,从任务管理器中看到GPU使用率超过了50%,并且温度甚至超过了70度,截图如下

本地部署完成后,我们需要在一个可视化的界面上使用,网页上使用的方案有多种,包括:Chatbox、docker+Open WebUI等,这些坑我踩过了,本地部署本地访问可行,修改成目标IP后无法获取到模型选项。

总结:可视化界面请使用page-assist扩展。

详细教程参考:全网最简单!本地部署DeepSeek-R1联网教程!-CSDN博客

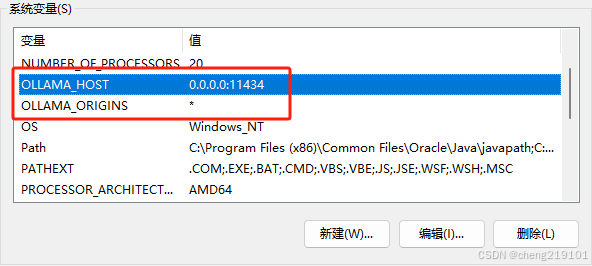

如果page-assist修改成目标电脑IP后未显示模型,设置下两个系统环境变量:

OLLAMA_HOST=0.0.0.0:11434

OLLAMA_ORIGINS=*

综上,即使部署了14b版本的模型,参数量级离671b还差了几十倍,使用效果还是没有官方或者其他第三方提供的deepseek模型好。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)