AI原生应用云端推理的自动化部署方案

概念通俗解释AI原生应用以“模型推理”为核心功能的应用(比如智能客服的语义理解、自动驾驶的目标检测)云端推理将模型部署在云端服务器(或云原生集群),通过API对外提供推理服务自动化部署从“模型注册”到“服务上线”的全流程自动化(无需手动上传文件、配置环境)推理框架封装模型推理逻辑的工具(比如Triton、TorchServe),解决“如何高效跑模型”的问题云原生编排用K8s等工具管理容器化的推理服

AI原生应用云端推理的自动化部署方案:从痛点到全流程落地的实践指南

一、引入:当“训练好的模型”遇到“部署的坑”

小张是某AI公司的算法工程师,上周刚用ResNet-50训练好了一个商品图像分类模型——在本地GPU服务器上,单张图片推理延迟仅8ms,准确率达到98%。他兴高采烈地把模型打包发给业务部门,却迎来了连环暴击:

- 环境不兼容:业务用的云端服务器是CUDA 11.8,而小张本地用的是CUDA 12.1,模型加载时直接报“CUDA版本不匹配”;

- 资源调度乱:手动启动3个推理服务,结果全挤在同一台GPU节点上,导致单卡负载100%,延迟飙升到500ms;

- 弹性跟不上:大促期间流量暴涨10倍,小张得手动创建10台GPU实例,等了40分钟才完成部署,业务已经损失了几十万;

- 版本管理混:迭代到V3版本时,不小心覆盖了V2模型,导致线上服务回滚失败,故障持续2小时。

小张的困境不是个例——对于AI原生应用(以模型推理为核心功能的应用)来说,“训练容易部署难”是行业普遍痛点。根据《2023年AI工程化白皮书》统计:60%的AI项目卡在部署环节,35%的算法工程师花在部署上的时间超过训练的2倍。

为什么AI原生应用的部署“更难”?

和传统应用(比如Web服务)相比,AI原生应用的核心是模型推理,其部署需要解决三个独特问题:

- 资源特殊性:依赖GPU、TPU等异构硬件,资源调度需精准匹配;

- 性能敏感性:实时推理场景(比如直播内容审核)要求延迟≤100ms,任何调度延迟都会影响体验;

- 模型动态性:模型迭代快(每周1-2次),版本管理和回滚需自动化;

- 多框架兼容性:可能同时用到PyTorch、TensorFlow、ONNX等框架,需统一推理入口。

我们需要什么样的部署方案?

理想的AI原生应用云端推理部署,应该是**“端到端自动化+AI优化+云原生”**的组合:

- 从模型注册到服务上线,全程无需手动操作;

- 针对推理场景优化性能(比如动态批量、模型量化);

- 利用云原生技术实现弹性伸缩、故障自愈;

- 支持多框架、多模型的统一管理。

接下来,我们将从知识框架→基础原理→实践步骤→进阶优化,一步步拆解AI原生应用云端推理的自动化部署方案,帮你从“部署小白”变成“AI工程化专家”。

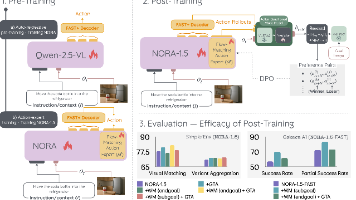

二、概念地图:构建自动化部署的“认知骨架”

在开始之前,我们需要先明确核心概念和它们的关系——这是理解复杂系统的第一步。

1. 核心概念定义

| 概念 | 通俗解释 |

|---|---|

| AI原生应用 | 以“模型推理”为核心功能的应用(比如智能客服的语义理解、自动驾驶的目标检测) |

| 云端推理 | 将模型部署在云端服务器(或云原生集群),通过API对外提供推理服务 |

| 自动化部署 | 从“模型注册”到“服务上线”的全流程自动化(无需手动上传文件、配置环境) |

| 推理框架 | 封装模型推理逻辑的工具(比如Triton、TorchServe),解决“如何高效跑模型”的问题 |

| 云原生编排 | 用K8s等工具管理容器化的推理服务,解决“如何调度资源、弹性伸缩”的问题 |

2. 知识关系图谱

graph TD

A[AI原生应用] --> B[云端推理服务]

B --> C[模型管理系统(MLflow/Hugging Face Hub)]

B --> D[推理框架(Triton/TorchServe)]

D --> E[容器化(Docker)]

E --> F[云原生编排(K8s)]

F --> G[监控运维系统(Prometheus/Grafana)]

G --> C[模型管理系统]

关键逻辑:模型从管理系统流出,经推理框架封装成容器,由K8s调度到合适的节点,监控系统反馈性能数据,驱动模型迭代——形成“开发→部署→监控→迭代”的闭环。

三、基础理解:用“餐厅模型”看懂自动化部署

为了让抽象概念更直观,我们用“餐厅运营”类比AI原生应用的云端推理部署:

1. 餐厅 vs AI部署的对应关系

| 餐厅角色/流程 | AI部署对应物 |

|---|---|

| 厨师(训练模型) | 算法工程师,负责训练出“能做菜(推理)”的模型 |

| 菜谱(模型文件) | .pt/.pb/.onnx等模型文件,包含“做菜的步骤(推理逻辑)” |

| 服务员(推理框架) | Triton等推理框架,负责“接待顾客(处理请求)、优化上菜顺序(动态批量)” |

| 餐厅(云端集群) | 云服务商的GPU集群(比如AWS G4dn、阿里云GPU计算型),提供“做菜的场地(硬件)” |

| 前台(API网关) | Nginx或云厂商的API网关,负责“接收顾客订单(推理请求)、分配给服务员(路由)” |

| 经理(K8s) | K8s编排系统,负责“安排服务员(推理服务)到合适的餐桌(节点)、根据客流调人数(弹性伸缩)” |

2. 自动化部署的“简化流程”

就像餐厅从“备菜”到“上菜”的标准化流程,AI部署的核心步骤可以简化为:

- 备菜(模型注册):把训练好的模型“放进菜谱库(模型仓库)”,标记版本(比如V1、V2);

- 做菜(推理封装):用“服务员(推理框架)”把模型包装成“能接单的服务”,比如给ResNet模型加个HTTP接口;

- 开餐厅(容器化):把“服务员+菜谱”装进“外卖盒(Docker容器)”,确保不管到哪个“场地(服务器)”都能直接用;

- 营业(编排部署):让“经理(K8s)”把“外卖盒”放到合适的“餐桌(GPU节点)”,并打开“店门(暴露API)”;

- 迎客(服务调用):用户通过API发送图片,“服务员”用模型算出分类结果,返回给用户;

- 巡店(监控运维):“经理”盯着“服务员”的状态(比如有没有忙不过来),自动加人(扩容)或换班(重启)。

3. 常见误解澄清

- ❌ “自动化部署=一键部署”:不是点一下按钮就完事,而是端到端流程自动化(包括版本管理、环境配置、资源调度、监控反馈);

- ❌ “推理框架=模型运行环境”:推理框架不仅是“跑模型的工具”,还能优化性能(比如动态批量、模型并行);

- ❌ “K8s只适合Web服务”:K8s的资源隔离、弹性伸缩、故障自愈特性,刚好匹配AI推理的需求,是目前云端部署的主流选择。

四、层层深入:从“能跑”到“跑好”的技术细节

接下来,我们将拆解自动化部署的四大核心环节,并深入讲解每个环节的技术细节和优化技巧。

环节1:模型管理——让模型“有迹可循”

模型是AI应用的“核心资产”,没有有效的管理,部署会变成“混乱的拼图”。

1.1 核心需求

- 版本控制:能追溯每个版本的模型(比如V1是ResNet-50,V2是ResNet-101);

- 元数据管理:记录模型的训练参数(比如学习率、 batch size)、评估指标(准确率、F1-score);

- 权限控制:防止未经授权的修改(比如实习生误删模型);

- 便捷获取:部署时能快速从仓库拉取模型。

1.2 主流工具:MLflow vs Hugging Face Hub

| 特性 | MLflow | Hugging Face Hub |

|---|---|---|

| 定位 | 通用MLOps平台(支持模型+实验管理) | 专注于预训练模型的共享与管理 |

| 版本控制 | 支持 | 支持(通过Git LFS) |

| 元数据管理 | 丰富(实验参数、指标、 artifacts) | 基础(模型卡片、作者、许可证) |

| 多框架支持 | 全(PyTorch、TensorFlow、ONNX) | 全(以Transformer模型为主) |

| 私有化部署 | 支持 | 支持(Enterprise版) |

1.3 实践步骤:用MLflow注册模型

- 安装MLflow:

pip install mlflow; - 训练并记录模型:

import mlflow import mlflow.pytorch from torchvision.models import resnet50 # 初始化MLflow实验 mlflow.set_experiment("image-classification") # 训练模型(简化版) model = resnet50(pretrained=True) model.eval() # 记录模型到MLflow with mlflow.start_run(): mlflow.log_param("model_name", "resnet50") mlflow.log_metric("accuracy", 0.98) mlflow.pytorch.log_model(model, "model") - 注册模型:在MLflow UI中,把“run”中的模型注册到“Model Registry”,标记为“Production”版本。

环节2:推理封装——让模型“能接活”

模型本身是“静态的文件”,需要用推理框架封装成“动态的服务”,才能处理用户请求。

2.1 推理框架的核心能力

- 多框架兼容:支持PyTorch、TensorFlow、ONNX等主流框架;

- 性能优化:动态批量(Dynamic Batching)、模型量化(Quantization)、GPU并行;

- 多模型支持:同一服务中运行多个模型(比如同时部署ResNet和YOLO);

- 监控指标:输出推理延迟、吞吐量、错误率等 metrics。

2.2 主流框架:Triton Inference Server(首选)

Triton是NVIDIA推出的开源推理框架,专为AI原生应用设计,支持CPU/GPU/TPU,是目前云端推理的“事实标准”。

2.2.1 Triton的核心组件

- Model Repository:模型仓库,按固定目录结构存储模型文件(比如

models/resnet50/1/model.pt); - Inference Engine:推理引擎,负责加载模型、处理请求;

- Protocol Support:支持HTTP/REST、gRPC、TensorRT等协议;

- Scheduler:调度器,实现动态批量、优先级调度。

2.2.2 实践步骤:用Triton封装ResNet模型

- 准备模型仓库:

models/ └── resnet50/ ├── 1/ # 版本号 │ └── model.pt # 模型文件 └── config.pbtxt # 模型配置文件 - 编写config.pbtxt(核心配置):

关键配置说明:name: "resnet50" platform: "pytorch_libtorch" # 模型框架(PyTorch) max_batch_size: 32 # 最大批量大小 input [ { name: "input" data_type: TYPE_FP32 dims: [3, 224, 224] # 输入维度(RGB图像,224x224) } ] output [ { name: "output" data_type: TYPE_FP32 dims: [1000] # 输出维度(ImageNet 1000类) } ] dynamic_batching { max_queue_delay_microseconds: 1000 # 队列最大延迟(1ms) }max_batch_size:一次处理的最大请求数,越大吞吐量越高,但延迟可能增加;dynamic_batching:自动把多个小请求合并成批量处理,提升GPU利用率(比如把10个单张图片请求合并成1个batch=10的请求)。

环节3:容器化——让模型“走到哪都能跑”

容器化是解决“环境不兼容”的终极方案——把推理服务、模型、依赖库装进“Docker容器”,确保在任何服务器上都能运行。

3.1 AI容器的特殊需求

- 基础镜像选择:需包含CUDA、cuDNN等GPU依赖(比如NVIDIA的

nvcr.io/nvidia/tritonserver:23.09-py3); - 镜像体积优化:模型文件可能很大(比如LLM模型达几十GB),需用多阶段构建减少镜像体积;

- 权限配置:需赋予容器访问GPU的权限(比如

--gpus all)。

3.2 实践步骤:构建Triton容器镜像

- 编写Dockerfile:

# 阶段1:下载模型(用小镜像,减少最终体积) FROM alpine:latest as model-downloader RUN apk add --no-cache wget # 从MLflow下载模型(假设MLflow地址是http://mlflow-server:5000) RUN wget -O /model.pt http://mlflow-server:5000/api/2.0/mlflow/models/get?name=resnet50&version=1 # 阶段2:构建Triton镜像(基于NVIDIA的基础镜像) FROM nvcr.io/nvidia/tritonserver:23.09-py3 # 复制模型到Triton的模型仓库 COPY --from=model-downloader /model.pt /models/resnet50/1/model.pt # 复制模型配置文件 COPY models/resnet50/config.pbtxt /models/resnet50/config.pbtxt # 暴露端口(HTTP:8000,gRPC:8001, metrics:8002) EXPOSE 8000 8001 8002 # 启动Triton服务 CMD ["tritonserver", "--model-repository=/models"] - 构建镜像:

docker build -t resnet50-triton:v1 .; - 本地测试:

docker run --gpus all -p 8000:8000 resnet50-triton:v1,用curl测试:curl -X POST http://localhost:8000/v2/models/resnet50/infer \ -H "Content-Type: application/json" \ -d '{ "inputs": [ { "name": "input", "shape": [1, 3, 224, 224], "datatype": "FP32", "data": [/* 图像数据 */] } ] }'

环节4:云原生编排——让模型“自动找资源”

容器化解决了“环境一致”的问题,但如何调度容器到合适的GPU节点、如何弹性伸缩、如何故障自愈?答案是Kubernetes(K8s)。

4.1 K8s在AI推理中的核心作用

- 资源调度:把容器调度到有空闲GPU的节点(用

nvidia.com/gpu资源请求); - 弹性伸缩:根据QPS或GPU利用率自动增加/减少副本数(HPA);

- 故障自愈:容器崩溃时自动重启,节点故障时自动迁移容器;

- 服务暴露:用Service或Ingress把推理服务暴露给外部用户。

4.2 实践步骤:用K8s部署Triton服务

- 准备K8s集群:确保集群中有GPU节点(比如阿里云的GPU计算型节点),并安装NVIDIA Device Plugin(用于识别GPU资源);

- 编写Deployment.yaml(核心配置):

apiVersion: apps/v1 kind: Deployment metadata: name: resnet50-triton spec: replicas: 2 # 初始副本数 selector: matchLabels: app: resnet50-triton template: metadata: labels: app: resnet50-triton spec: containers: - name: triton-server image: resnet50-triton:v1 resources: requests: cpu: "2" memory: "4Gi" nvidia.com/gpu: 1 # 请求1块GPU limits: cpu: "4" memory: "8Gi" nvidia.com/gpu: 1 # 限制1块GPU ports: - containerPort: 8000 # HTTP端口 - containerPort: 8001 # gRPC端口 - containerPort: 8002 # metrics端口 - 编写Service.yaml(暴露服务):

apiVersion: v1 kind: Service metadata: name: resnet50-triton-service spec: type: LoadBalancer # 用云厂商的负载均衡器暴露服务 selector: app: resnet50-triton ports: - name: http port: 80 targetPort: 8000 - name: grpc port: 8001 targetPort: 8001 - 部署到K8s:

kubectl apply -f deployment.yaml kubectl apply -f service.yaml - 验证部署:

- 查看Pod状态:

kubectl get pods(应显示“Running”); - 查看Service地址:

kubectl get service resnet50-triton-service(获取外部IP); - 测试推理:用外部IP发送请求,比如

curl http://<external-ip>/v2/models/resnet50/infer。

- 查看Pod状态:

4.3 进阶优化:弹性伸缩(HPA)

为了应对流量波动,我们可以用K8s的**Horizontal Pod Autoscaler(HPA)**自动调整副本数。

- 编写HPA.yaml:

apiVersion: autoscaling/v2 kind: HorizontalPodAutoscaler metadata: name: resnet50-triton-hpa spec: scaleTargetRef: apiVersion: apps/v1 kind: Deployment name: resnet50-triton minReplicas: 2 # 最小副本数 maxReplicas: 10 # 最大副本数 metrics: - type: Pods pods: metric: name: triton_inference_requests_per_second # Triton的QPS指标 target: type: AverageValue averageValue: "100" # 当平均QPS超过100时扩容 - type: Resource resource: name: nvidia.com/gpu target: type: Utilization averageUtilization: 70 # 当GPU利用率超过70%时扩容 - 部署HPA:

kubectl apply -f hpa.yaml; - 验证弹性:当流量上升时,HPA会自动增加副本数;流量下降时,自动减少副本数。

五、多维透视:从“单一视角”到“系统观”

1. 历史视角:部署方式的演变

- 手动部署(2018年前):用SSH上传模型,手动启动服务(比如

python app.py),效率极低; - 脚本自动化(2018-2020):用Shell或Python脚本实现环境配置、服务启动,但缺乏版本管理和弹性;

- 容器化+编排(2020至今):用Docker+K8s实现环境一致和弹性伸缩,结合Triton等推理框架优化性能;

- Serverless推理(未来):用云厂商的Serverless服务(比如AWS Lambda for AI),无需管理集群,按调用次数付费。

2. 实践视角:某电商实时推荐模型的部署案例

某电商的实时推荐系统需要部署BERT模型(用于用户兴趣预测),要求延迟≤100ms,吞吐量≥1000 QPS。他们的部署方案如下:

- 模型管理:用MLflow注册BERT模型,记录每个版本的AUC指标;

- 推理封装:用Triton封装BERT模型,开启动态批量(max_batch_size=64)和TensorRT优化(将PyTorch模型转换为TensorRT引擎,延迟降低30%);

- 容器化:用多阶段构建减少镜像体积(从15GB降到5GB);

- 编排部署:用K8s部署3个初始副本,HPA根据QPS(目标1000)自动扩容到10个副本;

- 监控运维:用Prometheus采集Triton的metrics(延迟、吞吐量、GPU利用率),Grafana可视化,当延迟超过100ms时触发告警。

3. 批判视角:当前方案的局限性

- K8s的调度延迟:对于超实时场景(比如自动驾驶的云端推理,要求延迟≤20ms),K8s的调度延迟(约50ms)可能无法满足;

- 模型镜像的存储成本:LLM模型(比如Llama 2-70B)的镜像体积达几十GB,存储和拉取成本高;

- 多框架的兼容性:虽然Triton支持多框架,但某些小众框架(比如JAX)的支持不够完善。

4. 未来视角:AI原生部署的趋势

- Serverless推理:云厂商推出的Serverless AI服务(比如阿里云FC的AI推理版),无需管理集群,按调用次数付费,适合突发流量场景;

- AI原生编排系统:比如Kubeflow(专为MLOps设计的K8s扩展)、Volcano(专为AI/ML任务优化的调度器),提升GPU利用率;

- 基于LLM的智能运维:用GPT-4或Claude 3分析监控数据,自动排查部署故障(比如“GPU利用率高是因为动态批量参数设置不合理”);

- 边缘-云端协同推理:将轻量级模型部署在边缘设备(比如手机、摄像头),复杂模型部署在云端,降低延迟(比如直播内容审核,边缘设备先过滤普通内容,云端处理敏感内容)。

六、实践转化:从“理论”到“实战”的 Step-by-Step

1. 工具栈选型建议

| 环节 | 工具推荐 |

|---|---|

| 模型管理 | MLflow(通用)、Hugging Face Hub(预训练模型) |

| 推理框架 | Triton Inference Server(首选)、TorchServe(PyTorch专用) |

| 容器化 | Docker(基础)、Kaniko(无Docker daemon的构建) |

| 云原生编排 | Kubernetes(基础)、Kubeflow(MLOps扩展)、Volcano(AI调度优化) |

| 监控运维 | Prometheus(指标采集)、Grafana(可视化)、Alertmanager(告警) |

2. 实战:部署Llama 2-7B模型(LLM案例)

Llama 2是Meta推出的开源大语言模型,我们用Triton+K8s部署它的7B版本(参数规模70亿)。

2.1 准备工作

- 下载Llama 2-7B模型(需申请Meta的授权);

- 转换模型格式:用

transformers库将模型转换为Triton支持的格式(比如pytorch_libtorch); - 编写Triton配置文件(config.pbtxt):

name: "llama2-7b" platform: "pytorch_libtorch" max_batch_size: 16 input [ { name: "input_ids" data_type: TYPE_INT64 dims: [-1] # 动态长度(输入文本的token数) }, { name: "attention_mask" data_type: TYPE_INT64 dims: [-1] } ] output [ { name: "output" data_type: TYPE_FP32 dims: [-1, 4096] # 输出维度(Llama 2的hidden size是4096) } ] dynamic_batching { max_queue_delay_microseconds: 5000 # LLM推理延迟高,队列延迟设为5ms }

2.2 构建容器镜像

FROM nvcr.io/nvidia/tritonserver:23.09-py3

# 复制Llama 2模型到Triton模型仓库

COPY llama2-7b /models/llama2-7b/1/

# 复制配置文件

COPY config.pbtxt /models/llama2-7b/config.pbtxt

# 安装依赖(比如transformers)

RUN pip install transformers torch

CMD ["tritonserver", "--model-repository=/models"]

2.3 部署到K8s

编写Deployment.yaml(注意请求GPU资源,比如nvidia.com/gpu: 1,Llama 2-7B需要至少16GB VRAM),然后用kubectl apply部署。

2.4 测试推理

用tritonclient发送请求:

from tritonclient.http import InferenceServerClient, InferInput

# 连接Triton服务

client = InferenceServerClient(url="http://<external-ip>:80")

# 准备输入(用transformers编码文本)

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-2-7b-hf")

text = "What is AI?"

inputs = tokenizer(text, return_tensors="pt")

# 构造Triton输入

input_ids = InferInput("input_ids", inputs["input_ids"].shape, "INT64")

input_ids.set_data_from_numpy(inputs["input_ids"].numpy())

attention_mask = InferInput("attention_mask", inputs["attention_mask"].shape, "INT64")

attention_mask.set_data_from_numpy(inputs["attention_mask"].numpy())

# 发送推理请求

response = client.infer(model_name="llama2-7b", inputs=[input_ids, attention_mask])

# 解析输出

output = response.as_numpy("output")

print(tokenizer.decode(torch.argmax(torch.tensor(output), dim=-1)[0]))

七、整合提升:从“碎片知识”到“体系能力”

1. 核心观点回顾

- AI原生应用的云端推理部署,核心是“模型+推理框架+云原生”的组合;

- 自动化部署的关键是端到端流程闭环:模型注册→推理封装→容器化→编排部署→监控反馈;

- 性能优化的重点是推理框架的配置(比如动态批量、模型量化)和云原生的弹性伸缩(HPA);

- 未来趋势是Serverless推理和AI原生编排系统,降低运维成本。

2. 知识体系重构

graph TD

A[AI原生应用] --> B[模型开发]

B --> C[模型管理(MLflow)]

C --> D[推理封装(Triton)]

D --> E[容器化(Docker)]

E --> F[云原生编排(K8s)]

F --> G[服务暴露(Service/Ingress)]

G --> H[监控运维(Prometheus/Grafana)]

H --> I[模型迭代(回到B)]

3. 拓展任务

- 尝试部署一个多模型 Ensemble服务(比如同时部署ResNet和YOLO,用于图像分类+目标检测);

- 用Kubeflow Pipelines实现端到端的MLOps流程(从数据预处理到模型部署);

- 测试Serverless推理服务(比如阿里云FC的AI推理版),对比其与K8s部署的成本和性能;

- 用GPT-4分析Triton的metrics数据,自动生成优化建议(比如“动态批量的max_queue_delay_microseconds可以从1000调整到500,提升吞吐量”)。

4. 学习资源推荐

- 官方文档:Triton Inference Server Docs(https://docs.nvidia.com/deeplearning/triton-inference-server/user-guide/docs/)、Kubernetes Docs(https://kubernetes.io/docs/);

- 书籍:《云原生AI:技术与实践》(作者:李响)、《MLOps实战》(作者:Andriy Burkov);

- 课程:Coursera的《Machine Learning Engineering for Production (MLOps)》、Udacity的《Cloud Native Application Architecture》。

八、结语:从“部署痛苦”到“部署自由”

AI原生应用的云端推理部署,曾经是算法工程师的“噩梦”,但随着MLOps工具(MLflow、Triton)和云原生技术(K8s、Docker)的发展,自动化部署已经从“不可能”变成“可落地”。

记住:部署不是目的,而是让模型产生价值的桥梁。当你掌握了自动化部署的能力,你将从“只会训练模型的算法工程师”,变成“能把模型变成产品的AI工程化专家”——这才是AI时代最稀缺的能力。

现在,拿起你的模型,按照本文的步骤,开始你的自动化部署之旅吧!你会发现:原来部署,可以这么简单。

更多推荐

已为社区贡献104条内容

已为社区贡献104条内容

所有评论(0)