曙光视控一体工业智能方案评测:基于曙睿(SugonRI)2.0 工业编程平台的 YOLO 应用实测

曙光视控一体工业智能方案评测:基于曙睿(SugonRI)2.0平台的YOLO应用实测 本文评测了曙光网络推出的视控一体化智能平台,重点测试其核心组件曙睿(SugonRI)2.0工业编程平台的YOLO目标检测应用。该方案通过将视觉算法与运动控制深度融合,实现微秒级延迟的"手眼协同",解决了传统工业场景中视觉与控制分离导致的响应延迟问题。平台提供低代码视觉算法训练工具和标准化控制接

曙光视控一体工业智能方案评测:基于曙睿(SugonRI)2.0 工业编程平台的 YOLO 应用实测

写在前面

大家好,我是猫头虎。之前在项目里被“视觉一套系统,控制一套系统”折腾过太多次,一堆协议、一堆延迟、调到怀疑人生。这次正好有机会完整体验一下基于曙光工业数智底座的“视控一体智能方案”,顺手用里面的核心平台——曙睿(SugonRI)2.0 工业编程平台跑了一个 YOLO Demo,就想着干脆写成一篇实测+方案解析,带大家从架构思路一路看到实际跑起来的效果。

一、 视控一体方案到底在干嘛?

先从痛点说起。

在绝大多数工厂里,视觉系统和控制系统基本是“两座孤岛”:摄像头和算法在一边干活,机器人、伺服、PLC 在另一边干活,两边靠 TCP/IP、IO 信号或者各种协议在“喊话”。

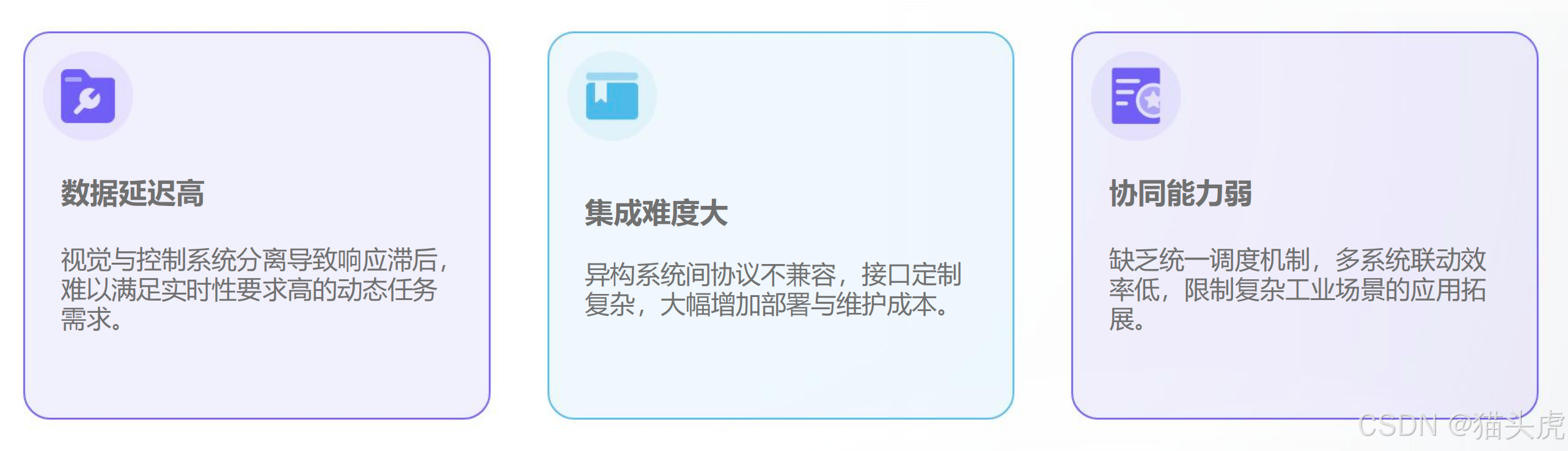

这样带来几个典型的问题:

数据传过去慢、控制反应不够快、视觉和动作配合不上。流水线上工件是动的、场景是变的,但系统往往还是“先看一眼,然后照着算好的轨迹慢慢走”,一旦节奏快一点,就容易出现“看得见,抓不到”的尴尬场面。

典型场景像是:无序流动工件的分拣、精密装配的实时位置校准、高速运动目标的动态抓取等等,这些对“视觉+控制”的协同要求非常高,而传统架构天然有短板。

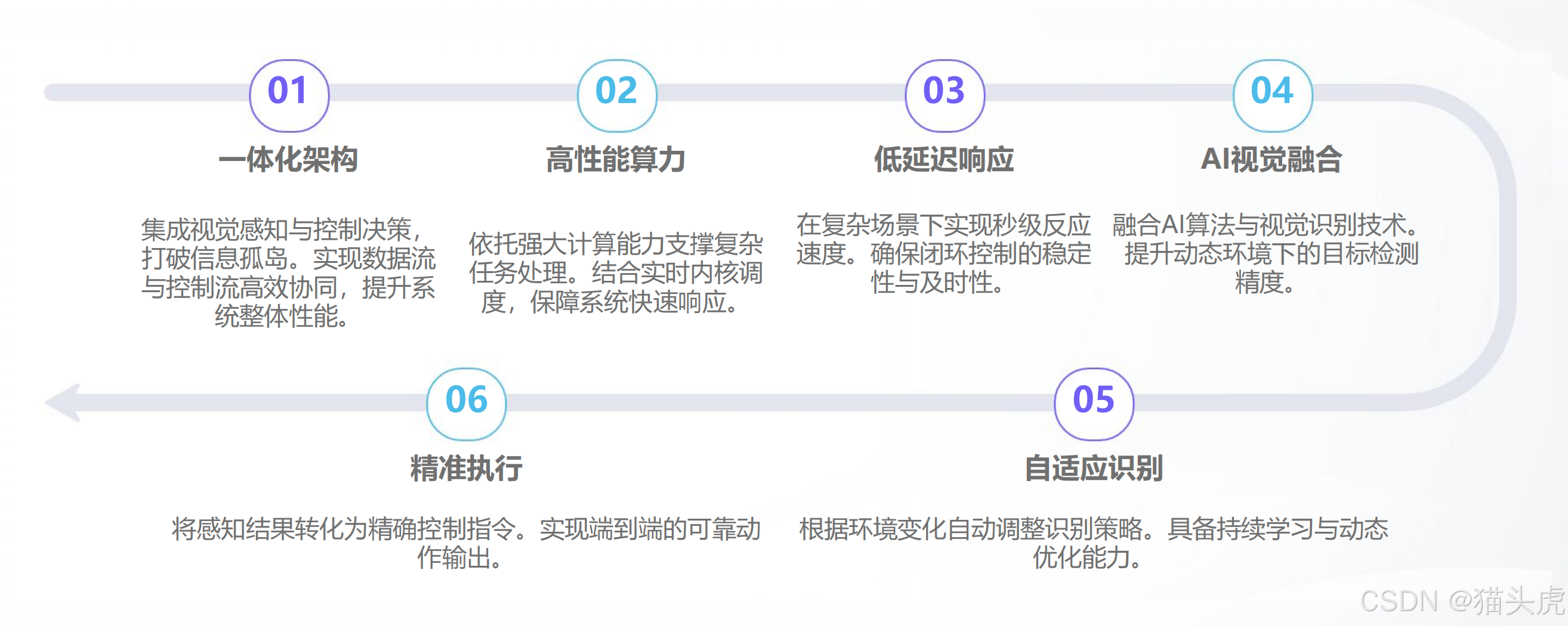

为了正面解决这些老问题,曙光网络做了一套完整的 “视控一体化智能平台”。它不是单独的视觉软件,也不是单独的运动控制,而是一整套把高性能 2D/3D 视觉、AI 深度学习和毫秒级实时运动控制揉在一起的底层技术架构。

简单理解就是:

视觉算法算出来的结果,不再是“慢悠悠地、绕几圈协议栈”才到控制系统,而是被高速、无缝地直接送进机器人或自动化设备的伺服控制环里,从“看到”到“动起来”的延迟被压得非常低,做到端到端接近微秒级。

这样的好处,就是让机器具备类似人类的“手眼协同”:看着目标,一边看一边改动作,实时地、动态地完成抓取、自适应装配、视觉伺服等任务。平台本身还配上低代码的视觉算法训练工具和一套开放接口,目标就是一句话:降低门槛,让视控一体方案真的能在产线里落地,而不是停留在 PPT 里。

二、从架构到落地:这套方案解决了哪些关键问题?

这一块我从三个我自己比较在意的“创新点”来聊,都是工程落地时会真切感受到的差异。

1. 深度融合的“感控一体”实时架构

先看第一个:实时性和协同性。

在传统方案里,视觉系统和控制系统通过 TCP/IP 或者 IO 信号通信,延迟动辄几十到几百毫秒。对于需要高速响应的工况,这种级别的延迟基本是“宣判死刑”:机器人来不及反应、目标已经移动到了另一边,于是就出现了各种“看着也挺准,就是抓不着”的故事。

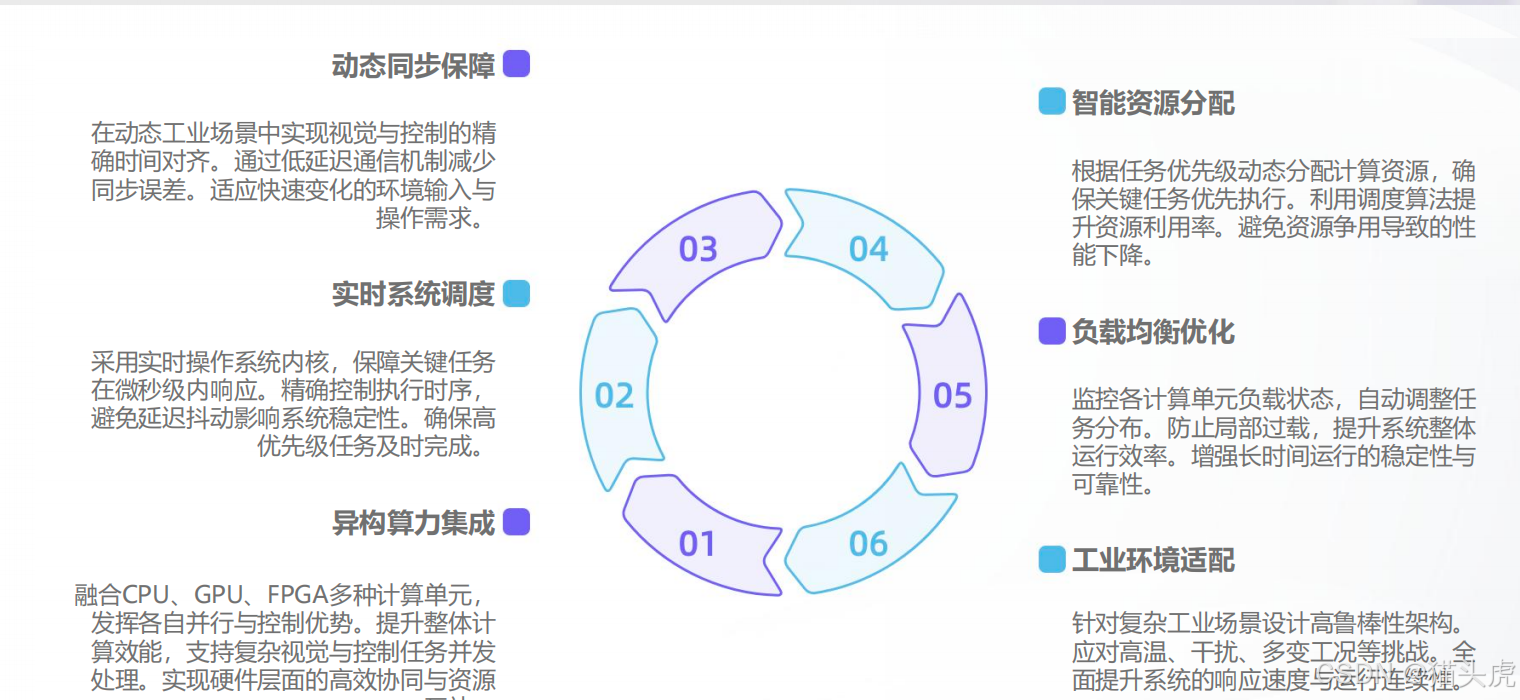

在这套视控一体平台里,底层做了一件关键的事:把视觉算力和实时控制融合在一套算力平台里。简单说,视觉处理和控制系统跑在同一硬件平台上,通过精细绑核,把实时操作系统和非实时操作系统合理分工调度。

运动控制的伺服循环通常是 1ms 左右一个周期,在这种架构下,它可以直接从共享内存里读到最新一帧的视觉处理结果,用作轨迹规划与修正的输入参数。

同时,平台还做了数据与时钟的精确同步,确保视觉数据帧和控制伺服周期对齐,尽量把传统协议栈带来的延迟和抖动压缩掉。

从实际效果来说,这种“感控一体”的好处非常直观:视觉反馈延迟显著下降,视觉伺服闭环真正跑得起来。机器不再是只会老老实实执行一条预设轨迹的“盲人”,而更像一个会盯着目标、实时调整自己动作的“熟练工”。

2. 零代码 / 低代码的视觉算法训练工具

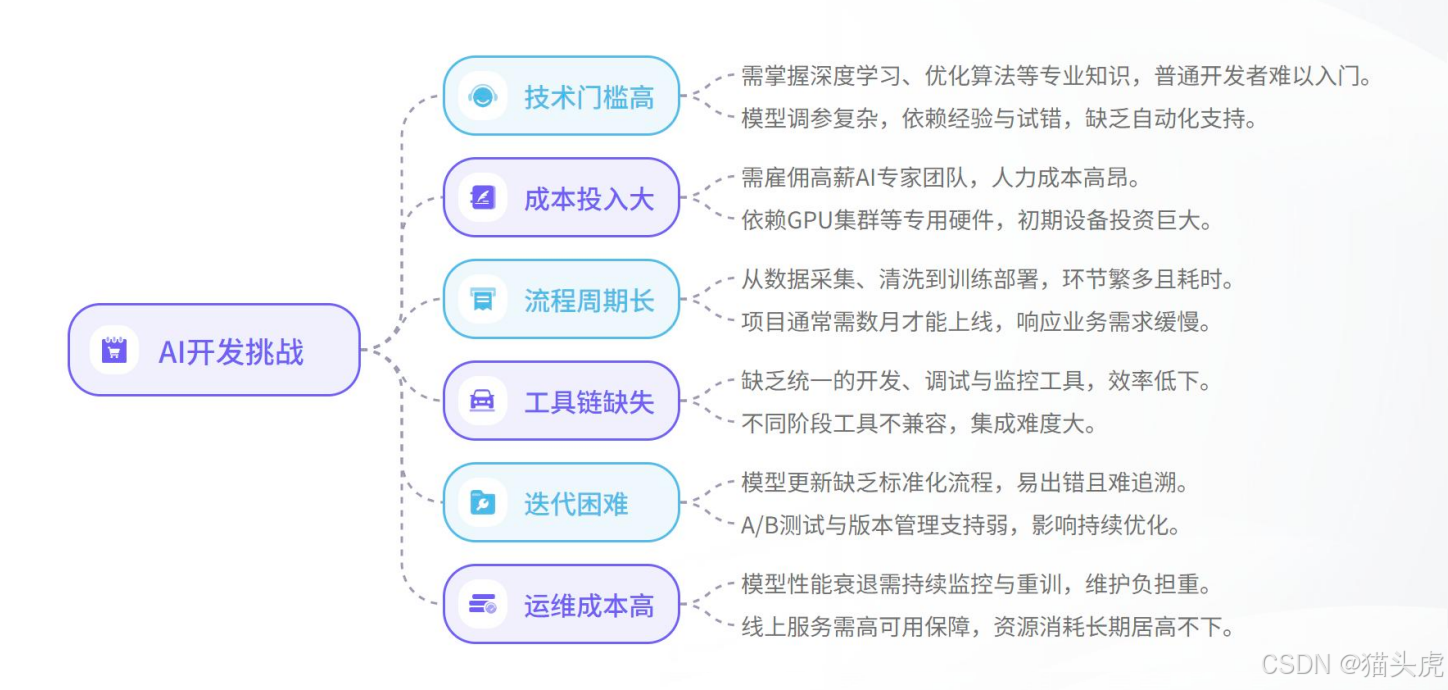

第二个点,是我个人非常关注的:谁来做算法、谁来调模型。

以前做一个 AI 视觉项目,通常要拉上专门的算法工程师团队,构建数据集、做标注、写训练代码、调超参、部署上线,每一步都挺重。对很多工厂里的 OT 团队来说,这几乎是“另一种语言”,门槛非常高,更别说快速迭代、频繁调整工艺。

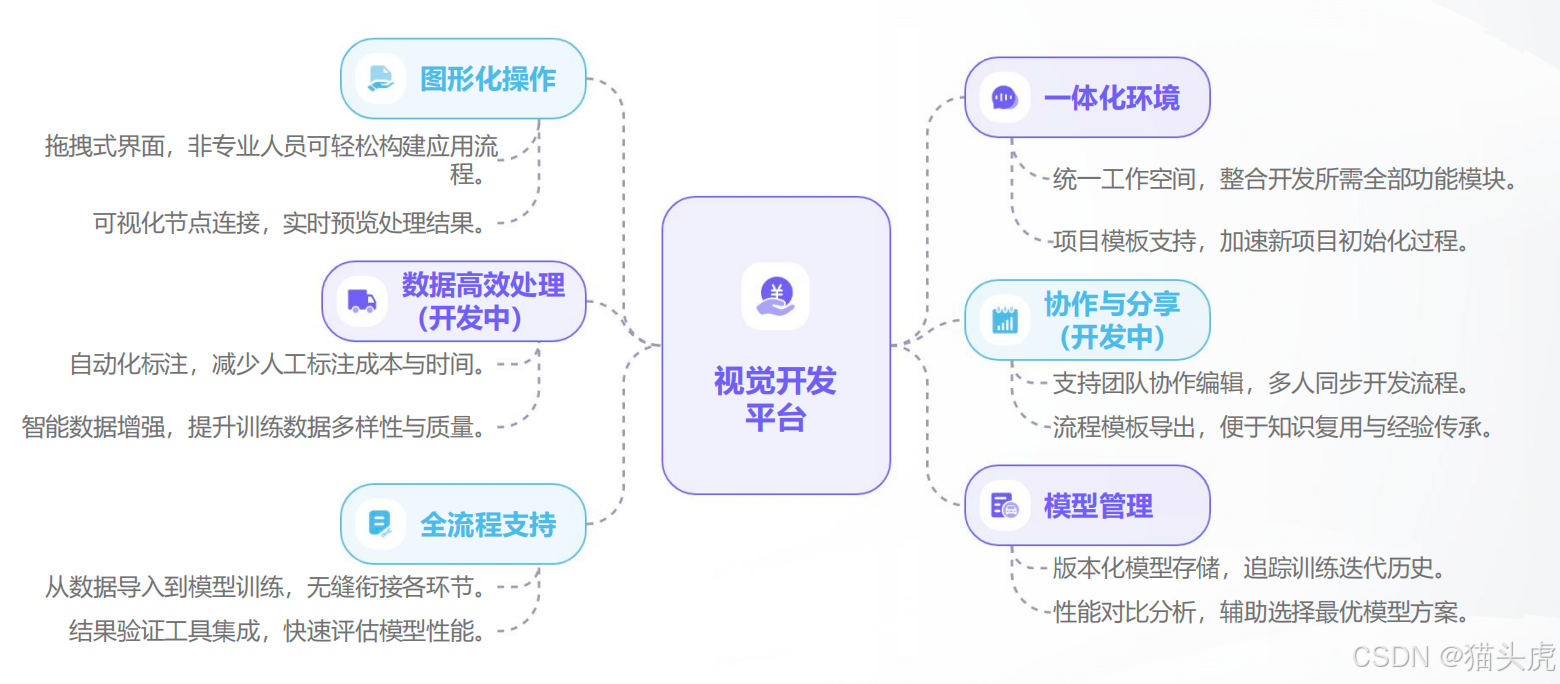

这里平台给出的思路是:把复杂的部分收进去,把可视化的部分抛出来。围绕这个目标,它提供了一套图形化的一站式视觉算法开发工具。

在这个工具里,你能做的事情大致包括:

可以通过图形界面串联流程,把采集、标注、训练、验证、部署组织成可视化的管线;

数据环节上,有 AI 辅助标注、自动数据增强之类的能力,帮你把枯燥重复的工作自动化掉一大块;

更关键的是,它内置了一整套针对工业场景调过优的预训练模型,覆盖缺陷检测、目标抓取、尺寸测量等典型任务,包括异常检测、分类、分割、目标检测等类型。你只需要上传自己场景里少量数据,做一个微调,而不是从头开始训练。

训练完成后,还有一个比较实用的点:一键部署。在工具里点一下,模型就会自动进行编译和优化,然后推送到生产环境,全程不要求你去写推理部署的代码。配合任务自启动、超参自动调优这些自动化机制,整个训练–部署闭环的人工成本会被明显拉下来。

用一句话来概括这个创新点的话,就是——让一线工程师和工艺专家也有机会成为 AI 落地项目的主角,而不是永远被动地等“算法团队排期”。

3. 标准化、开放式的控制集成接口

第三个问题,是系统集成时大家最头疼的那块: “这家视觉只支持那几个机器人”“协议不兼容怎么办” 之类的。

现实情况是,市面上视觉系统和控制设备品牌太多,各家接口都不太一样。项目一多,接口文档就能堆成一摞。每接一个品牌,都要重新适配、重新联调,方案难以复用,供应商锁定风险也很明显。

在这一点上,曙光平台给了一个比较工程化的解法:先定义好一套标准化的视觉控制接口,把视觉侧的能力抽象成统一的数据结构,再往下去兼容不同协议和控制设备。

例如,在上层,你不必去关心底层用的是哪一套目标检测算法,只需要通过统一的数据结构(比如 JSON 或 Protobuf 格式)拿到 object_id、位姿pose、速度velocity、置信度confidence 等关键字段,然后在控制程序里直接消费这些信息即可。

接口层同时配了一系列基础库和中间件,包括数学库、通讯中间件、控制中间件等,对控制程序开发者比较友好。底层协议上,支持 EtherCAT Master/Slave、Modbus TCP、MQTT 等主流工业协议,可以和市面上大部分机器人控制器、PLC 实现比较顺滑的集成。

对集成商或者甲方技术团队来说,这种做法的收益很直接:视觉能力和控制硬件彻底解耦,视觉平台可以作为一块标准化的“智能之眼”挂在不同设备上,方案的可复制性、可扩展性都强了很多,长期看也有助于降低整体拥有成本。

三、回到主角:曙睿(SugonRI)2.0 工业编程平台到底是什么?

聊完整体方案,再把视角拉回到这次实测的主角——曙睿(SugonRI)2.0 工业编程平台。在这整套视控一体方案里,它更像是“软件底座 + 工程中枢”。

官方定位是:基于 C/C++ 的工业可视化面向对象编程平台。

对于一直在 C/C++ 体系里做控制、做嵌入的来说,这一点亲切感还是挺强的。

它有一个挺有意思的设计:在 C/C++ 体系里引入了类似 PLC 世界里的 POU(程序组织单元) 概念,也就是说,可以更自然地把复杂的控制逻辑拆分成可复用的模块单元,用一种更接近工业工程师思维的方式去组织代码和项目,而不仅仅是一堆 .cpp / .h 文件散在工程里。

除此之外,平台支持图形化编程和文本编程并存,还能配合基于模型的系统工程(MBSE)方法做自顶向下或者自底向上的设计,比较适合大项目、长生命周期的工程管理。由于底层还是老朋友 C/C++,很多工业领域既有的开发习惯都能迁移过来。

适用的方向,官方给的是高端装备、工业自动化、测控仪器仪表、半实物仿真、工业物联网等,整体偏中高端工业应用。

结合前面讲的视控一体平台,它其实就是把这些复杂的功能,尽量落到一个统一、可视化、工程友好的开发环境里。

在这些能力之上,我这次选了一个大家比较熟悉的场景——YOLO 目标检测 Demo,来跑一遍完整流程,看看从安装、工程打开到部署设备端,再到最终识别效果,整个体验是怎样的。

四、跟着猫头虎跑一遍:曙睿 2.0 + YOLO Demo 实测过程

这一段我就按我自己的使用顺序来讲,尽量还原“第一次上手”时的体验。

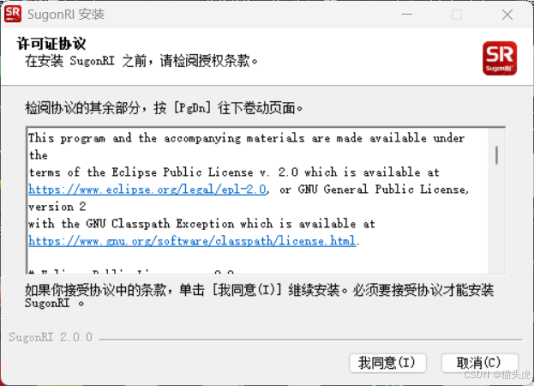

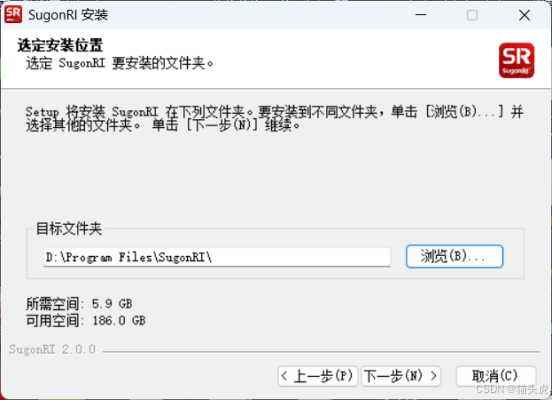

4.1 安装 IDE:整体比较顺畅

首先是安装 IDE。

双击 曙睿(SugonRI)2.0 安装程序.exe 之后,会先弹出安装向导界面,按惯例先是协议确认,读完(或者快速浏览一遍)之后,勾选同意继续往下。

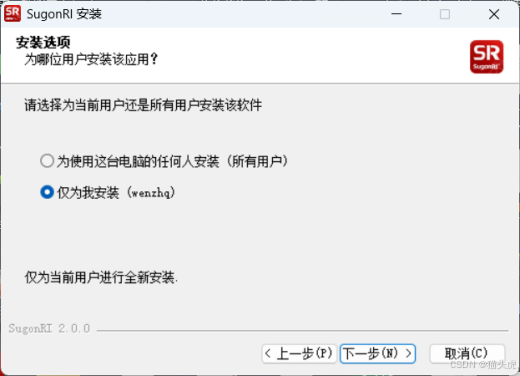

接下来是选择安装用户,我这边直接选了“仅为我安装”,比较符合个人开发环境的习惯。

然后是安装路径的选择。考虑到 C 盘空间,我把路径改到了 D 盘,你也可以根据自己的磁盘情况选择一个合适的目录。

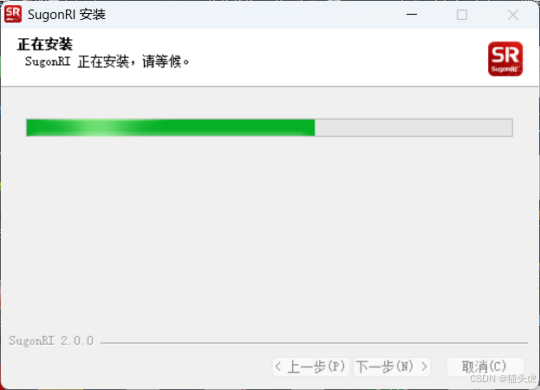

确认无误后,点击继续,等待安装进度条缓慢走完。

安装完成后,勾选“完成”或者手动启动,IDE 就能打开了。

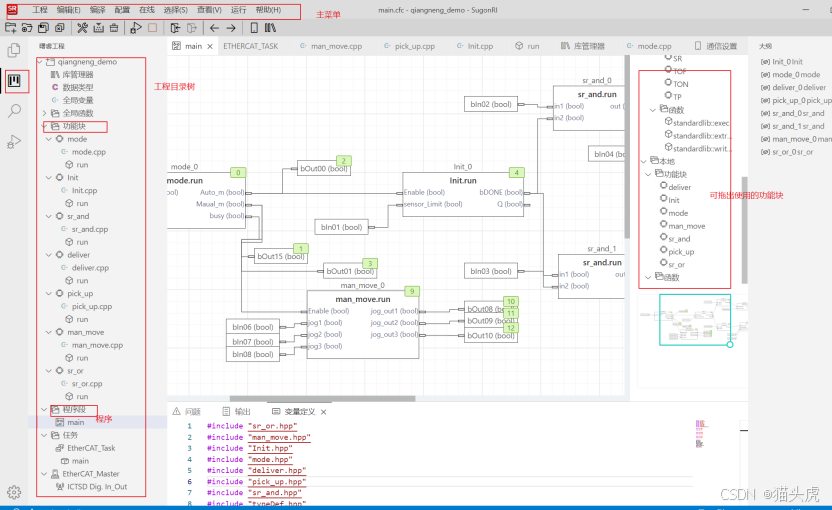

4.2 初见 IDE:界面风格和模块分布

第一次打开 曙睿(SugonRI)2.0 IDE,首页大概长这样:

整体是全中文界面,上手没有语言障碍。上方是一排主菜单和工具栏,左边是工程目录树,右边是功能模块区域,布局风格对有 PLC、工业软件使用经验的同学来说不会太陌生。

4.3 打开 YOLO Demo 工程

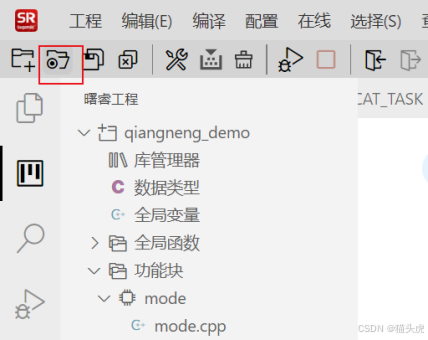

接下来就是今天的主角——YOLO Demo 了。

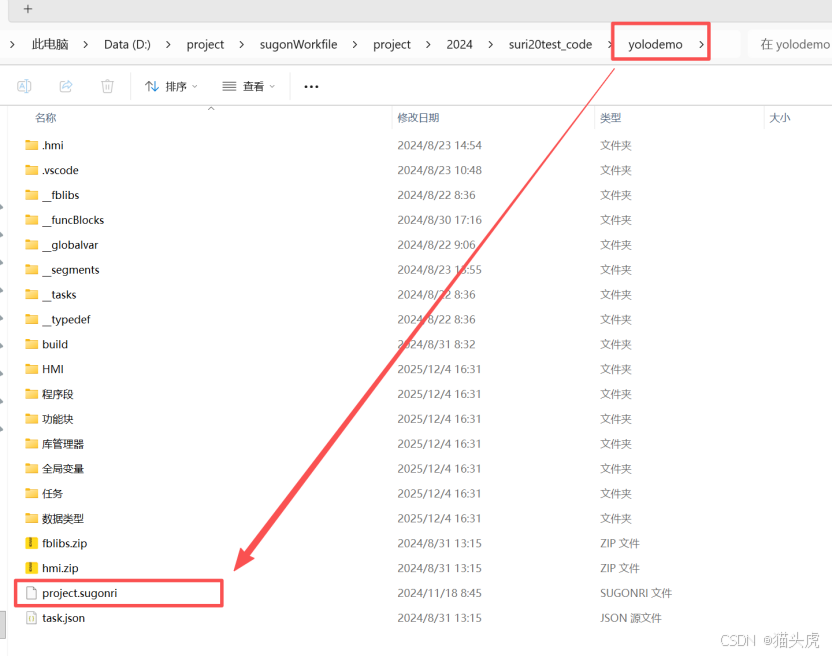

我这边是先把官方给的 YOLO 示例工程放在本地一个目录里,然后在 IDE 左上角点击“打开工程”的图标(第二个小图标),之后选择本地工程文件即可。

在对话框里找到 YOLO 工程所在路径,选中后确认打开。稍等片刻,就可以在左侧工程目录里看到一个 .sugonri 配置文件,这说明工程已经被曙睿的工程管理体系接管了。

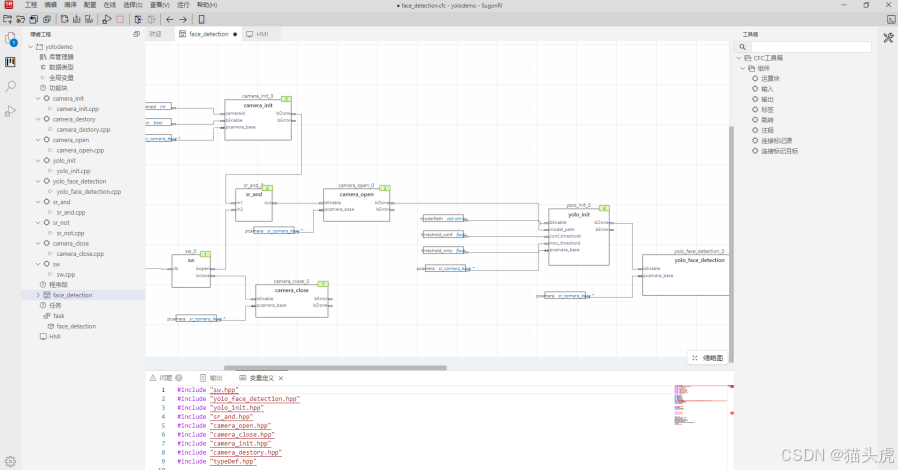

完整打开之后,整个工程层级大概是这样:

在这个基础上,可以点开看看各个模块的组织方式,包括视觉算法调用、数据流转、控制逻辑连接等。因为本篇重点不在“代码细节拆解”,我就不展开逐行说明了,更多是从“工程化体验”的角度看这件事。

4.4 调试完成后,打包并连接设备

本地把程序逻辑和参数调好以后,就可以进入部署和设备联调环节。

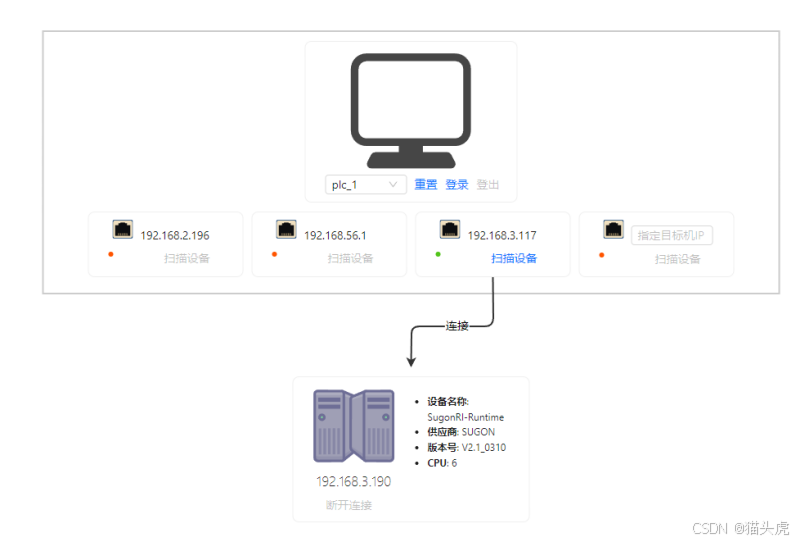

在我的环境里,测试设备和开发机在同一个局域网内,通过平台,可以把编译好的应用打包后发送到设备端运行。操作界面大致如下:

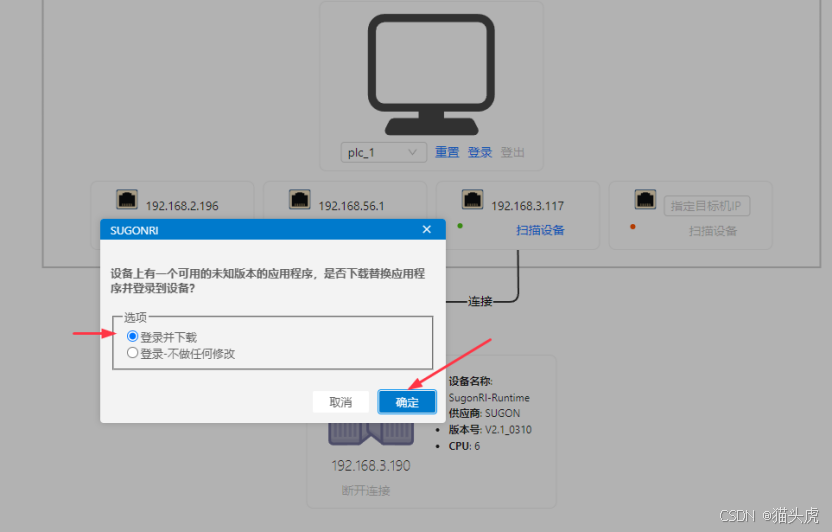

设备连接成功后,系统会检测当前设备上已有的版本,并提示是否更新下载新版的应用程序。如果你刚刚改动了工程,这一步当然是选择更新。

更新完成后,应用就会在设备端运行起来。到这一步为止,整个流程大致是:

本地开发调试 → 打包 → 通过局域网连接设备 → 下发新版应用 → 设备端运行。

4.5 实机视控效果:YOLO 识别跑起来是什么样?

最后就是大家最关心的“实测效果”了。

下面这张是设备端运行时的示意画面,可以看到来自视觉摄像头的画面以及叠加在上面的检测框、识别信息等。

通过曙睿 2.0 平台和视控一体底层架构的配合,可以比较直观地看到:

视觉侧的识别结果实时显示出来,同时这些结果也被送进控制侧用于动作规划,实现从“看见目标”到“执行动作”的连续闭环。

结合前面讲的架构,再看到这一组实际运行的画面,就能比较完整地把这套方案串起来:

上层的“视控一体智能平台”提供了从视觉处理到实时控制的整体能力,曙睿 2.0 作为开发和工程管理平台承接了具体实现,而 YOLO Demo 则是一个实际能跑起来的落地案例,把理念变成了可体验的应用。

五、结论:谁适合用这套东西?

从这次的体验来说,我个人对这套“视控一体 + 曙睿 2.0”的组合,大致有这样几个印象:

一是它确实在架构层面打通了视觉与控制之间的“壁垒”,不再是“看完再说话”,而是尽量把视觉反馈拉进控制闭环里,适合做动态、实时要求比较高的任务。

二是曙睿 2.0 这个平台把工程化这块做得比较系统,既照顾了 C/C++ 工程师的习惯,又往工业软件和 MBSE 靠,对大项目和长期维护会更友好。

三是配合低代码视觉工具和预训练模型,能一定程度上把 AI 视觉的门槛压下去,让现场工程师真正有能力参与到算法和应用的开发里。

如果结合实际应用场景来看的话,我觉得比较适合这样几类团队和项目:

- 内部有做视觉算法训练、模型部署需求的团队,希望有一套统一的工业开发平台承载这些能力;

- 集团层面的解决方案团队,需要在多个工厂、多个产线复制“视控一体”的做法,而不是每条线都从零开始重新集成;

- 想要构建自己工业数智底座、又不想被某一家设备或协议完全锁死的 OEM 厂商和系统集成商。

最后,一句话总结:

如果你正在为“视觉和控制两套系统难打通、AI 视觉项目落地周期长、方案复用性差”这些问题头疼,不妨亲自上手试一试 曙睿(SugonRI)2.0 和基于曙光工业数智底座打造的这套视控一体智能方案——它既是一套能写代码、能管工程的开发平台,也是一条可以复制到多条产线的工业智能化升级路径。猫头虎这次跑完 YOLO Demo,算是刚刚打开了它的一个侧面,后面如果有更复杂的实战项目,再来和大家继续聊。

更多推荐

已为社区贡献37条内容

已为社区贡献37条内容

所有评论(0)