生物信息学大模型应用全景指南:从序列预训练到临床转化的全流程落地(含微调 + 部署代码)

生物信息学大模型的出现,正打破传统研究的边界,从 “数据驱动” 走向 “知识驱动” 与 “数据驱动” 的深度融合。本文系统梳理了从数据预处理、预训练、微调、评估到部署的全流程,提供了可直接复用的实战代码与最佳实践,覆盖了基因分析、蛋白质预测、药物研发、临床诊断等核心应用场景。然而,大模型在生物信息学领域的落地并非一蹴而就,仍需解决数据、效率、可解释性、临床验证等多重挑战。

引言:生物信息学与大模型的双向奔赴

生物信息学作为生命科学与计算机科学的交叉学科,长期面临着数据爆炸与解析能力不足的矛盾。人类基因组计划完成以来,核酸序列、蛋白质结构、临床病历等多维度生物数据以指数级增长,仅 NCBI GenBank 数据库的序列数据总量已超 20TB,而传统机器学习模型在处理高维、非线性、强噪声的生物数据时,往往受限于特征工程的局限性和泛化能力不足的问题。

近年来,以 Transformer 架构为核心的大语言模型(LLM)掀起了人工智能领域的革命,其 “预训练 - 微调” 范式与生物信息学 “海量数据 - 特定任务” 的研究模式天然契合。从 AlphaFold2 破解蛋白质结构预测难题,到 ChatGPT 辅助生物医学文献分析,大模型正重构生物信息学的研究范式 —— 它不仅能自动挖掘生物数据中的深层规律,还能跨越 “序列 - 结构 - 功能 - 临床” 的多尺度鸿沟,为疾病诊断、药物研发、精准医疗等领域带来颠覆性突破。

本文将从生物信息学大模型的技术底层出发,系统梳理 “数据预处理 - 预训练 - 微调 - 评估 - 部署 - 临床转化” 的全流程,结合实战代码与最佳实践,为生物信息学从业者提供一套可落地、可复用的全景指南。

一、生物信息学大模型的技术基础与核心优势

1.1 核心技术架构:Transformer 与 “预训练 - 微调” 范式

生物信息学大模型的核心架构源于 Transformer(2017 年由 Vaswani 等人提出),其自注意力机制(Self-Attention)能够捕捉生物序列中的长程依赖关系(如 DNA 中的增强子 - 启动子相互作用、蛋白质中的跨结构域联系),这是传统 CNN/RNN 模型难以实现的。

关键技术组件:

- Tokenization(分词):将生物序列转化为模型可处理的基本单元,如 DNA 序列按 k-mer(常用 3-mer、6-mer)拆分,蛋白质序列按氨基酸残基或结构域拆分。

- 位置编码(Positional Encoding):生物序列的顺序至关重要(如 DNA 的碱基顺序决定基因功能),通过正弦 / 余弦函数或可学习位置编码,为 Token 注入位置信息。

- 多头注意力(Multi-Head Attention):并行计算多个注意力头,同时捕捉不同尺度的特征(如短程的碱基互补配对、长程的序列模体)。

- Feed-Forward Network(FFN):对注意力输出进行非线性变换,增强模型表达能力。

“预训练 - 微调” 范式:

- 预训练阶段:在海量无标注生物数据(如全基因组序列、UniProt 蛋白质库)上训练模型,学习通用生物规律(如密码子偏好性、蛋白质二级结构特征)。

- 微调阶段:使用小样本有标注数据(如特定疾病的基因突变数据、药物靶点相互作用数据)微调模型参数,适配具体任务(如疾病风险预测、药物活性分类)。

1.2 生物信息学大模型的核心优势

- 强特征学习能力:无需人工设计特征(如传统方法中的序列保守性评分、理化性质特征),自动从原始数据中挖掘高维特征。

- 跨模态融合能力:支持整合多源数据(如 DNA 序列 + 蛋白质结构 + 临床数据),构建多维度生物知识图谱。

- 泛化能力突出:在小样本场景下(如罕见病数据稀缺),通过预训练获得的通用知识,有效提升模型性能。

- 可解释性逐步增强:通过注意力权重可视化、特征归因分析(如 Integrated Gradients),揭示模型决策的生物机制(如哪个碱基突变导致疾病风险升高)。

1.3 主流生物信息学大模型分类

| 模型类型 | 代表模型 | 核心应用场景 | 数据来源 |

|---|---|---|---|

| DNA/RNA 大模型 | DNABERT、Enformer、RNA-BERT | 基因预测、突变效应分析、染色质相互作用预测 | GenBank、ENCODE、GTEx 数据库 |

| 蛋白质大模型 | AlphaFold2、ProtBERT、ESMFold | 蛋白质结构预测、功能注释、抗原 - 抗体结合预测 | UniProt、PDB、AlphaFold DB |

| 生物医学文本大模型 | BioBERT、PubMedBERT、ChatGPT-4 Bio | 文献检索、临床病历分析、知识问答 | PubMed、临床电子病历(EMR)、生物医学词典 |

| 多模态大模型 | CM3Leon、BioMedCLIP | 药物分子 - 靶点匹配、病理图像 - 文本关联 | ZINC(药物分子库)、TCGA(病理图像) |

二、全流程落地指南:从数据预处理到模型部署

2.1 数据预处理:生物数据的 “清洁与编码”

生物数据具有高噪声、异构性、格式不统一等特点,预处理质量直接决定模型性能。以下以 DNA 序列分类任务(如区分编码区 / 非编码区)为例,展示数据预处理的标准流程。

2.1.1 数据来源与格式

- 数据来源:ENCODE 数据库(编码区 / 非编码区序列)、UCSC Genome Browser(基因组序列)。

- 原始格式:FASTA 文件(> 序列 ID\n 碱基序列)、BED 文件(基因组区间)。

2.1.2 预处理步骤(Python 实战代码)

import pandas as pd

import numpy as np

from Bio import SeqIO

from sklearn.model_selection import train_test_split

from transformers import BertTokenizer

# 1. 读取FASTA文件(DNA序列)

def read_fasta(file_path):

sequences = []

labels = [] # 1: 编码区, 0: 非编码区

for record in SeqIO.parse(file_path, "fasta"):

seq = str(record.seq).upper() # 统一转为大写

# 过滤含N(未知碱基)的序列

if "N" not in seq and len(seq) >= 50: # 序列长度≥50bp

sequences.append(seq)

# 根据序列ID判断标签(假设ID含"coding"为编码区)

if "coding" in record.id:

labels.append(1)

else:

labels.append(0)

return pd.DataFrame({"sequence": sequences, "label": labels})

# 2. 数据清洗与过滤

df = read_fasta("dna_sequences.fasta")

# 去除重复序列

df = df.drop_duplicates(subset="sequence")

# 平衡数据集(避免类别偏倚)

coding_seq = df[df["label"] == 1]

non_coding_seq = df[df["label"] == 0].sample(n=len(coding_seq), random_state=42)

df_balanced = pd.concat([coding_seq, non_coding_seq]).reset_index(drop=True)

# 3. Tokenization(k-mer分词,以3-mer为例)

class KmerTokenizer:

def __init__(self, k=3):

self.k = k

self.vocab = self.build_vocab()

def build_vocab(self):

# 构建DNA 3-mer词汇表(A/T/C/G的所有组合)

bases = ["A", "T", "C", "G"]

vocab = {}

idx = 0

for i in bases:

for j in bases:

for k in bases:

vocab[i+j+k] = idx

idx += 1

vocab["<PAD>"] = idx # 填充符

vocab["<UNK>"] = idx + 1 # 未知token

return vocab

def tokenize(self, seq):

# 将序列拆分为3-mer

kmers = [seq[i:i+self.k] for i in range(len(seq)-self.k+1)]

# 转换为词汇表索引

tokens = [self.vocab[kmer] if kmer in self.vocab else self.vocab["<UNK>"] for kmer in kmers]

return tokens

# 初始化分词器并处理序列

tokenizer = KmerTokenizer(k=3)

df_balanced["tokens"] = df_balanced["sequence"].apply(tokenizer.tokenize)

# 4. 序列填充/截断(统一长度为128)

max_len = 128

def pad_truncate(tokens):

if len(tokens) < max_len:

tokens += [tokenizer.vocab["<PAD>"]] * (max_len - len(tokens))

else:

tokens = tokens[:max_len]

return tokens

df_balanced["tokens_padded"] = df_balanced["tokens"].apply(pad_truncate)

# 5. 划分训练集/验证集/测试集(8:1:1)

X = np.array(df_balanced["tokens_padded"].tolist())

y = np.array(df_balanced["label"].tolist())

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.2, random_state=42, stratify=y)

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42, stratify=y_temp)

# 保存处理后的数据

np.savez("dna_processed_data.npz", X_train=X_train, X_val=X_val, X_test=X_test, y_train=y_train, y_val=y_val, y_test=y_test)

print("数据预处理完成,训练集规模:", len(X_train))

关键注意事项:

- 数据质量控制:过滤含未知碱基(N)、低质量序列(如测序错误率高)的数据。

- 类别平衡:生物数据常存在类别偏倚(如罕见病样本少),可通过过采样(SMOTE)、欠采样或加权损失函数解决。

- Tokenization 策略:DNA 序列常用 k-mer(3-mer~6-mer),蛋白质序列可直接用氨基酸残基(20 种天然氨基酸 + 特殊符号)。

2.2 预训练:构建生物专属大模型

预训练是大模型获取通用生物知识的核心步骤,需基于海量无标注数据进行。以下以 DNA 序列预训练为例,介绍基于 Transformer 的预训练流程。

2.2.1 预训练任务设计

生物序列预训练任务需贴合数据特性,常用任务包括:

- 掩码语言模型(Masked Language Model, MLM):随机掩码部分 Token(如 DNA 序列中 15% 的 3-mer),让模型预测被掩码的 Token。

- -next Sentence Prediction(NSP):判断两个序列片段是否来自同一条原始序列(适用于长序列建模)。

- 序列重构(Sequence Reconstruction):随机打乱部分序列片段,让模型恢复原始顺序。

2.2.2 预训练模型实现(PyTorch 代码)

import torch

import torch.nn as nn

from torch.utils.data import Dataset, DataLoader

from transformers import BertPreTrainedModel, BertModel, BertConfig

# 1. 定义数据集类

class DNAPretrainDataset(Dataset):

def __init__(self, tokens, mask_prob=0.15):

self.tokens = tokens

self.mask_prob = mask_prob

self.vocab_size = 66 # 3-mer词汇表大小(4^3=64 + <PAD> + <UNK>)

def __len__(self):

return len(self.tokens)

def mask_tokens(self, tokens):

# 实现MLM掩码逻辑

tokens = torch.tensor(tokens, dtype=torch.long)

labels = tokens.clone()

# 随机选择掩码位置

mask = torch.rand(tokens.shape) < self.mask_prob

# 80%替换为<UNK>,10%替换为随机Token,10%保持不变

for i in range(len(tokens)):

if mask[i]:

if torch.rand(1) < 0.8:

tokens[i] = 65 # <UNK>的索引

elif torch.rand(1) < 0.5:

tokens[i] = torch.randint(0, 64, (1,)) # 随机Token

return tokens, labels

def __getitem__(self, idx):

tokens = self.tokens[idx]

input_ids, labels = self.mask_tokens(tokens)

attention_mask = (input_ids != 64).long() # <PAD>的注意力掩码为0

return {"input_ids": input_ids, "attention_mask": attention_mask, "labels": labels}

# 2. 加载预训练数据(大量无标注DNA序列的Token)

pretrain_tokens = np.load("dna_pretrain_tokens.npy", allow_pickle=True).tolist()

dataset = DNAPretrainDataset(pretrain_tokens)

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

# 3. 定义DNA-BERT预训练模型

class DNABertForPretraining(BertPreTrainedModel):

def __init__(self, config):

super().__init__(config)

self.bert = BertModel(config)

self.cls = nn.Linear(config.hidden_size, config.vocab_size)

self.init_weights()

def forward(self, input_ids, attention_mask=None, labels=None):

outputs = self.bert(input_ids=input_ids, attention_mask=attention_mask)

logits = self.cls(outputs.last_hidden_state)

loss = None

if labels is not None:

loss_fct = nn.CrossEntropyLoss(ignore_index=64) # 忽略<PAD>的损失

loss = loss_fct(logits.reshape(-1, self.config.vocab_size), labels.reshape(-1))

return {"loss": loss, "logits": logits}

# 4. 初始化模型配置

config = BertConfig(

vocab_size=66, # 3-mer词汇表大小

hidden_size=768,

num_hidden_layers=12,

num_attention_heads=12,

intermediate_size=3072,

max_position_embeddings=128,

hidden_dropout_prob=0.1,

attention_probs_dropout_prob=0.1,

)

model = DNABertForPretraining(config)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

# 5. 预训练训练循环

optimizer = torch.optim.AdamW(model.parameters(), lr=2e-5, weight_decay=0.01)

epochs = 10

for epoch in range(epochs):

model.train()

total_loss = 0

for batch in dataloader:

input_ids = batch["input_ids"].to(device)

attention_mask = batch["attention_mask"].to(device)

labels = batch["labels"].to(device)

optimizer.zero_grad()

outputs = model(input_ids=input_ids, attention_mask=attention_mask, labels=labels)

loss = outputs["loss"]

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Epoch {epoch+1}/{epochs}, Average Loss: {avg_loss:.4f}")

# 保存预训练模型

model.save_pretrained("dna_bert_pretrained")

print("预训练模型保存完成!")

预训练优化策略:

- 数据规模:预训练数据量越大,模型性能越好(建议至少 10 万条序列),可通过多数据库合并(如 GenBank+Ensembl)扩充数据。

- 硬件加速:使用 GPU(如 A100)或 TPU 加速训练,长序列建模可采用梯度检查点(Gradient Checkpointing)节省显存。

- 学习率调度:采用线性学习率预热(Warmup)+ 余弦退火调度,避免训练初期梯度震荡。

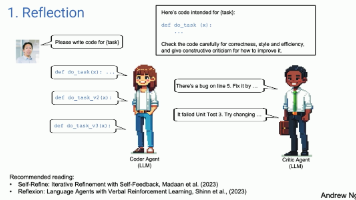

2.3 微调:适配具体生物信息学任务

预训练模型具备通用生物知识,需通过微调适配特定任务(如基因突变效应预测、蛋白质功能分类、药物活性预测)。以下以 “基因突变致病性预测” 任务为例,展示微调流程。

2.3.1 微调任务与数据准备

- 任务描述:给定 DNA 序列的突变位点(如 SNP),预测该突变是否为致病性突变(二元分类)。

- 数据来源:ClinVar 数据库(致病性 / 良性突变数据),每条数据包含 “野生型序列 + 突变位点 + 标签”。

2.3.2 微调代码实现

import torch

import torch.nn as nn

from torch.utils.data import Dataset, DataLoader

from transformers import BertPreTrainedModel, BertModel, Trainer, TrainingArguments

from sklearn.metrics import accuracy_score, precision_recall_fscore_support

# 1. 定义微调数据集

class MutationDataset(Dataset):

def __init__(self, sequences, mutations, labels, tokenizer, max_len=128):

self.sequences = sequences # 野生型DNA序列

self.mutations = mutations # 突变信息(如"A123T")

self.labels = labels # 1: 致病性, 0: 良性

self.tokenizer = tokenizer

self.max_len = max_len

def __len__(self):

return len(self.sequences)

def __getitem__(self, idx):

seq = self.sequences[idx]

mutation = self.mutations[idx]

# 将突变信息嵌入序列(如在突变位点前后添加特殊标记)

pos = int(mutation[1:-1]) - 1 # 突变位点位置(0-based)

seq_with_mutation = seq[:pos] + "[MUT]" + seq[pos:]

# Tokenize序列

tokens = self.tokenizer.tokenize(seq_with_mutation)

tokens = tokens[:self.max_len] # 截断

input_ids = torch.tensor([self.tokenizer.vocab.get(token, self.tokenizer.vocab["<UNK>"]) for token in tokens])

attention_mask = (input_ids != self.tokenizer.vocab["<PAD>"]).long()

label = torch.tensor(self.labels[idx], dtype=torch.long)

return {"input_ids": input_ids, "attention_mask": attention_mask, "label": label}

# 2. 加载预训练模型和分词器

from transformers import BertTokenizerFast

tokenizer = KmerTokenizer(k=3) # 复用预训练的分词器

model = DNABertForClassification.from_pretrained("dna_bert_pretrained", num_labels=2)

model.to(device)

# 3. 加载微调数据

df_finetune = pd.read_csv("mutation_data.csv") # 包含sequence, mutation, label列

dataset = MutationDataset(

sequences=df_finetune["sequence"].tolist(),

mutations=df_finetune["mutation"].tolist(),

labels=df_finetune["label"].tolist(),

tokenizer=tokenizer

)

# 划分训练集/验证集

train_size = int(0.8 * len(dataset))

val_size = len(dataset) - train_size

train_dataset, val_dataset = torch.utils.data.random_split(dataset, [train_size, val_size])

# 4. 定义评估指标

def compute_metrics(eval_pred):

logits, labels = eval_pred

predictions = torch.argmax(torch.tensor(logits), dim=1).numpy()

precision, recall, f1, _ = precision_recall_fscore_support(labels, predictions, average="binary")

accuracy = accuracy_score(labels, predictions)

return {"accuracy": accuracy, "f1": f1, "precision": precision, "recall": recall}

# 5. 微调训练配置

training_args = TrainingArguments(

output_dir="dna_bert_finetuned",

per_device_train_batch_size=16,

per_device_eval_batch_size=16,

num_train_epochs=5,

learning_rate=1e-5,

weight_decay=0.01,

logging_dir="logs",

logging_steps=10,

evaluation_strategy="epoch",

save_strategy="epoch",

load_best_model_at_end=True,

metric_for_best_model="f1",

fp16=torch.cuda.is_available() # 混合精度训练

)

# 6. 初始化Trainer并开始微调

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset,

eval_dataset=val_dataset,

compute_metrics=compute_metrics

)

trainer.train()

# 7. 保存微调后的模型

trainer.save_model("dna_bert_finetuned_mutation")

print("微调完成,模型保存至dna_bert_finetuned_mutation/")

微调关键技巧:

- 学习率选择:微调学习率通常为预训练的 1/10~1/100(如预训练 2e-5,微调 1e-5),避免覆盖预训练的通用知识。

- 冻结层策略:对于小样本任务,可冻结 Transformer 底层(如前 6 层),仅训练顶层分类器,减少过拟合。

- 数据增强:生物序列数据增强方法包括:DNA 序列反向互补、随机插入 / 删除短片段、替换同义密码子等。

2.4 模型评估:生物信息学专属指标体系

生物信息学任务的评估需结合领域特性,不能仅依赖准确率(Accuracy),以下是常用评估指标与实现方法。

2.4.1 分类任务评估指标(如疾病预测、突变致病性判断)

- 核心指标:准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1 分数、AUC-ROC、AUC-PR(精确率 - 召回率曲线下面积)。

- 代码实现:

from sklearn.metrics import roc_auc_score, average_precision_score, classification_report

# 加载测试集并预测

test_dataset = MutationDataset(...) # 测试集数据

test_dataloader = DataLoader(test_dataset, batch_size=16)

model.eval()

all_preds = []

all_labels = []

with torch.no_grad():

for batch in test_dataloader:

input_ids = batch["input_ids"].to(device)

attention_mask = batch["attention_mask"].to(device)

labels = batch["label"].cpu().numpy()

outputs = model(input_ids=input_ids, attention_mask=attention_mask)

preds = torch.softmax(outputs["logits"], dim=1).cpu().numpy()[:, 1] # 预测为致病性的概率

all_preds.extend(preds)

all_labels.extend(labels)

# 计算指标

auc_roc = roc_auc_score(all_labels, all_preds)

auc_pr = average_precision_score(all_labels, all_preds)

preds_binary = [1 if p >= 0.5 else 0 for p in all_preds]

report = classification_report(all_labels, preds_binary, target_names=["良性", "致病性"])

print(f"AUC-ROC: {auc_roc:.4f}")

print(f"AUC-PR: {auc_pr:.4f}")

print("分类报告:")

print(report)

2.4.2 序列预测任务评估指标(如基因预测、蛋白质结构预测)

- 基因预测:敏感性(Sensitivity)、特异性(Specificity)、马修斯相关系数(MCC)、序列一致性(Sequence Identity)。

- 蛋白质结构预测:RMSD(均方根偏差)、TM-score(模板建模分数)、GDT-TS(全局距离测试总分)。

2.4.3 模型可解释性评估

生物信息学模型需具备可解释性才能落地(如临床诊断需说明决策依据),常用方法:

- 注意力权重可视化:展示模型关注的序列片段(如哪个碱基对突变致病性判断至关重要)。

- 特征归因分析:使用 Integrated Gradients 计算每个 Token 对预测结果的贡献度。

- 生物验证:通过湿实验验证模型预测结果(如体外实验验证突变对蛋白质功能的影响)。

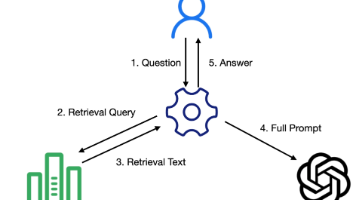

2.5 模型部署:从实验室到临床的工程化落地

模型训练完成后,需通过工程化部署,转化为可实际应用的工具(如临床诊断系统、药物研发平台)。以下介绍两种主流部署方式:API 服务部署与本地桌面应用部署。

2.5.1 API 服务部署(FastAPI + Uvicorn)

将模型封装为 RESTful API,支持跨平台调用(如 Web 前端、手机 APP)。

# 1. 模型服务代码(main.py)

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

import torch

from transformers import BertTokenizerFast

import numpy as np

# 初始化FastAPI应用

app = FastAPI(title="DNA突变致病性预测API", version="1.0")

# 定义请求体格式

class MutationRequest(BaseModel):

sequence: str # 野生型DNA序列

mutation: str # 突变信息(如"A123T")

# 加载微调后的模型和分词器

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

tokenizer = KmerTokenizer(k=3)

model = DNABertForClassification.from_pretrained("dna_bert_finetuned_mutation").to(device)

model.eval()

# 定义预测函数

def predict_mutation(sequence, mutation):

# 预处理序列(与微调时一致)

pos = int(mutation[1:-1]) - 1

seq_with_mutation = sequence[:pos] + "[MUT]" + sequence[pos:]

tokens = tokenizer.tokenize(seq_with_mutation)[:128]

input_ids = torch.tensor([tokenizer.vocab.get(token, tokenizer.vocab["<UNK>"]) for token in tokens]).unsqueeze(0).to(device)

attention_mask = (input_ids != tokenizer.vocab["<PAD>"]).long().to(device)

# 模型预测

with torch.no_grad():

outputs = model(input_ids=input_ids, attention_mask=attention_mask)

prob = torch.softmax(outputs["logits"], dim=1).cpu().numpy()[0]

pred_label = int(prob[1] >= 0.5)

pred_desc = "致病性" if pred_label == 1 else "良性"

return {

"mutation": mutation,

"predicted_label": pred_label,

"predicted_description": pred_desc,

"pathogenic_probability": float(prob[1]),

"benign_probability": float(prob[0])

}

# 定义API端点

@app.post("/predict", response_model=dict)

async def predict(request: MutationRequest):

try:

# 验证输入序列合法性

if not all(base in ["A", "T", "C", "G", "N"] for base in request.sequence.upper()):

raise HTTPException(status_code=400, detail="序列包含非法碱基,仅支持A/T/C/G/N")

# 调用预测函数

result = predict_mutation(request.sequence.upper(), request.mutation)

return result

except Exception as e:

raise HTTPException(status_code=500, detail=str(e))

# 健康检查端点

@app.get("/health")

async def health_check():

return {"status": "healthy", "model": "dna_bert_finetuned_mutation"}

# 2. 启动服务(终端命令)

# uvicorn main:app --host 0.0.0.0 --port 8000 --workers 4

2.5.2 本地桌面应用部署(PyQt5)

为非技术用户(如临床医生、实验人员)开发桌面应用,支持图形化操作。

import sys

from PyQt5.QtWidgets import (QApplication, QMainWindow, QWidget, QVBoxLayout, QHBoxLayout,

QLabel, QLineEdit, QPushButton, QTextEdit)

import torch

from transformers import BertTokenizerFast

class MutationPredictorApp(QMainWindow):

def __init__(self):

super().__init__()

self.setWindowTitle("DNA突变致病性预测工具")

self.setGeometry(100, 100, 800, 500)

# 加载模型和分词器

self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

self.tokenizer = KmerTokenizer(k=3)

self.model = DNABertForClassification.from_pretrained("dna_bert_finetuned_mutation").to(self.device)

self.model.eval()

# 构建UI

self.init_ui()

def init_ui(self):

central_widget = QWidget()

self.setCentralWidget(central_widget)

layout = QVBoxLayout(central_widget)

# 序列输入区域

seq_layout = QHBoxLayout()

seq_label = QLabel("DNA序列:")

self.seq_input = QLineEdit()

self.seq_input.setPlaceholderText("输入野生型DNA序列(仅含A/T/C/G)")

seq_layout.addWidget(seq_label)

seq_layout.addWidget(self.seq_input)

layout.addLayout(seq_layout)

# 突变输入区域

mut_layout = QHBoxLayout()

mut_label = QLabel("突变信息:")

self.mut_input = QLineEdit()

self.mut_input.setPlaceholderText("输入突变(如A123T,格式:野生型碱基+位置+突变后碱基)")

mut_layout.addWidget(mut_label)

mut_layout.addWidget(self.mut_input)

layout.addLayout(mut_layout)

# 预测按钮

self.predict_btn = QPushButton("开始预测")

self.predict_btn.clicked.connect(self.predict)

layout.addWidget(self.predict_btn)

# 结果显示区域

self.result_display = QTextEdit()

self.result_display.setReadOnly(True)

layout.addWidget(self.result_display)

def predict(self):

sequence = self.seq_input.text().strip().upper()

mutation = self.mut_input.text().strip()

# 输入验证

if not sequence or not mutation:

self.result_display.setText("错误:序列和突变信息不能为空!")

return

if not all(base in ["A", "T", "C", "G"] for base in sequence):

self.result_display.setText("错误:序列包含非法碱基,仅支持A/T/C/G!")

return

# 模型预测

try:

pos = int(mutation[1:-1]) - 1

seq_with_mutation = sequence[:pos] + "[MUT]" + sequence[pos:]

tokens = self.tokenizer.tokenize(seq_with_mutation)[:128]

input_ids = torch.tensor([self.tokenizer.vocab.get(token, self.tokenizer.vocab["<UNK>"]) for token in tokens]).unsqueeze(0).to(self.device)

attention_mask = (input_ids != self.tokenizer.vocab["<PAD>"]).long().to(self.device)

with torch.no_grad():

outputs = self.model(input_ids=input_ids, attention_mask=attention_mask)

prob = torch.softmax(outputs["logits"], dim=1).cpu().numpy()[0]

pred_label = "致病性" if prob[1] >= 0.5 else "良性"

# 显示结果

result = f"""

预测结果:

- 突变信息:{mutation}

- 预测类别:{pred_label}

- 致病性概率:{prob[1]:.4f}

- 良性概率:{prob[0]:.4f}

注:本工具仅为辅助分析,最终结果需结合临床实验验证。

"""

self.result_display.setText(result)

except Exception as e:

self.result_display.setText(f"预测失败:{str(e)}")

if __name__ == "__main__":

app = QApplication(sys.argv)

window = MutationPredictorApp()

window.show()

sys.exit(app.exec_())

部署优化建议:

- 模型压缩:使用量化(Quantization)、剪枝(Pruning)减少模型体积,提升推理速度(如将 FP32 量化为 INT8,模型体积减少 75%)。

- 硬件加速:CPU 推理可使用 OpenVINO 优化,GPU 推理可使用 TensorRT 加速,边缘设备(如医院终端)可部署到 NVIDIA Jetson 平台。

- 高可用设计:API 服务部署可采用负载均衡(Nginx)、容器化(Docker)+ Kubernetes 编排,确保服务稳定运行。

- 数据安全:临床数据需符合隐私保护法规(如 HIPAA、GDPR),部署时需加密数据传输(HTTPS)、限制访问权限。

三、典型应用场景与案例分析

3.1 基因与基因组分析

- 核心应用:基因预测、突变效应分析、染色质三维结构预测、基因表达调控网络构建。

- 案例:DeepMind 的 Enformer 模型,基于 Transformer 架构预测基因表达调控,在 ENCODE 数据集上的预测准确率超过传统模型 30%,能够捕捉 100kb 范围内的长程染色质相互作用,为非编码 RNA 功能注释提供了强大工具。

- 代码扩展:可基于本文预训练代码,增加 NSP 任务(Next Sentence Prediction),适配染色质相互作用预测任务。

3.2 蛋白质结构与功能预测

- 核心应用:蛋白质二级 / 三级结构预测、酶活性预测、蛋白质 - 蛋白质相互作用(PPI)预测、抗原 - 抗体结合预测。

- 案例:AlphaFold2 通过注意力机制和多序列比对(MSA),实现了蛋白质结构的原子级精度预测,在 CASP14 竞赛中超越所有传统方法,目前已预测超过 2 亿个蛋白质结构(AlphaFold DB),极大加速了结构生物学研究。

- 实战建议:使用 ESMFold(Meta 提出的快速蛋白质结构预测模型)进行微调,其推理速度比 AlphaFold2 快 100 倍,适合大规模蛋白质功能筛选。

3.3 药物研发与设计

- 核心应用:药物靶点识别、化合物活性预测、药物分子生成、药物重定位(Drug Repurposing)。

- 案例:Insilico Medicine 的 GPT4Mol 模型,基于 Transformer 架构生成新型药物分子,成功设计出针对特发性肺纤维化的候选药物 INS018_055,已进入临床试验 Ⅰ 期,将传统药物研发周期从 10 年缩短至 18 个月。

- 代码扩展:将本文的 DNA 序列 Tokenizer 替换为分子 SMILES 字符串 Tokenizer(如 ChemBERTa 的 Tokenizer),即可适配药物分子活性预测任务。

3.4 临床诊断与精准医疗

- 核心应用:疾病风险预测、罕见病诊断、肿瘤分型、个性化治疗方案推荐。

- 案例:Mayo Clinic 开发的基于 PubMedBERT 的临床病历分析模型,能够从电子病历中自动提取患者的基因突变信息、症状特征,辅助医生进行罕见病诊断,诊断准确率达到 89%,为罕见病患者平均节省 6 个月的确诊时间。

- 落地挑战:临床数据隐私保护、模型可解释性不足、不同医院数据格式不统一,需通过联邦学习(Federated Learning)、可解释 AI(XAI)技术解决。

四、挑战与未来展望

4.1 当前面临的核心挑战

- 数据瓶颈:高质量标注数据稀缺(如罕见病数据)、多源数据整合困难(如序列数据与临床数据格式异构)。

- 模型效率:大模型训练 / 推理成本高(如 AlphaFold2 训练需数千 GPU 小时)、长序列建模(如全基因组序列)的显存限制。

- 可解释性:现有模型多为 “黑箱”,难以解释预测结果的生物机制,限制了临床转化。

- 临床落地障碍:缺乏统一的模型评估标准、临床数据隐私保护严格、医生对 AI 工具的信任度不足。

4.2 未来发展趋势

- 多模态融合:整合 DNA/RNA 序列、蛋白质结构、病理图像、临床数据等多源信息,构建 “生命全景” 大模型。

- 高效模型设计:开发针对生物数据的专用 Transformer 变体(如稀疏注意力、分层注意力),降低训练 / 推理成本。

- 可解释 AI 与因果推断:结合生物知识图谱,让模型能够基于因果关系进行预测,而非单纯的相关性拟合。

- 联邦学习与边缘计算:在保护数据隐私的前提下,实现多中心数据联合训练,将模型部署到医院边缘设备,提升诊断效率。

- 通用生物智能体:构建能够自主设计实验、分析数据、提出科学假设的通用生物 AI 系统,加速生命科学研究迭代。

五、总结

生物信息学大模型的出现,正打破传统研究的边界,从 “数据驱动” 走向 “知识驱动” 与 “数据驱动” 的深度融合。本文系统梳理了从数据预处理、预训练、微调、评估到部署的全流程,提供了可直接复用的实战代码与最佳实践,覆盖了基因分析、蛋白质预测、药物研发、临床诊断等核心应用场景。

然而,大模型在生物信息学领域的落地并非一蹴而就,仍需解决数据、效率、可解释性、临床验证等多重挑战。未来,随着技术的不断迭代,大模型将与生命科学更深度地融合,不仅成为科研人员的 “超级助手”,更将在疾病诊断、药物研发、精准医疗等领域发挥关键作用,为人类健康事业带来革命性突破。

对于生物信息学从业者而言,掌握大模型的核心技术与落地流程,既是时代赋予的机遇,也是推动领域发展的责任。希望本文能够成为大家探索生物信息学大模型的 “指南针”,共同开启生命科学研究的新篇章。

附录:常用工具与资源汇总

1. 预训练模型库

- Hugging Face Transformers:包含 BioBERT、ProtBERT、DNABERT 等主流生物信息学大模型。

- AlphaFold DB:提供 2 亿 + 蛋白质结构预测结果。

- ENCODE Project:提供高质量的基因表达调控数据。

2. 开发工具

- 编程框架:PyTorch、TensorFlow、JAX(适合大规模预训练)。

- 数据处理:Biopython(生物序列处理)、Pandas(数据清洗)、NumPy(数值计算)。

- 可视化工具:Matplotlib、Seaborn(图表绘制)、PyMOL(蛋白质结构可视化)、Grad-CAM(注意力可视化)。

- 部署工具:FastAPI、Uvicorn(API 服务)、Docker、Kubernetes(容器化部署)、PyQt5(桌面应用)。

3. 数据集资源

- 基因 / 基因组数据:GenBank、Ensembl、UCSC Genome Browser、ENCODE。

- 蛋白质数据:UniProt、PDB、AlphaFold DB、STRING(PPI 数据)。

- 药物数据:ZINC(化合物库)、ChEMBL(药物活性数据)、DrugBank(药物信息库)。

- 临床数据:TCGA(肿瘤数据)、ClinVar(突变致病性数据)、MIMIC-Ⅲ(电子病历数据)。

4. 学习资源

- 书籍:《Deep Learning for Bioinformatics》、《Bioinformatics with Python Cookbook》。

- 课程:Coursera《Bioinformatics Specialization》、DeepMind AlphaFold Workshop。

- 论文:Transformer 原论文(Attention Is All You Need)、AlphaFold2、Enformer、BioBERT 等核心论文。

- 开源项目:Hugging Face Bioinformatics Repository、AlphaFold 开源代码、DNABERT 官方实现。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)