当AI竞赛遇上云原生:EvalAI如何用450+挑战赛重新定义机器学习评估标准

EvalAI的故事告诉我们,在技术快速迭代的AI时代,"标准制定者"往往比"技术领先者"拥有更持久的竞争优势。就像HTTP协议成就了互联网,SQL标准统一了数据库一样,EvalAI正在AI评估领域扮演着类似的"基础设施"角色。从450+挑战赛的成功举办,到51,000+用户的积极参与,EvalAI已经证明了自己不仅仅是一个技术平台,更是一个连接全球AI研究者的"数字巴别塔"。它让不同语言、不同文化

"在AI的世界里,没有标准答案,但有标准评估。"

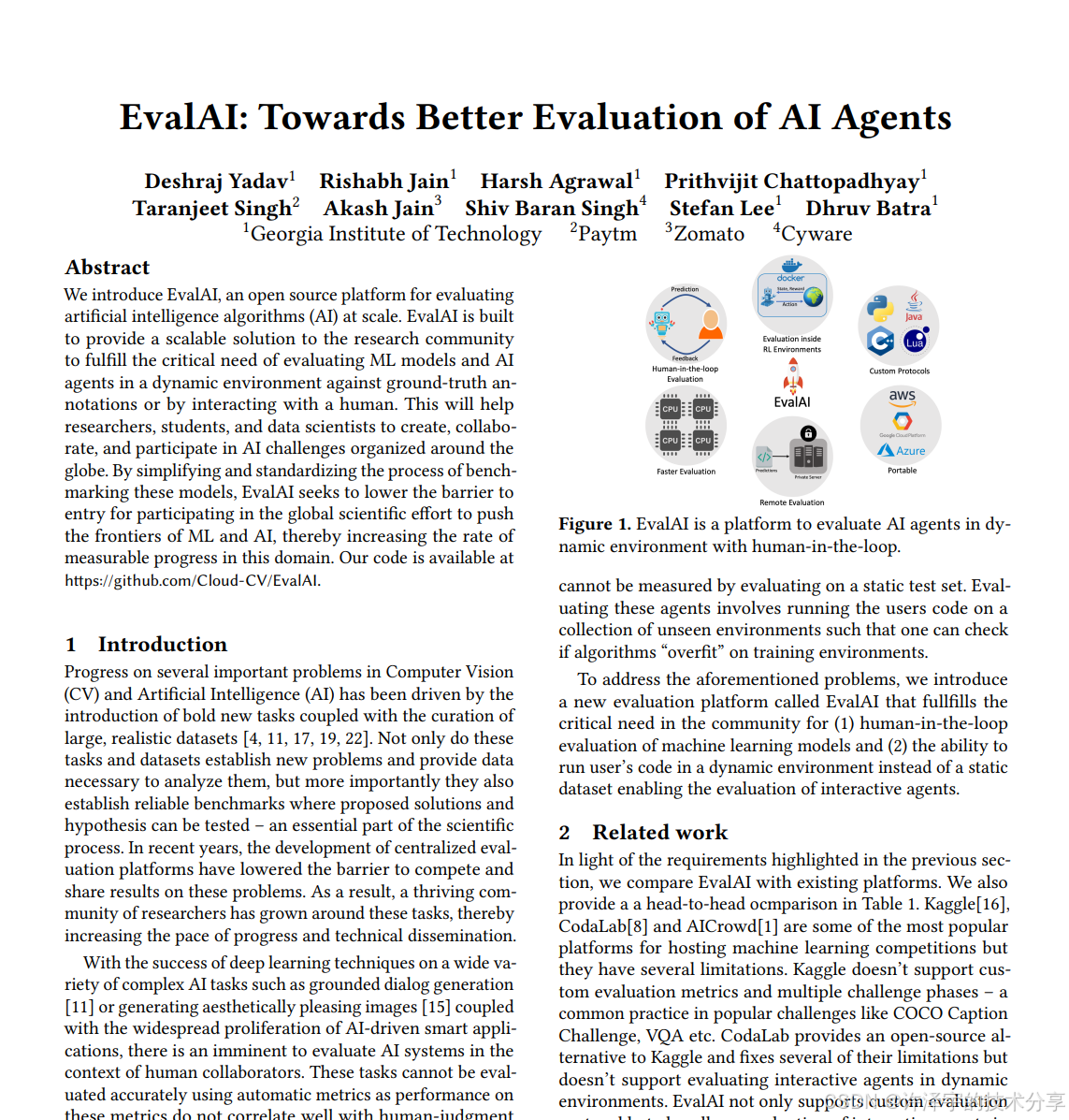

想象一下,如果ImageNet、Kaggle、GitHub和AWS生了个孩子,它会是什么样子?答案就是EvalAI——一个让全球AI研究者又爱又恨的开源竞赛平台。今天,让我们揭开这个"AI竞赛界瑞士军刀"的神秘面纱,看看它是如何在450+挑战赛中,悄悄改变着机器学习评估的游戏规则。

🎯 引子:一场改变AI评估格局的"静默革命"

还记得2020年那场轰动全球的GPT-3论文吗?在那篇创造了NLP里程碑的论文背后,隐藏着一个鲜为人知的故事:研究团队使用了EvalAI平台来评估模型在多个任务上的表现。这不仅仅是一个简单的技术选择,更预示着AI研究领域正在经历一场"评估标准化"的静默革命。

传统的AI算法评估就像是一场没有裁判的足球比赛——每个研究团队都声称自己的算法是最好的,但缺乏公平、透明、可复现的评估标准。EvalAI的出现,就像是给这场混乱的比赛请来了一个铁面无私的VAR(视频助理裁判),让每一次算法对决都有据可查、有标准可依。

🏗️ 技术架构解构:当Django遇上Kubernetes的化学反应

后端架构:Django的"变形金刚"式进化

EvalAI的后端核心建立在Django框架之上,但这绝非你想象中的"传统Web应用"。它更像是一个经过基因改造的"超级Django",通过精密的微服务架构设计,实现了从简单Web应用到企业级AI平台的华丽转身。

# 挑战阶段模型的精妙设计,展现了平台对复杂业务场景的深刻理解

class ChallengePhase(models.Model):

"""

挑战阶段模型——AI竞赛的"时间管理局"

"""

name = models.CharField(max_length=200)

description = models.TextField()

leaderboard_public = models.BooleanField(default=False)

is_public = models.BooleanField(default=False)

start_date = models.DateTimeField()

end_date = models.DateTimeField()

max_submissions_per_day = models.IntegerField(default=100000)

max_submissions = models.IntegerField(default=100000)

max_submissions_per_month = models.IntegerField(default=100000)

# 精妙的状态管理机制,让复杂的竞赛流程变得井井有条

is_active = models.BooleanField(default=False)

codename = models.CharField(max_length=200, unique=True)

# Docker集成,为算法评估提供隔离的运行环境

environment_image = models.CharField(max_length=200, null=True, blank=True)

class Meta:

app_label = 'challenges'

db_table = 'challenge_phase'

这个模型设计的精妙之处在于它不仅仅是一个简单的数据存储结构,更是一个完整的"竞赛生命周期管理器"。通过max_submissions_per_day、max_submissions_per_month、max_submissions这三个层级的限制,平台能够精确控制参与者的提交频率,防止恶意刷榜的同时保证公平性。

容器化架构:Docker与Kubernetes的"双人舞"

EvalAI的容器化策略堪称教科书级别的云原生实践。平台采用了"三驾马车"式的容器架构:

-

Django应用容器:承载核心业务逻辑

-

Celery Worker容器:处理异步任务队列

-

代码上传Worker容器:专门处理Docker镜像提交

# 代码上传Worker的Kubernetes集成,展现了平台对云原生技术的深度应用

def create_job(api_instance, job_name, submission_pk, challenge_pk, phase_pk):

"""

在AWS EKS集群上创建评估作业

"""

# 精妙的环境配置,确保每个评估任务都在隔离的环境中运行

environment_variables = [

client.V1EnvVar(name="SUBMISSION_PK", value=str(submission_pk)),

client.V1EnvVar(name="CHALLENGE_PK", value=str(challenge_pk)),

client.V1EnvVar(name="PHASE_PK", value=str(phase_pk)),

client.V1EnvVar(name="QUEUE_NAME", value=queue_name),

]

# GPU资源调度,为深度学习任务提供硬件加速

resources = client.V1ResourceRequirements(

limits={"nvidia.com/gpu": "1"} if not challenge.get("cpu_only_jobs") else {}

)

# 创建作业定义,体现了平台对资源管理的精细化控制

job = client.V1Job(

api_version="batch/v1",

kind="Job",

metadata=client.V1ObjectMeta(name=job_name),

spec=client.V1JobSpec(

template=client.V1PodTemplateSpec(

spec=client.V1PodSpec(

containers=[

client.V1Container(

name="submission",

image=submission_image,

env=environment_variables,

resources=resources,

volume_mounts=get_volume_mount_list(),

)

],

volumes=get_volume_list(),

restart_policy="Never",

)

),

backoff_limit=0,

),

)

return api_instance.create_namespaced_job(

namespace="default", body=job

)

这段代码展现了EvalAI在云原生技术运用上的深厚功力。通过Kubernetes的Job API,平台能够动态创建和销毁评估环境,实现真正的"弹性计算"。每个评估任务都在独立的容器中运行,既保证了安全性,又提高了资源利用率。

前端架构:Angular的"响应式魔法"

EvalAI的前端采用了Angular框架,通过组件化架构实现了高度可维护的代码结构。特别值得一提的是其状态管理机制——通过精心设计的Service层,实现了前后端数据的完美同步。

// 挑战列表组件的智能数据获取策略

@Component({

selector: 'app-templatechallengelist',

templateUrl: './templatechallengelist.component.html',

styleUrls: ['./templatechallengelist.component.scss'],

})

export class TemplateChallengeListComponent implements OnInit {

challengeTemplates = [];

fetchChallengeTemplates(callback = null) {

this.apiService.getUrl(this.templateChallengesFetchPath, true, false).subscribe(

(data) => {

// 智能的数据处理机制,避免重复渲染导致的性能问题

for (let i = 0; i < data.length; i++) {

this.challengeTemplates.push(data[i]);

}

if (callback) {

callback();

}

},

(err) => {

// 优雅的错误处理,提升用户体验

this.globalService.showToast(

'error',

'Sorry, something went wrong when fetching the templates. Please try again later.'

);

}

);

}

}

🔧 核心实现思路:让复杂变简单的"魔法公式"

评估流程的"流水线"设计

EvalAI的核心创新在于将复杂的AI算法评估流程标准化、自动化。整个评估流程就像一个精密的"数字工厂",每个环节都经过精心设计:

-

提交阶段:参与者通过Web界面或CLI工具提交算法

-

预处理阶段:平台验证提交内容的完整性和合规性

-

调度阶段:根据算法类型和资源需求分配到合适的计算节点

-

评估阶段:在隔离环境中运行算法并收集性能指标

-

排名阶段:根据预设的评估指标更新排行榜

-

反馈阶段:向参与者提供详细的评估报告

多租户架构的"智慧"

平台采用了先进的多租户架构设计,使得不同的竞赛可以在同一套基础设施上安全、隔离地运行。这种设计不仅提高了资源利用率,还大大降低了运维成本。

# 挑战级别的资源隔离和权限控制

def get_participant_teams_for_challenge(request, challenge_pk):

"""

获取特定挑战的参与者团队列表

"""

challenge = get_challenge_by_pk(challenge_pk)

# 智能的权限验证机制

if not is_user_a_host_of_challenge(request.user, challenge):

return Response(

{"error": "Sorry, you are not authorized to access this challenge."},

status=status.HTTP_403_FORBIDDEN,

)

# 高效的数据查询,避免N+1查询问题

participant_teams = ParticipantTeam.objects.filter(

challenge=challenge

).select_related('created_by').prefetch_related('participants')

serializer = ParticipantTeamSerializer(participant_teams, many=True)

return Response(serializer.data, status=status.HTTP_200_OK)

弹性伸缩的"智能大脑"

EvalAI的另一个技术亮点是其智能的弹性伸缩机制。平台能够根据当前的评估负载自动调整计算资源,既保证了评估效率,又控制了成本。

# AWS EKS节点的自动扩缩容策略

def auto_scale_eks_nodes(challenge, evalai_interface, aws_keys):

"""

根据挑战的活跃度和提交量自动调整EKS节点数量

"""

# 智能的负载预测算法

pending_submissions = get_pending_submissions_count(challenge)

active_participants = get_active_participants_count(challenge)

# 动态的资源分配策略

if pending_submissions > HIGH_LOAD_THRESHOLD:

# 高负载情况下扩容

desired_size = min(

MAX_NODE_COUNT,

calculate_optimal_node_count(pending_submissions, active_participants)

)

scale_up_eks_nodes(challenge, desired_size, aws_keys)

elif pending_submissions < LOW_LOAD_THRESHOLD:

# 低负载情况下缩容

scale_down_eks_nodes(challenge, MIN_NODE_COUNT, aws_keys)

🎪 实际应用案例:从象牙塔到产业界的"桥梁"

学术研究的"加速器"

在学术研究领域,EvalAI已经成为了推动AI技术发展的重要基础设施。以计算机视觉领域为例,平台已经成功支持了包括COCO、ImageNet、VQA等在内的多个顶级学术竞赛。

一个典型的成功案例是视觉问答(VQA)挑战赛。在这个挑战中,研究者需要开发能够理解图像内容并回答相关问题的AI系统。通过EvalAI平台,组织者能够:

-

标准化评估流程:确保所有参赛算法都在相同条件下进行评估

-

实时排行榜更新:让研究者能够及时了解自己的算法性能

-

详细的性能分析:提供包括准确率、响应时间、内存使用等多维度的评估指标

-

可复现的结果:确保评估结果可以被其他研究者验证和复现

工业界的"试金石"

在工业应用方面,EvalAI同样展现出了巨大的价值。许多科技公司利用平台来评估和筛选AI算法,大大降低了技术选型的成本和风险。

某自动驾驶公司就曾使用EvalAI平台来评估不同的目标检测算法。通过平台提供的标准化评估环境,该公司能够:

-

快速对比多种算法:在统一标准下评估来自不同团队的算法

-

**发现算法的"盲点"**:通过多样化的测试数据集发现算法在特定场景下的不足

-

优化算法选择:基于详细的评估报告选择最适合的算法方案

-

建立技术壁垒:通过持续的算法优化保持竞争优势

教育领域的"练兵场"

在教育领域,EvalAI为AI人才的培养提供了理想的实践平台。许多顶尖大学都使用平台来组织课程项目和算法竞赛,让学生在实践中掌握AI技术的核心要点。

# 教育场景下的挑战模板系统

class ChallengeTemplate(models.Model):

"""

挑战模板——让创建AI竞赛变得像填空一样简单

"""

title = models.CharField(max_length=200)

template_file = models.FileField(upload_to='challenge_templates/')

dataset = models.CharField(max_length=200)

eval_metrics = models.JSONField(default=list)

phases = models.IntegerField(default=1)

splits = models.IntegerField(default=1)

def create_challenge_from_template(self, host_team, **kwargs):

"""

从模板快速创建挑战,降低组织竞赛的技术门槛

"""

# 自动化的挑战创建流程

challenge = Challenge.objects.create(

title=kwargs.get('title', self.title),

description=kwargs.get('description', ''),

creator=host_team,

# 从模板继承评估配置

evaluation_details=self.eval_metrics,

# 自动设置时间计划

start_date=kwargs.get('start_date', timezone.now()),

end_date=kwargs.get('end_date', timezone.now() + timedelta(days=30)),

)

# 创建挑战阶段

for i in range(self.phases):

ChallengePhase.objects.create(

challenge=challenge,

name=f"Phase {i+1}",

# 继承模板配置

leaderboard_public=True,

is_public=True,

# 智能的日期分配

start_date=challenge.start_date + timedelta(days=i*10),

end_date=challenge.start_date + timedelta(days=(i+1)*10),

)

return challenge

🔮 未来发展趋势:AI评估的"下一站天后"

技术演进的"三驾马车"

展望未来,AI评估平台的发展将主要沿着三个方向前进:

1. 智能化评估:从"被动评分"到"主动指导"

未来的AI评估平台将不再仅仅是"评分器",而是"智能导师"。通过深度学习和知识图谱技术,平台将能够:

-

智能诊断算法缺陷:不仅告诉参与者算法表现如何,还能指出具体的问题所在

-

个性化的改进建议:基于算法特点提供针对性的优化建议

-

自动化的超参数调优:通过贝叶斯优化等技术帮助找到最优参数组合

-

算法性能预测:预测算法在新数据集上的表现

2. 多模态评估:打破"单一指标"的桎梏

随着AI应用场景的多样化,单一的评估指标已经无法满足需求。未来的评估平台将支持:

-

多维度性能评估:同时考虑准确率、效率、鲁棒性、公平性等多个维度

-

跨模态算法评估:支持图像、文本、语音、视频等多种数据类型的综合评估

-

实时性能监控:在真实环境中持续监控算法表现

-

A/B测试框架:支持不同算法版本的并行测试和对比

3. 去中心化评估:区块链技术的"颠覆性"应用

区块链技术的引入将彻底改变AI评估的信任模型:

-

评估结果的不可篡改性:确保评估结果的真实性和可信度

-

分布式的评估网络:通过全球节点的协作提高评估效率

-

透明的评估流程:让所有参与者都能验证评估过程的公平性

-

代币化的激励机制:通过经济激励吸引更多参与者贡献计算资源

应用场景的"无限游戏"

科学研究:从"可复现"到"可信任"

在科学研究领域,AI评估平台将成为确保研究结果可信度的关键基础设施:

-

论文复现的自动化:自动验证论文中报告的实验结果

-

同行评议的智能化:通过AI技术辅助论文评审过程

-

研究趋势的预测:基于大量评估数据预测研究方向的发展趋势

-

跨领域知识融合:促进不同学科之间的算法交流和创新

产业应用:从"技术验证"到"商业价值"

在产业应用方面,AI评估平台将成为连接技术创新和商业价值的重要桥梁:

-

**算法交易的"淘宝"**:建立算法性能评估和交易的标准化平台

-

**AI保险的"精算师"**:为AI系统的性能提供保险精算服务

-

**技术并购的"评估师"**:为企业并购中的AI技术估值提供专业评估

-

**合规审计的"会计师"**:为AI系统的合规性提供第三方审计服务

社会治理:从"技术工具"到"治理平台"

在社会治理层面,AI评估平台将发挥更加重要的作用:

-

AI治理的基础设施:为政府监管AI技术提供技术支撑

-

公共服务的优化器:通过算法竞赛优化公共服务提供方式

-

社会公平的守护者:确保AI系统不会加剧社会不平等

-

民主决策的助手:通过算法评估提高公共决策的科学性

🎭 挑战与机遇:在"理想"与"现实"之间寻找平衡

技术挑战:"完美"与"实用"的博弈

尽管EvalAI在技术上已经相当成熟,但仍面临着诸多挑战:

1. 评估标准的"巴别塔困境"

不同领域、不同应用场景对AI算法的要求差异巨大,如何建立一套既通用又有针对性的评估标准,是一个永恒的挑战。

2. 计算资源的"不可能三角"

在评估精度、计算成本和响应速度之间找到最佳平衡点,就像是在解一个不可能三角。

3. 数据隐私的"达摩克利斯之剑"

在提供详细评估结果的同时保护参与者的知识产权,需要精妙的平衡艺术。

发展机遇:"风口"上的"猪"也能飞

1. 开源生态的"滚雪球效应"

随着越来越多的研究者和开发者参与到EvalAI生态中,平台的网络效应将越来越明显,形成正向循环。

2. 企业需求的"刚性增长"

随着AI技术在各行各业的深入应用,对标准化评估的需求将呈指数级增长。

3. 政策支持的"春风化雨"

各国政府对AI技术标准化的重视,为平台发展提供了政策红利。

🎪 结语:在AI的"战国时代"做"标准制定者"

EvalAI的故事告诉我们,在技术快速迭代的AI时代,"标准制定者"往往比"技术领先者"拥有更持久的竞争优势。就像HTTP协议成就了互联网,SQL标准统一了数据库一样,EvalAI正在AI评估领域扮演着类似的"基础设施"角色。

从450+挑战赛的成功举办,到51,000+用户的积极参与,EvalAI已经证明了自己不仅仅是一个技术平台,更是一个连接全球AI研究者的"数字巴别塔"。它让不同语言、不同文化背景的研究者能够在统一的标准下进行公平的竞争和合作。

展望未来,随着AI技术的持续演进和应用场景的不断扩展,EvalAI这样的标准化评估平台将发挥越来越重要的作用。它不仅是技术创新的"催化剂",更是AI产业健康发展的"守护者"。

在这个充满不确定性的AI时代,或许我们最需要的就是像EvalAI这样能够提供"确定性"的基础设施。它让我们相信,无论技术如何变化,公平、透明、可复现的评估标准永远是推动人类知识进步的基石。

毕竟,在AI的星辰大海中,我们需要的不只是更强大的算法,更是更公正、更可靠的评估标准。

后记:本文撰写过程中,笔者深深被EvalAI团队的技术远见和工程实现所震撼。在这个"算法为王"的时代,他们选择了一条看似枯燥但意义非凡的道路——做AI世界的"裁判"。或许,这就是技术人的浪漫——用代码构建信任,用标准连接世界。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)