程序员的未来:AI将如何重塑职业路径

随着人工智能技术的飞速发展,其对各个行业都产生了深远的影响,程序员这一职业也不例外。本文的目的在于全面分析AI如何重塑程序员的职业路径,探讨程序员在AI时代面临的机遇和挑战,为程序员提供应对职业变化的策略和建议。范围涵盖了AI对编程工作的各个方面的影响,包括编程方式、技能需求、职业发展方向等。本文将按照以下结构进行阐述:首先介绍核心概念与联系,让读者了解AI与编程的基本原理和关系;接着详细讲解核心

程序员的未来:AI将如何重塑职业路径

关键词:程序员未来、AI、职业路径重塑、编程自动化、新兴技术领域、技能转型

摘要:本文深入探讨了AI对程序员职业路径的重塑作用。在AI迅猛发展的时代背景下,程序员的工作方式、技能需求、职业发展方向都面临着巨大的变革。文章首先介绍了研究的目的、范围、预期读者和文档结构,解释了相关术语。接着阐述了AI与编程的核心概念及联系,详细分析了AI辅助编程的算法原理和操作步骤,给出了数学模型和公式。通过实际项目案例展示了AI在编程中的应用,探讨了AI在不同场景下对程序员职业的影响。同时推荐了学习资源、开发工具框架和相关论文著作。最后总结了程序员未来的发展趋势与挑战,解答了常见问题,并提供了扩展阅读和参考资料,旨在帮助程序员更好地适应AI时代的职业变化。

1. 背景介绍

1.1 目的和范围

随着人工智能技术的飞速发展,其对各个行业都产生了深远的影响,程序员这一职业也不例外。本文的目的在于全面分析AI如何重塑程序员的职业路径,探讨程序员在AI时代面临的机遇和挑战,为程序员提供应对职业变化的策略和建议。范围涵盖了AI对编程工作的各个方面的影响,包括编程方式、技能需求、职业发展方向等。

1.2 预期读者

本文的预期读者主要是程序员群体,包括初级、中级和高级程序员,以及对程序员职业发展感兴趣的相关人员,如计算机专业学生、技术管理者等。通过阅读本文,读者可以了解AI对程序员职业的影响,提前做好职业规划和技能提升。

1.3 文档结构概述

本文将按照以下结构进行阐述:首先介绍核心概念与联系,让读者了解AI与编程的基本原理和关系;接着详细讲解核心算法原理和具体操作步骤,通过Python代码进行说明;然后给出数学模型和公式,并举例说明;之后通过项目实战展示AI在编程中的实际应用;再探讨AI的实际应用场景;推荐相关的工具和资源;最后总结未来发展趋势与挑战,解答常见问题,并提供扩展阅读和参考资料。

1.4 术语表

1.4.1 核心术语定义

- 人工智能(AI):是一门研究如何使计算机系统能够模拟人类智能的学科,包括机器学习、深度学习、自然语言处理等技术。

- 程序员:是指从事程序设计、开发和维护的专业人员。

- 职业路径:指个人在职业生涯中所经历的一系列职位和发展阶段。

1.4.2 相关概念解释

- 编程自动化:利用AI技术自动生成代码、进行代码优化和调试等,减少人工编程的工作量。

- 新兴技术领域:如人工智能、区块链、物联网等,这些领域对程序员的技能需求和职业发展带来了新的机遇。

1.4.3 缩略词列表

- ML:机器学习(Machine Learning)

- DL:深度学习(Deep Learning)

- NLP:自然语言处理(Natural Language Processing)

2. 核心概念与联系

2.1 AI与编程的基本原理

人工智能是通过计算机模拟人类智能的过程,主要包括机器学习和深度学习等技术。机器学习是让计算机通过数据学习模式和规律,从而进行预测和决策;深度学习则是机器学习的一个分支,通过多层神经网络来处理复杂的数据。

编程是指使用编程语言来编写计算机程序,实现特定的功能。传统的编程方式需要程序员手动编写代码,而AI的发展使得编程过程可以更加自动化和智能化。

2.2 AI与编程的联系架构

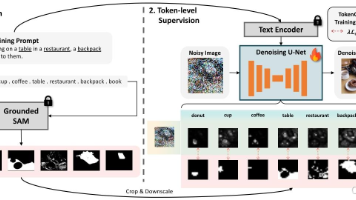

AI与编程的联系可以用以下架构来表示:

从这个架构图可以看出,AI技术通过数据处理、模型训练和算法优化等环节,为编程工作提供了自动代码生成和代码质量提升的支持。

2.3 详细解释

- 数据处理:AI需要大量的数据来进行学习和训练,编程数据包括代码库、编程规范等。通过对这些数据的处理,可以提取有用的信息,为模型训练提供基础。

- 模型训练:利用编程数据训练代码生成模型,这些模型可以根据输入的需求自动生成代码。例如,一些深度学习模型可以学习代码的语法和语义,从而生成符合要求的代码。

- 算法优化:通过优化算法,可以提高代码的质量和性能。例如,AI可以分析代码的复杂度、执行效率等,提出优化建议。

- 自动代码生成:基于训练好的模型,根据用户的需求自动生成代码。这可以大大提高编程效率,减少人工编程的工作量。

- 代码质量提升:AI可以检查代码中的错误和漏洞,提供代码优化建议,从而提高代码的质量和可靠性。

3. 核心算法原理 & 具体操作步骤

3.1 核心算法原理

在AI辅助编程中,常用的算法是基于深度学习的序列到序列模型(Sequence-to-Sequence Model)。这种模型由编码器(Encoder)和解码器(Decoder)组成。

编码器将输入的文本(如编程需求)转换为一个固定长度的向量表示,解码器则根据这个向量表示生成输出序列(如代码)。具体来说,编码器和解码器通常使用循环神经网络(RNN)或其变体,如长短期记忆网络(LSTM)或门控循环单元(GRU)。

以下是一个简单的基于LSTM的序列到序列模型的Python代码示例:

import torch

import torch.nn as nn

# 定义编码器

class Encoder(nn.Module):

def __init__(self, input_size, hidden_size):

super(Encoder, self).__init__()

self.hidden_size = hidden_size

self.embedding = nn.Embedding(input_size, hidden_size)

self.lstm = nn.LSTM(hidden_size, hidden_size)

def forward(self, input, hidden):

embedded = self.embedding(input).view(1, 1, -1)

output = embedded

output, hidden = self.lstm(output, hidden)

return output, hidden

def initHidden(self):

return (torch.zeros(1, 1, self.hidden_size),

torch.zeros(1, 1, self.hidden_size))

# 定义解码器

class Decoder(nn.Module):

def __init__(self, hidden_size, output_size):

super(Decoder, self).__init__()

self.hidden_size = hidden_size

self.embedding = nn.Embedding(output_size, hidden_size)

self.lstm = nn.LSTM(hidden_size, hidden_size)

self.out = nn.Linear(hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

output = self.embedding(input).view(1, 1, -1)

output = nn.functional.relu(output)

output, hidden = self.lstm(output, hidden)

output = self.softmax(self.out(output[0]))

return output, hidden

def initHidden(self):

return (torch.zeros(1, 1, self.hidden_size),

torch.zeros(1, 1, self.hidden_size))

3.2 具体操作步骤

3.2.1 数据准备

首先需要收集大量的编程数据,包括代码库、编程规范等。然后对数据进行预处理,如分词、编码等,将其转换为模型可以处理的格式。

# 示例数据预处理

def preprocess_data(data):

# 分词

tokenized_data = [tokenize(line) for line in data]

# 构建词汇表

vocab = build_vocab(tokenized_data)

# 编码

encoded_data = [encode(line, vocab) for line in tokenized_data]

return encoded_data, vocab

def tokenize(line):

return line.split()

def build_vocab(tokenized_data):

vocab = set()

for line in tokenized_data:

for token in line:

vocab.add(token)

return {token: i for i, token in enumerate(vocab)}

def encode(line, vocab):

return [vocab[token] for token in line if token in vocab]

3.2.2 模型训练

使用准备好的数据对序列到序列模型进行训练。训练过程中,需要定义损失函数和优化器,不断调整模型的参数,使模型的输出尽可能接近真实的代码。

# 模型训练

def train(encoder, decoder, input_tensor, target_tensor, encoder_optimizer, decoder_optimizer, criterion):

encoder_hidden = encoder.initHidden()

encoder_optimizer.zero_grad()

decoder_optimizer.zero_grad()

input_length = input_tensor.size(0)

target_length = target_tensor.size(0)

encoder_outputs = torch.zeros(input_length, encoder.hidden_size)

for ei in range(input_length):

encoder_output, encoder_hidden = encoder(

input_tensor[ei], encoder_hidden)

encoder_outputs[ei] = encoder_output[0, 0]

decoder_input = torch.tensor([[vocab['<SOS>']]])

decoder_hidden = encoder_hidden

loss = 0

for di in range(target_length):

decoder_output, decoder_hidden = decoder(

decoder_input, decoder_hidden)

topv, topi = decoder_output.topk(1)

decoder_input = topi.squeeze().detach()

loss += criterion(decoder_output, target_tensor[di].unsqueeze(0))

if decoder_input.item() == vocab['<EOS>']:

break

loss.backward()

encoder_optimizer.step()

decoder_optimizer.step()

return loss.item() / target_length

3.2.3 代码生成

训练好模型后,就可以使用它来生成代码。输入编程需求,模型将根据需求生成相应的代码。

# 代码生成

def generate_code(encoder, decoder, input_tensor, max_length=100):

encoder_hidden = encoder.initHidden()

input_length = input_tensor.size(0)

encoder_outputs = torch.zeros(input_length, encoder.hidden_size)

for ei in range(input_length):

encoder_output, encoder_hidden = encoder(

input_tensor[ei], encoder_hidden)

encoder_outputs[ei] = encoder_output[0, 0]

decoder_input = torch.tensor([[vocab['<SOS>']]])

decoder_hidden = encoder_hidden

decoded_words = []

for di in range(max_length):

decoder_output, decoder_hidden = decoder(

decoder_input, decoder_hidden)

topv, topi = decoder_output.topk(1)

decoder_input = topi.squeeze().detach()

if decoder_input.item() == vocab['<EOS>']:

decoded_words.append('<EOS>')

break

else:

decoded_words.append(index2word[decoder_input.item()])

return decoded_words

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 序列到序列模型的数学原理

序列到序列模型的目标是学习一个函数 fff,将输入序列 X=(x1,x2,⋯ ,xn)X = (x_1, x_2, \cdots, x_n)X=(x1,x2,⋯,xn) 映射到输出序列 Y=(y1,y2,⋯ ,ym)Y = (y_1, y_2, \cdots, y_m)Y=(y1,y2,⋯,ym)。

编码器将输入序列 XXX 转换为一个上下文向量 ccc,可以表示为:

c=Encoder(X)c = Encoder(X)c=Encoder(X)

解码器根据上下文向量 ccc 生成输出序列 YYY,可以表示为:

P(Y∣X)=∏i=1mP(yi∣y1,⋯ ,yi−1,c)P(Y|X) = \prod_{i=1}^{m} P(y_i|y_1, \cdots, y_{i-1}, c)P(Y∣X)=i=1∏mP(yi∣y1,⋯,yi−1,c)

在训练过程中,通常使用最大似然估计来优化模型的参数,即最大化训练数据的对数似然:

θ∗=argmaxθ∑(X,Y)∈DlogP(Y∣X;θ)\theta^* = \arg\max_{\theta} \sum_{(X, Y) \in D} \log P(Y|X; \theta)θ∗=argθmax(X,Y)∈D∑logP(Y∣X;θ)

其中,θ\thetaθ 是模型的参数,DDD 是训练数据集。

4.2 详细讲解

- 编码器:编码器的作用是将输入序列的信息压缩到一个上下文向量 ccc 中。在基于LSTM的编码器中,LSTM单元根据输入序列的每个元素更新隐藏状态,最终的隐藏状态就是上下文向量 ccc。

- 解码器:解码器根据上下文向量 ccc 和之前生成的输出元素 y1,⋯ ,yi−1y_1, \cdots, y_{i-1}y1,⋯,yi−1 来预测下一个输出元素 yiy_iyi。解码器也是一个LSTM单元,它在每个时间步输出一个概率分布,选择概率最大的元素作为当前时间步的输出。

- 损失函数:常用的损失函数是交叉熵损失函数,用于衡量模型预测的概率分布与真实标签之间的差异。

4.3 举例说明

假设我们有一个简单的编程需求:“计算两个数的和”。输入序列 XXX 可以表示为 [“计算”, “两个数”, “的和”],输出序列 YYY 可以表示为 [“def”, “add”, “(”, “a”, “,”, “b”, “)”, “:”, “return”, “a”, “+”, “b”]。

在训练过程中,模型会学习如何将输入序列映射到输出序列。在代码生成时,输入 “计算两个数的和”,模型将根据学习到的映射关系生成相应的代码。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

5.1.1 安装Python

首先需要安装Python,可以从Python官方网站(https://www.python.org/downloads/)下载适合自己操作系统的Python版本。建议安装Python 3.6及以上版本。

5.1.2 安装深度学习框架

本项目使用PyTorch作为深度学习框架,可以使用以下命令安装:

pip install torch torchvision

5.1.3 安装其他依赖库

还需要安装一些其他的依赖库,如NumPy、Matplotlib等,可以使用以下命令安装:

pip install numpy matplotlib

5.2 源代码详细实现和代码解读

5.2.1 数据加载和预处理

import torch

import torch.nn as nn

import numpy as np

# 加载数据

def load_data(file_path):

with open(file_path, 'r', encoding='utf-8') as f:

lines = f.readlines()

return lines

# 数据预处理

def preprocess_data(data):

# 分词

tokenized_data = [tokenize(line) for line in data]

# 构建词汇表

vocab = build_vocab(tokenized_data)

# 编码

encoded_data = [encode(line, vocab) for line in tokenized_data]

return encoded_data, vocab

def tokenize(line):

return line.split()

def build_vocab(tokenized_data):

vocab = set()

for line in tokenized_data:

for token in line:

vocab.add(token)

return {token: i for i, token in enumerate(vocab)}

def encode(line, vocab):

return [vocab[token] for token in line if token in vocab]

# 加载数据并预处理

data = load_data('data.txt')

encoded_data, vocab = preprocess_data(data)

代码解读:

load_data函数用于从文件中加载数据。preprocess_data函数对数据进行预处理,包括分词、构建词汇表和编码。tokenize函数将每行数据分词。build_vocab函数构建词汇表,将每个单词映射到一个唯一的整数。encode函数将分词后的句子编码为整数序列。

5.2.2 定义模型

# 定义编码器

class Encoder(nn.Module):

def __init__(self, input_size, hidden_size):

super(Encoder, self).__init__()

self.hidden_size = hidden_size

self.embedding = nn.Embedding(input_size, hidden_size)

self.lstm = nn.LSTM(hidden_size, hidden_size)

def forward(self, input, hidden):

embedded = self.embedding(input).view(1, 1, -1)

output = embedded

output, hidden = self.lstm(output, hidden)

return output, hidden

def initHidden(self):

return (torch.zeros(1, 1, self.hidden_size),

torch.zeros(1, 1, self.hidden_size))

# 定义解码器

class Decoder(nn.Module):

def __init__(self, hidden_size, output_size):

super(Decoder, self).__init__()

self.hidden_size = hidden_size

self.embedding = nn.Embedding(output_size, hidden_size)

self.lstm = nn.LSTM(hidden_size, hidden_size)

self.out = nn.Linear(hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

output = self.embedding(input).view(1, 1, -1)

output = nn.functional.relu(output)

output, hidden = self.lstm(output, hidden)

output = self.softmax(self.out(output[0]))

return output, hidden

def initHidden(self):

return (torch.zeros(1, 1, self.hidden_size),

torch.zeros(1, 1, self.hidden_size))

# 初始化模型

input_size = len(vocab)

hidden_size = 256

output_size = len(vocab)

encoder = Encoder(input_size, hidden_size)

decoder = Decoder(hidden_size, output_size)

代码解读:

Encoder类定义了编码器,包括嵌入层和LSTM层。Decoder类定义了解码器,包括嵌入层、LSTM层和输出层。initHidden方法用于初始化隐藏状态。

5.2.3 训练模型

import random

# 定义损失函数和优化器

criterion = nn.NLLLoss()

encoder_optimizer = torch.optim.Adam(encoder.parameters(), lr=0.001)

decoder_optimizer = torch.optim.Adam(decoder.parameters(), lr=0.001)

# 训练模型

n_iters = 10000

print_every = 1000

plot_every = 100

total_loss = 0

plot_losses = []

for iter in range(1, n_iters + 1):

input_tensor = torch.tensor(random.choice(encoded_data), dtype=torch.long)

target_tensor = input_tensor # 这里简单假设输入和输出相同

loss = train(encoder, decoder, input_tensor, target_tensor, encoder_optimizer, decoder_optimizer, criterion)

total_loss += loss

if iter % print_every == 0:

print(f'Iter {iter}, Loss: {loss:.4f}')

if iter % plot_every == 0:

plot_losses.append(total_loss / plot_every)

total_loss = 0

代码解读:

- 定义了损失函数

NLLLoss和优化器Adam。 - 训练过程中,随机选择一个输入序列进行训练,并调用

train函数计算损失和更新参数。 - 每隔一定的迭代次数打印损失值,并记录损失值用于绘图。

5.2.4 代码生成

# 代码生成

input_text = "计算两个数的和"

input_tokens = tokenize(input_text)

input_encoded = encode(input_tokens, vocab)

input_tensor = torch.tensor(input_encoded, dtype=torch.long)

decoded_words = generate_code(encoder, decoder, input_tensor)

print('生成的代码:', ' '.join(decoded_words))

代码解读:

- 输入一个编程需求,将其分词并编码为整数序列。

- 调用

generate_code函数生成代码,并将生成的代码打印输出。

5.3 代码解读与分析

5.3.1 数据处理

数据处理是整个项目的基础,通过分词、构建词汇表和编码,将文本数据转换为模型可以处理的格式。这一步骤对于模型的训练和代码生成至关重要。

5.3.2 模型训练

模型训练过程中,使用了交叉熵损失函数和Adam优化器来更新模型的参数。通过不断迭代训练,模型逐渐学习到输入序列和输出序列之间的映射关系。

5.3.3 代码生成

代码生成阶段,根据输入的编程需求,模型生成相应的代码。生成的代码质量取决于模型的训练效果和数据的质量。

6. 实际应用场景

6.1 编程自动化

AI可以自动生成代码,减少程序员的手动编程工作量。例如,对于一些常见的算法和数据结构,AI可以根据需求快速生成相应的代码。这可以提高编程效率,尤其是在处理重复性任务时。

6.2 代码审查和优化

AI可以分析代码的质量和性能,检查代码中的错误和漏洞,并提供优化建议。例如,AI可以检测代码中的潜在安全风险,如缓冲区溢出、SQL注入等,并提出修复方案。同时,AI可以优化代码的复杂度和执行效率,提高代码的性能。

6.3 智能编程助手

AI可以作为智能编程助手,为程序员提供实时的帮助和建议。例如,当程序员遇到编程难题时,AI可以根据问题的描述提供解决方案和代码示例。此外,AI还可以自动补全代码,提高编程速度。

6.4 新兴技术领域

在新兴技术领域,如人工智能、区块链、物联网等,AI对程序员的职业路径产生了重要影响。这些领域需要程序员具备跨学科的知识和技能,AI可以帮助程序员快速学习和掌握新的技术。例如,在人工智能领域,AI可以辅助程序员进行模型训练和调优,提高模型的性能。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《Python深度学习》:这本书详细介绍了Python在深度学习中的应用,包括神经网络、卷积神经网络、循环神经网络等。

- 《人工智能:一种现代的方法》:这是一本经典的人工智能教材,涵盖了人工智能的各个方面,包括搜索算法、机器学习、自然语言处理等。

- 《代码大全》:这本书是一本关于软件开发的经典著作,介绍了编程的最佳实践和技巧,对于提高编程能力非常有帮助。

7.1.2 在线课程

- Coursera上的“深度学习专项课程”:由深度学习领域的知名专家吴恩达教授授课,系统地介绍了深度学习的理论和实践。

- edX上的“人工智能导论”:这门课程介绍了人工智能的基本概念和方法,适合初学者学习。

- 中国大学MOOC上的“Python编程基础”:这门课程从零开始介绍Python编程,适合初学者入门。

7.1.3 技术博客和网站

- Medium:这是一个技术博客平台,有很多关于人工智能和编程的优质文章。

- GitHub:这是一个代码托管平台,上面有很多开源的人工智能项目和代码,可以学习和参考。

- Stack Overflow:这是一个程序员社区,程序员可以在这里提问和回答问题,解决编程中遇到的难题。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:这是一个专门为Python开发设计的集成开发环境,具有代码自动补全、调试等功能。

- Visual Studio Code:这是一个轻量级的代码编辑器,支持多种编程语言,有丰富的插件可以扩展功能。

- Jupyter Notebook:这是一个交互式的编程环境,适合进行数据分析和机器学习实验。

7.2.2 调试和性能分析工具

- PDB:这是Python自带的调试器,可以帮助程序员定位代码中的错误。

- cProfile:这是Python的性能分析工具,可以分析代码的执行时间和调用关系。

- TensorBoard:这是TensorFlow的可视化工具,可以用于可视化模型的训练过程和性能指标。

7.2.3 相关框架和库

- PyTorch:这是一个深度学习框架,具有动态图和易于使用的特点,适合进行研究和开发。

- TensorFlow:这是一个广泛使用的深度学习框架,具有强大的分布式训练和部署能力。

- Scikit-learn:这是一个机器学习库,提供了各种机器学习算法和工具,适合进行数据挖掘和分析。

7.3 相关论文著作推荐

7.3.1 经典论文

- 《Attention Is All You Need》:这篇论文提出了Transformer模型,是自然语言处理领域的重要突破。

- 《Generative Adversarial Nets》:这篇论文提出了生成对抗网络(GAN),在图像生成和数据增强等领域有广泛应用。

- 《Long Short-Term Memory》:这篇论文介绍了长短期记忆网络(LSTM),解决了循环神经网络中的梯度消失问题。

7.3.2 最新研究成果

- 关注顶级学术会议,如NeurIPS、ICML、CVPR等,这些会议上会发表很多关于人工智能和编程的最新研究成果。

- 关注知名学术期刊,如Journal of Artificial Intelligence Research(JAIR)、Artificial Intelligence等,这些期刊上会发表高质量的研究论文。

7.3.3 应用案例分析

- 《Deep Learning in Practice》:这本书介绍了深度学习在各个领域的应用案例,包括计算机视觉、自然语言处理、语音识别等。

- 《AI in Action》:这本书介绍了人工智能在不同行业的应用案例,如医疗、金融、交通等。

8. 总结:未来发展趋势与挑战

8.1 未来发展趋势

- 编程自动化程度提高:随着AI技术的不断发展,编程自动化程度将不断提高,程序员将更多地专注于问题的分析和设计,而不是具体的代码编写。

- 跨学科技能需求增加:新兴技术领域的发展需要程序员具备跨学科的知识和技能,如人工智能、区块链、物联网等。程序员需要不断学习和掌握新的技术,以适应市场的需求。

- 智能编程助手普及:智能编程助手将成为程序员的重要工具,为程序员提供实时的帮助和建议,提高编程效率和质量。

8.2 挑战

- 技能转型挑战:程序员需要不断学习和掌握新的技术,进行技能转型,以适应AI时代的职业变化。这需要程序员具备较强的学习能力和适应能力。

- 就业竞争加剧:随着AI技术的普及,编程工作的门槛可能会降低,就业竞争将加剧。程序员需要不断提升自己的竞争力,才能在市场中脱颖而出。

- 伦理和法律问题:AI在编程中的应用可能会带来一些伦理和法律问题,如代码版权、数据隐私等。程序员需要了解相关的法律法规,遵守伦理准则。

9. 附录:常见问题与解答

9.1 AI会取代程序员吗?

AI不会完全取代程序员,但会改变程序员的工作方式和职业路径。AI可以自动生成代码、进行代码优化和调试等,减少程序员的手动编程工作量。但程序员仍然需要具备问题分析、设计和解决的能力,以及对业务的理解和沟通能力。

9.2 程序员如何应对AI的挑战?

程序员可以通过以下方式应对AI的挑战:

- 不断学习和掌握新的技术,进行技能转型,如学习人工智能、区块链等新兴技术。

- 提高自己的问题分析和解决能力,注重编程的思维和方法。

- 培养跨学科的知识和技能,了解不同领域的业务需求。

- 关注行业的发展趋势,及时调整自己的职业规划。

9.3 AI辅助编程的代码质量如何保证?

AI辅助编程的代码质量可以通过以下方式保证:

- 选择高质量的训练数据,确保模型学习到正确的编程知识和规范。

- 对生成的代码进行人工审查和测试,检查代码的正确性和性能。

- 不断优化模型,提高模型的准确性和可靠性。

10. 扩展阅读 & 参考资料

10.1 扩展阅读

- 《未来简史:从智人到智神》:这本书探讨了人工智能对人类社会的影响,以及人类未来的发展方向。

- 《奇点临近》:这本书提出了技术奇点的概念,探讨了人工智能和技术进步对人类未来的影响。

- 《人类简史:从动物到上帝》:这本书从人类进化的角度探讨了人类的发展历程,对于理解人工智能的发展背景有一定的帮助。

10.2 参考资料

- 相关学术论文和研究报告,如IEEE、ACM等学术组织发表的论文。

- 行业研究报告,如Gartner、IDC等机构发布的报告。

- 开源项目和代码库,如GitHub上的相关项目。

更多推荐

已为社区贡献73条内容

已为社区贡献73条内容

所有评论(0)