Google第六代Trillium TPU详解

Trillium TPU代表了Google在AI专用芯片领域的最新突破,标志着TPU从"训练导向"向"推理与训练并重"的战略转型,为Google在大模型时代的领先地位提供了强大的硬件支撑。随着TPU v7(Ironwood)的即将推出,Google正持续强化其在AI基础设施领域的领导地位,推动AI技术向更高效、更经济的方向发展。

Trillium TPU基本概况

Trillium(TPU v6e)是Google于2024年5月15日正式发布、同年12月12日全面向Cloud客户开放的第六代张量处理单元(TPU),是Google十多年AI专用芯片研发的集大成之作。

核心定位:专为大规模AI训练和推理设计,特别是针对大语言模型(LLM)、多模态和推荐系统进行优化,是Google"推理时代最省钱的商业引擎"战略的硬件核心。

技术规格与性能突破

| 参数 | TPU v5e | Trillium (v6e) | 提升 |

|---|---|---|---|

| 计算性能 | 197 TFLOPS (bf16) | 918 TFLOPS (bf16) | 4.7倍 |

| 393 TOPs (Int8) | 1,836 TOPs (Int8) | 4.7倍 | |

| 内存 | 16 GB HBM | 32 GB HBM | 2倍 |

| 内存带宽 | 800 GB/s | 1,600 GB/s | 2倍 |

| 芯片间互联 | 1,600 Gbps | 3,200 Gbps | 2倍 |

| 能效比 | 基准值 | 提升67% | 能耗降低67% |

| 特殊功能 | - | SparseCore (第三代) | 加速超大规模嵌入处理 |

核心架构创新

1. 增强型脉动阵列(Systolic Array)

- 256×256矩阵乘法单元,是v5e(128×128)的4倍,单周期MAC吞吐量大幅提升

- 专为Transformer架构优化,与注意力机制计算模式高度契合

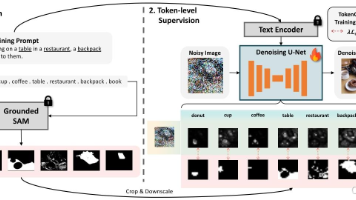

2. SparseCore专用加速器

- 专为处理推荐系统和大模型中常见的超大规模嵌入表设计

- 通过策略性卸载TensorCore的随机和细粒度访问,显著提升性能和能效

3. 系统级创新

- 单机柜最大256芯片的Pod架构,支持2D torus互联拓扑

- 单个Pod总性能达234.9 PFLOPS (bf16),是v5e Pod(50.63 PFLOPS)的4.6倍

- 与Jupiter数据中心网络集成,支持跨Pod扩展至数万芯片,形成"AI超级计算机"

Trillium TPU的应用场景

- Gemini系列模型训练与推理:Google DeepMind用其加速Gemini 3等下一代多模态模型开发

- 推荐系统:支持万亿级参数推荐模型训练和低延迟线上服务

- 内容生成:赋能文本-to-image、视频生成等创意AI应用,如Imagen 3和Gemma 2

- 科学计算:助力药物发现(如Deep Genomics)和气候模拟等计算密集型研究

Google TPU发展历程

起源(2006-2013):从构想走向实践

-

2006年:Google开始探索为神经网络构建专用ASIC的可能性,但因当时GPU资源充足,未正式推进

-

2013年底:Google正式启动TPU项目,由Norm Jouppi领导的团队负责开发,目标是解决深度学习带来的算力瓶颈和能耗危机

-

2015年:随着深度学习在Google服务(搜索、广告等)中广泛应用,团队意识到依赖GPU将导致数据中心电力成本增长十倍,自研ASIC成为唯一可行路径

历代TPU演进:从推理芯片到AI基础设施

TPU v1 (2016年):初试锋芒

- 首款专用AI加速器,采用28nm工艺,700MHz频率,功耗75W

- 核心创新:采用"脉动阵列"(Systolic Array)架构,专为矩阵运算优化,性能达92 TOPS (Int8)

- 应用场景:初期用于Google翻译和搜索功能,支撑AlphaGo击败李世石的算力需求

TPU v2 (2017年):架构突破

-

16nm工艺,首次引入高带宽内存HBM,容量16GB,带宽700GB/s

-

计算性能:单芯片45 TFLOPS (bf16),四芯片模块达180 TFLOPS

-

里程碑:首次提出TPU Pod概念,由256颗芯片组成,总性能达11.5 PFLOPS,开启超大规模AI计算时代

-

战略转变:同年Transformer论文发表,Google发现其计算模式与TPU架构高度匹配,TPU从单一芯片升级为AI基础设施底座

TPU v3 (2018年):性能飞跃

-

性能提升:相比v2,计算性能提升2.7倍,达420 TFLOPS (bf16),内存带宽提升至900GB/s

-

互联升级:2D torus拓扑扩展至1,024颗芯片,Pod总性能突破100 PFLOPS,达126 PFLOPS (bf16)

-

功耗优化:能效比(TOPS/W)从v2的0.16提升至0.56,在保持高性能的同时提高能源效率

TPU v4 (2021年):制程革命

-

工艺突破:从16nm跃升至7nm,芯片尺寸达780mm²,内存带宽提升至1,200GB/s,功耗控制在300W

-

架构创新:3D torus互联提供更高带宽和容错能力,支持4,096颗芯片集成,单Pod总性能达1.126 EFLOPS (bf16)

-

模型训练:成功支持PaLM 540B等千亿级参数模型训练,奠定Google在大模型领域的领先地位

TPU v5系列 (2023-2024):商业落地

-

v5p:性能较v4翻倍,首次大规模应用于Google广告系统、搜索排序和YouTube推荐等核心产品线,标志TPU从"实验室"走向"赚钱机器"

-

弹性架构:支持客户按需扩展至近9,000颗芯片,吸引Meta、Anthropic等头部AI公司评估采购

Trillium (TPU v6e):推理时代的王者

-

性能巅峰:单芯片918 TFLOPS(bf16),是v5e的4.7倍;1,836 TOPs(Int8),适合FP8量化模型加速

-

内存升级:32GB HBM,带宽1,600GB/s,支持更大模型和KV缓存,大幅提升推理效率

-

专用引擎:第三代SparseCore,专为推荐系统和大规模嵌入表优化,显著提升推荐模型训练和推理性能

-

推理优化:KV缓存访问深度优化,片上SRAM容量翻倍,首Token响应延迟降低,成为"推理成本杀手"

TPU的核心设计哲学

极简主义脉动阵列:与GPU通用计算架构不同,TPU采用极简"脉动阵列",牺牲通用性换取极致效率,专为深度学习矩阵运算定制,使能效比同期GPU高2-3倍。

垂直整合战略:Google构建了"芯片-云-模型-应用"全栈能力,从芯片设计到数据中心网络、软件框架(XLA、JAX)全部自研,避免"CUDA税",形成难以复制的成本和性能优势。

TPU与Google AI生态

模型训练:支撑Gemini 3、Imagen 3、AlphaFold等旗舰模型训练,使Google能够以更低成本、更快速度迭代模型。

推理服务:为Google搜索、广告、翻译等核心服务提供低延迟、高吞吐的AI推理能力,同时通过Google Cloud向全球客户提供TPU服务。

总结

Trillium TPU代表了Google在AI专用芯片领域的最新突破,标志着TPU从"训练导向"向"推理与训练并重"的战略转型,为Google在大模型时代的领先地位提供了强大的硬件支撑。随着TPU v7(Ironwood)的即将推出,Google正持续强化其在AI基础设施领域的领导地位,推动AI技术向更高效、更经济的方向发展。

更多推荐

已为社区贡献53条内容

已为社区贡献53条内容

所有评论(0)