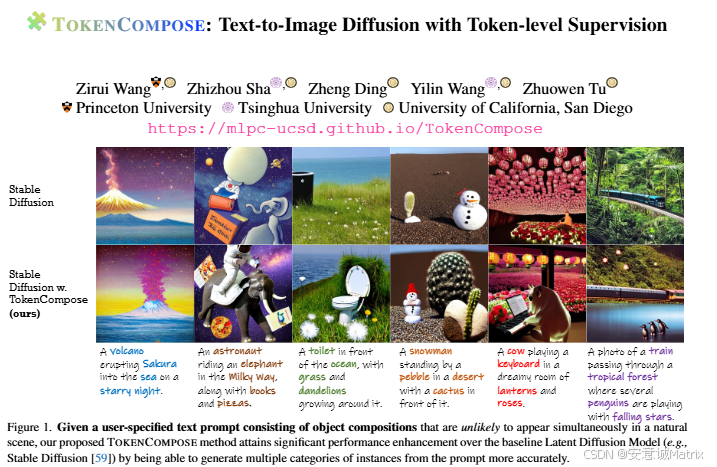

AI论文整理:TOKENCOMPOSE: Text-to-Image Diffusion with Token-level Supervision

为解决现有文本到图像扩散模型(如)在生成多类别物体组合(尤其是现实中不常见的组合)时文本与图像一致性差的问题,研究者提出方法:通过在微调阶段引入token级监督,利用POS标注器提取文本中的名词token,结合自动生成对应物体的二进制分割掩码,设计Token-level注意力损失(L_token)和Pixel-level注意力损失(L_pixel),与原 latent 扩散模型(LDM)的去噪损失

1. 一段话总结

为解决现有文本到图像扩散模型(如Stable Diffusion)在生成多类别物体组合(尤其是现实中不常见的组合)时文本与图像一致性差的问题,研究者提出TokenCompose方法:通过在微调阶段引入token级监督,利用POS标注器提取文本中的名词token,结合Grounded SAM自动生成对应物体的二进制分割掩码,设计Token-level注意力损失(L_token) 和Pixel-level注意力损失(L_pixel),与原 latent 扩散模型(LDM)的去噪损失(L_LDM)联合优化;该方法无需额外人工标注,在VISOR基准(Object Accuracy达52.15%)和自建的MULTIGEN基准(多类别生成成功率MG2-5优于基线)上表现突出,同时提升图像真实感(FID值更低)且无额外推理成本,还能泛化到Stable Diffusion v2.1并实现分割任务的知识迁移。

2. 思维导图(mindmap)

## 研究背景与问题

- 现有文本到图像扩散模型(如Stable Diffusion)局限

- 多类别物体组合生成时文本-图像一致性差

- 不常见物体组合易缺失或布局不合理

- 仅以文本为条件,无显式token-图像一致性约束

- 研究动机:提升多类别物体组合生成准确性与真实感

## 方法设计:TokenCompose

- 核心思路:引入token级监督,联合优化去噪与token-图像一致性

- 训练Pipeline

1. 文本预处理:POS标注器提取名词token

2. 分割掩码生成:Grounded SAM生成名词token对应二进制分割掩码

3. 损失函数:联合优化L_LDM、L_token、L_pixel

- 关键组件

- L_token:约束注意力激活聚集于目标分割区域(归一化)

- L_pixel:像素级交叉熵损失,避免注意力过度聚集于子区域

- 超参数:λ(L_token权重,1e-3)、γ(L_pixel权重,5e-5)

## 实验设置

- 数据集:COCO子集(~4526图像-文本对,含分割掩码)

- 模型基础:Stable Diffusion v1.4(主实验)、v2.1(泛化验证)

- 训练参数

- 学习率:5e-6

- 训练步数:v1.4(24000步)、v2.1(32000步)

- 批次:1(4步梯度累积)

- 基线对比:Composable Diffusion、Layout Guidance、Structured Diffusion、Attend-and-Excite

- 评价指标

- 多类别组合:Object Accuracy(VISOR)、MG2-5(MULTIGEN)

- 真实感:FID(COCO、Flickr30K)

- 效率:单张图像生成时间(NVIDIA RTX 3090)

## 实验结果

- 多类别组合性能:Ours在Object Accuracy(52.15%)、MG2-5均优于所有基线

- 泛化性:在SD v2.1上同样提升(Object Accuracy达60.10%)

- 知识迁移:分割任务mIoU提升(从0.5371→0.5876)

- 效率:无额外推理成本(生成时间~7.56s,与SD相当)

## 局限性与结论

- 局限性:仅针对名词token,未涵盖形容词、动词等

- 结论

- TokenCompose有效提升多类别物体组合生成能力

- MULTIGEN基准可用于评估多类别组合生成性能

- 验证了图像理解模型与生成模型协同的价值

3. 详细总结

1. 研究背景与动机

现有文本到图像扩散模型(如Stable Diffusion)虽在图像质量、分辨率等方面取得进展,但存在核心问题:多类别物体组合生成时文本与图像一致性不足。当文本包含现实中不常见的多类别物体(如“银河系中骑大象的宇航员,旁边有书和披萨”)时,模型常出现物体缺失、布局不合理的情况。

根本原因在于:模型仅以文本为条件优化去噪损失(L_LDM),未对文本token与图像内容的对应关系施加显式约束,导致无法泛化到任意物体组合。因此,研究需设计token级监督机制,提升多类别物体组合的生成准确性与真实感。

2. 方法设计:TokenCompose

2.1 核心思路

通过自动获取token级分割监督信号,在微调阶段将“文本token-图像分割区域”的一致性约束融入扩散模型训练,实现“去噪优化”与“token-图像对齐”的联合学习,且无需额外人工标注。

2.2 训练Pipeline

- 文本预处理:使用POS标注器(flair/pos-english)从训练文本中提取所有名词token(如“donut”“coffee”“table”),过滤非名词token以聚焦物体类别。

- 分割掩码生成:利用Grounded SAM(结合Grounding DINO与Segment Anything)自动生成每个名词token对应的二进制分割掩码(M_i),掩码值为1的区域代表该token对应的物体位置。

- 掩码分辨率匹配:针对U-Net不同层的交叉注意力图(A)分辨率差异,通过双线性插值将分割掩码(M_i)下采样至对应分辨率,并二值化得到M_i^(m)(m为U-Net层)。

- 联合损失优化:将原LDM损失与token级、像素级损失结合,优化U-Net参数(VAE、文本编码器冻结)。

2.3 关键损失函数

| 损失类型 | 公式核心 | 作用 |

|---|---|---|

| L_LDM(去噪损失) | EE(x),y,ϵ∼N(0,1),t[∣ϵ−ϵθ(zt,t,τθ(y))∣22]\mathbb{E}_{\mathcal{E}(x), y, \epsilon \sim \mathcal{N}(0,1), t}\left[\left| \epsilon-\epsilon_{\theta}\left(z_{t}, t, \tau_{\theta}(y)\right)\right| _{2}^{2}\right]EE(x),y,ϵ∼N(0,1),t[∣ϵ−ϵθ(zt,t,τθ(y))∣22] | 基础损失,预测 latent 中的噪声,保证图像生成基础质量 |

| L_token(Token级损失) | 1N∑iN(1−∑u∈BiLztA(i,u)∑uLtA(i,u))2\frac{1}{N} \sum_{i}^{N}\left(1-\frac{\sum_{u \in \mathcal{B}_{i}}^{L_{z_{t}}} \mathcal{A}_{(i, u)}}{\sum_{u}^{L_{t}} \mathcal{A}_{(i, u)}}\right)^{2}N1∑iN(1−∑uLtA(i,u)∑u∈BiLztA(i,u))2 | 约束交叉注意力激活聚集于分割区域(B_i为M_i^(m)中值为1的区域),归一化避免偏置 |

| L_pixel(Pixel级损失) | −1Lτθ(y)Lzt∑iLτθ(y)∑uLzt(M(i,u)log(A(i,u))+(1−M(i,u))log(1−A(i,u)))-\frac{1}{L_{\tau_{\theta}(y)} L_{z_{t}}} \sum_{i}^{L_{\tau_{\theta}(y)}} \sum_{u}^{L_{z_{t}}}\left(\mathcal{M}_{(i, u)} log \left(\mathcal{A}_{(i, u)}\right) +\left(1-\mathcal{M}_{(i, u)}\right) log \left(1-\mathcal{A}_{(i, u)}\right)\right)−Lτθ(y)Lzt1∑iLτθ(y)∑uLzt(M(i,u)log(A(i,u))+(1−M(i,u))log(1−A(i,u))) | 像素级交叉熵,避免注意力过度聚集于分割区域内的子区域,提升激活分布合理性 |

最终总损失:LTokenCompose=LLDM+∑mM(λLtoken(m)+γLpixel(m))\mathcal{L}_{TokenCompose} = \mathcal{L}_{LDM} + \sum_{m}^{M}(\lambda \mathcal{L}_{token}^{(m)} + \gamma \mathcal{L}_{pixel}^{(m)})LTokenCompose=LLDM+∑mM(λLtoken(m)+γLpixel(m)),其中λ=1e-3、γ=5e-5(平衡各损失权重)。

2.4 训练细节

- 模型基础:基于Stable Diffusion v1.4(主实验)、v2.1(泛化验证);

- 训练数据:COCO子集(~4526图像-文本对,来自Visual Spatial Reasoning数据集,经CLIP筛选高语义相似度文本);

- 训练参数:学习率5e-6,训练步数24000(v1.4)/32000(v2.1),批次1(4步梯度累积),仅优化U-Net(VAE、文本编码器冻结);

- 注意力层约束:仅对U-Net的中间块(U_Mid)和解码器(U_D)的交叉注意力层施加L_token与L_pixel。

3. 实验设计与结果

3.1 实验设置

| 类别 | 详情 |

|---|---|

| 基线模型 | 1. Composable Diffusion;2. Layout Guidance Diffusion;3. Structured Diffusion;4. Attend-and-Excite |

| 评价基准 | 1. VISOR:评估2类别物体组合(Object Accuracy);2. MULTIGEN(自建):评估5类别物体组合(MG2-5:生成2-5类物体的成功率) |

| 评价指标 | 多类别组合:Object Accuracy、MG2-5;真实感:FID(越低越好);效率:单图生成时间(NVIDIA RTX 3090,50 DDIM步) |

3.2 核心实验结果(表1:SD v1.4对比)

| 方法 | Object Accuracy(%) | MG2(COCO) | MG4(COCO) | MG5(COCO) | FID(COCO) | 生成时间(s) |

|---|---|---|---|---|---|---|

| SD(基线) | 29.86 | 90.72±1.33 | 11.68±0.45 | 0.88±0.21 | 20.88 | 7.54±0.17 |

| Layout Guidance | 43.59 | 93.22±0.69 | 19.49±0.88 | 2.27±0.44 | - | 18.89±0.20 |

| Attend-and-Excite | 45.13 | 93.64±0.76 | 28.01±0.90 | 6.01±0.61 | - | 25.43±4.89 |

| Ours(TokenCompose) | 52.15 | 98.08±0.40 | 28.81±0.95 | 3.28±0.48 | 20.19 | 7.56±0.14 |

关键结论:

- 多类别组合性能最优:Object Accuracy达52.15%,较SD基线提升22.29个百分点;MG2-5在COCO和ADE20K数据集上均优于所有基线;

- 真实感提升:FID(COCO)从20.88降至20.19,图像更逼真;

- 效率无损失:生成时间与SD基线相当(7.56s),远快于Attend-and-Excite(25.43s)等基线。

3.3 消融实验(表2)

验证各组件作用:

- 仅L_LDM微调:Object Accuracy仅38.02%,说明仅去噪优化提升有限;

- L_LDM+L_pixel:Object Accuracy 37.46%,L_pixel单独作用微弱;

- L_LDM+L_token:Object Accuracy 49.85%,L_token是提升核心,但易导致注意力过度聚集;

- 全损失(L_LDM+L_token+L_pixel):Object Accuracy达52.15%,证明两者结合可互补优势。

3.4 泛化性与知识迁移

- 泛化到SD v2.1(表3):Object Accuracy从冻结模型的47.82%提升至60.10%,MG4(COCO)从25.57%提升至36.69%,验证方法普适性;

- 知识迁移至分割任务(表4):在COCO-Gen数据集上,分割mIoU从SD基线的0.5371提升至0.5876,说明模型学到的token-分割对应关系可迁移。

4. 局限性与结论

4.1 局限性

- 仅针对名词token施加监督,未涵盖形容词(如颜色)、动词(如动作)等文本成分,无法优化属性绑定或动作一致性;

- 多类别生成中,5类物体的成功率(MG5)仍较低(COCO仅3.28%),复杂组合生成仍有挑战。

4.2 结论

- 方法有效性:TokenCompose通过token级监督,显著提升文本到图像模型的多类别物体组合生成能力,兼顾真实感与效率;

- 基准价值:自建的MULTIGEN基准填补了“多类别(>2类)物体组合评估”的空白;

- 协同潜力:验证了图像理解模型(Grounded SAM)与生成模型协同的价值,为后续跨模态模型优化提供思路。

4. 关键问题

问题1:TokenCompose如何解决现有文本到图像扩散模型在多类别物体组合生成中的一致性问题?

答案:核心通过“自动token级监督+联合损失优化”解决:

- 监督信号自动获取:无需人工标注,利用POS标注器提取文本中的名词token,结合Grounded SAM生成每个token对应的二进制分割掩码,建立“文本token-图像区域”的对应关系;

- 双损失约束注意力:设计L_token(约束注意力激活聚集于分割区域,归一化避免偏置)和L_pixel(像素级交叉熵,避免注意力过度聚集于子区域),与原LDM去噪损失联合优化;

- 聚焦关键层优化:仅对U-Net的中间块(U_Mid)和解码器(U_D)的交叉注意力层施加约束,平衡优化效果与计算成本。最终使模型在生成多类别物体时,每个token能精准对应图像中的物体区域,提升文本-图像一致性。

问题2:相比现有基线方法,TokenCompose在性能和效率上有哪些核心优势?

答案:优势体现在“性能更优”“真实感更强”“效率无损失”三方面:

- 性能优势:在多类别组合评估中,Object Accuracy(52.15%)较SD基线(29.86%)提升22.29个百分点,较次优基线Attend-and-Excite(45.13%)提升7.02个百分点;MG2-5(多类别生成成功率)在COCO和ADE20K数据集上均为最优;

- 真实感优势:FID(COCO)从SD基线的20.88降至20.19,图像更接近真实场景;

- 效率优势:单张图像生成时间(7.56s)与SD基线(7.54s)基本一致,远快于Layout Guidance(18.89s)、Attend-and-Excite(25.43s)等基线,因无需在推理阶段进行梯度回传或注意力图操纵,无额外计算成本。

问题3:TokenCompose的泛化性和知识迁移能力体现在哪些方面,验证依据是什么?

答案:泛化性体现在“跨模型版本”,知识迁移体现在“跨任务(生成→分割)”,具体验证如下:

- 泛化到不同模型版本:将TokenCompose应用于Stable Diffusion v2.1(输入分辨率、文本编码器、训练策略与v1.4不同),Object Accuracy从冻结模型的47.82%提升至60.10%,MG4(COCO)从25.57%提升至36.69%,FID(COCO)从19.59优化至19.15,证明方法不依赖特定模型版本;

- 知识迁移至分割任务:利用DAAM算法评估模型分割能力,在COCO-Gen数据集上,SD v1.4冻结模型的分割mIoU为0.5371,经TokenCompose微调后提升至0.5876,说明模型在训练中习得的“token-分割区域对应关系”可迁移到下游分割任务,验证跨任务知识复用价值。

更多推荐

已为社区贡献53条内容

已为社区贡献53条内容

所有评论(0)