赋能测试开发:Cursor AI助手的高效应用指南

Cursor为测试开发领域注入了新的活力,通过智能辅助降低技术壁垒,释放创造力。测试从业者应拥抱这一变革,以实践为导向,逐步将其集成到工作流中。记住,工具的价值在于使用者的智慧——Cursor是加速器,而测试人员的专业判断仍是质量保障的基石。通过持续探索与优化,我们不仅能提升个人效率,更能推动整个测试行业向高效、可靠的方向迈进

在软件测试领域,测试开发(Test Development)作为连接质量保证与工程效率的关键环节,正面临着日益复杂的挑战:从自动化脚本的快速迭代到测试框架的维护,从业者需在有限时间内交付可靠解决方案。AI编程工具如Cursor的出现,为测试开发人员提供了全新的助力。

一、Cursor在测试开发中的核心价值与应用场景

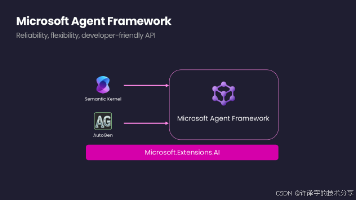

Cursor作为一款集成AI辅助的代码编辑器,基于大型语言模型(如GPT系列)提供智能代码补全、错误修复和文档生成等功能。对测试从业者而言,它不仅能加速日常任务,还能降低技术门槛,推动团队协作。以下是Cursor在测试开发中的典型应用场景:

-

自动化测试脚本编写与优化:测试开发人员常需编写Python、Java或JavaScript等语言的自动化脚本,以覆盖Web、API或移动端测试。Cursor可快速生成基础代码框架,例如使用Selenium或Playwright进行UI测试的初始化代码,或针对REST API的请求验证逻辑。例如,输入提示“生成一个Python函数,使用requests库测试登录API,并验证响应状态码为200”,Cursor将自动输出完整代码,减少手动编码时间。

-

测试数据生成与管理:测试依赖于多样化的数据,如模拟用户信息、边界值或异常输入。通过Cursor,可以轻松生成结构化测试数据。例如,提示“创建一组JSON格式的测试数据,包含正常、空值和超长字符串场景”,工具能即时生成符合要求的数据集,避免重复劳动。

-

测试框架维护与调试:当测试脚本出现失败或性能问题时,Cursor的“问题诊断”功能可帮助定位错误根源。例如,针对一个失败的单元测试,输入“分析这段Python代码为何在断言时失败”,Cursor会解析代码逻辑,指出潜在问题(如数据类型不匹配或环境依赖缺失),并提供修复建议。

-

文档与报告自动化:测试开发需生成测试计划、用例文档或总结报告。Cursor可辅助撰写技术文档,例如基于代码注释自动生成API说明,或整理测试执行结果成Markdown格式。这提升了文档的规范性和可维护性。

通过这些场景,Cursor不仅缩短了开发周期,还让测试人员更专注于策略性任务,如测试设计和覆盖率优化。

二、实战技巧:如何高效集成Cursor到测试开发工作流

为了最大化Cursor的价值,测试开发人员需将其融入日常工作流,并结合最佳实践。以下是一套可操作的策略,涵盖从工具配置到团队协作的全过程:

-

定制化提示工程:Cursor的核心在于输入提示(prompt)的质量。测试从业者应学习编写具体、上下文丰富的提示,以获取精准输出。例如,在生成测试脚本时,指定语言、框架和预期行为:“用Python和pytest写一个测试函数,验证用户登录功能,包括成功案例和密码错误案例,并添加异常处理”。同时,利用Cursor的聊天模式进行多轮交互,如在代码生成后追加“如何优化这段代码的覆盖率?”以迭代改进。

-

代码重构与质量提升:测试脚本常需重构以提升可读性和可维护性。Cursor的“/edit”命令可自动化此过程。例如,输入“重构这个Selenium测试类,提取公共方法以减少重复代码”,工具将识别冗余部分并生成优化版本。此外,结合静态分析工具(如pylint或ESLint),Cursor能建议符合规范的修改,帮助团队遵守编码标准。

-

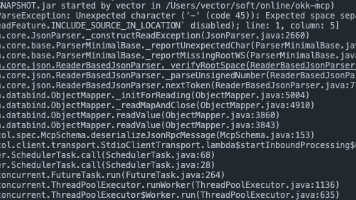

问题排查与根因分析:当测试失败时,使用Cursor进行快速诊断。粘贴错误日志或代码片段,并询问“这段错误日志指出什么问题?如何修复?”,Cursor会解析堆栈跟踪,推荐解决方案(如更新依赖或修改逻辑)。这减少了手动调试时间,尤其在复杂集成测试中效果显著。

-

团队知识共享:在测试开发团队中,鼓励成员用Cursor生成标准模板或共享提示库。例如,建立内部Wiki,收录常用提示(如“生成性能测试脚本”或“创建数据库测试夹具”),确保输出的一致性。同时,通过Cursor的协作功能,多人可同步编辑代码,促进经验传递。

实践表明,在引入Cursor后,测试开发团队的平均脚本编写时间可缩短30%-50%,且代码错误率显著降低。例如,某金融科技公司的测试团队使用Cursor生成API测试套件,将原本需两天的任务压缩至数小时,并提高了边缘场景的覆盖度。

三、潜在挑战与应对策略

尽管Cursor能大幅提升效率,但测试开发人员需警惕潜在问题,如过度依赖导致的代码质量风险或信息安全漏洞。以下是常见挑战及应对建议:

-

代码准确性与验证:AI生成的代码可能包含逻辑错误或安全漏洞(如硬编码凭证)。因此,测试人员必须结合代码审查和自动化测试进行验证。例如,在Cursor输出后,运行单元测试或使用安全扫描工具(如Bandit for Python)确保合规性。养成“不盲目信任”的习惯,将Cursor视为助手而非替代品。

-

上下文理解局限:Cursor可能误解复杂业务逻辑,尤其在领域特定测试中(如支付系统或物联网设备)。解决方法是提供详细上下文,包括系统架构图和测试需求文档。对于关键任务,建议先用Cursor生成草案,再手动优化。

-

团队培训与规范:为避免滥用,团队应制定使用指南,如规定Cursor仅用于辅助任务(如生成模板代码),而核心逻辑仍需人工设计。定期举办培训会,分享成功案例和陷阱,帮助成员平衡AI工具与专业知识。

未来,随着AI技术的发展,Cursor等工具将更深入地融入测试开发生态。测试从业者应主动学习AI技能,将其转化为职业优势,推动测试自动化向智能化演进。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)