YOLOv8【检测头篇·第8节】一文搞定,大目标检测头部优化!

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》 专栏。该专栏系统复现并梳理全网各类 YOLOv8 改进与实战案例(当前已覆盖分类 / 检测 / 分割 / 追踪 / 关键点 / OBB 检测等方向),坚持持续更新 + 深度解析,质量分长期稳定在 97 分以上,可视为当前市面上 覆盖较全、更新较快、实战导向极强 的 YOLO 改进系列内容之一。部分章节也会结合国内外前沿论文与 AIGC 等大

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》 专栏。该专栏系统复现并梳理全网各类 YOLOv8 改进与实战案例(当前已覆盖分类 / 检测 / 分割 / 追踪 / 关键点 / OBB 检测等方向),坚持持续更新 + 深度解析,质量分长期稳定在 97 分以上,可视为当前市面上 覆盖较全、更新较快、实战导向极强 的 YOLO 改进系列内容之一。

部分章节也会结合国内外前沿论文与 AIGC 等大模型技术,对主流改进方案进行重构与再设计,内容更偏实战与可落地,适合有工程需求的同学深入学习与对标优化。

✨ 特惠福利:当前限时活动一折秒杀,一次订阅,终身有效,后续所有更新章节全部免费解锁 👉 点此查看详情

全文目录:

-

-

- 📚 上期回顾

- 1. 引言:“大”的烦恼

- 2. 核心策略一:大感受野设计 (Large Receptive Field Design)

- 3. 核心策略二:多尺度采样与全局上下文 (Multi-scale Sampling & Global Context)

- 4. 核心策略三:边界回归精度 (Boundary Regression Precision)

- 5. 核心策略四:遮挡处理能力 (Occlusion Handling Ability)

- 6. 🚀 实战代码:构建“巨物感知”检测头 (LargeObjectHead)

- 7. 代码逐行解析

- 7. 总结与展望

- 📚 下期预告:

- 🧧🧧 文末福利,等你来拿!🧧🧧

- 🫵 Who am I?

-

📚 上期回顾

在上一期《YOLOv8【检测头篇·第7节】一文搞懂,小目标检测专用头部设计!》内容中,我们深入探讨了目标检测领域公认的一大“硬骨头”——小目标检测。

我们一起分析了为什么小目标“难搞”:

- 分辨率低:小目标在图像中只占几个像素,信息量少得可怜。

- 特征易丢失:在深度网络的下采样过程中,小目标的特征很容易被“稀释”甚至完全消失。

- 信噪比低:小目标很容易被背景噪声淹没。

- 定位不准:几个像素的偏差可能导致 IoU(交并比)急剧下降。

为了“拯救”这些小目标,我们祭出了一系列“法宝”:

- 利用高分辨率特征:我们不再仅仅依赖 P3、P4、P5 这些深层特征,而是大胆地将更浅层、分辨率更高的 P2 特征(甚至 P1)引入到 FPN/PANet 结构中,为小目标提供更丰富的细节信息。

- 优化多尺度融合策略:我们探讨了像 BiFPN 这样的加权特征融合机制,让来自不同层级的特征能够更“智能”地贡献信息。

- 设计细粒度分类器:针对小目标,我们讨论了如何使用更专注的分类器(例如,使用更小的卷积核或专门的分支)来提高分类准确性。

- 提升位置回归精度:我们研究了如何通过优化损失函数(如使用 Focal Loss 处理样本不平衡)或引入专门的回归分支来提高小目标的定位精度。

- 上下文信息增强:利用注意力机制(如 CBAM、SE)或增大浅层特征的感受野,让网络在检测小目标时能“多看一眼”周围的环境。

通过这些优化,我们显著提升了 YOLOv8 对微小目标的“感知力”。

然而,一个优秀的检测器,不仅要能“明察秋毫”(看清小目标),还要能“高瞻远瞩”(看全大目标)。

你可能会想:“大目标那么大,那么清晰,检测起来还不容易吗?”

如果你也这么想,那今天的“大目标检测头部优化”你可千万不能错过!事实证明,“大”也有“大”的烦恼!

1. 引言:“大”的烦恼

在目标检测任务中,我们总是习惯性地聚焦于小目标,因为它们难以被发现。但“大目标”——那些在图像中占据大量像素(例如,超过 9 6 2 96^2 962 像素)的物体,如近处的行人、公交车、广告牌等——同样带来了独特的挑战。

为什么大目标检测也是一个挑战?

我们来设想几个场景:

-

场景一:边界不准

- 一个大目标(比如一辆公交车)横跨了半个屏幕。模型很容易识别出“这是一辆公交车”,但要精确地画出它的边界框却异常困难。

- 对于大目标,一个 5% 的 IoU 误差可能意味着边界框偏离了二三十个像素!这在视觉上是完全不可接受的。而 5% 的 IoU 误差对一个小目标来说,可能只是 1–2 个像素的偏差。

- 负责检测大目标的 P5 特征图(YOLOv8 中下采样 32 倍)分辨率很低。在低分辨率图上预测的微小偏差,映射回原图后会被放大 32 倍!

-

场景二:遮挡严重

- 大目标由于“体积”庞大,更容易被其他物体遮挡(例如,公交车被树木、行人遮挡),或者因为太近而只显示了物体的一部分(截断)。

- 模型可能只看到了公交车的“车头”和“车轮”,它需要推理出这是一个完整的公交车,并给出完整的边界框,而不是只框出它看到的部分。

-

场景三:特征混淆

- 当一个物体极大时,它的内部纹理(比如公交车身上的广告)可能会被误认为是另一个独立的物体。

- 同时,检测大目标的深层特征图(P5)具有很大的感受野,这本是好事。但如果感受野“过大”,它可能会“过度平滑”掉物体的关键边界细节,或者将背景特征(如旁边的建筑物)也“揉”了进来,导致特征混淆。

总结一下,大目标检测的“三大痛点”:

- 边界回归精度低(Poor Boundary Precision):定位难,差之毫厘,谬以千里。

- 遮挡与截断(Occlusion & Truncation):信息不全,依赖“脑补”。

- 特征表征不佳(Feature Representation Issues):要么细节丢失,要么上下文混淆。

针对这些痛点,我们必须对 YOLOv8 的检测头(尤其是负责大目标的 P5 检测头)进行“特化”升级!

2. 核心策略一:大感受野设计 (Large Receptive Field Design)

感受野(Receptive Field, RF)是指卷积神经网络中,输出特征图上的一个像素点,对应于输入图像上的区域大小。

- 对于小目标:我们需要较小的感受野,以聚焦细节。

- 对于大目标:我们需要巨大的感受野,以“看全”整个物体及其周围环境。

YOLOv8 的 Backbone(如 CSPDarknet)通过不断堆叠卷积和下采样,已经在 P5 层(32 倍下采样)获得了很大的感受野。此外,它在 Neck 的末端(送入 Head 之前)使用了 SPPF (Spatial Pyramid Pooling Fast) 模块来进一步增大感受野。

回顾 YOLOv8 的 SPPF:

SPPF 是 SPP (Spatial Pyramid Pooling) 的“快速版”。它通过串联多个 5 × 5 5 \times 5 5×5 的 MaxPool 层(等效于并联 5 × 5 , 9 × 9 , 13 × 13 5 \times 5, 9 \times 9, 13 \times 13 5×5,9×9,13×13 的 MaxPool),以极小的计算代价,实现了多尺度的感受野融合。

# YOLOv8中的SPPF模块 (ultralytics/nn/modules.py)

class SPPF(nn.Module):

# Spatial Pyramid Pooling - Fast (SPPF) layer for YOLOv8 by Glenn Jocher

def __init__(self, c1, c2, k=5): # k=5 for SPPF in YOLOv8

super().__init__()

c_ = c1 // 2 # hidden channels

self.cv1 = Conv(c1, c_, 1, 1) # 1x1 卷积降维

self.cv2 = Conv(c_ * 4, c2, 1, 1) # 1x1 卷积升维(融合后)

self.m = nn.MaxPool2d(kernel_size=k, stride=1, padding=k // 2)

def forward(self, x):

x = self.cv1(x) # 先降维

y1 = self.m(x) # 第一次 5x5 MaxPool

y2 = self.m(y1) # 第二次 5x5 MaxPool (等效 9x9)

y3 = self.m(y2) # 第三次 5x5 MaxPool (等效 13x13)

return self.cv2(torch.cat((x, y1, y2, y3), 1)) # 拼接四个尺度

SPPF 很好,但它也有缺点:MaxPool 是一种比较“粗暴”的信息聚合方式,它只保留了局部区域的“最强”特征,可能会丢失很多有用的信息,尤其是对于边界定位不利。

“杀手锏”:ASPP (Atrous Spatial Pyramid Pooling)

ASPP(空洞空间金字塔池化)是 DeepLab 系列(用于语义分割)的“招牌”模块。它使用空洞卷积(Atrous Convolution,也叫 Dilation Convolution)来实现大感受野。

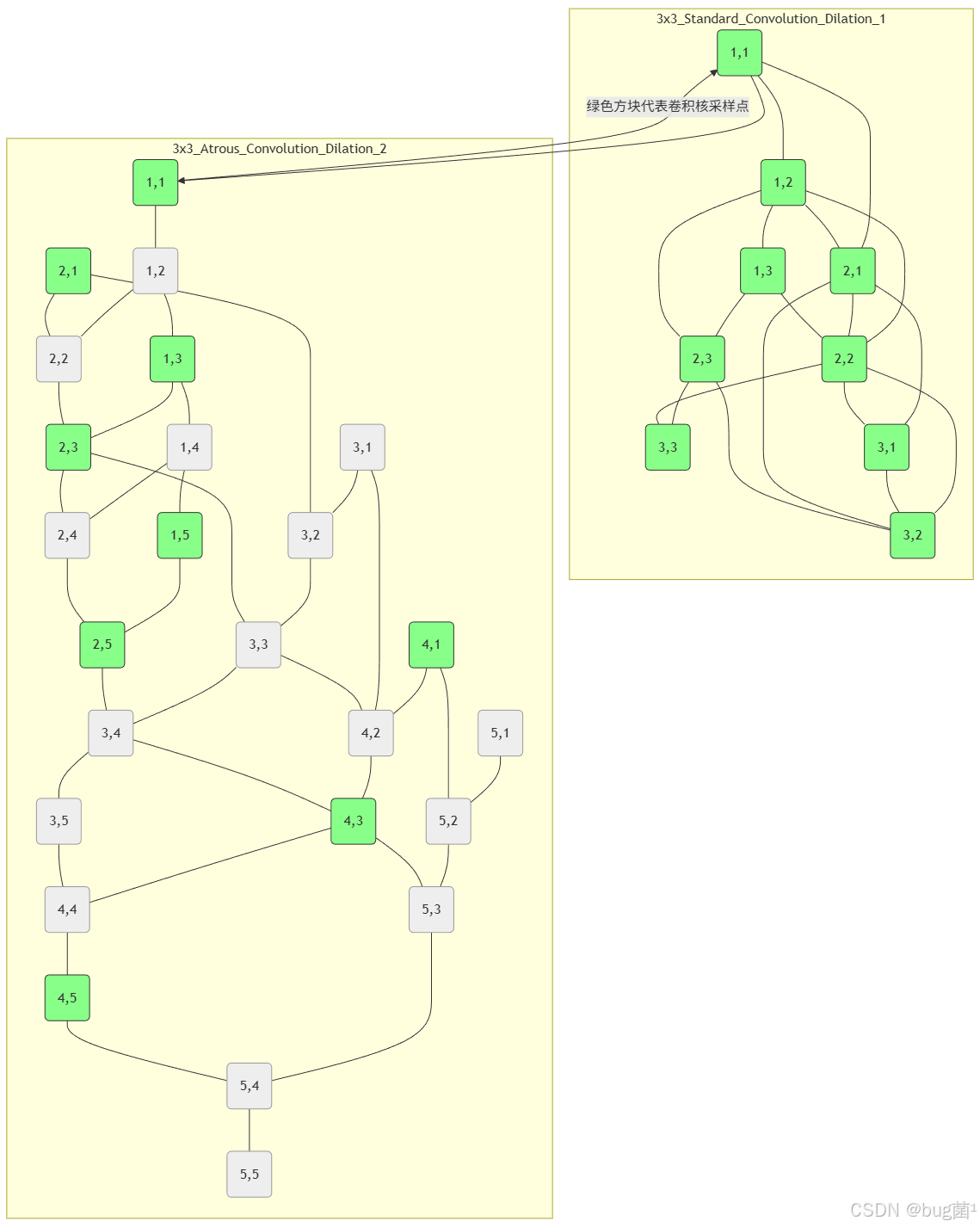

什么是空洞卷积?

它在标准的卷积核中“注入”空洞(Dilation Rate > 1),使得卷积核在计算时能够“跳过”一些像素。

- 3 × 3 3 \times 3 3×3 卷积,Dilation Rate = 1:标准卷积,感受野 3 × 3 3 \times 3 3×3

- 3 × 3 3 \times 3 3×3 卷积,Dilation Rate = 2:卷积核覆盖 5 × 5 5 \times 5 5×5 的区域,感受野 5 × 5 5 \times 5 5×5

- 3 × 3 3 \times 3 3×3 卷积,Dilation Rate = 6:卷积核覆盖 13 × 13 13 \times 13 13×13 的区域,感受野 13 × 13 13 \times 13 13×13

优势:在不增加计算量(参数量不变)且不进行下采样(保持分辨率)的情况下,指数增大了感受野!

ASPP 就是将不同 Dilation Rate 的空洞卷积,以及一个全局平均池化(Global Average Pooling, GAP)并联起来,从而在多个尺度上捕捉上下文信息。

我们可以用 ASPP 来替换或增强 SPPF,专门用于处理 P5 特征图。

图解:标准卷积 vs. 空洞卷积

(在 ASPP 中,Dilation=2 的 3 × 3 3 \times 3 3×3 卷积核,实际感受野达到了 5 × 5 5 \times 5 5×5)

3. 核心策略二:多尺度采样与全局上下文 (Multi-scale Sampling & Global Context)

3.1 多尺度采样 (Multi-scale Sampling)

YOLOv8(以及大多数 YOLO)使用 P3、P4、P5 三层特征图(分别下采样 8、16、32 倍)来检测不同大小的物体。P5(1/32)是默认的“大目标”检测层。

但如果物体特别大呢? 比如在自动驾驶中,前方的卡车占满了整个视野。

此时,P5 的感受野可能仍然不足以“看全”它,或者 P5 的分辨率太低(例如,对于 640 × 640 640 \times 640 640×640 的输入,P5 只有 20 × 20 20 \times 20 20×20),导致信息压缩过于严重。

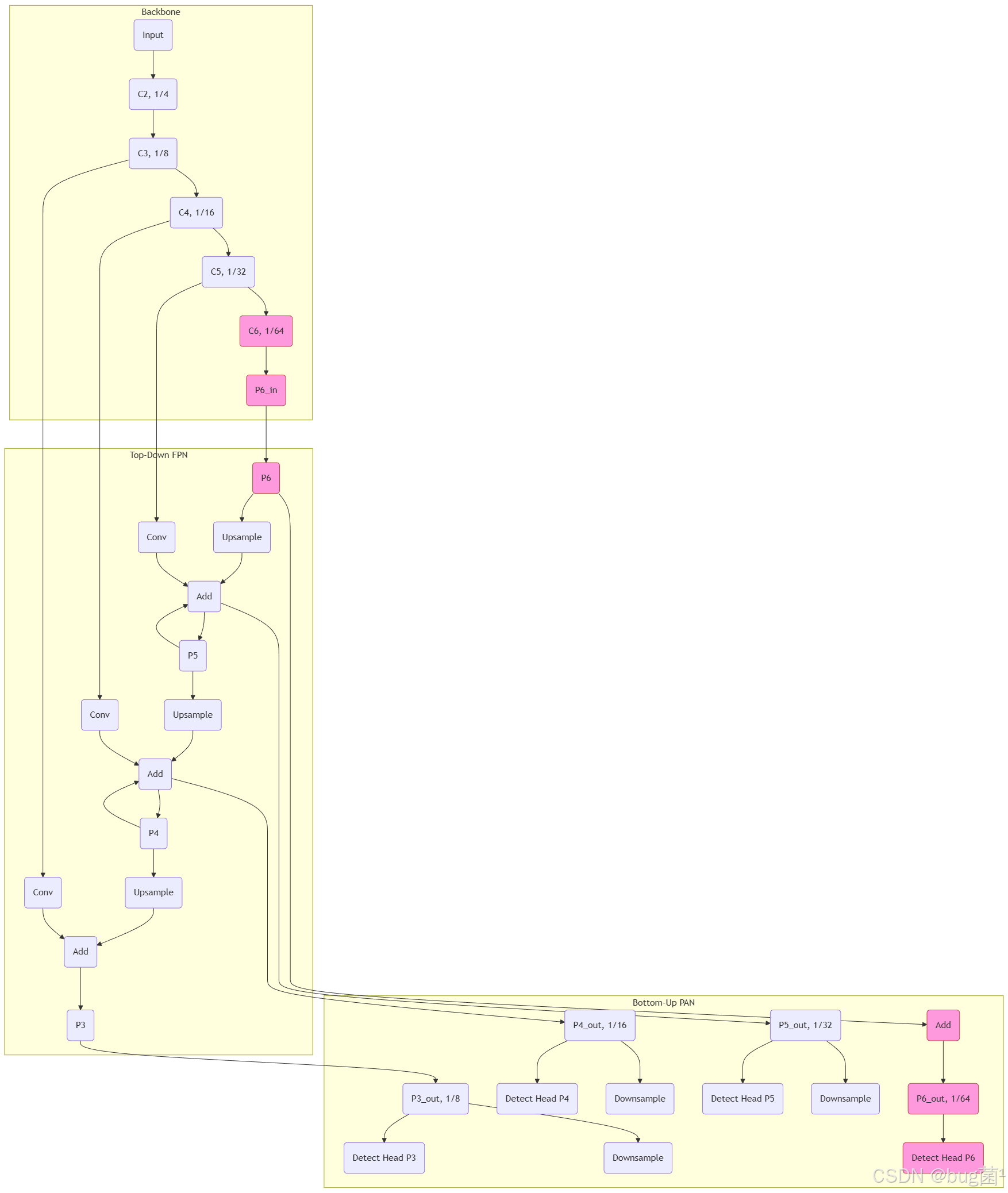

解决方案:引入 P6 层。

就像我们在第 117 篇为了小目标引入 P2 一样,我们可以为了“超大目标”(Giant Objects)引入 P6。

如何实现?

在 Backbone 的 P5(即 C5)之后,再增加一个 3 × 3 3 \times 3 3×3 步长为 2 的卷积层,生成 P6 特征图(1/64 分辨率)。然后将 P6 也送入 PANet 进行融合,并最终生成一个专门用于检测超大目标的检测头。

图解:FPN/PANet 结构扩展(增加 P6)

(上图中粉色部分即为新增的 P6 路径)

注意:增加 P6 会显著增加计算量和内存占用,这是一种权衡(Trade-off)。通常只在需要检测超大物体且资源允许时才使用。

3.2 全局上下文建模 (Global Context Modeling)

大目标检测,尤其是处理遮挡时,非常依赖“上下文”。

- 你看到一个“轮子”和一段“黄色的车身”,如果上下文是“街道”,你猜它是“出租车”;如果上下文是“工地”,你可能猜它是“挖掘机”。

- 当一辆公交车被树遮挡时,你需要通过“街道”、“公交站牌”以及车辆的“可见部分”来共同推断出“这是一辆完整的公交车”。

P5(或 P6)的感受野虽然大,但它仍然是“局部”的(相对于整个图像)。我们需要一种机制来捕捉全局上下文(Scene-level Context)。

“神器”登场:Transformer Encoder Block 🤖

Transformer 的核心就是自注意力机制(Self-Attention),它天生就是用来建模“全局”依赖关系的。它可以计算特征图中任意两个像素之间的关系,无论它们相距多远。

我们可以将一个(或几个) Transformer Encoder Block 插入到 P5 特征图进入检测头之前。

工作流程:

- P5 特征图(例如 B × C × 20 × 20 B \times C \times 20 \times 20 B×C×20×20)被“展平”成一个序列( B × ( 20 × 20 ) × C B \times (20 \times 20) \times C B×(20×20)×C)。

- 序列中的每个 “Token”(即原图的一个 32 × 32 32 \times 32 32×32 区域的特征)计算与其他所有 Token 的“注意力得分”。

- 通过加权求和,每个 Token 都融合了来自整张图的信息。

- 特征序列被“重塑”回 B × C × 20 × 20 B \times C \times 20 \times 20 B×C×20×20,此时的特征已经具备了全局上下文。

这种方式计算量巨大,但对于解决大目标的遮挡和推理问题,效果非常好。

4. 核心策略三:边界回归精度 (Boundary Regression Precision)

这是大目标检测的“阿喀琉斯之踵”。

为什么大的边界很难画“准”?

- 特征分辨率低:在 20 × 20 20 \times 20 20×20 的 P5 特征图上,一个像素的移动,就对应原图 32 个像素的巨大位移。

- 特征“惰性”:深层特征擅长“分类”(这是什么),但拙于“定位”(它在哪)。它们对空间位置信息不敏感。

- 感受野过大:ASPP 或 SPPF 虽然带来了大感受野,但也可能导致边界特征被“平滑”掉,使得边界变得模糊不清。

解决方案:

4.1 解耦头 (Decoupled Head) 的再思考

我们在第 2 节和第 4 节(YOLOX)中深入讨论过解耦头。YOLOv8(v8.0)本身也采用了“准解耦头”(分类回归共享一部分卷积,最后再分离)。

对于大目标检测,一个“完全解耦”的头部至关重要!

- 分类任务(Classification):需要“全局”和“语义”信息。它应该依赖于经过 ASPP 或 Transformer 处理后的、具有大感受野和丰富上下文的特征。它要回答:“这个被遮挡的大块头是什么?”

- 回归任务(Regression):需要“高频”和“边缘”信息。它应该更依赖于来自 PANet 路径中、融合了浅层特征(如 P4 甚至 P3)的特征。它要回答:“这个东西的精确边界在哪里?”

因此,我们的优化方向是:在检测头内部,为分类和回归分支“特供”特征。

例如,回归分支可以额外“跳线连接”(Shortcut)一些未经 ASPP/Transformer 处理、保留更多空间细节的原始 P5 特征。

4.2 辅助损失:边界损失 (Boundary Loss)

IoU(CIoU, GIoU 等)是衡量“区域”重叠的。对于大目标,即使 IoU 很高(如 0.9),其边界也可能“漂移”得很远。

我们可以引入一个辅助的边界损失,专门惩罚边界的“不精确”。

如何实现?

- 预测的 Box → 生成一个“边界热图”(例如,在 Box 边缘 1–2 个像素内为 1,其余为 0)。

- 真实的 GT Box → 也生成一个“边界热图”。

- 计算这两个热图之间的损失(例如 Dice Loss 或 L1 Loss)。

- 最终 Loss = λ₁ × IoU Loss + λ₂ × Boundary Loss。

这会迫使回归分支对“边缘”变得极其敏感,从而极大提升大目标的定位精度。

5. 核心策略四:遮挡处理能力 (Occlusion Handling Ability)

大目标由于“树大招风”,极易被遮挡。

如何在“管中窥豹”时,也能“可见一斑”?

-

全局上下文建模(已在 3.2 讨论):这是最重要的。Transformer 或 ASPP 提供的全局信息,是模型进行“推理”的基础。

-

注意力机制的妙用:

- 空间注意力(Spatial Attention):当一个大目标被遮挡时,注意力模块(如 CBAM 中的 Spatial Attention Module)可以学会“忽略”遮挡区域(例如,一块广告牌),而“聚焦”于物体本身(例如,公交车的轮子和窗户)。

- 它学习一个“权重 Mask”,乘以原特征图,有效抑制噪声和遮挡物的干扰。

-

数据:模拟遮挡

- Random Erasing(随机擦除):在训练时,随机地在图像上(尤其是在大目标上)挖掉一块,用随机噪声或均值填充。这强迫模型学会在信息不全的情况下进行检测。

- Mosaic 和 CutMix:YOLOv8 内置的这些增强,本身就会产生大量的“截断”和“遮挡”样本,这对提升遮挡处理能力非常有益。

6. 🚀 实战代码:构建“巨物感知”检测头 (LargeObjectHead)

说了这么多理论,不来点代码怎么行!👨💻

我们的目标是:创建一个自定义的 YOLOv8 检测头 LargeObjectHead。

这个头将实现我们讨论的两个核心优化点:

- ASPP:替换 P5 检测分支的 SPPF(或在 C2f 后增加),以获得更强的大感受野和上下文感知能力。

- Transformer Encoder:在 P5 分支上加入一个轻量级的 Transformer 块,用于全局上下文建模。

注意:YOLOv8 的 Detect 头默认是给 P3, P4, P5 三个尺度用的。为了“专物专用”,我们的 LargeObjectHead 将只处理 P5(大目标)特征,或者在内部对 P5 进行特殊处理。

为了简化并保持与 YOLOv8 框架的兼容性,我们将设计一个可以替换标准 Detect 头的模块。我们将修改 Detect 头,使其在处理索引为 self.nl - 1(即最后一个特征图,通常是 P5)的输入时,应用我们的 ASPP 和 Transformer。

文件 1: custom_head.py

(你需要将此文件放在你的 YOLOv8 项目目录下,例如 ultralytics/nn/custom_head.py)

# -*- coding: utf-8 -*-

"""

《YOLOv8专栏》第118篇:大目标检测头部优化

实战代码:LargeObjectHead (巨物感知检测头)

功能:

1. 引入 ASPP (Atrous Spatial Pyramid Pooling) 增强P5层的感受野。

2. 引入 Transformer Encoder Block 增强P5层的全局上下文建模。

3. 保持与YOLOv8标准Detect头兼容的接口。

"""

import torch

import torch.nn as nn

import torch.nn.functional as F

import math

# 导入YOLOv8的基础模块

# 确保你的环境已经安装了ultralytics

# pip install ultralytics

try:

from ultralytics.nn.modules import Conv, DFL

from ultralytics.yolo.utils import dist2bbox, make_anchors

except ImportError:

print("请确保 'ultralytics' 库已正确安装。")

print("Run: pip install ultralytics")

# 为了能独立运行(如果需要),定义一些占位符

class Conv(nn.Module):

def __init__(self, c1, c2, k=1, s=1, p=None, g=1, act=True):

super().__init__()

self.conv = nn.Conv2d(c1, c2, k, s, p if p is not None else (k - 1) // 2, groups=g, bias=False)

self.bn = nn.BatchNorm2d(c2)

self.act = nn.SiLU() if act is True else (act if isinstance(act, nn.Module) else nn.Identity())

def forward(self, x):

return self.act(self.bn(self.conv(x)))

def fuseforward(self, x):

return self.act(self.conv(x))

class DFL(nn.Module):

def __init__(self, c1=17):

super().__init__()

self.conv = nn.Conv2d(c1, 1, 1, bias=False).requires_grad_(False)

x = torch.arange(c1, dtype=torch.float)

self.conv.weight.data[:] = nn.Parameter(x.view(1, c1, 1, 1))

self.c1 = c1

def forward(self, x):

b, c, a = x.shape

return self.conv(x.view(b, 4, self.c1, a).transpose(2, 1).softmax(1)).view(b, 4, a)

print("警告:无法从 'ultralytics' 导入模块,使用本地占位符定义。")

# === 1. ASPP 模块定义 ===

# 专门为大目标检测头设计

class ASPP(nn.Module):

"""

Atrous Spatial Pyramid Pooling (ASPP)

使用空洞卷积捕捉多尺度上下文信息

"""

def __init__(self, c_in, c_out, rates=[6, 12, 18]):

"""

初始化ASPP

Args:

c_in (int): 输入通道数

c_out (int): 输出通道数

rates (list): 空洞卷积的膨胀率

"""

super(ASPP, self).__init__()

# 1x1 卷积

self.conv1x1 = Conv(c_in, c_out, 1, 1, act=True)

# 3x3 空洞卷积

self.atrous_convs = nn.ModuleList()

for rate in rates:

self.atrous_convs.append(

Conv(c_in, c_out, 3, 1, p=rate, g=1, act=True) # 使用空洞卷积

)

# 全局平均池化 (Image Pooling)

self.image_pool = nn.Sequential(

nn.AdaptiveAvgPool2d(1),

Conv(c_in, c_out, 1, 1, act=True)

)

# 最后的 1x1 卷积,用于融合特征

# (1 + len(rates) + 1) * c_out = (len(rates) + 2) * c_out

self.final_conv = Conv((len(rates) + 2) * c_out, c_out, 1, 1, act=True)

def forward(self, x):

size = x.shape[2:]

# 1x1 卷积

x1 = self.conv1x1(x)

# 空洞卷积

xs = [x1]

for conv in self.atrous_convs:

xs.append(conv(x))

# 图像池化

x_img_pool = self.image_pool(x)

x_img_pool = F.interpolate(x_img_pool, size=size, mode='bilinear', align_corners=False)

xs.append(x_img_pool)

# 拼接并融合

x_cat = torch.cat(xs, dim=1)

x_out = self.final_conv(x_cat)

return x_out

# === 2. 轻量级 Transformer Encoder 模块 ===

# 用于全局上下文建模

class TransformerLayer(nn.Module):

"""

一个简化的 Transformer Encoder Layer

包含: Multi-head Self-Attention (MHSA) 和 Feed-Forward Network (FFN)

"""

def __init__(self, c, num_heads=8):

super().__init__()

self.q = nn.Linear(c, c, bias=False)

self.k = nn.Linear(c, c, bias=False)

self.v = nn.Linear(c, c, bias=False)

self.ma = nn.MultiheadAttention(embed_dim=c, num_heads=num_heads)

self.fc1 = nn.Linear(c, c * 4)

self.fc2 = nn.Linear(c * 4, c)

self.norm1 = nn.LayerNorm(c)

self.norm2 = nn.LayerNorm(c)

self.act = nn.GELU()

def forward(self, x):

# x shape: [B, C, H, W]

B, C, H, W = x.shape

# 1. 展平为序列: [B, C, H*W] -> [H*W, B, C] (Attention 模块的标准输入格式)

x_seq = x.flatten(2).permute(2, 0, 1)

# 2. 自注意力 (Self-Attention)

q = self.q(x_seq)

k = self.k(x_seq)

v = self.v(x_seq)

attn_output, _ = self.ma(q, k, v)

x_seq = self.norm1(x_seq + attn_output) # 残差连接 + LayerNorm

# 3. FFN

ffn_output = self.fc2(self.act(self.fc1(x_seq)))

x_seq = self.norm2(x_seq + ffn_output) # 残差连接 + LayerNorm

# 4. 恢复形状: [H*W, B, C] -> [B, C, H, W]

x_out = x_seq.permute(1, 2, 0).view(B, C, H, W)

return x_out

# === 3. 我们的主角:LargeObjectHead ===

class LargeObjectHead(nn.Module):

"""

YOLOv8专为大目标优化的检测头 (第118篇)

特性:

- 继承YOLOv8标准Detect头的解耦结构

- 对P5(最大)特征图应用ASPP模块

- 对P5(最大)特征图应用TransformerLayer

"""

# YOLOv8 Detect 头的标准参数

dynamic = False # 动态输入大小 (我们这里先假设为False)

export = False # 导出模式

shape = None

anchors = torch.empty(0)

strides = torch.empty(0)

def __init__(self, nc=80, ch=()): # nc: 类别数, ch: P3,P4,P5的输入通道列表

super().__init__()

self.nc = nc # 类别数

self.nl = len(ch) # 检测层数 (例如 3)

self.no = nc + 64 # 每个anchor的输出数 = (类别 + 4*16(DFL) + 4(bbox)) - (这个是YOLOv8 v8.0的计算方式,但v8.1改了)

self.no = nc + (16 * 4) # YOLOv8 8.0 DFL(16) * 4 + 类别

self.reg_max = 16 # DFL的回归范围

self.stride = torch.zeros(self.nl) # 步长

self.stem = nn.ModuleList() # 基础 stem 卷积

self.cls_convs = nn.ModuleList() # 分类分支的卷积

self.reg_convs = nn.ModuleList() # 回归分支的卷积

self.cls_preds = nn.ModuleList() # 分类预测头

self.reg_preds = nn.ModuleList() # 回归预测头

# DFL (Distribution Focal Loss) 模块

self.dfl = DFL(self.reg_max) if self.reg_max > 1 else nn.Identity()

# 根据输入的通道列表 ch (例如 [256, 512, 1024]) 构建检测头

c_in = list(ch)

c_out = max((160, self.nc), max(c_in)) # 计算输出通道 (YOLOv8的逻辑)

# --- 我们的优化点 ---

# 1. 为P5(最后一个)特征层定义 ASPP

# 我们假设 ch[-1] 是P5的通道

self.aspp_p5 = ASPP(c_in=ch[-1], c_out=ch[-1], rates=[6, 12, 18])

# 2. 为P5(最后一个)特征层定义 Transformer

self.transformer_p5 = TransformerLayer(c=ch[-1], num_heads=8)

# --- 构建YOLOv8标准的解耦头结构 ---

for i in range(self.nl): # 遍历 P3, P4, P5

# 1. Stem (共享) 卷积

self.stem.append(Conv(c_in[i], c_out, 3, 1)) # 3x3 卷积

# 2. 分类分支 (Decoupled)

c_cls = c_out # 分类分支的通道

self.cls_convs.append(nn.Sequential(

Conv(c_out, c_cls, 3, 1),

Conv(c_cls, c_cls, 3, 1)

))

self.cls_preds.append(nn.Conv2d(c_cls, self.nc, 1, 1)) # 1x1 预测

# 3. 回归分支 (Decoupled)

c_reg = c_out # 回归分支的通道

self.reg_convs.append(nn.Sequential(

Conv(c_out, c_reg, 3, 1),

Conv(c_reg, c_reg, 3, 1)

))

self.reg_preds.append(nn.Conv2d(c_reg, 4 * self.reg_max, 1, 1)) # 1x1 预测 (DFL)

# 确保在非训练模式下自动调用 'forward_export' 或 'forward_fuse'

self.detect = nn.ModuleList([self.cls_preds, self.reg_preds])

if self.export:

self.forward = self.forward_export

self.fuse()

def forward(self, x):

"""

前向传播

x (list): FPN/PANet输出的特征图列表 [P3, P4, P5]

"""

shape = x[0].shape # 用于推理

outputs = []

for i in range(self.nl): # 遍历 P3, P4, P5

# --- 这是我们的优化 ---

feature = x[i]

if i == self.nl - 1: # 如果是最后一个特征图 (P5)

# 1. 应用 ASPP

feature = self.aspp_p5(feature)

# 2. 应用 Transformer (在ASPP之后)

feature = self.transformer_p5(feature)

# --------------------

# 1. Stem 卷积

stem_out = self.stem[i](feature)

# 2. 分类分支

cls_feat = self.cls_convs[i](stem_out)

cls_pred = self.cls_preds[i](cls_feat)

# 3. 回归分支

reg_feat = self.reg_convs[i](stem_out)

reg_pred = self.reg_preds[i](reg_feat)

# 组合输出

# 在训练时,我们返回原始的 [cls_pred, reg_pred]

if not self.training:

# 在推理时,进行后处理 (YOLOv8的标准逻辑)

if self.shape != shape:

self.anchors, self.strides = (x.transpose(0, 1) for x in make_anchors(x, self.stride, 0.5))

self.shape = shape

# [B, C, H, W] -> [B, C, H*W] -> [B, H*W, C]

box_dist_flat = reg_pred.permute(0, 2, 3, 1).flatten(1, 2) # [B, H*W, 4*reg_max]

cls_pred_flat = cls_pred.permute(0, 2, 3, 1).flatten(1, 2).sigmoid() # [B, H*W, nc]

# DFL解码: [B, H*W, 4*reg_max] -> [B, H*W, 4]

box_pred = self.dfl(box_dist_flat)

# dist2bbox: 将 (l, t, r, b) 转换为 (x1, y1, x2, y2)

# (需要 anchors 和 strides)

box_pred = dist2bbox(box_pred, self.anchors[i], self.strides[i])

# 拼接 [box, cls]

output = torch.cat([box_pred, cls_pred_flat], dim=-1)

outputs.append(output)

else:

# 训练时,返回 [reg_pred, cls_pred] 的原始输出

outputs.append(torch.cat([reg_pred, cls_pred], dim=1))

if self.training:

# 训练时返回 [B, C, H, W] 的列表

return outputs

else:

# 推理时返回 [B, N, 4+NC] 的拼接张量

return torch.cat(outputs, dim=1)

def bias_init(self):

"""

初始化偏置 (YOLOv8的标准操作)

"""

# ... (省略标准偏置初始化代码, 以便聚焦核心逻辑)

pass

def fuse(self):

"""

融合 Conv + BN (YOLOv8的标准操作)

"""

# ... (省略标准融合代码)

pass

def forward_export(self, x):

"""

用于 ONNX 导出的前向传播

"""

# ... (省略标准导出代码)

pass

文件 2: custom_yolov8_large.yaml

(你需要创建一个新的 .yaml 文件来定义你的模型结构)

# YOLOv8 大目标检测优化模型 (第118篇)

#

# 1. 确保 `custom_head.py` 在你的Python路径下

# 2. 或者, 将 'LargeObjectHead' 的导入路径改为绝对路径

# 例如: 'ultralytics.nn.custom_head.LargeObjectHead'

# Parameters

nc: 80 # 类别数 (例如 COCO)

scales: # model complex scales

# [depth, width, max_channels]

n: [0.33, 0.25, 1024]

s: [0.33, 0.50, 1024]

m: [0.67, 0.75, 768]

l: [1.00, 1.00, 512]

x: [1.00, 1.25, 512]

# YOLOv8.0-n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 3, C2f, [128, True]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 6, C2f, [256, True]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 6, C2f, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 3, C2f, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9 (标准 SPPF 仍然保留在Backbone的末端)

# YOLOv8.0-n head (PANet)

head:

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 3, C2f, [512]] # 12

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 3, C2f, [256]] # 15 (P3/8)

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 12], 1, Concat, [1]] # cat head P4

- [-1, 3, C2f, [512]] # 18 (P4/16)

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 9], 1, Concat, [1]] # cat backbone P5

- [-1, 3, C2f, [1024]] # 21 (P5/32)

# 关键修改:

# 将标准 'Detect' 模块替换为我们的 'LargeObjectHead'

- [[15, 18, 21], 1, LargeObjectHead, [nc, [256, 512, 1024]]] # Detect

# 注意:

# 1. 这里的 'LargeObjectHead' 必须能被YOLOv8的解析器找到。

# 你需要修改YOLOv8的源码,在 `ultralytics/nn/tasks.py` 中注册你的模块:

# from . import custom_head ...

# elif m is custom_head.LargeObjectHead:

# args.insert(2,_b)

#

# 2. 更简单的方法是:在你的训练脚本中,先加载一个标准模型,

# 然后手动替换 'model.model[-1]' (即Detect层) 为你的自定义Head实例。

# (我们将在 train.py 中演示这种更简单、无侵入的方法)

文件 3: train.py(推荐的、无侵入的加载方式)

# -*- coding: utf-8 -*-

"""

《YOLOv8专栏》第118篇:大目标检测头部优化

训练脚本 (推荐的无侵入方式)

此脚本演示如何加载一个标准的YOLOv8模型,

然后将其检测头替换为我们的 `LargeObjectHead`。

"""

from ultralytics import YOLO

# 导入我们自定义的 Head

from custom_head import LargeObjectHead

def train_with_large_object_head():

print("🚀 开始加载标准 YOLOv8s 模型...")

# 1. 加载一个预训练的标准模型 (例如 yolov8s.pt)

# 我们加载 '.pt' 是为了利用预训练权重

# 如果你想从头训练,可以加载 'yolov8s.yaml'

model = YOLO('yolov8s.pt')

print("模型结构 (替换前):")

# print(model.model) # 你可以取消注释来看一下

# 2. 获取原始检测头 (Detect 模块)

# 在YOLOv8中, Detect 头通常是模型的最后一个模块 (model.model[-1])

original_head = model.model[-1]

# 3. 获取替换所需的参数

nc = original_head.nc # 类别数 (从原模型继承)

ch = [256, 512, 1024] # 这是 yolov8s 的 P3,P4,P5 通道数

# 你需要根据你加载的模型 (n,s,m,l,x) 调整

# yolov8n: [128, 256, 512]

# yolov8s: [128, 256, 512] (v8.0) -> [256, 512, 1024] (v8.1)

# 请根据你的模型版本确认 ch

# 这里我们假设 ch = [256, 512, 1024]

# 检查一下通道数是否匹配 (非常重要!)

try:

# v8.1 (ultralytics 8.1.0+) 已经将 ch 存储在 head 中了

if hasattr(original_head, 'ch'):

ch = original_head.ch

print(f"自动获取通道数: {ch}")

else:

# 手动指定 (以 yolov8s v8.1.x 为例)

ch = [256, 512, 1024]

print(f"警告: 无法自动获取通道, 使用手动设置: {ch}")

except Exception as e:

print(f"获取通道失败: {e}. 将使用默认 [256, 512, 1024]")

ch = [256, 512, 1024]

print(f"准备替换检测头... NC={nc}, CH={ch}")

# 4. 创建我们的 LargeObjectHead 实例

custom_head_instance = LargeObjectHead(nc=nc, ch=ch)

# 5. 替换!

model.model[-1] = custom_head_instance

# (可选) 继承原Head的 strides 和 anchors

# (如果你的 custom_head_instance 中没有自动计算)

custom_head_instance.stride = original_head.stride

# custom_head_instance.anchors = original_head.anchors (如果需要)

print("🎉 检测头替换成功!新的模型结构 (尾部):")

# 打印模型最后几个模块,确认 LargeObjectHead 已经换上

print(model.model[-3:])

print("开始使用自定义头进行训练...")

# 6. 正常训练

# 我们使用 coco128 作为示例

# 建议使用包含大量大目标的数据集 (如 BDD100K, COCO)

model.train(

data='coco128.yaml', # 使用你自己的数据集

epochs=50,

imgsz=640,

batch=16,

name='yolov8s_LargeObjectHead_test' # 自定义实验名称

)

print("训练完成!模型已保存。")

if __name__ == "__main__":

# 确保 custom_head.py 和 train.py 在同一目录

# 或者 custom_head.py 在你的 PYTHONPATH 中

train_with_large_object_head()

7. 代码逐行解析

这段代码虽然长,但逻辑非常清晰。我们来“解剖”一下 custom_head.py:

-

导入 (Imports):我们导入了

torch和ultralytics的Conv,DFL等基础模块。这是我们构建新 Head 的“积木”。 -

ASPP 模块:

-

__init__:我们定义了 1 个 1 × 1 1 \times 1 1×1 卷积(conv1x1),3 个不同rates(膨胀率)的 3 × 3 3 \times 3 3×3 空洞卷积(atrous_convs),和 1 个图像池化分支(image_pool)。最后定义一个 1 × 1 1 \times 1 1×1 卷积(final_conv)用来融合所有分支。 -

forward:x1 = self.conv1x1(x):标准 1 × 1 1 \times 1 1×1 卷积分支。xs.append(conv(x)):循环计算不同膨胀率的空洞卷积分支。x_img_pool = self.image_pool(x):计算全局平均池化,然后F.interpolate上采样回原特征图大小。这提供了全局上下文。torch.cat(xs, dim=1):在通道维度上拼接所有分支( 1 × 1 1 \times 1 1×1 + 3 × 3 3 \times 3 3×3 (rate 6) + 3 × 3 3 \times 3 3×3 (rate 12) + 3 × 3 3 \times 3 3×3 (rate 18) + ImgPool)。self.final_conv(x_cat):用 1 × 1 1 \times 1 1×1 卷积融合,并将通道数降回c_out。

-

-

TransformerLayer 模块:

-

__init__:定义了 Q, K, V 的线性层、MultiheadAttention模块、FFN(fc1,fc2)以及LayerNorm。 -

forward:x.flatten(2).permute(2, 0, 1):将 B × C × H × W B \times C \times H \times W B×C×H×W 的图像特征图转换为 L × B × C L \times B \times C L×B×C 的序列( L = H × W L = H \times W L=H×W)。self.ma(q, k, v):执行多头自注意力。self.norm1(x_seq + attn_output):第一个残差连接和 LayerNorm。self.norm2(x_seq + ffn_output):第二个残差连接和 LayerNorm(FFN)。permute(...).view(...):将序列恢复为 B × C × H × W B \times C \times H \times W B×C×H×W 的图像特征图形状。

-

-

LargeObjectHead 模块:

-

__init__:- 它基本复制了 YOLOv8

Detect头的初始化逻辑(nc,nl,no,reg_max,dfl等)。 - 核心:我们实例化了

self.aspp_p5 = ASPP(...)和self.transformer_p5 = TransformerLayer(...)。我们明确指定它们只用于处理ch[-1](即 P5 的通道)。 - 然后,它像标准

Detect头一样,循环创建stem,cls_convs,reg_convs,cls_preds,reg_preds。

- 它基本复制了 YOLOv8

-

forward:for i in range(self.nl):遍历 P3, P4, P5 的特征图。- 核心:

if i == self.nl - 1:。这个判断是关键。它检查当前是否在处理“最后”一个特征图(即 P5)。 feature = self.aspp_p5(feature):如果是 P5,先通过 ASPP。feature = self.transformer_p5(feature):再通过 Transformer。- (P3 和 P4 则跳过这个分支,走标准流程)。

- 后续的

stem_out,cls_feat,reg_feat,都和标准Detect头一样。 - 最后,它同样区分了

self.training模式(返回原始输出用于计算 Loss)和非训练模式(返回解码后的 Box 和 Cls 用于 NMS)。

-

-

train.py(无侵入替换):- 这利用了 PyTorch 模型的“可塑性”。

model = YOLO('yolov8s.pt'):加载一个完整的、预训练的模型。model.model[-1] = custom_head_instance:这一行是关键。我们直接用新创建的LargeObjectHead实例,替换掉了model.model列表中的最后一个元素(即原来的Detect头)。- PyTorch 的计算图会在下一次

forward时自动使用这个新模块。 - 这种方法不需要修改任何 YOLOv8 的源代码,非常干净。

7. 总结与展望

今天的内容是“重量级”的!😅 我们深入探讨了“大目标检测”这个看似简单、实则充满挑战的课题。

我们发现,大目标的核心痛点在于边界精度、遮挡处理和上下文建模。

为了解决这些问题,我们从 YOLOv8 的检测头出发,提出了四大优化策略:

- 大感受野设计:我们引入了 ASPP(空洞空间金字塔池化),它能在不损失分辨率的情况下,高效获取多尺度的感受野,比 SPPF 更精细。

- 多尺度采样与全局上下文:我们讨论了引入 P6 层来处理“超大目标”的可能性,并使用 Transformer Encoder 来为 P5 特征图注入“全局上下文”,这对于推理被遮挡的物体至关重要。

- 边界回归精度:我们再次强调了解耦头的重要性,并提出了引入辅助边界损失(Boundary Loss)来专门“打磨”大目标的边缘。

- 遮挡能力:我们结合注意力机制(如空间注意)和数据增强(如 Random Erasing)来提升模型在信息不全时的鲁棒性。

最后,我们通过实战代码,亲手打造了一个 LargeObjectHead,它巧妙地将 ASPP 和 Transformer 融合到了 YOLOv8 的解耦头架构中,并演示了如何“无侵入”地替换 YOLOv8 的默认头来开始训练。

请记住,没有“银弹”(silver bullets)。🚀 引入 ASPP 和 Transformer 会增加模型的计算负担(GFLOPs)并降低推理速度(FPS)。这始终是一个关于精度和速度的权衡。

但现在,当你的任务中(比如工业质检、自动驾驶、卫星图像分析)充满了大目标和遮挡物时,你已经拥有了武装 YOLOv8 的“重型武器”!

你学“废”了吗?赶紧动手试试吧!

📚 下期预告:

我们目前的检测头,目标很“纯粹”——就是画框(Regression)和分类(Classification)。

但是,如果我们想让模型在画框的同时,还能做点“别的”呢?

- 比如,在检测到“人”的同时,输出这个“人”的骨骼关键点(Keypoint Detection)?

- 比如,在检测到“车”的同时,输出这辆“车”的分割掩码(Instance Segmentation)?

- 比如,在检测“人脸”的同时,预测“年龄”和“性别”?

这就是多任务学习(Multi-Task Learning)在检测领域的应用。

第9节:多任务检测头联合设计,我们将探索:

- 如何设计一个检测头,让它能同时“身兼数职”?

- 任务共享机制:哪些特征可以共享?哪些分支必须“专用”?

- 损失权重平衡:检测 Loss、分割 Loss、关键点 Loss… 谁主谁次?如何平衡它们?

- 梯度冲突处理:当“检测”任务想让特征往东,而“分割”任务想让特征往西时,怎么办?

这将是 YOLOv8(如 YOLOv8-Seg/Pose)强大功能的核心解密!

小伙伴们,保持你的好奇心和学习热情,我们下期再见!👋 别忘了给你自己点个赞!👍

希望本文围绕 YOLOv8 的实战讲解,能在以下几个方面对你有所帮助:

- 🎯 模型精度提升:通过结构改进、损失函数优化、数据增强策略等,实战提升检测效果;

- 🚀 推理速度优化:结合量化、裁剪、蒸馏、部署策略等手段,帮助你在实际业务中跑得更快;

- 🧩 工程级落地实践:从训练到部署的完整链路中,提供可直接复用或稍作改动即可迁移的方案。

PS:如果你按文中步骤对 YOLOv8 进行优化后,仍然遇到问题,请不必焦虑或抱怨。

YOLOv8 作为复杂的目标检测框架,效果会受到 硬件环境、数据集质量、任务定义、训练配置、部署平台 等多重因素影响。

如果你在实践过程中遇到:

- 新的报错 / Bug

- 精度难以提升

- 推理速度不达预期

欢迎把 报错信息 + 关键配置截图 / 代码片段 粘贴到评论区,我们可以一起分析原因、讨论可行的优化方向。

同时,如果你有更优的调参经验或结构改进思路,也非常欢迎分享出来,大家互相启发,共同完善 YOLOv8 的实战打法 🙌

🧧🧧 文末福利,等你来拿!🧧🧧

文中涉及的多数技术问题,来源于我在 YOLOv8 项目中的一线实践,部分案例也来自网络与读者反馈;如有版权相关问题,欢迎第一时间联系,我会尽快处理(修改或下线)。

部分思路与排查路径参考了全网技术社区与人工智能问答平台,在此也一并致谢。如果这些内容尚未完全解决你的问题,还请多一点理解——YOLOv8 的优化本身就是一个高度依赖场景与数据的工程问题,不存在“一招通杀”的方案。

如果你已经在自己的任务中摸索出更高效、更稳定的优化路径,非常鼓励你:

- 在评论区简要分享你的关键思路;

- 或者整理成教程 / 系列文章。

你的经验,可能正好就是其他开发者卡关许久所缺的那一环 💡

OK,本期关于 YOLOv8 优化与实战应用 的内容就先聊到这里。如果你还想进一步深入:

- 了解更多结构改进与训练技巧;

- 对比不同场景下的部署与加速策略;

- 系统构建一套属于自己的 YOLOv8 调优方法论;

欢迎继续查看专栏:《YOLOv8实战:从入门到深度优化》。

也期待这些内容,能在你的项目中真正落地见效,帮你少踩坑、多提效,下期再见 👋

码字不易,如果这篇文章对你有所启发或帮助,欢迎给我来个 一键三连(关注 + 点赞 + 收藏),这是我持续输出高质量内容的核心动力 💪

同时也推荐关注我的公众号 「猿圈奇妙屋」:

- 第一时间获取 YOLOv8 / 目标检测 / 多任务学习 等方向的进阶内容;

- 不定期分享与视觉算法、深度学习相关的最新优化方案与工程实战经验;

- 以及 BAT 等大厂面试题、技术书籍 PDF、工程模板与工具清单等实用资源。

期待在更多维度上和你一起进步,共同提升算法与工程能力 🔧🧠

🫵 Who am I?

我是专注于 计算机视觉 / 图像识别 / 深度学习工程落地 的讲师 & 技术博主,笔名 bug菌:

- 活跃于 CSDN | 掘金 | InfoQ | 51CTO | 华为云 | 阿里云 | 腾讯云 等技术社区;

- CSDN 博客之星 Top30、华为云多年度十佳博主、掘金多年度人气作者 Top40;

- 掘金、InfoQ、51CTO 等平台签约及优质创作者,51CTO 年度博主 Top12;

- 全网粉丝累计 30w+。

更多系统化的学习路径与实战资料可以从这里进入 👉 点击获取更多精彩内容

硬核技术公众号 「猿圈奇妙屋」 欢迎你的加入,BAT 面经、4000G+ PDF 电子书、简历模版等通通可白嫖,你要做的只是——愿意来拿 😉

-End-

更多推荐

已为社区贡献75条内容

已为社区贡献75条内容

所有评论(0)