【万字长文】2025年大模型落地指南:向量数据库选型全攻略,解决幻觉与算力难题!

AI大模型已从概念验证进入实用落地阶段,面临幻觉、算力成本和企业数据利用等挑战。解决这些问题的关键在于高效管理和检索企业知识,使向量数据库成为AI时代的关键基础设施。本文全面介绍开源与托管向量数据库的特点、性能及适用场景,并提供基于数据规模、运维能力和技术栈的选型建议,助力开发者构建高质量AI应用。

AI大模型正在以极快的速度颠覆我们的业务和产品,市场的焦点正在从狂热到理性,从酷炫转向实用。大家已不再满足于演示和概念验证,而是直面真正的落地挑战。如何解决大模型的幻觉问题,让它生成真实可信的结果?如何控制高昂的算力成本?如何让企业独有的数据资产真正被AI理解和运用,这些才是当前AI进入深水区后最真实、最迫切的问题。而所有这些问题的答案都指向一个共同的核心,如何高效、精准的管理和检索企业的知识,这也让向量数据库从一项可选技术,变成了AI时代不可或缺的关键基础设施。

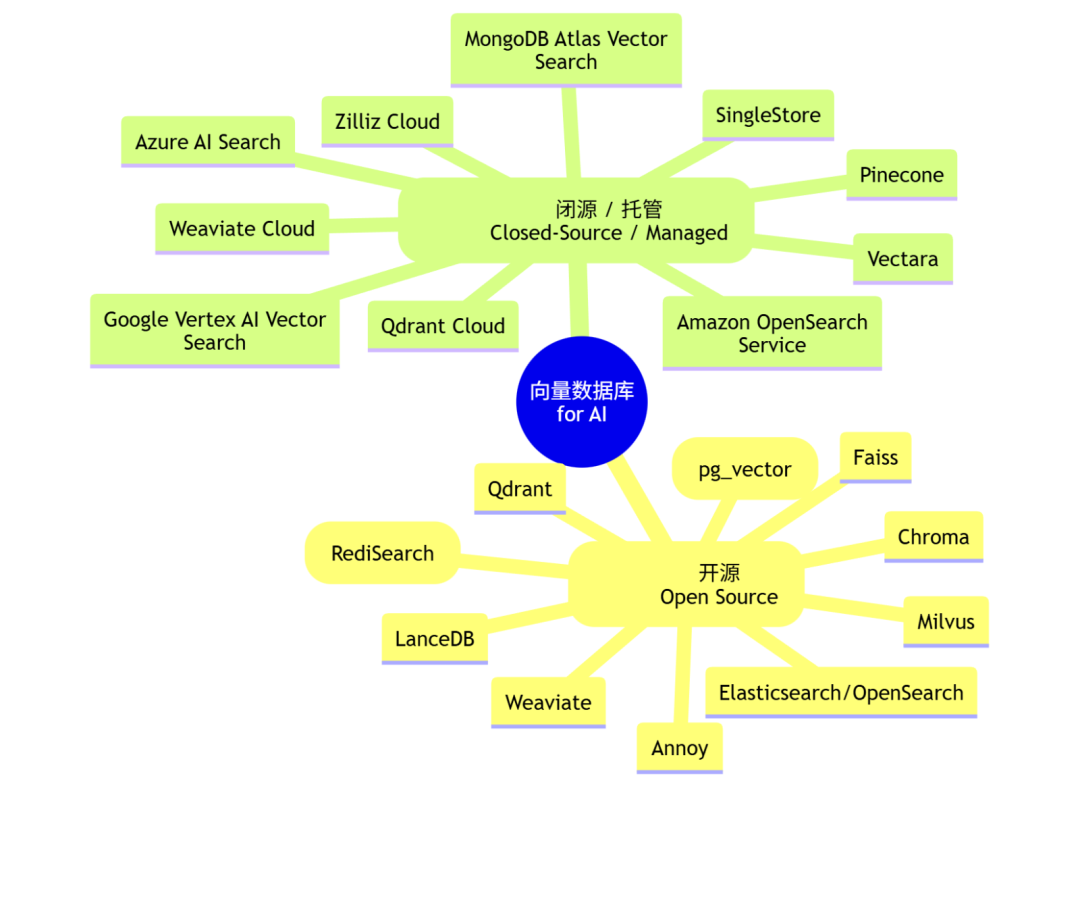

向量数据库从整体上分为开源 (Open Source)** 和 闭源/托管/商业 (Closed-Source / Managed) 两大阵营,下面进行详细介绍。**

导读:

一、向量数据库整体概览

二、开源向量数据库

三、闭源/托管向量数据库

四、国内商用向量数据库

五、如何选择向量数据库

一、向量数据库整体概览 (导图)

mindmap root((向量数据库 for AI)) (开源 Open Source) ::icon(fa fa-cogs) Milvus Qdrant Weaviate Chroma PostgreSQL (pg_vector) Elasticsearch / OpenSearch Redis (RediSearch) LanceDB Faiss Annoy (闭源 / 托管 Closed-Source / Managed) ::icon(fa fa-cloud) Pinecone Zilliz Cloud Qdrant Cloud Weaviate Cloud Google Vertex AI Vector Search Amazon OpenSearch Service Azure AI Search MongoDB Atlas Vector Search Vectara SingleStore

二、开源向量数据库(Open Source)

开源方案提供了极高的灵活性、可定制性和成本控制,但通常需要团队投入更多的运维精力。

1. Milvus

- 技术栈偏好和主要依赖关系: 主要使用 Go 和 C++ 开发。分布式架构依赖 etcd 进行元数据管理,依赖 MinIO/S3/Azure Blob 等对象存储服务进行数据持久化。

- 访问网址/安装命令:

- 网址: https://milvus.io/

- 安装:

docker run -d --name milvus_standalone milvusdb/milvus:v2.4.1(以 Docker Standalone 模式为例)

- 特点:

- 云原生分布式架构: 为大规模、高可用场景设计,支持水平扩展。

- 丰富的索引类型: 支持多种 ANN 索引(如 HNSW, IVF_FLAT, SCANN),可根据场景平衡召回率和性能。

- 标量字段过滤与混合搜索: 支持在向量搜索前/中进行元数据过滤,也支持与传统关键词搜索结合。

- 数据分区与TTL: 支持数据分区管理和自动过期,便于数据生命周期管理。

- 性能: 专为海量数据设计,可以轻松扩展至十亿甚至百亿级向量。通过横向扩展,并发量(QPS)可以达到数万级别。

- 应用场景: 大型企业级语义搜索系统、推荐引擎、AI Agent 的长期记忆存储、需要高可用和水平扩展的复杂AI应用。

2. Qdrant

- 技术栈偏好和主要依赖关系: 使用 Rust 语言开发,保证了内存安全和高性能。使用 RocksDB 作为存储后端。

- 访问网址/安装命令:

- 网址: https://qdrant.tech/

- 安装:

docker run -p 6333:6333 qdrant/qdrant

- 特点:

- 性能卓越: Rust 带来的性能优势,尤其在过滤搜索方面表现出色。

- 高级过滤能力: 可以在搜索时附加丰富的过滤条件,且过滤性能高。

- 在线学习与量化: 支持标量量化和产品量化,可在不显著牺牲精度的情况下大幅减少内存占用。

- 分片与副本: 支持手动或自动分片,确保数据扩展性和可用性。

- 性能: 适合千万到数亿级向量规模。得益于 Rust 和高效的过滤机制,单机并发性能非常高,可应对数千 QPS 的查询。

- 应用场景: 需要复杂元数据过滤的RAG(检索增强生成)应用、实时推荐系统、需要低延迟响应的AI Agent、API服务后端。

3. Weaviate

- 技术栈偏好和主要依赖关系: 使用 Go 语言开发。其独特的模块化系统可以集成多种第三方服务(如 OpenAI, Cohere)用于向量化。

- 访问网址/安装命令:

- 网址: https://weaviate.io/

- 安装: (通常使用 Docker Compose)

curl -o docker-compose.yml "https://configuration.weaviate.io/v2/docker-compose.yaml?modules=...&runtime=docker-compose&weaviate_version=v1.24.1"

- 特点:

- GraphQL API: 提供强大且灵活的 GraphQL API,便于进行复杂的数据关联查询。

- 模块化生态系统: 内置了对多种 embedding 模型的支持,可以在数据导入时自动进行向量化,简化了AI工作流。

- 混合搜索: 开箱即用地支持基于 BM25 的关键词搜索和向量搜索的混合。

- 数据对象链接: 允许在数据对象之间建立图关系,实现更复杂的知识图谱式查询。

- 性能: 适合处理千万到数亿级向量。并发量支持中到高,可满足数百到上千 QPS 的需求。

- 应用场景: 知识图谱与语义搜索结合的应用、需要自动向量化的AI工作流、为开发者提供灵活查询能力的API平台。

4. Chroma (ChromaDB)

- 技术栈偏好和主要依赖关系: 主要使用 Python 开发,定位为“AI 原生的开源嵌入式数据库”。底层使用 DuckDB 和 HNSWlib。

- 访问网址/安装命令:

- 网址: https://www.trychroma.com/

- 安装:

pip install chromadb

- 特点:

- Python 优先: API 设计非常贴合 Python 开发者的习惯,与 LangChain、LlamaIndex 等框架无缝集成。

- “Batteries-included”: 内置了 embedding 计算功能,简化了开发流程。

- 内存与磁盘模式: 支持纯内存模式用于快速原型开发,也支持持久化到磁盘。

- 客户端/服务器模式: 支持作为本地库使用,也支持部署为独立的服务器。

- 性能: 主要面向百万到千万级向量规模。性能瓶颈在于其 Python 实现和单机架构,适合中低并发(数十到上百 QPS)场景。

- 应用场景: 快速原型开发、个人项目、中小型 RAG 应用、教学和实验、AI Agent 的本地短期记忆。

5. PostgreSQL (with pg_vector extension)

- 技术栈偏好和主要依赖关系: 依赖于成熟的 PostgreSQL 数据库生态。

pg_vector扩展本身用 C 语言编写。 - 访问网址/安装命令:

- 网址: https://github.com/pgvector/pgvector

- 安装:

CREATE EXTENSION vector;(在已安装 PostgreSQL 的数据库中执行)

- 特点:

- 与现有数据统一: 最大的优势在于可以将向量数据与结构化数据存储在同一个数据库、同一张表中,简化技术栈。

- 事务一致性: 享受 PostgreSQL 带来的 ACID 事务保证。

- 成熟生态: 可以利用 PostgreSQL 强大的备份、恢复、权限管理、复制等全套功能。

- 支持 HNSW 索引: 近期版本已支持 HNSW 索引,大幅提升了查询性能。

- 性能: 适合百万到千万级向量。性能受限于 PostgreSQL 本身的架构,通常用于中低并发场景。对于需要事务一致性的场景是最佳选择。

- 应用场景: 需要将向量搜索与现有业务数据(如用户信息、商品详情)紧密结合的系统、希望简化技术栈的中小型应用、金融或电商等需要强事务性的AI功能。

6. Elasticsearch / OpenSearch

- 技术栈偏好和主要依赖关系: Java。它们是成熟的分布式搜索引擎,向量搜索是其 k-NN (k-Nearest Neighbor) 插件提供的功能。

- 访问网址/安装命令:

- 网址: https://www.elastic.co/ 或 https://opensearch.org/

- 安装: 提供 Docker 镜像和多种平台的安装包。

- 特点:

- 强大的混合搜索: 核心优势是其顶级的全文检索能力与向量搜索的无缝结合。

- 分布式与可扩展性: 天然的分布式架构,易于扩展。

- 丰富的聚合与分析: 可以对搜索结果进行复杂的聚合分析。

- 成熟的运维工具: 拥有 Kibana/OpenSearch Dashboards 等完善的可视化和管理工具。

- 性能: 可扩展至数十亿级文档(每个文档可包含向量)。高并发能力强,可支持数千 QPS。向量搜索性能略逊于专用向量数据库,但混合搜索能力是其长板。

- 应用场景: 企业级搜索、日志分析与异常检测、需要将传统关键词搜索与语义搜索深度融合的复杂查询系统。

7. Redis (with RediSearch module)

- 技术栈偏好和主要依赖关系: C 语言。依赖于 Redis 内存数据库,向量搜索是 RediSearch 模块的功能。

- 访问网址/安装命令:

- 网址: https://redis.io/docs/stack/search/

- 安装:

docker run -d -p 6379:6379 redis/redis-stack-server:latest

- 特点:

- 极低延迟: 基于内存存储,查询延迟可以做到亚毫秒级,是所有方案中最低的之一。

- 多功能数据模型: 除了向量,还可以存储哈希、集合等多种数据结构,并进行联合查询。

- 实时索引: 数据写入后几乎可以立即被索引和查询。

- 性能: 数据量受限于内存大小,通常用于百万到千万级向量。并发性能极高,轻松应对数万 QPS 的高频读写。

- 应用场景: 实时个性化推荐、欺诈检测、需要极致低延迟的AI Agent 决策系统、会话缓存与语义匹配。

8. LanceDB

- 技术栈偏好和主要依赖关系: Rust 核心,提供 Python 和 JavaScript/TypeScript API。基于 Apache Arrow 和 Parquet 列式存储格式。

- 访问网址/安装命令:

- 网址: https://lancedb.github.io/lancedb/

- 安装:

pip install lancedb

- 特点:

- “Serverless” 本地数据库: 无需启动独立服务进程,直接在代码中作为库使用,数据持久化到本地或云存储(如 S3)。

- 零拷贝与版本控制: 基于 Arrow 格式,读取数据时无需反序列化,性能高。支持数据版本化,便于回溯和实验(类似 git)。

- SQL 支持: 可以通过 DuckDB 对其数据进行 SQL 查询。

- 性能: 面向百万到千万级向量。由于是本地库,并发由应用层控制,适合嵌入式或单机高强度分析场景。查询性能优于纯 Python 方案。

- 应用场景: AI/ML 数据科学家进行本地实验、边缘计算设备上的AI应用、需要数据版本管理的 AI 工作流、构建可复现的机器学习模型。

如果你也想通过学大模型技术去帮助自己升职和加薪,可以扫描下方链接【保证100%免费】👇👇

9. Faiss (Facebook AI Similarity Search)

- 技术栈偏好和主要依赖关系: C++ 核心,提供 Python 封装。它是一个库,而不是一个数据库。

- 访问网址/安装命令:

- 网址: https://github.com/facebookresearch/faiss

- 安装:

pip install faiss-cpu或pip install faiss-gpu

- 特点:

- 算法全面: 提供了最全面的 ANN 算法实现,包括多种量化策略,是学术界和工业界研究的基石。

- 极致性能: 经过高度优化,尤其是在 GPU 上,可以实现极高的搜索吞吐量。

- 灵活性: 作为一个库,可以被集成到任何系统中,用户对数据存储、元数据管理有完全的控制权。

- 性能: 在 GPU 上可以处理十亿级向量。性能取决于所选算法和硬件,吞吐量可以达到极高水平。它本身不处理并发,需要上层应用来管理。

- 应用场景: 作为自研向量数据库的底层核心引擎、对性能有极致要求的离线批处理任务、学术研究和算法评估。

10. Annoy (Approximate Nearest Neighbors Oh Yeah)

- 技术栈偏好和主要依赖关系: C++ 核心,提供 Python 封装。由 Spotify 开发,也是一个库。

- 访问网址/安装命令:

- 网址: https://github.com/spotify/annoy

- 安装:

pip install annoy

- 特点:

- 简单易用: API 极其简单,学习成本低。

- 内存映射文件: 索引文件可以被内存映射,允许多个进程共享同一份索引数据,节省内存。

- 轻量级: 依赖少,易于集成到各种项目中。

- 性能: 适合百万级向量。性能表现良好,但功能相对基础。并发由应用层控制。

- 应用场景: 快速构建中小型推荐系统或相似性搜索功能、作为大型系统中的一个轻量级组件、资源受限的环境。

三、闭源/托管向量数据库 (Closed-Source / Managed)

这类服务免去了用户部署、维护、扩展数据库的烦恼,提供开箱即用的高性能服务和专业支持,但会锁定在特定供应商,并按使用量付费。

1. Pinecone

- 技术栈偏好和主要依赖关系: 闭源,作为 SaaS 服务提供。提供 Python, TypeScript/JavaScript 等多种语言的 SDK。

- 访问网址: https://www.pinecone.io/

- 特点:

- Serverless 架构: 用户无需关心底层服务器、扩展和配置,只需创建索引并推送数据即可。

- 易用性: API 设计极其简洁,上手非常快,是托管向量数据库的标杆。

- 低延迟与高吞吐: 专为高性能实时查询设计,提供稳定的低延迟保证。

- 命名空间与过滤: 支持命名空间进行多租户隔离,并支持元数据过滤。

- 性能: 可轻松扩展至数十亿级向量。根据选择的 Pod 类型,可以支持从数百到数万 QPS 的高并发查询。

- 应用场景: 各类 SaaS 应用中的语义搜索、RAG、推荐功能;需要快速上线、运维简单的 AI Agent 和 API 服务。

2. Zilliz Cloud

- 技术栈偏好和主要依赖关系: Milvus 的商业化全托管版本。

- 访问网址: https://zilliz.com/cloud

- 特点:

- 企业级 Milvus: 提供了 Milvus 开源版的所有功能,并增加了企业级特性,如更强的安全性、多云支持、图形化管理界面等。

- 多种计费模式: 提供 Serverless 模式(按量付费)和专用集群模式(资源独占)。

- 专家支持: 提供来自 Milvus 核心开发团队的商业支持。

- 性能: 与 Milvus 开源版相当或更优,可扩展至百亿级向量,并支持极高并发的查询。Serverless 版本可以自动扩缩容。

- 应用场景: 已使用或计划使用 Milvus 但希望降低运维成本的企业、对数据安全和技术支持有高要求的大型项目。

3. Qdrant Cloud

- 技术栈偏好和主要依赖关系: Qdrant 的官方全托管服务。

- 访问网址: https://qdrant.tech/cloud/

- 特点:

- 托管的 Qdrant: 享受 Qdrant 的高性能、高级过滤等所有优点,无需自行部署和维护。

- 多云部署: 支持在 AWS, GCP, Azure 等主流云平台上部署。

- 自动备份与高可用: 提供自动备份、快照和高可用集群配置。

- 性能: 性能与 Qdrant 开源版一致,可处理数亿级向量,并支持高并发查询。

- 应用场景: 业务逻辑需要复杂元数据过滤的 RAG 或搜索应用、希望使用 Rust 技术栈优势但又不想自己运维的团队。

4. Weaviate Cloud Services

- 技术栈偏好和主要依赖关系: Weaviate 的全托管版本。

- 访问网址: https://weaviate.io/cloud

- 特点:

- Serverless 与企业专用: 提供按需付费的 Serverless 模式和为大型企业准备的专用集群。

- 简化模块管理: 在云平台上可以轻松启用和配置各种向量化模块和插件。

- 企业级安全: 提供私有网络链接(Private Link)、SOC 2 Type 2 合规等安全特性。

- 性能: 性能与 Weaviate 开源版一致,适合数亿级向量和中高并发场景。

- 应用场景: 需要利用 Weaviate 模块化生态系统(如自动向量化)来简化 AI 工作流的开发者、构建知识图谱类应用的团队。

5. Google Vertex AI Vector Search

- 技术栈偏好和主要依赖关系: Google Cloud Platform 的一部分,深度集成 Google Cloud 生态。

- 访问网址: https://cloud.google.com/vertex-ai/docs/vector-search

- 特点:

- 海量规模: 基于 Google 内部用于支持搜索、YouTube 等产品的核心技术,专为超大规模设计。

- 全自动扩缩容: 完全托管,根据流量自动扩展,无需手动干预。

- 集成 Google 生态: 与 BigQuery, GCS, Vertex AI Pipelines 等无缝集成。

- 支持流式更新: 支持近实时地更新索引。

- 性能: 可扩展至百亿甚至千亿级向量。能够承受极高的并发查询压力。

- 应用场景: 拥有海量数据、需要在 Google Cloud 生态内构建超大规模推荐、搜索系统的企业。

6. Amazon OpenSearch Service

- 技术栈偏好和主要依赖关系: AWS 托管的 OpenSearch 服务。

- 访问网址: https://aws.amazon.com/opensearch-service/

- 特点:

- 深度集成 AWS: 与 S3, Kinesis, Lambda, SageMaker 等 AWS 服务紧密集成。

- Serverless 选项: 提供 Serverless 模式,可根据工作负载自动预置和扩展资源。

- 混合搜索能力: 继承了 OpenSearch 强大的全文检索和聚合分析能力。

- 性能: 可扩展至数十亿级文档/向量,支持高并发。性能与自建 OpenSearch 集群相当,但免去运维烦恼。

- 应用场景: AWS 技术栈的重度用户、需要将向量搜索与日志分析、业务监控等功能结合的场景。

7. Azure AI Search

- 技术栈偏好和主要依赖关系: Microsoft Azure 的一部分,原名 Azure Cognitive Search。

- 访问网址: https://azure.microsoft.com/en-us/products/ai-services/ai-search

- 特点:

- 一体化 AI 能力: 集成了 Azure AI 服务的多种能力,如 OCR、语言识别、实体提取,可以在索引管道中直接使用。

- 成熟的搜索服务: 作为一个成熟的搜索即服务产品,提供了语义重排(Semantic Ranker)、自动补全、同义词等高级搜索功能。

- 混合搜索: 提供强大的关键词搜索、向量搜索和语义重排的综合能力。

- 性能: 可处理亿级向量,并发能力可根据选择的服务层级进行扩展,支持中高并发。

- 应用场景: Azure 技术栈的重度用户、需要将文档(PDF, Office 文档等)处理与向量搜索结合的企业、希望利用集成 AI 技能简化数据处理流程的开发者。

8. MongoDB Atlas Vector Search

- 技术栈偏好和主要依赖关系: MongoDB Atlas 云数据库平台的一部分。

- 访问网址: https://www.mongodb.com/products/platform/atlas-vector-search

- 特点:

- 与文档模型统一: 将向量索引无缝集成到 MongoDB 的文档数据模型中,可以在同一个数据库中存储和查询所有应用数据。

- 简化的开发者体验: 对于已使用 MongoDB 的开发者,学习成本极低,可以通过 MQL (MongoDB Query Language) 进行向量查询。

- 全托管平台优势: 享受 Atlas 平台带来的自动扩展、全球集群、备份恢复等所有好处。

- 性能: 适合千万到亿级向量。性能与 MongoDB Atlas 集群的规模和配置直接相关,适合中高并发。

- 应用场景: 现有或新项目选择 MongoDB 作为主要数据库的开发者、需要灵活文档模型与向量搜索结合的应用。

9. Vectara

- 技术栈偏好和主要依赖关系: 闭源 SaaS 服务,定位为“端到端的 RAG API 平台”。

- 访问网址: https://vectara.com/

- 特点:

- Grounded Generation: 核心特色是提供“有根据的生成”,API 返回的摘要或答案会附带原始文本的引用,有效抑制幻觉。

- 托管的 RAG 流程: 不仅仅是向量数据库,它内置了高质量的 embedding 模型和摘要生成能力,用户只需上传文档,即可获得一个完整的 RAG API。

- 跨语言搜索: 支持多种语言的混合查询。

- 性能: 作为一个全托管平台,其内部可以处理亿级文档。API 响应速度快,并发能力通过其 Serverless 架构保障。

- 应用场景: 希望快速实现一个高质量、抗幻觉的 RAG 功能而不想处理底层 embedding、chunking、数据库管理的开发者和企业。

10. SingleStore

- 技术栈偏好和主要依赖关系: 一个分布式的 SQL 数据库,支持 HTAP (混合事务/分析处理),向量是其核心功能之一。

- 访问网址: https://www.singlestore.com/

- 特点:

- 实时 HTAP + 向量: 可以在同一个数据库中进行高速事务处理、实时分析和向量搜索。

- SQL 接口: 使用标准的 SQL

DOT_PRODUCT和EUCLIDEAN_DISTANCE等函数进行向量查询,对 SQL 开发者友好。 - 极速性能: 以其内存优先的架构和列式存储而闻名,无论是事务处理还是向量查询,速度都非常快。

- 性能: 可处理亿级向量,并保持极低的查询延迟。高并发处理能力强,适合实时性要求高的场景。

- 应用场景: 金融交易分析与欺诈检测、实时 BI 与个性化推荐结合、需要将操作型数据与 AI 驱动的洞察紧密结合的业务系统。

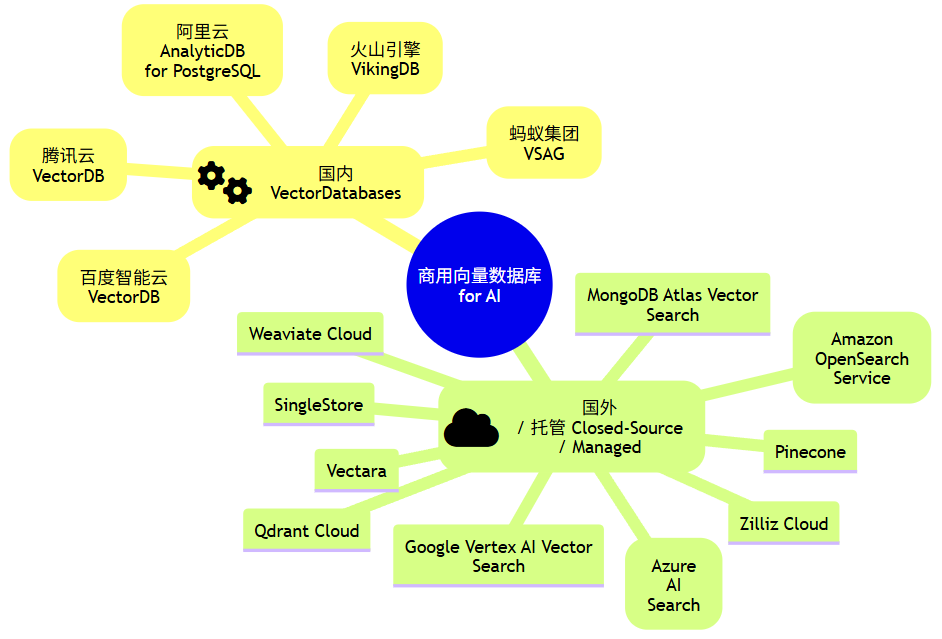

四、国内商用向量数据库

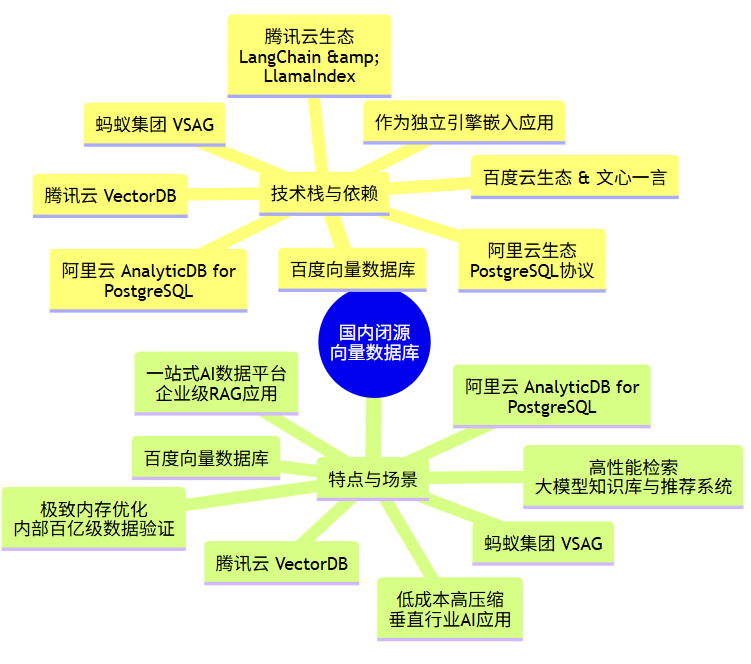

以下梳理适用于AI工作流、Agent和API开发的国内闭源(商业)向量数据库。树状图清晰地展示了向量数据库技术栈偏好和主要依赖关系、特点和性能,以快速形成一个整体印象。

mindmap root((国内闭源向量数据库)) 技术栈与依赖 阿里云 AnalyticDB for PostgreSQL :::dependence 阿里云生态<br>PostgreSQL协议 腾讯云 VectorDB :::dependence 腾讯云生态<br>LangChain & LlamaIndex 百度向量数据库 :::dependence 百度云生态 & 文心一言 蚂蚁集团 VSAG :::dependence 作为独立引擎嵌入应用 特点与场景 阿里云 AnalyticDB for PostgreSQL :::feature 一站式AI数据平台<br>企业级RAG应用 腾讯云 VectorDB :::feature 高性能检索<br>大模型知识库与推荐系统 百度向量数据库 :::feature 低成本高压缩<br>垂直行业AI应用 蚂蚁集团 VSAG :::feature 极致内存优化<br>内部百亿级数据验证

下面我们来详细看看它们各自的技术特点、性能和应用场景。

阿里云 AnalyticDB for PostgreSQL

- 技术栈偏好与依赖:深度集成于阿里云生态,使用标准的PostgreSQL协议,便于已有PostgreSQL用户迁移和使用。其RAG服务能够与阿里云百炼(大模型服务平台)快速对接。

- 访问方式:你需要先在阿里云官网创建并配置 AnalyticDB for PostgreSQL 实例。

- 特点:它并非一个单纯的向量数据库,而是一个支持向量检索的分析型数据库,实现了 “向量+全文+结构化” 的混合查询能力。提供了开箱即用的RAG服务功能,可以快速构建知识库问答应用。

- 性能与应用场景:适合构建企业级的高精度RAG应用,例如智能客服、企业知识库等,能够处理百万到亿级的数据量,并受益于其分布式架构支持较高的并发查询。

腾讯云 VectorDB

- 技术栈偏好与依赖:作为腾讯云AI生态的一部分,与自家的云服务器、对象存储等产品无缝集成。提供了对主流AI开发生态(如LangChain、LlamaIndex)的良好支持。

- 访问方式:你可以在腾讯云官网上找到其产品页面并申请开通。

- 特点:提供全托管服务,免运维。支持自动化的索引构建与数据持久化,宣称能够处理千亿级向量规模。具备高稳定性,并深度适配国产信创生态。

- 性能与应用场景:面向需要处理超大规模向量数据的场景,例如构建大模型知识库、推荐系统、和面向海量用户的新媒体内容去重等。

百度向量数据库

- 技术栈偏好与依赖:天然与百度云基础设施和文心一言(ERNIE)大模型紧密结合,为百度AI生态内的应用提供优化支持。

- 访问方式:通过百度智能云平台进行访问和购买。

- 特点:在架构上注重存储成本的优化,通过高效的向量压缩算法在保证召回率的同时降低存储开销。提供行业定制化解决方案。

- 性能与应用场景:适用于对成本敏感且数据量巨大的垂直行业AI应用,如医疗影像分析、金融风控等。

蚂蚁集团 VSAG

- 技术栈偏好与依赖:这是一个向量索引库,你可以将其作为核心引擎嵌入到自己的C++或Python应用中。它独立于特定的云服务,提供了更大的灵活性。

- 访问方式:VSAG是开源项目,你可以在相关的开源代码托管平台(如GitHub)上找到其项目仓库。

- 特点:核心优势在于极致的性能优化。通过量化和基于磁盘的重排技术,在保证高召回率的前提下,能将内存消耗降至流行索引算法HNSW的十分之一。这直接带来了生产部署成本的大幅下降。

- 性能与应用场景:专为**“降本增效”** 而设计,尤其适合在资源敏感但需要处理百亿级以上数据的生产环境中构建RAG应用,例如在自有数据中心部署大规模向量检索服务。

💎 选择建议

- 追求开箱即用和快速集成:若你的团队技术栈以阿里云或腾讯云为主,希望快速搭建RAG应用,阿里云 AnalyticDB for PostgreSQL 和 腾讯云 VectorDB 是省心的选择。

- 处理超大规模数据且预算有限:如果你的应用场景涉及百亿级以上向量,并对性能和成本有极致要求,可以考虑将 蚂蚁集团 VSAG 作为底层引擎进行自主集成。

- 深耕特定垂直行业:如果您的项目在医疗、金融等领域,且已在使用百度的AI服务,百度向量数据库 可能提供更贴合的行业解决方案。

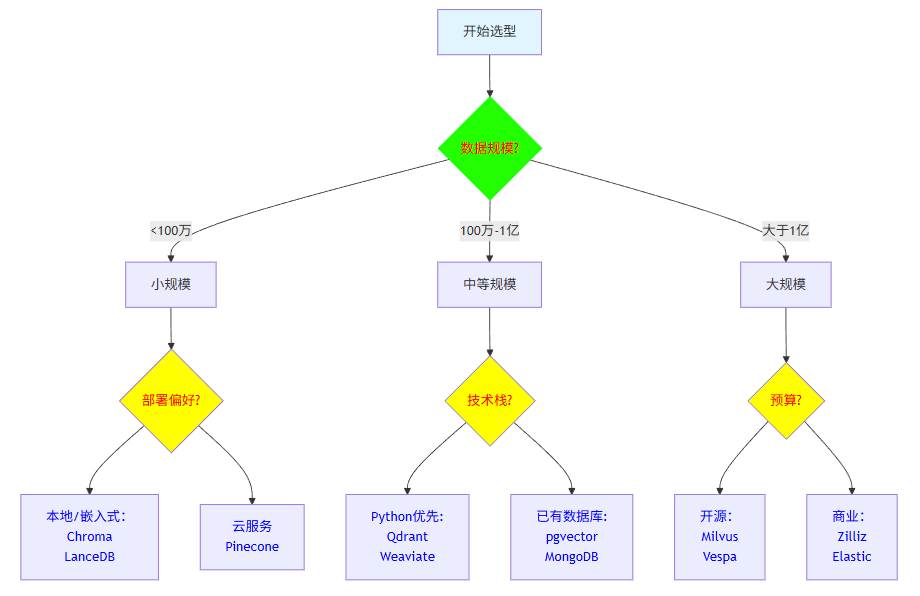

五、💡 如何选择向量数据库

以上的信息可能有些繁杂,你可以根据以下思路来缩小选择范围:

- 评估数据规模与性能需求

- 对于亿级及以上的超大规模数据,并有高并发、低延迟要求时,可优先考虑 Milvus、腾讯云VectorDB 或 VikingDB。

- 对于百万到千万级的数据,且更看重开发效率,Qdrant、Weaviate 和 Pinecone 都是不错的选择。

- 对于小型项目、原型验证或学习用途,Chroma 和 PGvector 能让你快速上手。

- 权衡运维成本与技术能力

- 如果你拥有专业的运维团队,并希望拥有最大的控制权和成本优势,开源方案(如Milvus, Qdrant)是很好的方向,但需要承担部署和维护的复杂性。

- 如果你的团队希望专注于业务逻辑而非基础设施维护,那么全托管的商业服务(如Pinecone, 各类云VectorDB)是更省心的选择,但需支付相应费用并考虑潜在的厂商锁定风险。

- 考虑集成与生态兼容性

-

明确你的技术栈。例如,如果你的项目深度绑定 PostgreSQL,那么 PGvector 几乎是无缝集成的首选。如果主要使用 AWS 或 Google Cloud,那么选择其旗下的向量数据库服务能获得更好的集成体验。

最后

我在一线科技企业深耕十二载,见证过太多因技术卡位而跃迁的案例。那些率先拥抱 AI 的同事,早已在效率与薪资上形成代际优势,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在大模型的学习中的很多困惑。

我整理出这套 AI 大模型突围资料包:

- ✅AI大模型学习路线图

- ✅Agent行业报告

- ✅100集大模型视频教程

- ✅大模型书籍PDF

- ✅DeepSeek教程

- ✅AI产品经理入门资料

如果你也想通过学大模型技术去帮助自己升职和加薪,可以扫描下方链接【保证100%免费】👇👇

为什么说现在普通人就业/升职加薪的首选是AI大模型?

人工智能技术的爆发式增长,正以不可逆转之势重塑就业市场版图。从DeepSeek等国产大模型引发的科技圈热议,到全国两会关于AI产业发展的政策聚焦,再到招聘会上排起的长队,AI的热度已从技术领域渗透到就业市场的每一个角落。

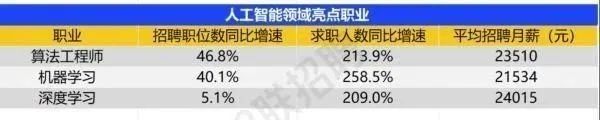

智联招聘的最新数据给出了最直观的印证:2025年2月,AI领域求职人数同比增幅突破200% ,远超其他行业平均水平;整个人工智能行业的求职增速达到33.4%,位居各行业榜首,其中人工智能工程师岗位的求职热度更是飙升69.6%。

AI产业的快速扩张,也让人才供需矛盾愈发突出。麦肯锡报告明确预测,到2030年中国AI专业人才需求将达600万人,人才缺口可能高达400万人,这一缺口不仅存在于核心技术领域,更蔓延至产业应用的各个环节。

资料包有什么?

①从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

② AI大模型学习路线图(还有视频解说)

全过程AI大模型学习路线

③学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

④各大厂大模型面试题目详解

⑤ 这些资料真的有用吗?

这份资料由我和鲁为民博士共同整理,鲁为民博士先后获得了北京清华大学学士和美国加州理工学院博士学位,在包括IEEE Transactions等学术期刊和诸多国际会议上发表了超过50篇学术论文、取得了多项美国和中国发明专利,同时还斩获了吴文俊人工智能科学技术奖。目前我正在和鲁博士共同进行人工智能的研究。

所有的视频教程由智泊AI老师录制,且资料与智泊AI共享,相互补充。这份学习大礼包应该算是现在最全面的大模型学习资料了。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

智泊AI始终秉持着“让每个人平等享受到优质教育资源”的育人理念,通过动态追踪大模型开发、数据标注伦理等前沿技术趋势,构建起"前沿课程+智能实训+精准就业"的高效培养体系。

课堂上不光教理论,还带着学员做了十多个真实项目。学员要亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓**

更多推荐

已为社区贡献485条内容

已为社区贡献485条内容

所有评论(0)