11-模型压缩与推理加速技术解析

大模型压缩与推理加速技术是深度学习领域的关键技术,旨在减少模型的大小、计算复杂度和内存需求,同时尽量保持模型的预测精度。本文是对一些主要技术的详细解析和对比,并补充了最新技术和丰富应用案例。

引言

在现代人工智能(AI)和机器学习(ML)领域,模型压缩与推理加速技术已成为研究和应用中的关键议题。随着深度学习模型的复杂性和规模不断增长,其在实际应用中面临的挑战也日益凸显。传统的深度学习模型往往需要大量的计算资源和存储空间,这不仅增加了部署成本,还限制了其在资源受限环境(如移动设备、嵌入式系统)中的应用。

模型压缩与推理加速技术的核心目标是通过优化模型结构、减少参数数量和降低计算复杂度,实现模型的高效部署和快速推理。这一技术不仅能够显著提升模型的运行效率,还能降低能耗,从而满足实时性和便携性的需求。

关注这一技术的重要性在于其广泛的应用前景和实际价值。无论是在自动驾驶、智能制造,还是在医疗诊断、智能家居等领域,高效的模型压缩与推理加速技术都是实现智能应用落地的关键。此外,随着数据量的爆炸式增长和计算资源的有限性,如何在不牺牲模型性能的前提下实现高效的模型压缩与推理加速,已成为学术界和工业界共同面临的挑战。

因此,深入解析模型压缩与推理加速技术,不仅有助于推动AI和ML技术的进一步发展,还能为实际应用提供强有力的技术支撑。本文将系统性地探讨这一领域的核心技术和最新进展,旨在为读者提供全面而深入的理解。

1. 历史背景

模型压缩与推理加速技术的研究与发展,可以追溯到上世纪末和本世纪初,随着人工智能和深度学习技术的迅猛发展,模型的复杂度和计算需求急剧增加,推动了相关技术的探索与突破。

早期的研究主要集中在模型简化方面,如1990年代提出的神经网络剪枝技术,通过移除冗余的神经元来减少模型大小和计算量。进入21世纪,随着深度学习的兴起,更多的研究开始关注模型量化,即将浮点数权重和激活值转换为低精度表示,如二进制或八位整数,以降低存储和计算需求。

2006年,Hinton等人提出的深度信念网络标志着深度学习的复兴,随后涌现出大量高效的模型压缩方法,如深度压缩(Deep Compression)和知识蒸馏(Knowledge Distillation)。这些方法不仅减少了模型参数,还保持了较高的推理精度。

2010年代中期,随着移动设备和边缘计算的普及,推理加速技术逐渐受到工业界的重视。各大科技公司如谷歌、英伟达和苹果纷纷推出专用硬件和优化框架,如TPU(Tensor Processing Unit)和Core ML,以加速模型在设备端的推理速度。

近年来,模型压缩与推理加速技术不仅在学术界取得显著进展,还在工业界得到广泛应用,涵盖了自动驾驶、智能医疗、自然语言处理等多个领域。随着技术的不断成熟和优化,预计未来将在更多场景中发挥关键作用,推动人工智能技术的普及和发展。

2. 模型压缩与推理加速的主要特点

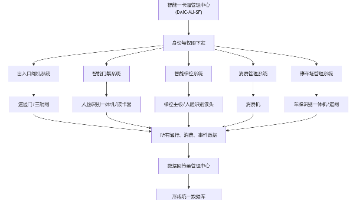

随着人工智能技术的飞速发展,深度学习模型在各个领域取得了显著的成果。然而,这些模型通常具有庞大的参数量和复杂的计算需求,给计算资源和部署带来了巨大的挑战。为了解决这些问题,模型压缩与推理加速技术应运而生。本文将深入探讨这些技术,并分析其原理、优缺点和最新进展。模型压缩与推理加速技术旨在提升深度学习模型在实际应用中的效率和性能,其关键特征涵盖模型压缩方法和推理加速技术两大方面。

模型压缩方法主要包括:

- 剪枝:通过移除冗余的神经元或权重,减少模型复杂度。优点是能显著降低模型大小和计算量,提升推理速度;缺点是可能影响模型精度,需精细调参以平衡性能和效率。

- 量化:将模型的浮点数权重和激活值转换为低精度表示(如8位整数)。优点是大幅减少模型存储需求和计算资源消耗;缺点是低精度可能导致精度损失,需精心设计量化方案。

- 知识蒸馏:将大型复杂模型(教师模型)的知识迁移到小型模型(学生模型)。优点是能在保持较高精度的同时显著减小模型尺寸;缺点是需要额外的训练步骤,且教师模型的选择和训练过程复杂。

- 低秩近似:通过将高维矩阵分解为低秩矩阵,来减少模型参数量和计算复杂度。

推理加速技术主要包括:

- 模型优化:通过优化模型的计算图和操作顺序,来减少计算量和提高计算效率。例如,使用TensorRT等工具进行模型推理层面的加速。

- 硬件加速:利用专用硬件(如GPU、TPU、FPGA)提升推理速度。优点是显著提高计算效率,适用于大规模部署;缺点是硬件成本高,且需针对特定硬件优化模型。

- 模型并行化和分布式计算:将模型拆分为多个部分,在多个计算节点上并行计算,从而提高推理速度。

- 算法优化:通过改进算法结构(如使用高效的网络架构、优化计算图)提升推理效率。优点是通用性强,适用于多种硬件平台;缺点是需要深厚的算法设计经验,优化过程复杂。

综上所述,模型压缩与推理加速技术通过多种方法综合提升模型性能,各有优缺点,实际应用中需根据具体需求灵活选择和组合。

3. 模型压缩与推理加速技术深度解析

3.1. 参数剪枝

原理:通过移除神经网络中对输出影响较小的冗余或不重要的连接和神经元。常用的剪枝方法包括权重剪枝、神经元剪枝和结构化剪枝。

数学基础:权重剪枝通常基于权重的绝对值进行排序,移除较小的权重;神经元剪枝则考虑整个神经元的贡献度,常用L1正则化来促进稀疏性。

实现细节:权重剪枝通常基于权重的绝对值进行排序,移除较小的权重;神经元剪枝则考虑整个神经元的贡献度。

优点:

- 显著减少模型参数量,降低计算复杂度。

- 提高模型的稀疏性,便于进一步优化。

缺点:

- 可能需要重新训练模型以恢复精度。

- 剪枝策略的选择对结果影响较大。

应用案例

在图像分类任务中,剪枝后的ResNet模型可以在保持精度的情况下减少50%的参数。在自动驾驶系统中,剪枝技术用于减少模型的计算负担。

3.2. 量化

原理:使用低精度(如8位或16位)表示模型的权重和激活值。量化方法包括均匀量化和非均匀量化。

数学基础:均匀量化将数值范围均匀划分,非均匀量化则根据数据分布进行划分,常用聚类算法如K-means进行量化级别的确定。

实现细节:均匀量化将数值范围均匀划分,非均匀量化则根据数据分布进行划分。

优点:

- 大幅减少模型存储需求和加速推理速度。

- 兼容性好,易于部署。

缺点:

- 精度损失可能导致性能下降。

- 需要专门的量化工具和算法。

应用案例

TensorFlow Lite和PyTorch Mobile支持量化,广泛应用于移动设备上的模型部署。在语音识别任务中,量化技术显著减少了模型大小。

3.3. 知识蒸馏

原理:将复杂模型(教师模型)的知识迁移到轻量级模型(学生模型)。通过最小化教师模型和学生模型输出之间的差异进行训练。

数学基础:常用的损失函数包括软标签损失(KL散度)和硬标签损失(交叉熵)。

实现细节:常用的损失函数包括软标签损失和硬标签损失。

优点:

- 学生模型能在保持较高精度的情况下显著减少计算量。

- 可用于多种任务和模型类型。

缺点:

- 需要额外的训练步骤,且教师模型的选择影响较大。

- 训练过程复杂,需精心设计。

应用案例

BERT模型的蒸馏版本在自然语言处理任务中表现出色。在推荐系统中,知识蒸馏用于提升轻量级模型的性能。

3.4. 低秩近似/分解

原理:用低维矩阵近似高维矩阵,减少参数数量。常用方法包括奇异值分解(SVD)和 Tucker 分解。

数学基础:SVD 将矩阵分解为两个低秩矩阵和一个对角矩阵,Tucker 分解则将多维数组分解为多个低维数组。

实现细节:SVD 将矩阵分解为两个低秩矩阵和一个对角矩阵,Tucker 分解则将多维数组分解为多个低维数组。

优点:

- 减少计算量和存储需求。

- 适用于多种矩阵运算场景。

缺点:

- 近似过程可能引入误差。

- 需要复杂的数学工具和算法。

应用案例

在推荐系统中,低秩分解技术常用于矩阵分解。在图像处理中,低秩近似用于加速卷积运算。

3.5. 轻量化设计

原理:设计精简的网络结构,如MobileNet、ShuffleNet。通过使用深度可分离卷积和通道混洗等技术减少计算量。

数学基础:深度可分离卷积将标准卷积分解为深度卷积和逐点卷积,通道混洗操作则重新排列通道以减少计算量。

实现细节:MobileNet使用深度可分离卷积,ShuffleNet则引入通道混洗操作。

优点:

- 天生适合移动和嵌入式设备。

- 计算效率高,延迟低。

缺点:

- 设计复杂,可能需要从头开始训练。

- 精度可能略低于复杂模型。

应用案例

MobileNet广泛应用于移动端图像识别。在智能家居设备中,轻量化设计用于实现实时图像处理。

3.6. 模型并行化和分布式计算

原理:将模型拆分并在多个计算节点上并行计算。常用方法包括数据并行、模型并行和流水线并行。

数学基础:数据并行将数据分片,模型并行将模型分片,流水线并行则将计算过程分阶段执行,利用并行计算理论优化性能。

实现细节:数据并行将数据分片,模型并行将模型分片,流水线并行则将计算过程分阶段执行。

优点:

- 显著提高推理速度。

- 适用于大规模模型和复杂任务。

缺点:

- 需要高性能计算资源,通信开销大。

- 实现复杂,需专业知识和工具。

应用案例

大规模语言模型如GPT-3的推理常采用分布式计算。在视频分析任务中,分布式计算用于加速处理。

3.7. 硬件加速

原理:利用GPU、TPU、FPGA等硬件的并行计算能力。通过专用硬件优化深度学习计算。

数学基础:GPU擅长并行计算,TPU专为深度学习优化,FPGA则提供灵活的硬件配置,利用硬件加速原理提升性能。

实现细节:GPU擅长并行计算,TPU专为深度学习优化,FPGA则提供灵活的硬件配置。

优点:

- 大幅提升计算效率。

- 适用于多种深度学习任务。

缺点:

- 硬件成本高,开发复杂。

- 需要专门的驱动和库支持。

应用案例

Google的TPU专为深度学习推理设计,显著加速模型计算。在自动驾驶系统中,硬件加速用于实时数据处理。

3.8. 优化模型的推理顺序

原理:通过优化计算图,减少冗余计算。常用方法包括图融合、内存复用和计算重排。

数学基础:图融合将多个操作合并为一个,内存复用减少内存分配,计算重排优化计算顺序,利用图论和优化算法提升效率。

实现细节:图融合将多个操作合并为一个,内存复用减少内存分配,计算重排优化计算顺序。

优点:

- 提高推理效率,无需改变模型结构。

- 兼容性好,易于集成。

缺点:

- 优化过程复杂,需专业知识。

- 需要专门的工具和算法。

应用案例

TensorRT通过优化计算图加速推理。在语音识别任务中,优化推理顺序显著提升了处理速度。

3.9. 解码方法

原理:使用新型解码方法如Speculative Decoding、LLMA等。通过改进解码过程提升效率。

数学基础:Speculative Decoding并行处理多个候选,LLMA则优化了长序列的处理,利用并行计算和优化算法提升解码效率。

实现细节:Speculative Decoding并行处理多个候选,LLMA则优化了长序列的处理。

优点:

- 提高解码速度,保证质量。

- 适用于自然语言处理任务。

缺点:

- 技术较新,应用场景有限。

- 需要专门的算法和实现。

应用案例

在机器翻译任务中,新型解码方法显著提升速度。在聊天机器人中,优化解码方法提升了响应速度。

3.10. 底层优化

原理:优化计算图,利用硬件加速等技术。通过底层优化全面提升计算效率。

数学基础:包括内存管理优化、计算图优化和硬件指令优化,利用系统优化和硬件加速原理提升性能。

实现细节:包括内存管理优化、计算图优化和硬件指令优化。

优点:

- 全面提升计算效率。

- 适用于多种模型和任务。

缺点:

- 需深入了解底层硬件和软件。

- 实现复杂,需专业知识和工具。

应用案例

深度学习框架如PyTorch和TensorFlow提供底层优化工具。在视频分析任务中,底层优化显著提升了处理速度。

3.11. 神经架构搜索(NAS)

原理:自动搜索最优的网络结构,通过迭代优化找到性能和效率平衡的模型。

数学基础:包括基于强化学习的搜索、基于进化算法的搜索和基于梯度优化的搜索,利用优化算法和搜索策略找到最优解。

实现细节:包括基于强化学习的搜索、基于进化算法的搜索和基于梯度优化的搜索。

优点:

- 自动化设计,减少人工干预。

- 能找到高效且性能优异的模型。

缺点:

- 计算资源消耗大。

- 搜索过程复杂,需专业知识。

应用案例

在图像分类任务中,NAS搜索到的模型在保持高精度的同时显著减少了计算量。在自然语言处理任务中,NAS用于设计高效的Transformer模型。

4. 模型压缩与推理加速的应用领域

模型压缩与推理加速技术在多个领域展现出显著的应用价值,极大提升了系统性能和效率。

自动驾驶

在自动驾驶系统中,模型压缩技术显著减少了车载计算单元的负担。通过压缩深度学习模型,车辆能在有限硬件资源下快速响应复杂路况,提升行驶安全。例如,特斯拉利用压缩后的神经网络模型,实现了更高效的实时路况分析和决策。

智能手机

智能手机应用中,推理加速技术优化了图像识别、语音助手等功能。压缩后的模型不仅占用更少存储空间,还能在低功耗下快速运行,提升用户体验。如苹果的Core ML框架,通过加速推理过程,使iPhone在处理图像和语音任务时更为流畅。

医疗影像分析

在医疗领域,模型压缩技术助力高效处理大量影像数据。压缩后的模型能快速识别病变区域,提高诊断准确性和效率。例如,谷歌的DeepMind Health利用压缩模型,在短时间内分析大量CT扫描图像,辅助医生做出精准诊断。

自然语言处理(NLP)

NLP领域通过推理加速技术,实现了更快的文本分析和响应。压缩后的语言模型在保持理解能力的同时,显著降低了计算资源需求。如微软的Azure Cognitive Services,通过优化模型,提供实时高效的语音和文本处理服务。

综上所述,模型压缩与推理加速技术在各领域的应用,不仅提升了系统性能,还带来了显著的经济和社会效益,推动了智能技术的广泛应用。

5. 模型压缩与推理加速的争议

尽管模型压缩与推理加速技术在人工智能领域取得了显著进展,但其应用过程中仍面临诸多争议与批评。

首先,模型压缩技术在实际应用中可能引发精度损失问题。为了降低模型的存储和计算需求,压缩技术通常会简化模型结构或减少参数数量,这可能导致模型在处理复杂任务时精度下降。尤其是在高精度要求的应用场景中,如医疗诊断和自动驾驶,精度损失可能带来严重的后果。

其次,推理加速技术的兼容性问题也备受关注。不同的硬件平台和软件框架对加速技术的支持程度各异,导致加速技术在跨平台部署时可能遇到兼容性障碍。这不仅增加了开发者的工作量,也可能限制技术的广泛应用。

此外,学术界和工业界对模型压缩与推理加速技术的效果存在不同看法。学术界倾向于关注技术的理论创新和长期潜力,而工业界更注重技术的实际应用效果和成本效益。部分学者认为,当前的压缩和加速技术尚未达到理想状态,仍需进一步研究优化。而工业界则更关注技术在特定场景下的实际表现,对技术的推广和应用持谨慎态度。

综上所述,模型压缩与推理加速技术在带来便利的同时,也面临精度损失、兼容性问题和不同领域对其效果的不同评价等争议与批评。未来,如何在保证模型性能的前提下,进一步优化压缩与加速技术,仍是业界需要重点解决的问题。

6. 未来展望

随着人工智能技术的迅猛发展,模型压缩与推理加速技术在未来的发展趋势呈现出多方面的可能性。首先,技术创新将持续推动该领域的进步。预期未来将出现更多高效的模型压缩算法,如基于神经架构搜索(NAS)的自动化压缩方法,能够在保证模型性能的前提下大幅减少参数数量。此外,硬件层面的优化,如专用AI加速芯片的设计,将进一步提升推理速度和能效比。

应用场景的拓展也是未来的一大趋势。目前,模型压缩与推理加速技术主要应用于智能手机、自动驾驶等领域,未来有望扩展到更多垂直行业,如智能制造、医疗诊断和智慧城市等。这些场景对实时性和低功耗有极高要求,模型压缩与推理加速技术的应用将极大提升系统的响应速度和可靠性。

然而,这一领域也面临诸多挑战。数据隐私和安全问题日益凸显,如何在压缩和加速过程中确保数据的安全性和隐私保护将成为重要课题。此外,随着模型复杂度的增加,压缩和加速的难度也随之提升,如何在保证模型精度的前提下实现高效压缩仍需深入研究。

机遇与挑战并存,模型压缩与推理加速技术在未来有望迎来更多的研究投入和应用落地,成为推动人工智能普及和发展的关键力量。通过不断的技术创新和应用拓展,这一领域将为各行各业带来更高效、更智能的解决方案。

参考资料

在撰写本文的过程中,参考了大量的文献、学术论文、技术报告以及在线资源,以确保内容的准确性和权威性。以下列出了一些主要的参考资料,供读者进一步深入研究:

1. 学术论文:

Han, S., Mao, H., & Dally, W. J. (2015). "Deep Compression: Compressing Deep Neural Networks with Pruning, Trained Quantization and Huffman Coding." 在这篇论文中,作者详细介绍了深度压缩技术,包括剪枝、量化以及霍夫曼编码等方法。

Gupta, S., Agrawal, A., Gopalakrishnan, K., & Narayanan, P. (2015). "Deep Learning with Limited Numerical Precision." 该论文探讨了在有限数值精度下进行深度学习的可能性及其影响。

2. 技术报告:

Google Research. (2017). "Quantization and Training of Neural Networks for Efficient Integer-Arithmetic-Only Inference." 这份报告由谷歌研究团队发布,详细介绍了整数算术推理的量化与训练方法。

NVIDIA. (2019). "TensorRT: High-Performance Deep Learning Inference." NVIDIA的技术报告详细介绍了TensorRT在深度学习推理加速中的应用。

3. 在线资源:

TensorFlow官网. "Model Optimization Toolkit." TensorFlow官方提供的模型优化工具包,包含多种模型压缩和加速技术。

PyTorch官网. "Quantization Documentation." PyTorch官方文档中的量化部分,提供了详细的量化方法和实践指南。

4. 书籍:

Goodfellow, I., Bengio, Y., & Courville, A. (2016). "Deep Learning." 这本书是深度学习领域的经典著作,其中也涉及了模型压缩与加速的相关内容。

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)