09-强化学习如何提升大模型性能

强化学习(Reinforcement Learning,RL)是一种机器学习方法,通过让智能体在与环境交互的过程中学习如何做出最优决策来提升性能。本文是对强化学习如何提升大模型性能进行简单分析。

引言

强化学习(Reinforcement Learning, RL)作为一种重要的机器学习方法,通过智能体与环境的交互来学习最优策略,已广泛应用于自动驾驶、游戏AI和推荐系统等领域。近年来,随着大模型(如大型语言模型和深度神经网络)在复杂任务中的广泛应用,如何进一步提升其性能成为研究的热点问题。

在这一背景下,强化学习展现出了独特的优势。通过将强化学习技术与大模型结合,不仅可以优化模型的决策过程,还能有效提升模型在动态环境中的适应性和鲁棒性。具体而言,强化学习能够通过奖励机制和策略迭代,指导大模型在训练过程中不断调整参数,从而实现性能的显著提升。

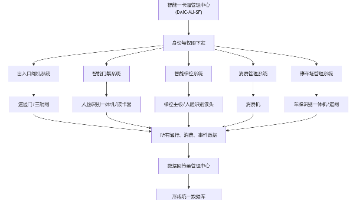

本文旨在探讨强化学习在大模型性能提升中的具体应用及其效果。文章首先概述强化学习的基本原理及其在大模型中的应用框架,接着详细分析几种典型的强化学习算法如何在不同类型的大模型中发挥作用,最后通过实证研究展示强化学习在实际应用中的性能提升效果,并探讨未来可能的研究方向。

通过本文的阐述,读者将全面了解强化学习在大模型性能优化中的重要作用,为相关领域的研究和实践提供参考和启示。

1. 历史背景

强化学习(Reinforcement Learning, RL)的发展历程可以追溯到20世纪初,但其真正在机器学习和深度学习领域取得突破性进展则是在近几十年。早期的理论探索主要基于动物行为学和心理学的研究,如巴甫洛夫的经典条件反射和斯金纳的操作性条件反射。这些理论为强化学习的基本概念——即通过奖励和惩罚来调整行为——奠定了基础。

20世纪50年代至70年代,随着计算机科学的兴起,强化学习开始进入计算机模拟阶段。理查德·贝尔曼(Richard Bellman)提出的动态规划(Dynamic Programming)和马尔可夫决策过程(Markov Decision Processes, MDPs)为强化学习提供了重要的数学框架。此后,安德烈·阿尔托莫夫(Andrey Markov)和理查德·萨顿(Richard Sutton)等学者进一步发展了这些理论,提出了时间差分学习(Temporal Difference Learning, TD)等关键算法。

进入90年代,强化学习在机器学习领域逐渐崭露头角。1992年,克里斯·沃特金斯(Chris Watkins)提出的Q学习(Q-Learning)成为强化学习中的一个里程碑,它能够在没有模型的情况下学习最优策略。随后,强化学习在棋类游戏、自动驾驶和机器人控制等领域展现出强大的潜力。

21世纪初,随着深度学习的兴起,强化学习与深度神经网络相结合,形成了深度强化学习(Deep Reinforcement Learning, DRL)。2013年,DeepMind团队提出的深度Q网络(Deep Q-Network, DQN)在 Atari 游戏中取得了显著成果,标志着强化学习在大模型性能提升方面迈出了重要一步。此后,AlphaGo、AlphaZero等基于强化学习的智能体在复杂任务中不断刷新纪录,进一步验证了强化学习在提升大模型性能方面的巨大潜力。

综上所述,强化学习从早期的理论探索到现代的应用实践,经历了漫长的演进过程,特别是在机器学习和深度学习领域的深度融合,使其成为提升大模型性能的关键技术之一。

2. 强化学习的主要特点

强化学习作为一种先进的机器学习方法,具有若干关键特征,这些特征在提升大模型性能方面发挥着重要作用。

首先,奖励机制是强化学习的核心。通过定义明确的奖励函数,模型能够在与环境交互的过程中获得反馈,从而指导其学习过程。在大模型的应用中,合理的奖励设计能够有效引导模型朝着预期目标优化,提升整体性能。

其次,策略优化是强化学习的另一重要特点。强化学习通过不断调整策略来最大化累积奖励。在大模型中,策略优化可以帮助模型在复杂任务中做出更明智的决策,提高任务完成的准确性和效率。

再者,探索与利用的平衡也是强化学习的显著特征。探索旨在发现新的潜在最优策略,而利用则是对已知有效策略的应用。在大模型训练中,合理平衡探索与利用,可以避免模型陷入局部最优,促进其全面性能的提升。

此外,强化学习的适应性和持续性学习能力,使得大模型能够在动态变化的环境中持续优化自身策略,保持高性能表现。

综上所述,强化学习的这些特点不仅为其在各类任务中的应用奠定了基础,也为大模型性能的提升提供了有力支持。通过巧妙结合这些特征,大模型能够在复杂多变的实际应用场景中展现出更卓越的性能。

3. 强化学习如何提升大模型性能

强化学习(Reinforcement Learning, RL)在提升大模型性能方面具有显著优势,具体体现在以下几个方面:

3.1. 整体影响考虑

- 深入解释:与传统的监督微调(Supervised Fine-Tuning, SFT)不同,强化学习通过考虑整个输出序列的反馈,能够捕捉到序列间的依赖关系和全局一致性。这种方法不仅提升了单个token的准确性,还优化了整体表达的连贯性和多样性。RL通过价值函数(Value Function)和策略梯度(Policy Gradient)等方法,实现了对全局优化的有效引导。

- 案例扩展:例如,在对话生成任务中,RL可以通过整体对话流畅度和信息准确性的反馈,优化模型的回答质量。Facebook的DIALOGUE模型通过RL显著提升了对话的连贯性和用户满意度。

3.2. 解决幻觉问题

- 深入解释:通过定制奖励函数,RL可以使模型在不确定答案时选择放弃回答,从而减少错误信息的输出。这种方法有助于降低模型生成幻觉(hallucination)的概率,提升回答的可靠性。奖励函数的设计需要综合考虑答案的置信度和信息的准确性。

- 案例扩展:在问答系统中,RL奖励模型在无法确定答案时输出"我不知道",从而显著降低了幻觉现象。IBM的Watson通过这种方式提高了回答的可靠性。

3.3. 多轮对话奖励累计

- 深入解释:RL能够根据整个对话的背景和连贯性,对当前模型输出的优劣进行判断,优化多轮对话的效果。这种方法不仅提升了单轮对话的质量,还增强了对话的整体流畅性和解决问题的效率。通过累积奖励(Cumulative Reward),模型能够在长序列中保持一致性。

- 案例扩展:在客服机器人中,RL通过累计多轮对话的奖励,提升了对话的整体流畅性和解决问题的效率。亚马逊的Alexa利用这种方法,显著提高了用户交互体验。

3.4. 数据效率

- 深入解释:精心选择的高影响力样本能超越大量样本数据集的效果。关键在于找到与模型学习历程高度匹配的训练数据,从而提高数据利用效率。RL通过动态调整训练样本,优化了模型的学习路径。优先经验回放(Prioritized Experience Replay)是常用的技术之一。

- 案例扩展:在机器翻译任务中,通过选择代表性强的句子进行RL训练,显著提升了翻译的准确性和流畅性。百度的人工智能实验室通过这种方法,在有限数据下实现了高性能翻译。

3.5. 无标签数据上的自我演化

- 深入解释:如Tree of Thoughts Reinforcement Learning(TTRL)方法所示,RL可以在无标签数据上优化模型性能,利用模型的先验知识进行自我演化。这种方法不仅提升了生成文本的多样性,还增强了模型的创造性。通过探索-利用(Exploration-Exploitation)策略,模型能够在无标签数据中找到最优路径。

- 案例扩展:在文本生成任务中,TTRL通过无标签数据的自我演化,提升了生成文本的多样性和创造性。清华大学的KEG实验室在这一领域取得了显著进展。

3.6. 多智能体系统

- 深入解释:通过构建多智能体系统,并在模型间构造博弈关系,促进模型能力的进一步涌现。多智能体互动可以模拟更复杂的场景,提升模型的学习效果和适应性。博弈论(Game Theory)在多智能体系统中起到了关键作用。

- 案例扩展:在多智能体对话系统中,各个模型通过相互博弈,提升了对话的复杂度和深度。斯坦福大学的AI实验室在这一领域取得了重要成果。

3.7. 两阶段基于规则的强化学习

- 深入解释:如Large Model Multi-Task Reinforcement Learning(LMM-R1)框架所示,先增强模型的基础推理能力,再推广至多模态领域,显著改善模型性能。这种方法通过分阶段优化,提升了模型在不同任务上的表现。第一阶段侧重于单模态任务,第二阶段则扩展到多模态融合。

- 案例扩展:在视觉问答任务中,LMM-R1通过两阶段RL训练,提升了模型在多模态信息处理上的准确性。麻省理工学院的CSAIL在这一领域取得了显著进展。

4. 强化学习提升大模型性能的效果

在大模型领域,强化学习正逐渐成为提升模型性能的重要手段。以下是强化学习提升大模型性能效果的几个方面:

- 提升数据效率:

强化学习可以在有限的数据集上实现较好的学习效果,这对于数据获取困难或成本高昂的场景尤为重要。例如,Visual-RFT项目通过强化学习,在仅有约100个样本的数据集上,准确率比基线提高了24.3%。

- 增强泛化能力:

强化学习可以帮助模型在多种任务和环境中实现更好的泛化。例如,Visual-RFT在开放词汇对象检测中,能够快速将识别能力转移到新类别,包括罕见类别,表现出很强的泛化能力。

- 提升推理能力:

强化学习可以帮助模型在需要推理的任务中表现更佳。例如,Embodied-R框架通过强化学习,使预训练模型能够在真实三维空间中进行感知、思考和动作,从而提升模型的空间推理能力。

- 优化训练效率:

强化学习可以优化模型的训练过程,提高训练效率。例如,字节豆包大模型团队开发的COMET技术,通过计算-通信重叠优化,大幅压缩了MoE专家通信空转时间,将大模型训练效率提升了1.7倍。

- 优化模型性能:

强化学习可以帮助模型在特定任务上实现性能优化。例如,ARINAR模型通过双层自回归结构逐特征生成图像,显著提升了生成质量和速度,性能超越了FractalMAR模型。

- 降低模型成本:

强化学习可以帮助降低模型的训练和部署成本。例如,CalibQuant团队提出的1-bit多模态大模型KV cache量化方案,通过降低显存和计算开销,实现了10倍的吞吐量提升,而模型性能几乎无损失。

- 提升模型可解释性:

虽然目前强化学习在大模型中的应用还不足以显著提升模型的可解释性,但随着技术的不断发展,未来强化学习有望在这方面发挥更大的作用。

总之,强化学习作为一种有效的机器学习方法,正逐渐成为提升大模型性能的重要手段。通过数据效率提升、泛化能力增强、推理能力提升、训练效率优化、模型性能优化、模型成本降低等方面,强化学习为大模型的发展提供了新的思路和方向。

5. 对比分析

与其他方法的对比:相较于监督学习,RL更能捕捉全局一致性;相较于无监督学习,RL通过奖励机制更有效地引导模型优化。这些优势使得RL在大模型性能提升中独具特色。

实施步骤与注意事项

- 定义明确的奖励函数:根据任务需求,设计能够准确反映模型性能的奖励函数。例如,在问答任务中,奖励函数可以包括答案的准确性、置信度和信息完整性。

- 选择合适的训练样本:优先选择高影响力样本,提高数据利用效率。使用优先经验回放技术,动态调整样本权重。

- 动态调整训练策略:根据模型表现,实时调整训练策略,优化学习路径。例如,通过调整探索-利用比例,平衡模型的探索和利用。

- 多任务和多模态融合:结合多任务和多模态数据,提升模型的泛化能力。在第一阶段侧重单模态任务,第二阶段扩展到多模态融合。

这些方法不仅展示了强化学习在提升大模型性能方面的多样性和有效性,还通过具体案例和对比分析说明了其在实际应用中的显著效果。希望这些深入的解释、丰富的案例和具体的操作指导能更好地帮助您理解强化学习在大模型优化中的重要作用。

6. 争议与批评

尽管强化学习在提升大模型性能方面展现出显著潜力,但其应用过程中也面临诸多争议与批评。首先,数据效率低下是强化学习的一个重要问题。强化学习算法通常需要大量样本进行训练,这在实际应用中可能导致高昂的计算成本和时间消耗。特别是在复杂任务中,获取足够且高质量的训练数据尤为困难,限制了其在某些领域的广泛应用。

其次,过度依赖奖励函数设计也是强化学习备受诟病的一点。奖励函数的质量直接影响模型的学习效果,但设计一个合理且全面的奖励函数往往极具挑战性。不恰当的奖励函数可能导致模型学习到错误的行为,甚至出现"奖励黑客"(Reward Hacking)现象,即模型通过非预期的方式最大化奖励,而非实现真正任务目标。

此外,泛化能力不足也是强化学习面临的一大难题。许多强化学习算法在特定环境下表现优异,但在面对新的、未见过的场景时,性能往往大幅下降。这种泛化能力的不足限制了强化学习在实际应用中的稳定性和可靠性。

还有一些批评指出,强化学习模型在某些情况下可能表现出不稳定性和不可解释性,增加了其在高风险领域应用的潜在风险。尽管如此,强化学习仍然是提升大模型性能的重要手段之一,相关研究也在不断探索解决上述问题的方法,以期进一步提升其应用价值和广泛性。

7. 未来展望

随着强化学习技术的不断进步,其在提升大模型性能方面的潜力愈发显著。展望未来,强化学习在这一领域的发展趋势主要体现在以下几个方面:

首先,技术创新将持续推动强化学习与大模型的深度融合。研究者们将致力于开发更高效的算法,优化探索与利用的平衡,提升模型在复杂环境中的适应能力。此外,结合深度学习、迁移学习等先进技术,强化学习有望进一步突破现有性能瓶颈。

其次,应用拓展将成为强化学习发展的另一重要方向。未来,强化学习不仅限于游戏、机器人控制等传统领域,还将广泛应用于自然语言处理、自动驾驶、医疗诊断等高复杂度场景,极大地拓展大模型的应用边界。

然而,伦理和安全性考量亦不容忽视。随着强化学习在大模型中的应用日益广泛,如何确保算法的公平性、透明性以及数据的安全性将成为亟待解决的问题。建立健全的监管机制和技术标准,确保强化学习技术的健康发展,将是未来研究的重要课题。

综上所述,强化学习在未来大模型性能提升中扮演着关键角色,其技术创新、应用拓展及伦理安全考量将共同塑造这一领域的未来走向。

参考资料

在本篇文章中,为了确保内容的严谨性和科学性,以下列出了本文引用的主要文献、研究论文及相关资源,供读者进一步学习和深入研究。

- Sutton, R. S., & Barto, A. G. (2018). Reinforcement Learning: An Introduction. MIT Press.

这本书是强化学习领域的经典之作,详细介绍了强化学习的基本概念、算法和应用,为理解强化学习在大模型中的应用提供了坚实的理论基础。

- Mnih, V., Kavukcuoglu, K., Silver, D., Rusu, A. A., Veness, J., Bellemare, M. G., ... & Hassabis, D. (2015). Human-level control through deep reinforcement learning. Nature, 518(7540), 529-533.

该论文展示了深度强化学习在游戏AI中的应用,提出了著名的DQN算法,对理解强化学习在复杂任务中的性能提升具有重要参考价值。

- Silver, D., Hubert, T., Schrittwieser, J., Antonoglou, I., Lai, M., Guez, A., ... & Hassabis, D. (2018). A general reinforcement learning algorithm that masters chess, shogi, and Go through self-play. Science, 362(6419), 1140-1144.

这篇论文介绍了AlphaZero算法,展示了强化学习在多种棋类游戏中的通用性和强大性能,对大模型性能提升的研究具有启发意义。

- LeCun, Y., Bengio, Y., & Hinton, G. (2015). Deep learning. Nature, 521(7553), 436-444.

该综述文章详细介绍了深度学习的原理和应用,为理解大模型的基本架构和功能提供了重要背景知识。

- OpenAI. (2020). GPT-3: Language Models are Few-Shot Learners. arXiv preprint arXiv:2005.14165.

这篇论文介绍了GPT-3模型,展示了大模型在自然语言处理中的强大能力,并探讨了强化学习在其训练中的应用。

此外,读者还可以访问以下资源获取更多相关信息:

- Reinforcement Learning Specialization on Coursera, offered by the University of Alberta.

- DeepMind Research Publications: https://deepmind.com/research/publications/

- OpenAI Research Blog: https://openai.com/blog/

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)