Agent RL 速览 — 打造自主学习的 Agent

为什么在大模型时代仍然离不开强化学习?

过去,许多大模型训练以“预训练 → 监督微调(SFT)”为主。

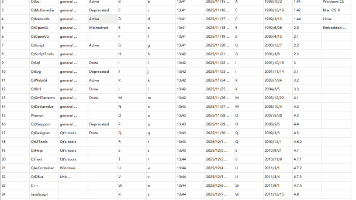

自 2025 年起,强化学习(RL)及其后训练(post-training)范式逐步成为主流大语言模型与智能体(Agent)系统的标配。几乎所有顶尖模型与 Agent 在技术报告中均提及强化学习微调流程,并大量引入基于反馈的后训练机制,从而获得显著性能提升。

由此可见,强化学习正成为主流模型与 Agent 的基础能力构建路径。

什么是 Agent RL?

Agent RL 是强化学习在智能体(Agent)系统中的应用范式。通过 Agent RL 可以让 Agent 自主学习自主迭代。Agent RL 不仅优化语言输出质量,与传统的大模型强化学习不同,其更关注模型在动态环境中如何自主行动、调用工具、纠错迭代,最终高效完成任务。

在一个具备“感知环境 → 决策 → 行动 → 反馈”闭环的 Agent 系统中,利用强化学习方法来优化 Agent 的行为策略、工具调用、任务拆解、长期规划与多步交互能力。

与传统 LLM 强化学习主要优化生成质量不同,Agent RL 更关注“Agent 在现实或模拟环境中完成任务的能力”。

详细的 Agent RL 原理及入门实战教程 加 小助理 免费领取

Agent RL 关键环节

Agent RL 的学习过程是一个持续交互的闭环系统,包括以下关键环节:

| 环节 | 描述 |

|---|---|

| 状态(State) | 当前任务上下文,如用户问题、工具返回结果、数据库状态等 |

| 动作(Action) | 模型可执行的操作,如生成 SQL、调用 API、发起搜索等 |

| 奖励(Reward) | 根据执行结果给出的反馈,如 SQL 是否正确、结果是否匹配预期 |

| 策略(Policy) | 模型根据状态选择动作的规则,通常是一个语言模型 |

| 更新(Update) | 利用 RL 算法(如 PPO、GRPO)优化策略,使未来更可能获得高奖励 |

Agent RL 的用途

Agent RL 的用途非常广泛包括:

在自动化流程中,Agent 利用 RL 来提升流程效率、错误恢复能力、工具调用决策能力。

在对话系统或用户交互系统中,Agent 利用 RL 来优化多轮任务完成率、用户满意度、任务成功率。

在机器人、虚拟助手、搜索引擎等系统中,Agent 利用 RL 来提升执行策略、适应环境变化、自我纠错能力

Agent RL 框架

代表框架包括 ART 与 Microsoft Agent-Lightning。

ART(Agent Reinforcement Trainer):智能体行为优化框架

GitHub: https://github.com/OpenPipe/ART

定位:ART 由 OpenPipe 团队在 2025 年推出,面向 Agent 场景的强化学习训练。它让语言模型在动态环境中执行任务、收集交互轨迹,并基于反馈优化策略,是“从 LLM 到 Agent RL”的典型实现。

核心功能:ART 以 POMDP(部分可观测马尔可夫决策过程)建模 Agent 行为,支持 GRPO 与 RLVR 等算法。训练循环可连接外部工具(如 Web API、文件系统、浏览器模拟器等),使模型在真实任务中优化执行策略。

用途与特点:ART 适用于构建“会操作”的 Agent,如 Web 浏览、代码调试或信息抽取等。与 TRL 关注文本对齐不同,ART 更关注执行反馈。其可插拔的 environment 接口便于定义任务环境,使 Agent 在执行中获得奖励信号,实现端到端强化学习。

示例代码:

from art import AgentTrainer, WebEnvironment

env = WebEnvironment(tasks="search_and_extract")

trainer = AgentTrainer(model="deepseek-r1", environment=env, algo="GRPO")

trainer.train(episodes=500)

Microsoft Agent-Lightning:企业级 Agent RL 平台

GitHub: https://github.com/microsoft/agent-lightning

定位:Agent-Lightning 是微软在 2025 年推出的多智能体强化学习框架,旨在为企业提供统一的 Agent 训练与评估平台。其设计灵感来自 PyTorch Lightning 的模块化结构,可在 LangChain、AutoGen、Swarm 等系统上无缝嵌入 RL 训练机制。

核心功能:框架由 Trainer、Rewarder、Environment 与 Orchestrator 构成,支持 PPO、DPO、RLVR 等算法。可在多 Agent 协作任务中共享奖励信号,实现自适应优化,并内置 MCP(Model Context Protocol)接口,便于连接外部 LLM 服务进行协同训练。

技术特点与用途:面向“多智能体系统的强化学习训练”,适用于任务自动化、AI 编程助理与搜索规划等场景,支持多 Agent 间的动态协作优化、自动奖励归因与可视化分析。

示例代码:

import agent_lightning as al

from my_agents import CodeAgent, SearchAgent

system = al.AgentSystem([CodeAgent(), SearchAgent()])

trainer = al.AgentTrainer(system, method="RLVR", environment="dev_env")

trainer.run(episodes=200)

Agent RL 框架对比

| 框架名称 | 定位 | 主要算法 | 典型用途 | 难度 |

|---|---|---|---|---|

| ART | 动态环境 Agent 优化 | GRPO、RLVR | 单 Agent 执行任务 | 中等 |

| Agent-Lightning | 多 Agent RL 系统 | PPO、RLVR | 企业级 Agent 强化学习平台 | 较高 |

详细的 Agent RL 原理及入门实战教程 加入 赋范空间 免费领取

还有更多免费的前沿技术解读、Agent开发实战等资源等你来拿~

总结

- Agent RL 是强化学习在智能体系统中的应用范式,关注 Agent 在动态环境中自主行动、调用工具、纠错迭代的能力。

- 代表框架包括 ART 与 Microsoft Agent-Lightning,分别定位为“单 Agent 执行任务”与“企业级多 Agent 强化学习平台”。

- 对比 ART 与 Agent-Lightning,ART 更关注单 Agent 执行任务,而 Agent-Lightning 更关注多 Agent 协作优化。

更多相关文章

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)