提升AI模型在多语言多模态机器翻译任务中的性能

在全球化的背景下,语言和信息的交流跨越了国界和模态的限制。多语言多模态机器翻译旨在打破语言和信息形式的障碍,实现不同语言之间以及文本、图像、音频等多种模态信息的准确转换。本研究的目的在于深入探讨如何提升AI模型在这一复杂任务中的性能,范围涵盖了从模型架构的设计、数据处理方法到算法优化等多个方面。通过对这些关键因素的研究和改进,期望能够提高翻译的准确性、流畅性和对多模态信息的处理能力,为跨语言跨模态

提升AI模型在多语言多模态机器翻译任务中的性能

关键词:AI模型、多语言多模态机器翻译、性能提升、模型架构、数据处理

摘要:本文聚焦于提升AI模型在多语言多模态机器翻译任务中的性能这一关键问题。首先介绍了该研究的背景,包括目的、预期读者、文档结构和相关术语。接着阐述了多语言多模态机器翻译的核心概念与联系,给出了原理和架构的文本示意图及Mermaid流程图。详细讲解了核心算法原理和具体操作步骤,并结合Python源代码进行说明。对涉及的数学模型和公式进行了深入剖析,并举例说明。通过项目实战,展示了代码实际案例及详细解释。探讨了该技术的实际应用场景,推荐了学习、开发所需的工具和资源,包括书籍、在线课程、技术博客、IDE等。最后总结了未来发展趋势与挑战,提供了常见问题解答和扩展阅读参考资料,旨在为研究和应用多语言多模态机器翻译的人员提供全面且深入的指导。

1. 背景介绍

1.1 目的和范围

在全球化的背景下,语言和信息的交流跨越了国界和模态的限制。多语言多模态机器翻译旨在打破语言和信息形式的障碍,实现不同语言之间以及文本、图像、音频等多种模态信息的准确转换。本研究的目的在于深入探讨如何提升AI模型在这一复杂任务中的性能,范围涵盖了从模型架构的设计、数据处理方法到算法优化等多个方面。通过对这些关键因素的研究和改进,期望能够提高翻译的准确性、流畅性和对多模态信息的处理能力,为跨语言跨模态的信息交流提供更高效、更优质的解决方案。

1.2 预期读者

本文预期读者包括从事自然语言处理、机器学习、人工智能等领域的研究人员和学者,他们希望深入了解多语言多模态机器翻译的技术原理和最新发展趋势,为自己的研究工作提供参考和启发。同时,也适合从事相关软件开发的工程师和开发者,他们可以从本文中获取实际的技术指导,应用到具体的项目开发中。此外,对多语言多模态机器翻译感兴趣的学生和爱好者也可以通过阅读本文,系统地学习这一领域的知识和技术。

1.3 文档结构概述

本文将按照以下结构进行阐述。首先,介绍多语言多模态机器翻译的核心概念与联系,包括其原理和架构,通过文本示意图和Mermaid流程图进行直观展示。接着,详细讲解核心算法原理和具体操作步骤,并结合Python源代码进行说明,让读者能够深入理解算法的实现细节。然后,对涉及的数学模型和公式进行深入剖析,并举例说明,为算法的理解提供理论支持。通过项目实战,展示代码实际案例及详细解释,帮助读者将理论知识应用到实际项目中。探讨该技术的实际应用场景,让读者了解其在不同领域的潜在价值。推荐学习、开发所需的工具和资源,包括书籍、在线课程、技术博客、IDE等,为读者提供更多的学习和实践途径。最后,总结未来发展趋势与挑战,提供常见问题解答和扩展阅读参考资料,为读者的进一步学习和研究提供指导。

1.4 术语表

1.4.1 核心术语定义

- 多语言机器翻译:指能够同时处理多种语言之间翻译任务的机器翻译技术,旨在打破不同语言之间的交流障碍,实现多种语言之间的信息转换。

- 多模态机器翻译:不仅考虑文本信息,还融合了图像、音频等其他模态信息进行翻译的技术。通过综合利用多种模态的数据,能够更准确地理解和传达信息。

- AI模型:即人工智能模型,是基于机器学习或深度学习算法构建的模型,用于处理和解决各种复杂的任务,如机器翻译、图像识别等。

- 性能提升:指通过各种方法和技术,提高AI模型在特定任务中的表现,如提高翻译的准确性、流畅性和处理速度等。

1.4.2 相关概念解释

- 模态:在信息处理领域,模态指的是信息的表现形式,如文本、图像、音频、视频等。不同的模态包含不同类型的信息,多模态处理就是要综合利用这些不同类型的信息。

- 编码器 - 解码器架构:是一种常见的深度学习模型架构,广泛应用于机器翻译等任务中。编码器将输入的信息进行编码,提取特征;解码器根据编码器输出的特征,生成目标输出。

- 注意力机制:是一种在深度学习中广泛应用的技术,用于在处理序列数据时,动态地关注输入序列中的不同部分。在机器翻译中,注意力机制可以帮助模型更好地捕捉源语言和目标语言之间的对应关系。

1.4.3 缩略词列表

- NLP:Natural Language Processing,自然语言处理

- CNN:Convolutional Neural Network,卷积神经网络

- RNN:Recurrent Neural Network,循环神经网络

- LSTM:Long Short - Term Memory,长短期记忆网络

- GRU:Gated Recurrent Unit,门控循环单元

- Transformer:一种基于注意力机制的深度学习模型架构

2. 核心概念与联系

核心概念原理

多语言多模态机器翻译的核心在于综合处理多种语言和多种模态的信息。从语言处理的角度来看,需要对不同语言的语法、语义和语用进行深入理解和分析。不同语言有着不同的词汇、语法结构和表达方式,模型需要能够准确地捕捉这些差异,并进行有效的转换。

在多模态方面,文本、图像、音频等不同模态的信息具有不同的特征和表达方式。例如,文本信息是基于语言符号的序列,图像信息则是由像素点组成的二维矩阵,音频信息是声音信号的时间序列。模型需要将这些不同模态的信息进行融合,提取出其中的语义信息,并根据目标语言和模态进行转换。

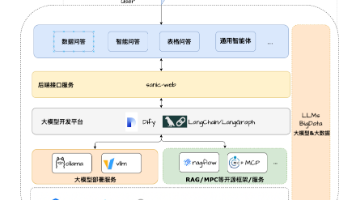

架构的文本示意图

多语言多模态机器翻译系统通常由多个模块组成,包括多模态编码器、语言编码器、解码器和融合模块。

- 多模态编码器:负责对图像、音频等非文本模态的信息进行编码,提取其特征。例如,对于图像信息,可以使用卷积神经网络(CNN)进行特征提取;对于音频信息,可以使用循环神经网络(RNN)或其变体(如LSTM、GRU)进行处理。

- 语言编码器:对输入的文本信息进行编码,将其转换为向量表示。常见的语言编码器包括基于RNN的编码器和基于Transformer的编码器。

- 融合模块:将多模态编码器和语言编码器输出的特征进行融合,得到综合的特征表示。融合的方法可以有多种,如简单的拼接、加权求和等。

- 解码器:根据融合后的特征表示,生成目标语言的输出。解码器可以采用与编码器类似的架构,如RNN或Transformer架构。

Mermaid流程图

graph LR

classDef process fill:#E5F6FF,stroke:#73A6FF,stroke-width:2px;

A(输入: 多语言文本、图像、音频):::process --> B(多模态编码器):::process

A --> C(语言编码器):::process

B --> D(融合模块):::process

C --> D

D --> E(解码器):::process

E --> F(输出: 目标语言文本):::process

3. 核心算法原理 & 具体操作步骤

核心算法原理

在多语言多模态机器翻译中,Transformer架构是一种非常有效的算法。Transformer基于注意力机制,能够更好地捕捉序列中的长距离依赖关系,在机器翻译任务中取得了很好的效果。

Transformer的核心是多头注意力机制(Multi - Head Attention)和前馈神经网络(Feed - Forward Network)。多头注意力机制允许模型在不同的表示子空间中并行地关注输入序列的不同部分,从而提高模型的表达能力。前馈神经网络则对注意力机制的输出进行非线性变换,进一步提取特征。

Python源代码实现

import torch

import torch.nn as nn

import torch.nn.functional as F

# 多头注意力机制

class MultiHeadAttention(nn.Module):

def __init__(self, num_heads, d_model):

super(MultiHeadAttention, self).__init__()

assert d_model % num_heads == 0, "d_model must be divisible by num_heads"

self.num_heads = num_heads

self.d_k = d_model // num_heads

self.W_q = nn.Linear(d_model, d_model)

self.W_k = nn.Linear(d_model, d_model)

self.W_v = nn.Linear(d_model, d_model)

self.W_o = nn.Linear(d_model, d_model)

def forward(self, Q, K, V, mask=None):

batch_size = Q.size(0)

# 线性变换

Q = self.W_q(Q).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)

K = self.W_k(K).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)

V = self.W_v(V).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)

# 计算注意力分数

scores = torch.matmul(Q, K.transpose(-2, -1)) / torch.sqrt(torch.tensor(self.d_k, dtype=torch.float32))

if mask is not None:

scores = scores.masked_fill(mask == 0, -1e9)

# 计算注意力权重

attention_weights = F.softmax(scores, dim=-1)

# 计算输出

output = torch.matmul(attention_weights, V)

output = output.transpose(1, 2).contiguous().view(batch_size, -1, self.num_heads * self.d_k)

output = self.W_o(output)

return output

# 前馈神经网络

class PositionwiseFeedForward(nn.Module):

def __init__(self, d_model, d_ff):

super(PositionwiseFeedForward, self).__init__()

self.fc1 = nn.Linear(d_model, d_ff)

self.fc2 = nn.Linear(d_ff, d_model)

self.relu = nn.ReLU()

def forward(self, x):

return self.fc2(self.relu(self.fc1(x)))

# Transformer编码器层

class EncoderLayer(nn.Module):

def __init__(self, num_heads, d_model, d_ff, dropout):

super(EncoderLayer, self).__init__()

self.self_attn = MultiHeadAttention(num_heads, d_model)

self.feed_forward = PositionwiseFeedForward(d_model, d_ff)

self.norm1 = nn.LayerNorm(d_model)

self.norm2 = nn.LayerNorm(d_model)

self.dropout = nn.Dropout(dropout)

def forward(self, x, mask):

attn_output = self.self_attn(x, x, x, mask)

x = self.norm1(x + self.dropout(attn_output))

ff_output = self.feed_forward(x)

x = self.norm2(x + self.dropout(ff_output))

return x

# Transformer解码器层

class DecoderLayer(nn.Module):

def __init__(self, num_heads, d_model, d_ff, dropout):

super(DecoderLayer, self).__init__()

self.self_attn = MultiHeadAttention(num_heads, d_model)

self.cross_attn = MultiHeadAttention(num_heads, d_model)

self.feed_forward = PositionwiseFeedForward(d_model, d_ff)

self.norm1 = nn.LayerNorm(d_model)

self.norm2 = nn.LayerNorm(d_model)

self.norm3 = nn.LayerNorm(d_model)

self.dropout = nn.Dropout(dropout)

def forward(self, x, enc_output, src_mask, tgt_mask):

attn_output1 = self.self_attn(x, x, x, tgt_mask)

x = self.norm1(x + self.dropout(attn_output1))

attn_output2 = self.cross_attn(x, enc_output, enc_output, src_mask)

x = self.norm2(x + self.dropout(attn_output2))

ff_output = self.feed_forward(x)

x = self.norm3(x + self.dropout(ff_output))

return x

具体操作步骤

- 数据预处理:对输入的多语言文本、图像和音频数据进行预处理。对于文本数据,进行分词、词嵌入等操作;对于图像数据,进行归一化、缩放等操作;对于音频数据,进行特征提取等操作。

- 多模态编码:使用多模态编码器对图像、音频等非文本模态的信息进行编码,使用语言编码器对文本信息进行编码。

- 特征融合:将多模态编码器和语言编码器输出的特征进行融合,得到综合的特征表示。

- 解码生成:使用解码器根据融合后的特征表示,生成目标语言的输出。

- 模型训练:使用标注好的数据集对模型进行训练,调整模型的参数,以提高模型的性能。

4. 数学模型和公式 & 详细讲解 & 举例说明

多头注意力机制的数学模型和公式

多头注意力机制的核心公式如下:

MultiHead ( Q , K , V ) = Concat ( head 1 , ⋯ , head h ) W O \text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, \cdots, \text{head}_h)W^O MultiHead(Q,K,V)=Concat(head1,⋯,headh)WO

其中,

head i = Attention ( Q W i Q , K W i K , V W i V ) \text{head}_i = \text{Attention}(QW_i^Q, KW_i^K, VW_i^V) headi=Attention(QWiQ,KWiK,VWiV)

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

- Q Q Q 是查询矩阵, K K K 是键矩阵, V V V 是值矩阵。

- W i Q W_i^Q WiQ、 W i K W_i^K WiK 和 W i V W_i^V WiV 是线性变换矩阵,用于将输入的 Q Q Q、 K K K 和 V V V 投影到不同的子空间。

- d k d_k dk 是键向量的维度。

- W O W^O WO 是输出的线性变换矩阵。

详细讲解

多头注意力机制通过将输入的 Q Q Q、 K K K 和 V V V 分别投影到多个子空间,并行地计算注意力分数。这样可以让模型在不同的表示子空间中关注输入序列的不同部分,从而提高模型的表达能力。最后,将各个子空间的输出拼接起来,并通过一个线性变换得到最终的输出。

举例说明

假设输入的序列长度为 n n n,特征维度为 d d d。 Q Q Q、 K K K 和 V V V 的形状分别为 [ n , d ] [n, d] [n,d]。我们设置多头注意力机制的头数为 h h h,则每个头的特征维度为 d k = d / h d_k = d / h dk=d/h。

首先,将 Q Q Q、 K K K 和 V V V 分别通过线性变换 W i Q W_i^Q WiQ、 W i K W_i^K WiK 和 W i V W_i^V WiV 投影到 h h h 个子空间,得到 h h h 组 Q Q Q、 K K K 和 V V V。对于每组 Q Q Q、 K K K 和 V V V,计算注意力分数:

scores i = Q i K i T d k \text{scores}_i = \frac{Q_iK_i^T}{\sqrt{d_k}} scoresi=dkQiKiT

然后,对分数进行 softmax 操作,得到注意力权重:

KaTeX parse error: Expected 'EOF', got '_' at position 17: …\text{attention_̲weights}_i = \t…

最后,根据注意力权重对 V V V 进行加权求和,得到每个头的输出:

KaTeX parse error: Expected 'EOF', got '_' at position 33: …\text{attention_̲weights}_iV_i

将 h h h 个头的输出拼接起来,并通过线性变换 W O W^O WO 得到最终的输出:

output = Concat ( head 1 , ⋯ , head h ) W O \text{output} = \text{Concat}(\text{head}_1, \cdots, \text{head}_h)W^O output=Concat(head1,⋯,headh)WO

前馈神经网络的数学模型和公式

前馈神经网络的数学模型可以表示为:

F F N ( x ) = max ( 0 , x W 1 + b 1 ) W 2 + b 2 FFN(x) = \max(0, xW_1 + b_1)W_2 + b_2 FFN(x)=max(0,xW1+b1)W2+b2

- x x x 是输入向量。

- W 1 W_1 W1 和 W 2 W_2 W2 是权重矩阵, b 1 b_1 b1 和 b 2 b_2 b2 是偏置向量。

- max ( 0 , ⋅ ) \max(0, \cdot) max(0,⋅) 是 ReLU 激活函数。

详细讲解

前馈神经网络由两个线性变换和一个 ReLU 激活函数组成。首先,输入向量 x x x 通过第一个线性变换 x W 1 + b 1 xW_1 + b_1 xW1+b1 进行变换,然后通过 ReLU 激活函数引入非线性。最后,通过第二个线性变换得到最终的输出。

举例说明

假设输入向量 x x x 的形状为 [ n , d ] [n, d] [n,d], W 1 W_1 W1 的形状为 [ d , d f f ] [d, d_{ff}] [d,dff], W 2 W_2 W2 的形状为 [ d f f , d ] [d_{ff}, d] [dff,d],其中 d f f d_{ff} dff 是前馈神经网络的隐藏层维度。

首先,计算第一个线性变换的输出:

y 1 = x W 1 + b 1 y_1 = xW_1 + b_1 y1=xW1+b1

然后,对 y 1 y_1 y1 应用 ReLU 激活函数:

y 2 = max ( 0 , y 1 ) y_2 = \max(0, y_1) y2=max(0,y1)

最后,计算第二个线性变换的输出:

output = y 2 W 2 + b 2 \text{output} = y_2W_2 + b_2 output=y2W2+b2

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

- 操作系统:推荐使用 Linux 系统,如 Ubuntu 18.04 或更高版本。

- 编程语言:Python 3.7 或更高版本。

- 深度学习框架:PyTorch 1.7 或更高版本。

- 其他依赖库:NumPy、SciPy、Matplotlib 等。

可以使用以下命令安装所需的库:

pip install torch numpy scipy matplotlib

5.2 源代码详细实现和代码解读

以下是一个简单的多语言多模态机器翻译项目的代码实现:

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import Dataset, DataLoader

# 定义数据集类

class MultiModalDataset(Dataset):

def __init__(self, text_data, image_data, audio_data, target_data):

self.text_data = text_data

self.image_data = image_data

self.audio_data = audio_data

self.target_data = target_data

def __len__(self):

return len(self.text_data)

def __getitem__(self, idx):

text = self.text_data[idx]

image = self.image_data[idx]

audio = self.audio_data[idx]

target = self.target_data[idx]

return text, image, audio, target

# 定义多语言多模态机器翻译模型

class MultiModalTranslationModel(nn.Module):

def __init__(self, num_heads, d_model, d_ff, num_layers, dropout):

super(MultiModalTranslationModel, self).__init__()

# 语言编码器

self.language_encoder = EncoderLayer(num_heads, d_model, d_ff, dropout)

# 多模态编码器

self.multimodal_encoder = EncoderLayer(num_heads, d_model, d_ff, dropout)

# 解码器

self.decoder = DecoderLayer(num_heads, d_model, d_ff, dropout)

# 输出层

self.output_layer = nn.Linear(d_model, vocab_size)

def forward(self, text, image, audio, src_mask, tgt_mask):

# 语言编码

text_encoded = self.language_encoder(text, src_mask)

# 多模态编码

multimodal_encoded = self.multimodal_encoder(torch.cat([image, audio], dim=-1), src_mask)

# 特征融合

fused_features = text_encoded + multimodal_encoded

# 解码

output = self.decoder(fused_features, fused_features, src_mask, tgt_mask)

# 输出层

output = self.output_layer(output)

return output

# 训练模型

def train_model(model, dataloader, criterion, optimizer, num_epochs):

model.train()

for epoch in range(num_epochs):

total_loss = 0

for text, image, audio, target in dataloader:

optimizer.zero_grad()

src_mask = None

tgt_mask = None

output = model(text, image, audio, src_mask, tgt_mask)

loss = criterion(output.view(-1, vocab_size), target.view(-1))

loss.backward()

optimizer.step()

total_loss += loss.item()

print(f'Epoch {epoch + 1}/{num_epochs}, Loss: {total_loss / len(dataloader)}')

# 示例数据

text_data = torch.randn(100, 10, 512)

image_data = torch.randn(100, 10, 512)

audio_data = torch.randn(100, 10, 512)

target_data = torch.randint(0, 1000, (100, 10))

# 数据集和数据加载器

dataset = MultiModalDataset(text_data, image_data, audio_data, target_data)

dataloader = DataLoader(dataset, batch_size=10, shuffle=True)

# 模型参数

num_heads = 8

d_model = 512

d_ff = 2048

num_layers = 6

dropout = 0.1

vocab_size = 1000

# 模型、损失函数和优化器

model = MultiModalTranslationModel(num_heads, d_model, d_ff, num_layers, dropout)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.0001)

# 训练模型

train_model(model, dataloader, criterion, optimizer, num_epochs=10)

代码解读与分析

- 数据集类

MultiModalDataset:用于封装多语言多模态的数据,包括文本、图像、音频和目标数据。通过__len__方法返回数据集的长度,通过__getitem__方法根据索引返回相应的数据样本。 - 多语言多模态机器翻译模型

MultiModalTranslationModel:language_encoder:对输入的文本进行编码。multimodal_encoder:对输入的图像和音频进行编码。decoder:根据编码后的特征生成目标语言的输出。output_layer:将解码器的输出映射到词汇表大小的维度。

- 训练函数

train_model:- 对模型进行训练,迭代多个 epoch。

- 在每个 epoch 中,遍历数据加载器中的所有数据样本。

- 计算模型的输出和损失,并进行反向传播和参数更新。

- 示例数据:生成随机的文本、图像、音频和目标数据,用于演示训练过程。

- 模型参数:设置多头注意力机制的头数、模型的维度、前馈神经网络的隐藏层维度、层数和 dropout 率等参数。

- 模型、损失函数和优化器:创建模型实例,使用交叉熵损失函数和 Adam 优化器进行训练。

6. 实际应用场景

跨语言视频翻译

在全球化的背景下,视频内容的传播跨越了语言的障碍。多语言多模态机器翻译技术可以用于跨语言视频翻译,将视频中的语音和文字信息翻译成不同的语言。通过结合视频中的图像、音频和文本信息,能够更准确地理解视频的内容,并生成高质量的翻译结果。例如,在国际会议、在线课程、电影等领域,跨语言视频翻译可以让不同语言的观众更好地理解视频内容。

智能客服系统

智能客服系统需要处理来自不同语言用户的咨询和问题。多语言多模态机器翻译技术可以帮助智能客服系统理解不同语言的用户输入,并以用户熟悉的语言进行回复。同时,结合用户的语音、图像等多模态信息,能够更准确地理解用户的意图,提供更个性化的服务。例如,在电商平台、银行、航空公司等领域的智能客服系统中,多语言多模态机器翻译技术可以提高客户服务的效率和质量。

跨境电商

跨境电商涉及到不同国家和地区的商家和消费者,语言障碍是一个重要的问题。多语言多模态机器翻译技术可以用于商品信息的翻译、客服沟通等方面。通过将商品的描述、图片等信息翻译成不同的语言,能够吸引更多的国际客户。同时,在客服沟通中,实时翻译可以帮助商家和消费者更好地交流,促进交易的达成。

国际新闻报道

国际新闻报道需要及时、准确地将世界各地的新闻信息传递给不同语言的读者。多语言多模态机器翻译技术可以用于新闻文章的翻译,同时结合新闻中的图片、视频等多模态信息,能够更生动地呈现新闻内容。例如,在新闻网站、电视台等媒体中,多语言多模态机器翻译技术可以提高新闻的传播范围和影响力。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《深度学习》(Deep Learning):由 Ian Goodfellow、Yoshua Bengio 和 Aaron Courville 合著,是深度学习领域的经典教材,涵盖了深度学习的基本概念、算法和应用。

- 《自然语言处理入门》(Natural Language Processing with Python):由 Steven Bird、Ewan Klein 和 Edward Loper 合著,介绍了自然语言处理的基本技术和方法,使用 Python 语言进行实现。

- 《多模态机器学习:基础与应用》(Multimodal Machine Learning: A Survey and Taxonomy):全面介绍了多模态机器学习的理论和方法,适合对多模态领域感兴趣的读者。

7.1.2 在线课程

- Coursera 上的 “深度学习专项课程”(Deep Learning Specialization):由 Andrew Ng 教授授课,涵盖了深度学习的各个方面,包括神经网络、卷积神经网络、循环神经网络等。

- edX 上的 “自然语言处理”(Natural Language Processing):由 Carnegie Mellon University 提供,介绍了自然语言处理的基本概念、算法和应用。

- Udemy 上的 “多模态机器学习实战”(Multimodal Machine Learning in Practice):通过实际案例介绍多模态机器学习的应用和实现。

7.1.3 技术博客和网站

- arXiv:是一个开放获取的学术预印本平台,提供了大量关于人工智能、机器学习等领域的最新研究成果。

- Medium:有许多技术博客和文章,涵盖了深度学习、自然语言处理、多模态机器学习等领域的技术和应用。

- Towards Data Science:专注于数据科学和机器学习领域的技术博客,提供了许多实用的教程和案例。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:是一款专门为 Python 开发设计的集成开发环境,提供了丰富的功能,如代码调试、代码分析、版本控制等。

- Jupyter Notebook:是一个交互式的开发环境,适合进行数据分析、模型训练和实验。可以在浏览器中直接编写和运行代码,并展示代码的运行结果。

- Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言,具有丰富的插件和扩展功能。

7.2.2 调试和性能分析工具

- TensorBoard:是 TensorFlow 提供的一个可视化工具,用于监控模型的训练过程、可视化模型的结构和性能指标等。

- PyTorch Profiler:是 PyTorch 提供的一个性能分析工具,用于分析模型的性能瓶颈,找出耗时的操作和模块。

- NVIDIA Nsight Systems:是 NVIDIA 提供的一个性能分析工具,用于分析 GPU 上的程序性能,找出 GPU 利用率低的原因。

7.2.3 相关框架和库

- PyTorch:是一个开源的深度学习框架,具有动态图机制,易于使用和调试。提供了丰富的深度学习模型和工具,如神经网络、优化器、损失函数等。

- TensorFlow:是一个广泛使用的深度学习框架,具有静态图机制,适合大规模分布式训练。提供了丰富的深度学习模型和工具,如 TensorFlow Hub、TensorFlow Datasets 等。

- Transformers:是 Hugging Face 开发的一个开源库,提供了预训练的 Transformer 模型,如 BERT、GPT - 2 等,方便进行自然语言处理任务。

7.3 相关论文著作推荐

7.3.1 经典论文

- “Attention Is All You Need”:提出了 Transformer 架构,是自然语言处理领域的经典论文,为后续的研究和应用奠定了基础。

- “Neural Machine Translation by Jointly Learning to Align and Translate”:提出了基于注意力机制的神经机器翻译模型,提高了机器翻译的性能。

- “Multimodal Learning with Deep Boltzmann Machines”:介绍了使用深度玻尔兹曼机进行多模态学习的方法,是多模态机器学习领域的早期工作。

7.3.2 最新研究成果

- 关注 arXiv 上关于多语言多模态机器翻译的最新论文,了解该领域的最新研究进展和技术方法。

- 参加国际学术会议,如 ACL(Association for Computational Linguistics)、EMNLP(Conference on Empirical Methods in Natural Language Processing)等,获取最新的研究成果和趋势。

7.3.3 应用案例分析

- 分析一些实际应用中的多语言多模态机器翻译案例,了解该技术在不同领域的应用场景和实现方法。可以参考一些技术博客、企业报告和学术论文中的案例分析。

8. 总结:未来发展趋势与挑战

未来发展趋势

- 融合更多模态信息:未来的多语言多模态机器翻译模型将融合更多类型的模态信息,如触觉、嗅觉等,以更全面地理解和传达信息。例如,在虚拟现实和增强现实场景中,结合触觉和视觉信息进行翻译,能够提供更加沉浸式的体验。

- 零样本和少样本学习:随着数据收集的难度和成本增加,零样本和少样本学习将成为多语言多模态机器翻译的重要发展方向。模型需要能够在少量或没有标注数据的情况下,进行有效的翻译。

- 跨领域和跨任务应用:多语言多模态机器翻译技术将不仅仅局限于传统的翻译任务,还将应用于更多的跨领域和跨任务场景,如智能医疗、智能家居等。例如,在智能医疗中,翻译医疗图像、病历和语音信息,帮助医生进行跨国诊断。

挑战

- 数据获取和标注:多语言多模态数据的获取和标注是一个巨大的挑战。不同模态的数据具有不同的特点和格式,需要专门的工具和方法进行收集和处理。同时,标注多模态数据需要专业的知识和技能,成本较高。

- 模型复杂度和计算资源:随着模型融合的模态信息增多,模型的复杂度也会相应增加。这将导致模型的训练和推理需要更多的计算资源和时间,对硬件设备提出了更高的要求。

- 语义理解和融合:不同模态的信息具有不同的语义表示,如何有效地将这些语义信息进行融合,是多语言多模态机器翻译面临的一个重要挑战。需要开发更加先进的语义理解和融合技术,提高模型的性能。

9. 附录:常见问题与解答

问题1:多语言多模态机器翻译模型的训练时间通常需要多久?

训练时间取决于多个因素,如模型的复杂度、数据集的大小、硬件设备的性能等。一般来说,使用中等规模的数据集和普通的 GPU 设备,训练一个多语言多模态机器翻译模型可能需要几天到几周的时间。如果使用更大的数据集和更强大的硬件设备,训练时间可能会更长。

问题2:如何评估多语言多模态机器翻译模型的性能?

可以使用多种指标来评估多语言多模态机器翻译模型的性能,如 BLEU 分数、METEOR 分数、ROUGE 分数等。这些指标主要用于评估翻译结果的准确性和流畅性。此外,还可以进行人工评估,让专业的翻译人员对翻译结果进行评价。

问题3:多语言多模态机器翻译模型是否可以处理实时翻译任务?

目前,大多数多语言多模态机器翻译模型在处理实时翻译任务时还存在一定的挑战。由于模型的复杂度和计算资源的限制,模型的推理速度可能较慢,无法满足实时翻译的要求。但是,随着技术的不断发展,一些优化方法和硬件加速技术可以提高模型的推理速度,使得实时翻译成为可能。

问题4:如何处理多语言多模态数据中的噪声和缺失值?

对于多语言多模态数据中的噪声和缺失值,可以采用以下方法进行处理:

- 数据清洗:对数据进行预处理,去除噪声和异常值。

- 插值和填充:对于缺失值,可以使用插值方法进行填充,如均值插值、中位数插值等。

- 模型鲁棒性设计:在模型设计中,考虑数据的噪声和缺失值,提高模型的鲁棒性。

10. 扩展阅读 & 参考资料

- Vaswani, A., Shazeer, N., Parmar, N., et al. (2017). Attention Is All You Need. Advances in Neural Information Processing Systems.

- Bahdanau, D., Cho, K., & Bengio, Y. (2014). Neural Machine Translation by Jointly Learning to Align and Translate. arXiv preprint arXiv:1409.0473.

- Ngiam, J., Khosla, A., Kim, M., et al. (2011). Multimodal Deep Learning. Proceedings of the 28th International Conference on Machine Learning.

- Hugging Face. Transformers: State - of - the - art Natural Language Processing. https://huggingface.co/

- PyTorch. Deep learning for research and production. https://pytorch.org/

- TensorFlow. An end - to - end open source machine learning platform. https://www.tensorflow.org/

更多推荐

已为社区贡献48条内容

已为社区贡献48条内容

所有评论(0)