零基础教程:手把手教你在本地部署DeepSeek-R1大模型

想体验最新的大模型,但苦于没有API密钥?担心隐私泄露,不希望对话数据被上传到云端?想要无限次免费使用AI助手,不受使用次数限制?今天,我将教你通过两个简单的工具,在本地电脑上部署DeepSeek-R1大模型,彻底解决以上问题!通过本教程,你已经成功在本地部署了属于自己的AI助手!这不仅让你能够免费、私密地使用大模型,更为你打开了通向AI世界的大门。现在,你可以:✅ 无限次免费与AI对话✅ 在断网

零基础教程:手把手教你在本地部署DeepSeek-R1大模型

无需编程基础,只需跟着步骤操作,就能在个人电脑上运行属于自己的AI助手

前言

作为一名AI爱好者,你是否曾经:

- 想体验最新的大模型,但苦于没有API密钥?

- 担心隐私泄露,不希望对话数据被上传到云端?

- 想要无限次免费使用AI助手,不受使用次数限制?

今天,我将教你通过两个简单的工具,在本地电脑上部署DeepSeek-R1大模型,彻底解决以上问题!

准备工作:认识两大核心工具

1. Ollama - 模型运行引擎

Ollama是一个专门用于在本地运行大语言模型的框架,它简化了模型的下载、管理和运行过程,让普通用户也能轻松使用。

2. Cherry Studio - 可视化操作界面

Cherry Studio提供了一个类似ChatGPT的图形化界面,让你可以通过点击和输入与AI交互,告别复杂的命令行操作。

工作流程示意图:

[用户输入] → [Cherry Studio界面] → [Ollama引擎] → [DeepSeek-R1模型] → [返回回答]

详细部署步骤

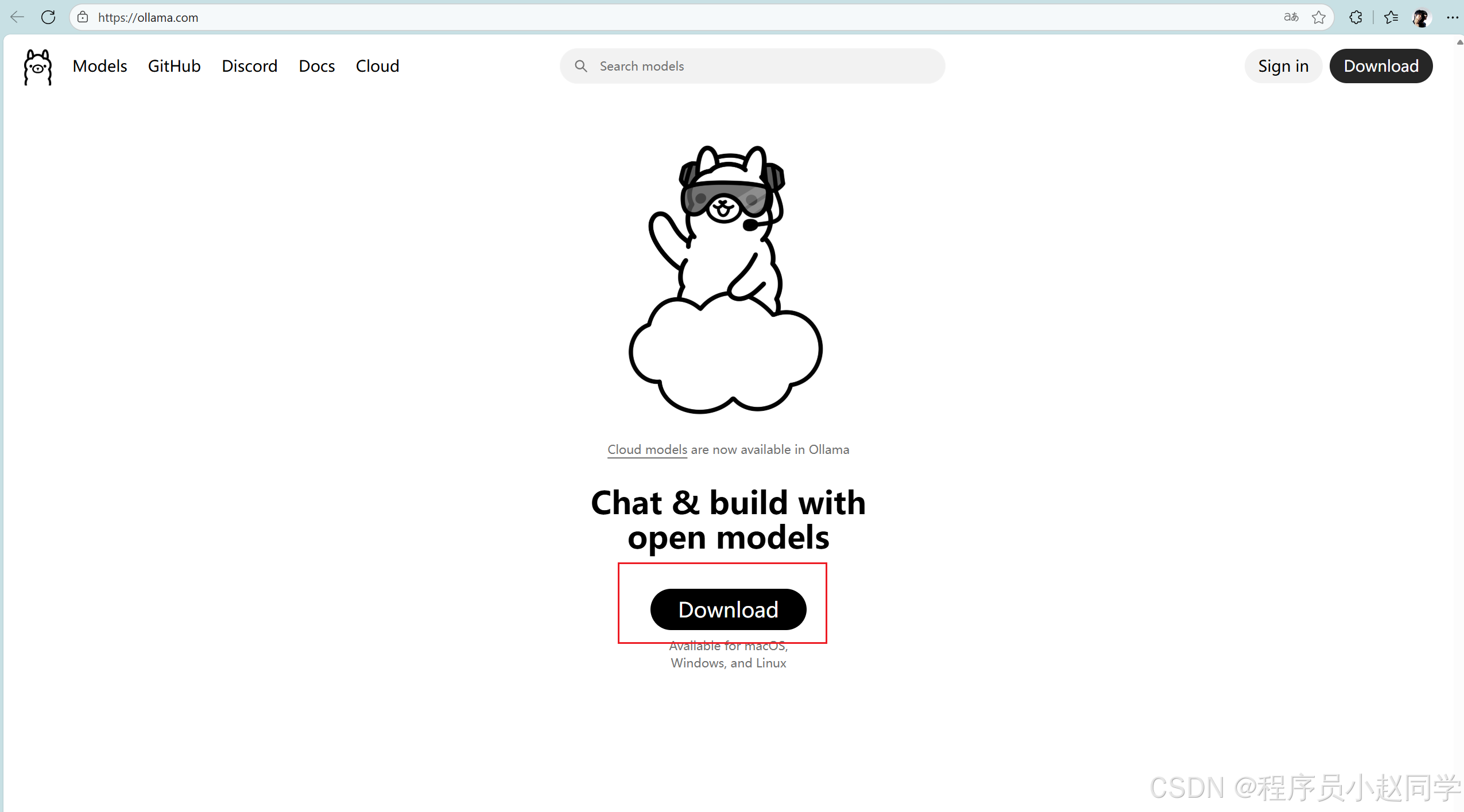

第一步:安装Ollama模型引擎

- 访问官网下载

打开浏览器,访问 Ollama官网,点击首页的"Download"按钮。

- 安装软件

下载完成后,双击安装包,按照提示完成安装。这个过程与安装QQ、微信等普通软件完全相同。(一直点击下一步就行)

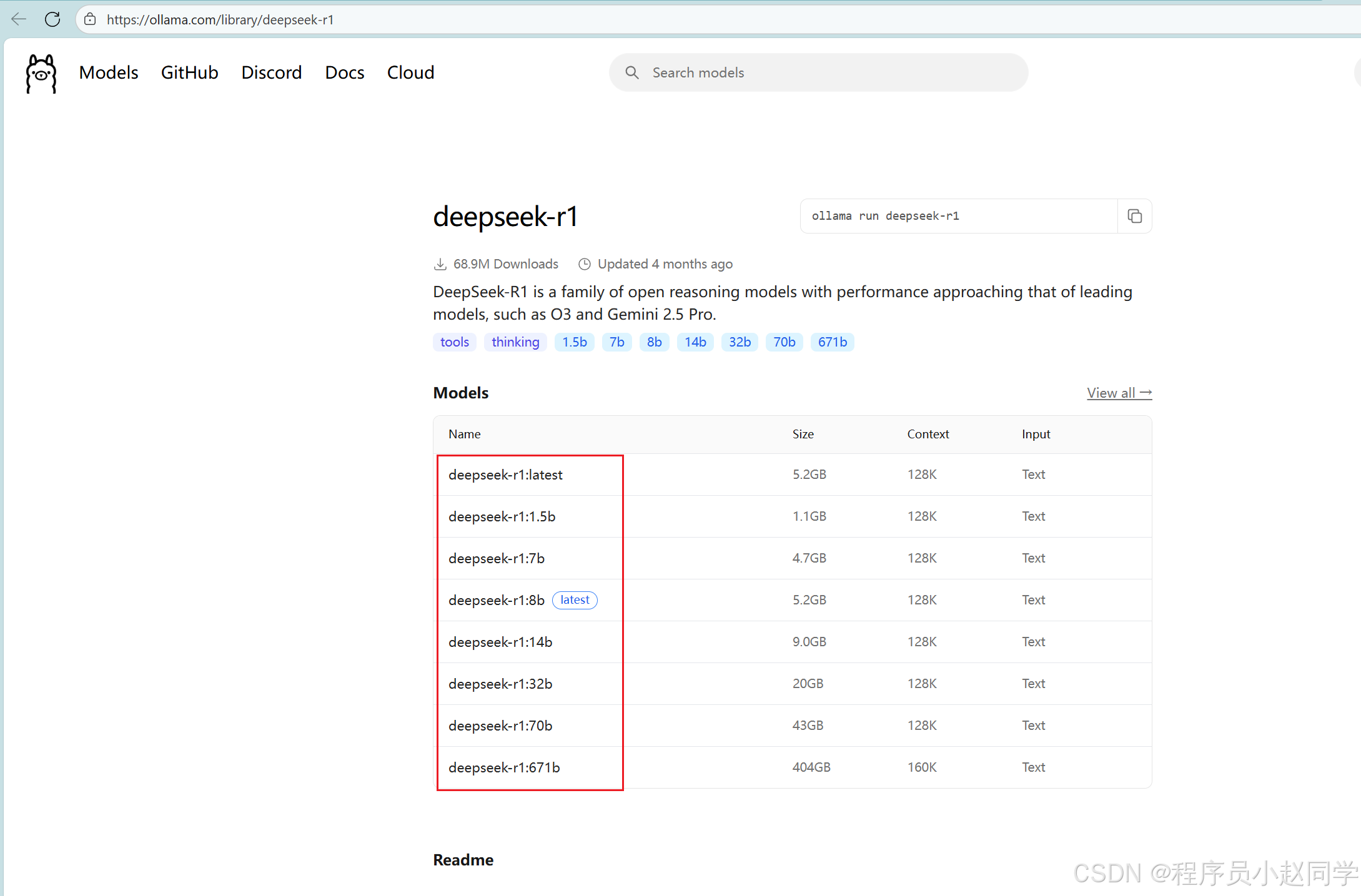

第二步:选择适合的模型版本

-

打开模型库

访问 DeepSeek-R1模型页面 -

理解模型版本

在模型下拉框中,你会看到多个版本,数字代表参数数量:- 1.5B:15亿参数,适合入门和低配置电脑(电脑较差选这个)

- 7B:70亿参数,平衡性能和资源消耗(16G和32G电脑一般选这个就行)

- 更大版本:能力更强,但对硬件要求更高

-

硬件配置建议

模型版本 推荐内存 适用场景 1.5B/2B 8GB以上 学习体验、简单对话 7B 16GB以上 复杂任务、编程辅助 67B 32GB以上 专业用途、高质量输出 -

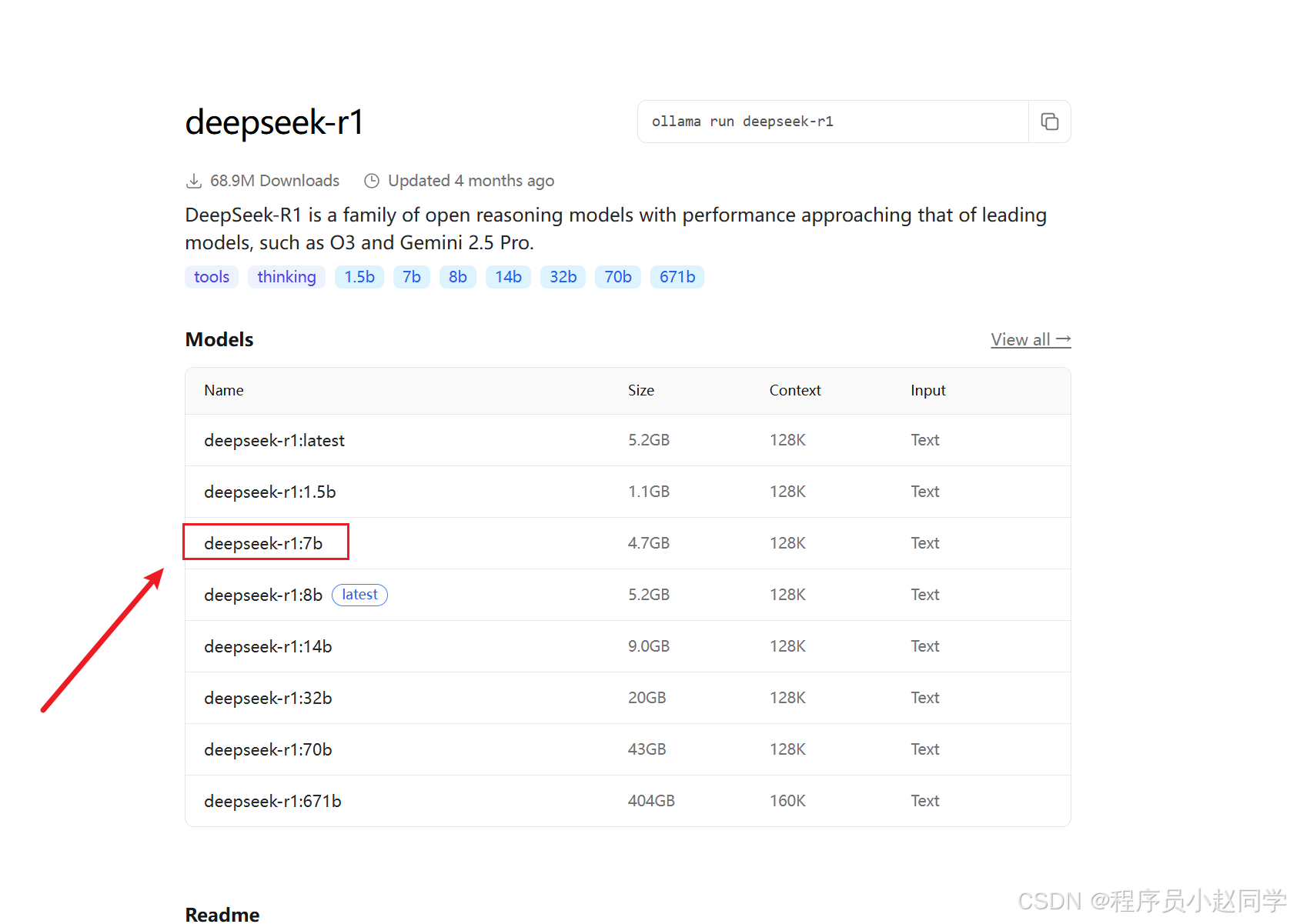

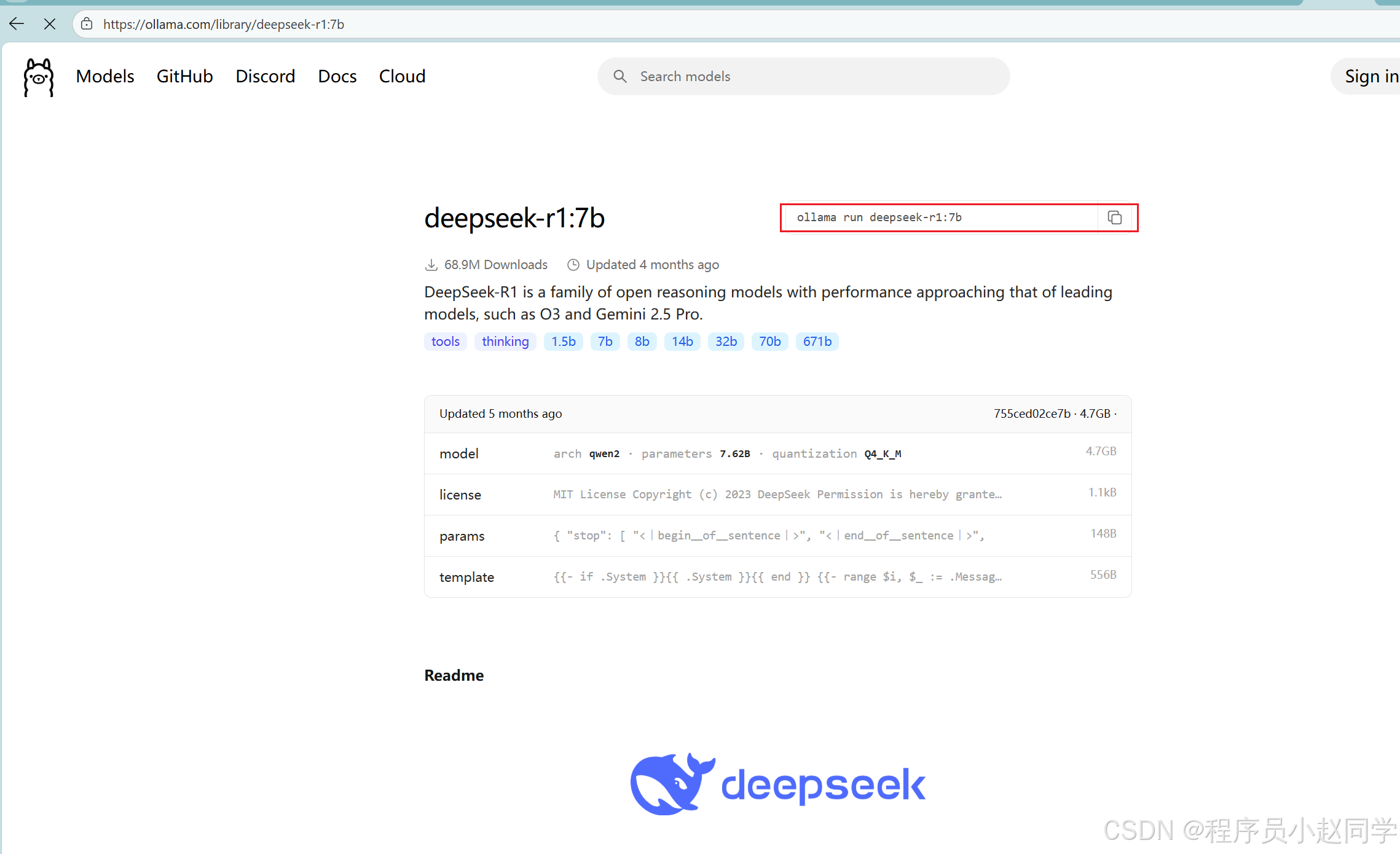

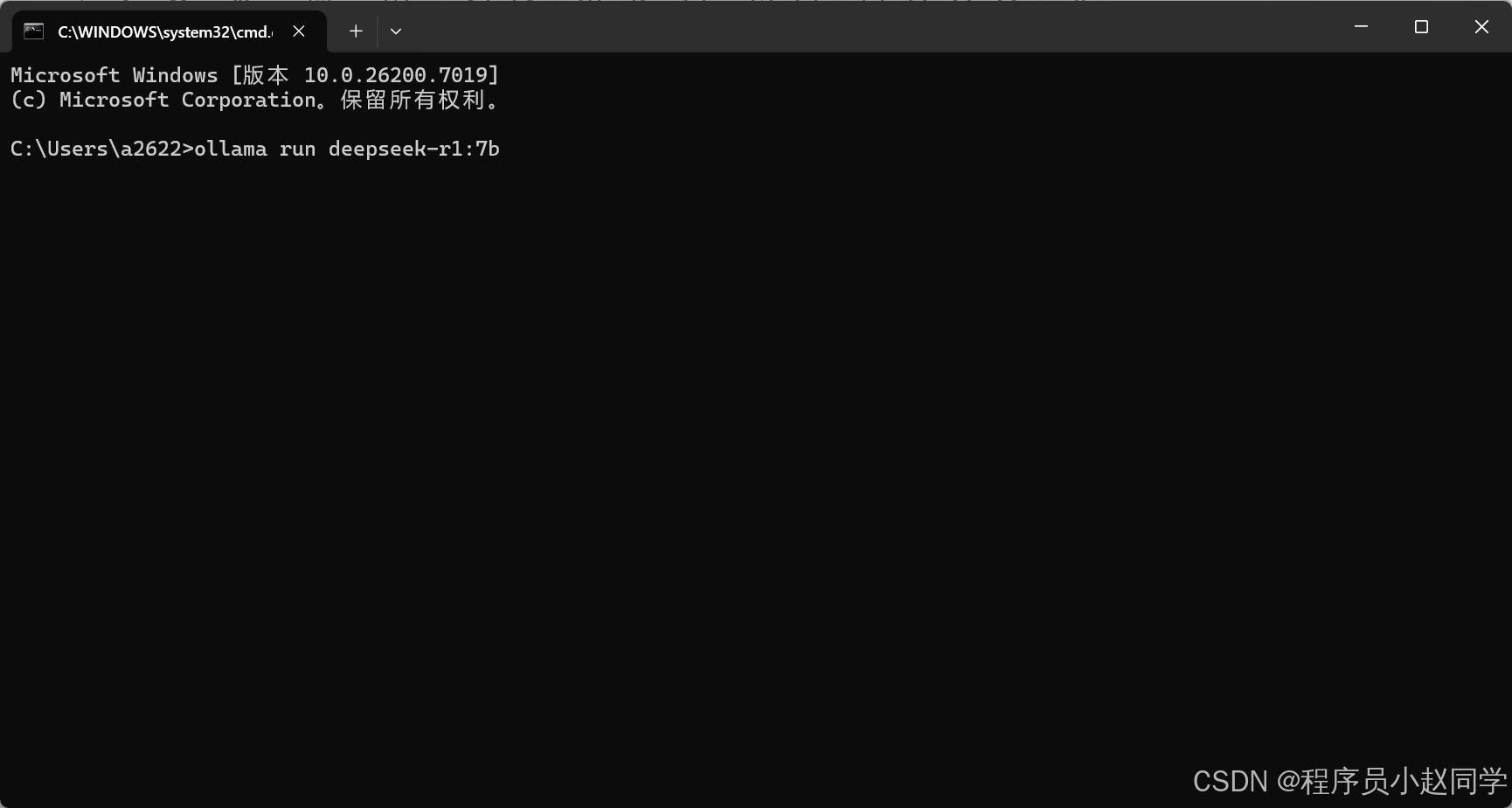

复制运行命令

1、先选择一个版本,点击版本名称。

2、在页面右侧找到并复制命令:ollama run deepseek-r1:1.5b

第三步:通过命令行安装模型

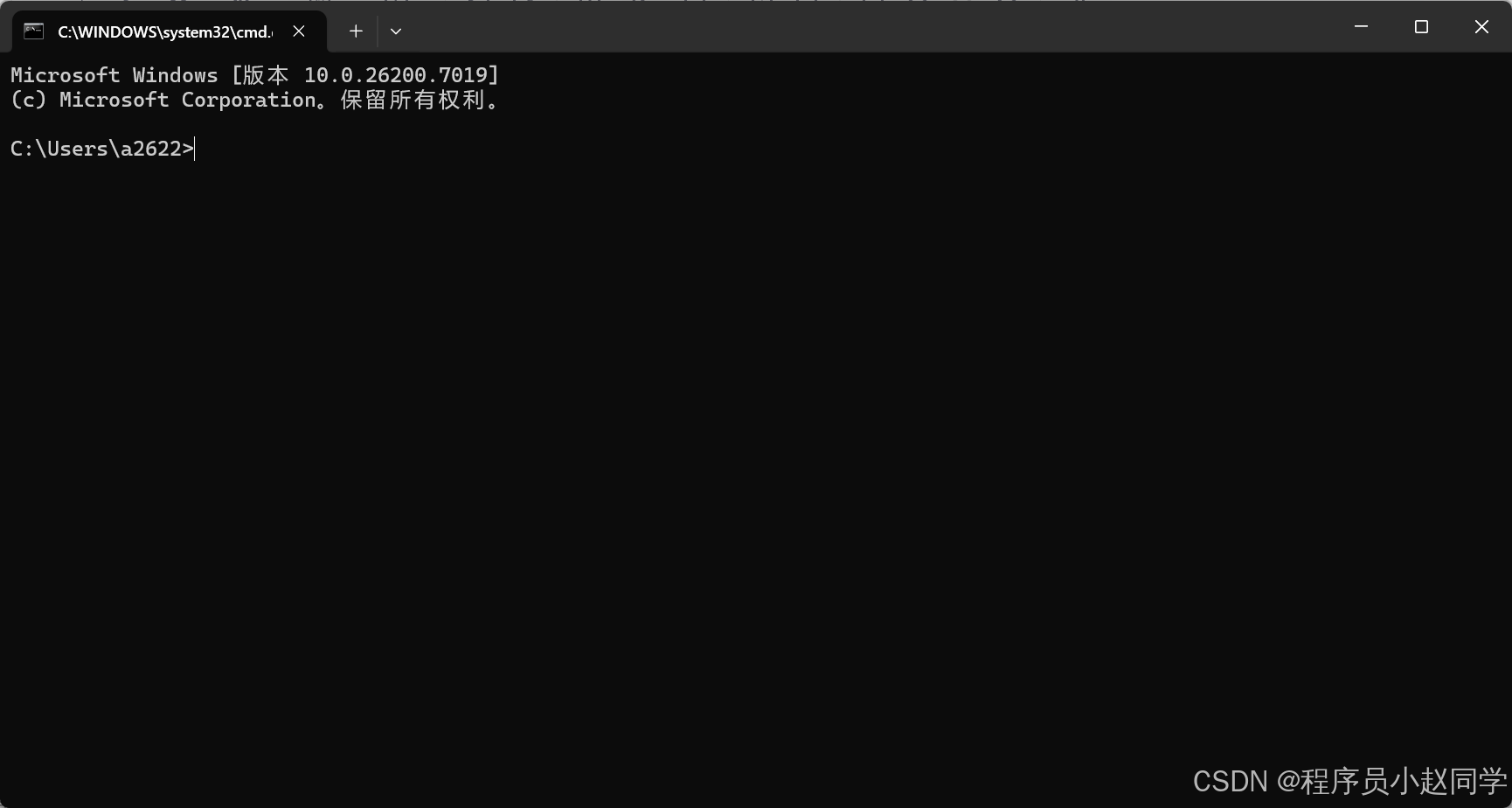

- 打开命令提示符

- 按下

Win + R键(Windows系统) - 输入

cmd - 按回车键

- 按下

-

安装模型

- 在命令提示符窗口中右键点击,选择"粘贴"

- 或者直接按

Ctrl + V粘贴命令 - 按回车键开始安装

-

等待安装完成

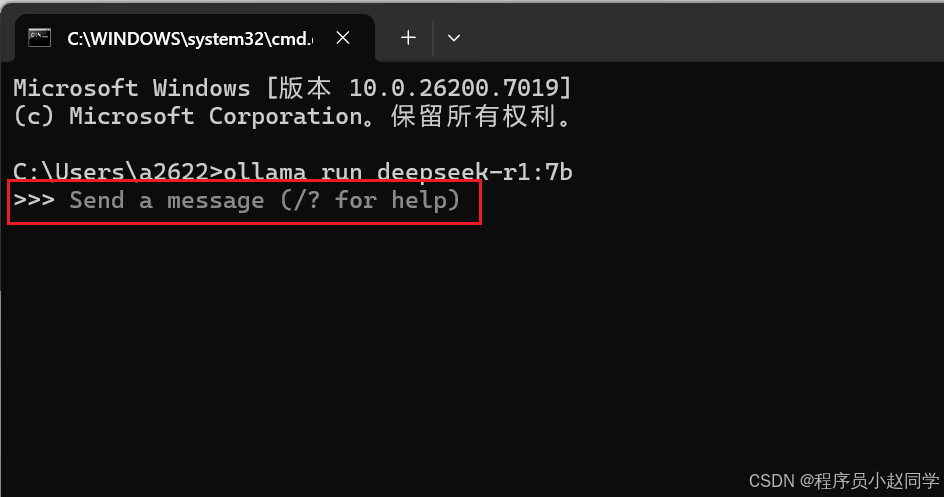

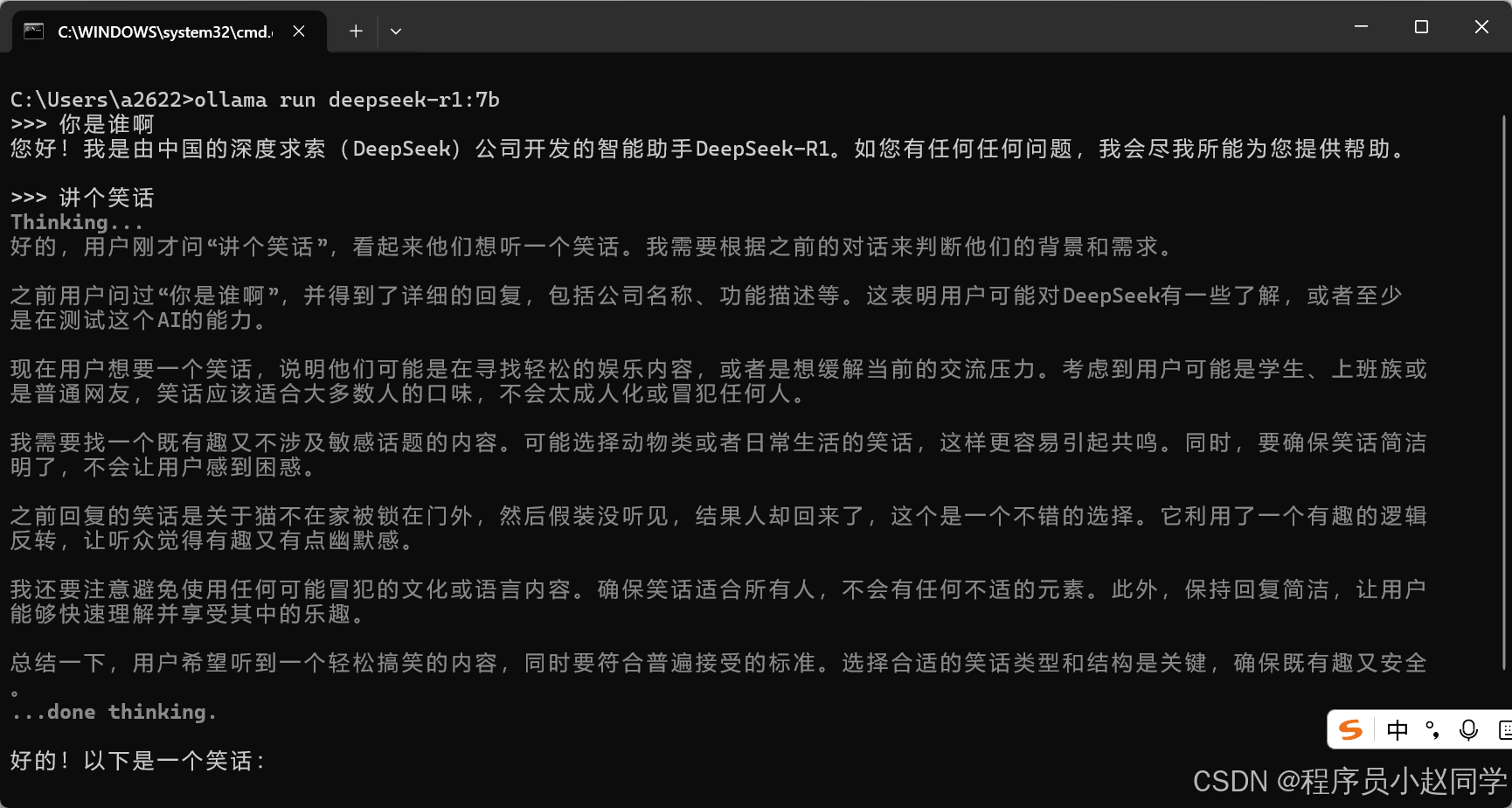

你会看到显示下载进度的百分比条,等待其达到100%即表示安装成功。下载完成就可以在这里和模型进行对话了

-

测试对话

安装完成后,会自动进入对话模式,尝试输入:“你好,请介绍一下你自己”,看看AI的回答吧!

第四步:安装可视化界面(强烈推荐)

为了帮你清晰地了解 Ollama 可视化界面(通常指 Open WebUI)和 Cherry Studio 的区别,下面这个表格从核心定位、模型支持、功能特性等角度进行了梳理。

| 维度 | Ollama Open WebUI | Cherry Studio |

|---|---|---|

| 核心定位 | 专注于为本地Ollama模型提供轻量、纯粹的Web交互界面 | 多功能聚合型AI桌面客户端,整合云端与本地模型 |

| 与Ollama关系 | Ollama的官方推荐WebUI,深度集成,几乎无需配置 | 将Ollama作为其支持的众多模型源之一 |

| 模型支持 | 主要支持本地Ollama模型,也可配置接入兼容OpenAI API的模型 | 支持40+家主流云端模型(如OpenAI, Gemini, Claude)和本地模型(如Ollama) |

| 核心功能 | 提供基础的对话、上下文管理、模型选择 | 除对话外,还提供知识库(基于文档的问答)、联网搜索、自定义AI助手等 |

| 数据与隐私 | 自托管,数据完全在本地 | 使用云端模型时数据流向对应服务商;使用本地Ollama时,对话数据本地处理 |

| 适用场景 | 希望快速、简单地与本地Ollama模型交互;隐私要求极高,所有操作需离线完成 | 需要频繁切换和对比不同云端和本地模型;工作流需要知识库、联网搜索等高级功能 |

💡 如何选择

你可以根据以下场景来判断哪款工具更适合你:

-

选择 Ollama Open WebUI,如果你的需求是:

- 只想专注于本地运行的Ollama模型,追求最简单、直接的对话体验。

- 希望部署流程足够轻量和快速,对高级功能没有要求。

- 非常看重极致的隐私安全,要求整个应用栈(模型+界面)完全运行在本地离线环境。

-

选择 Cherry Studio,如果你的需求是:

- 需要一个 “全能型工作站” ,既能用本地Ollama模型,也要方便地调用各种云端API。

- 你的工作严重依赖基于文档的问答(RAG),需要强大的知识库管理功能。

- 你是一个AI爱好者或重度用户,喜欢探索不同模型的特点,并需要联网搜索、自定义助手等增强功能。

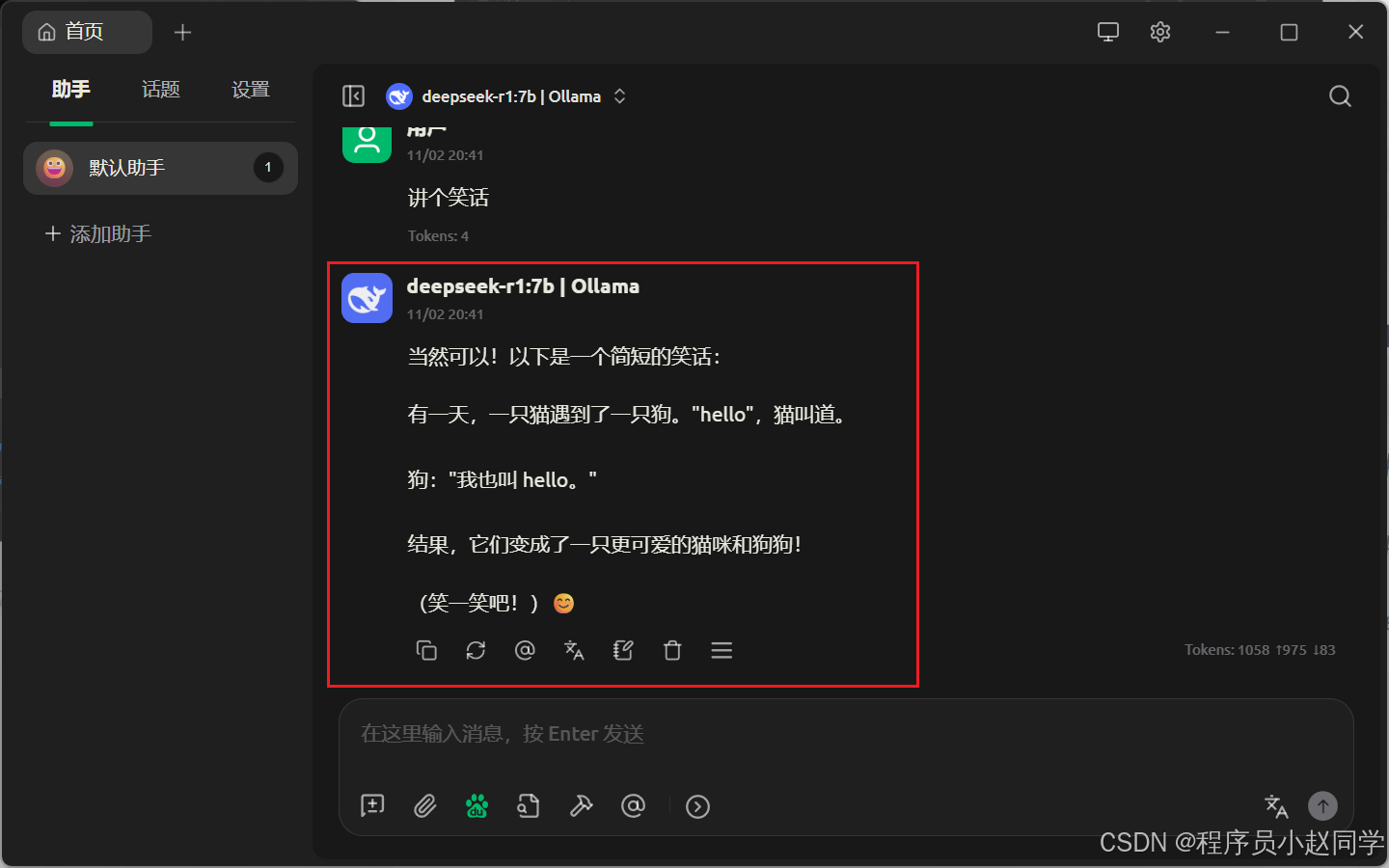

ollama可视化界面

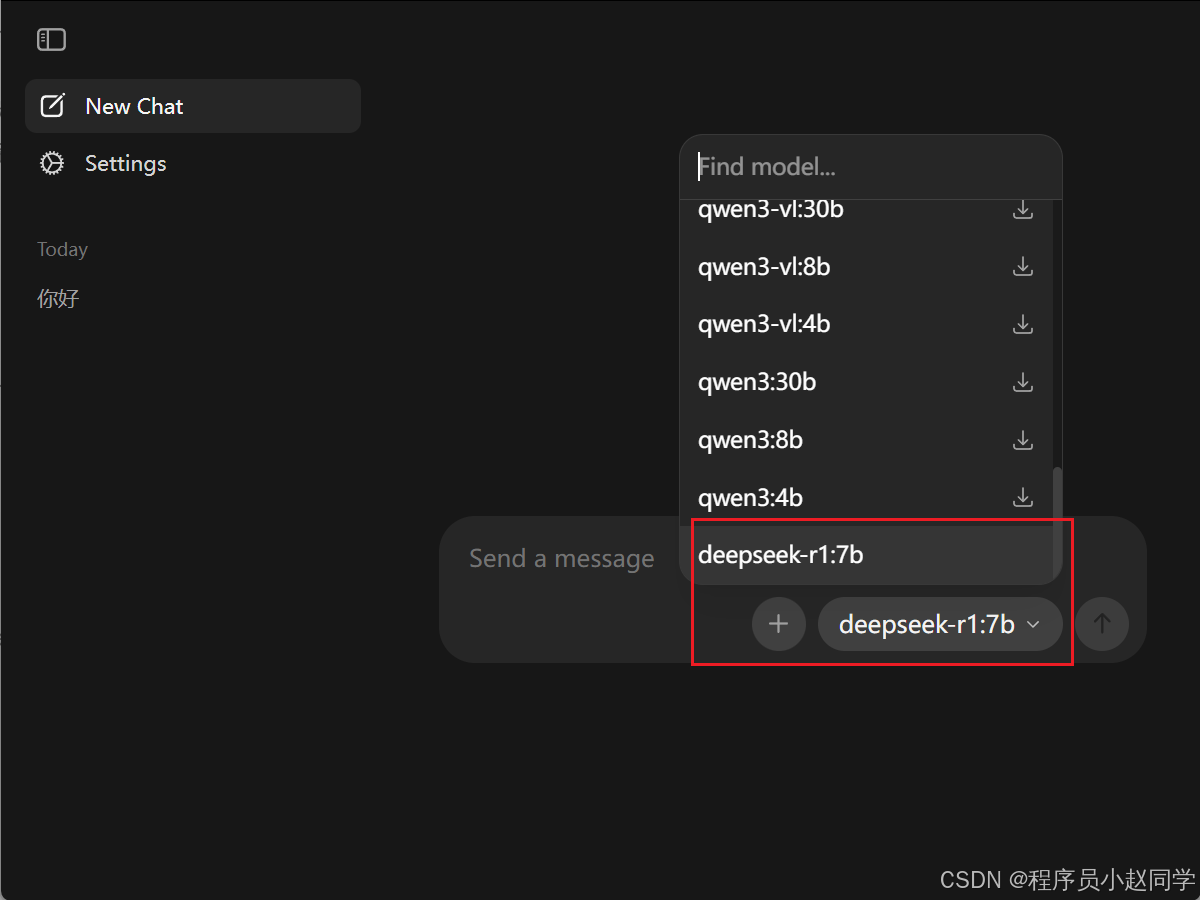

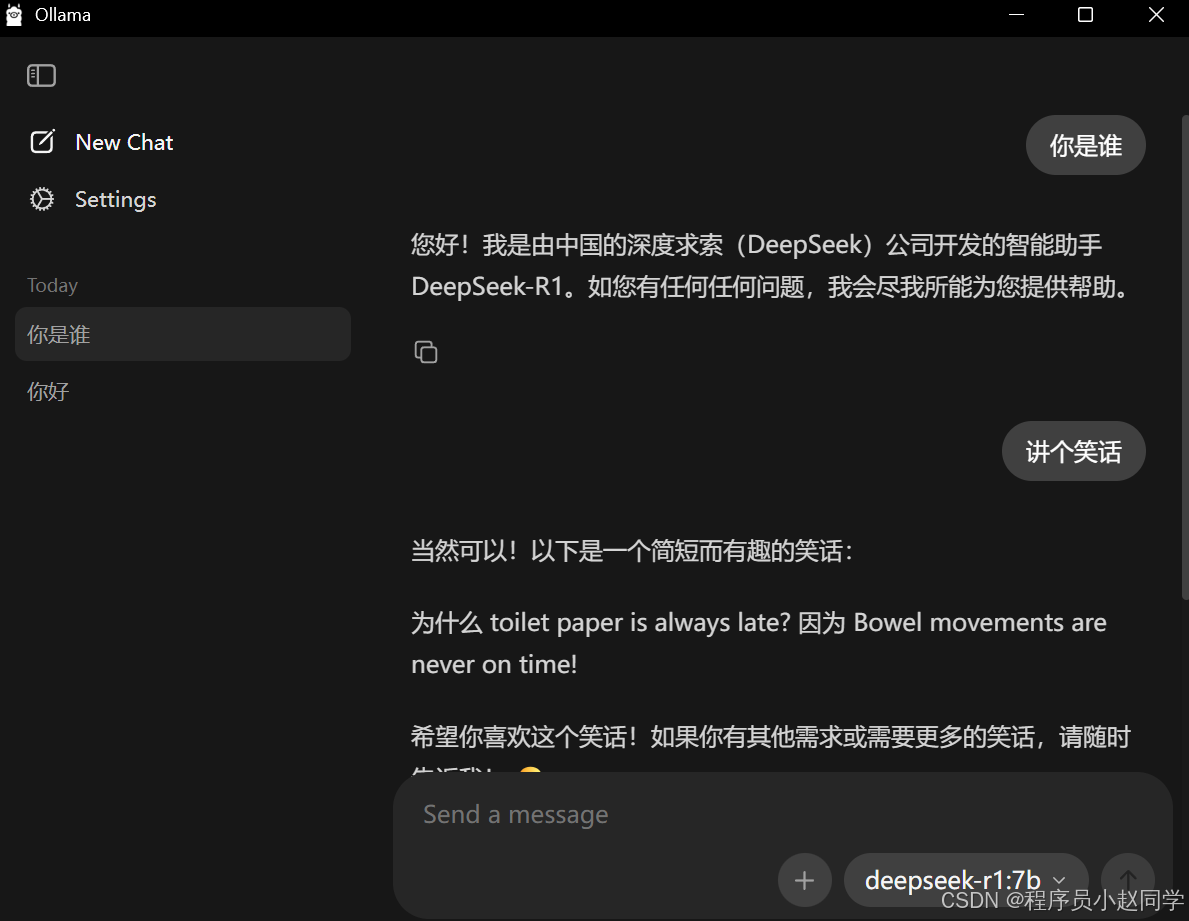

- 选择模型

经过上面的安装之后,就可以在ollama选择刚刚下载的大模型了。

可以看到,其他模型都需要下载 ,而我们刚刚在命令行下载的7b的模型,是可以直接使用的。 - 对话

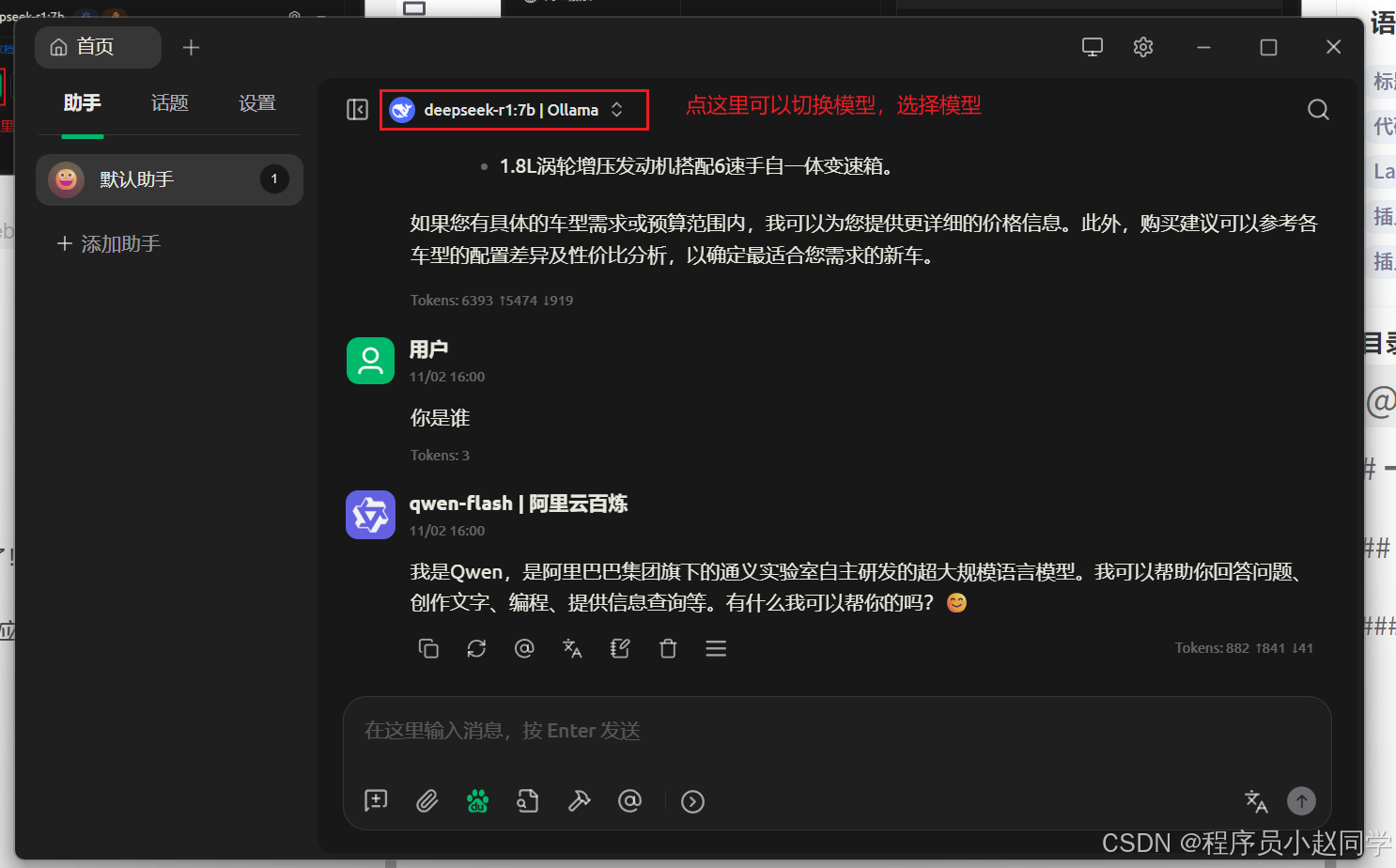

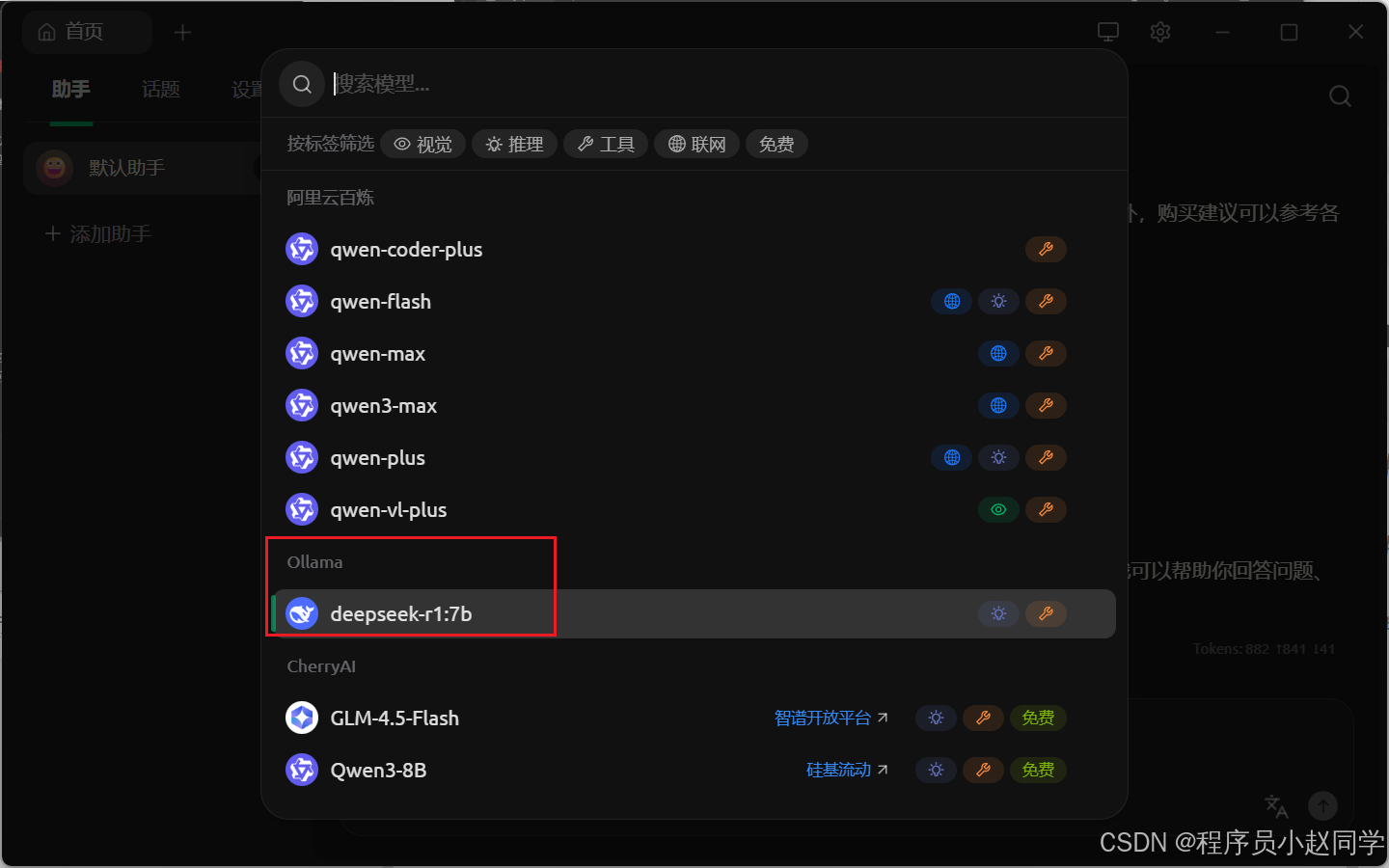

Cherry Studio可视化界面

-

下载Cherry Studio

访问 Cherry Studio下载页面,下载并安装软件。 -

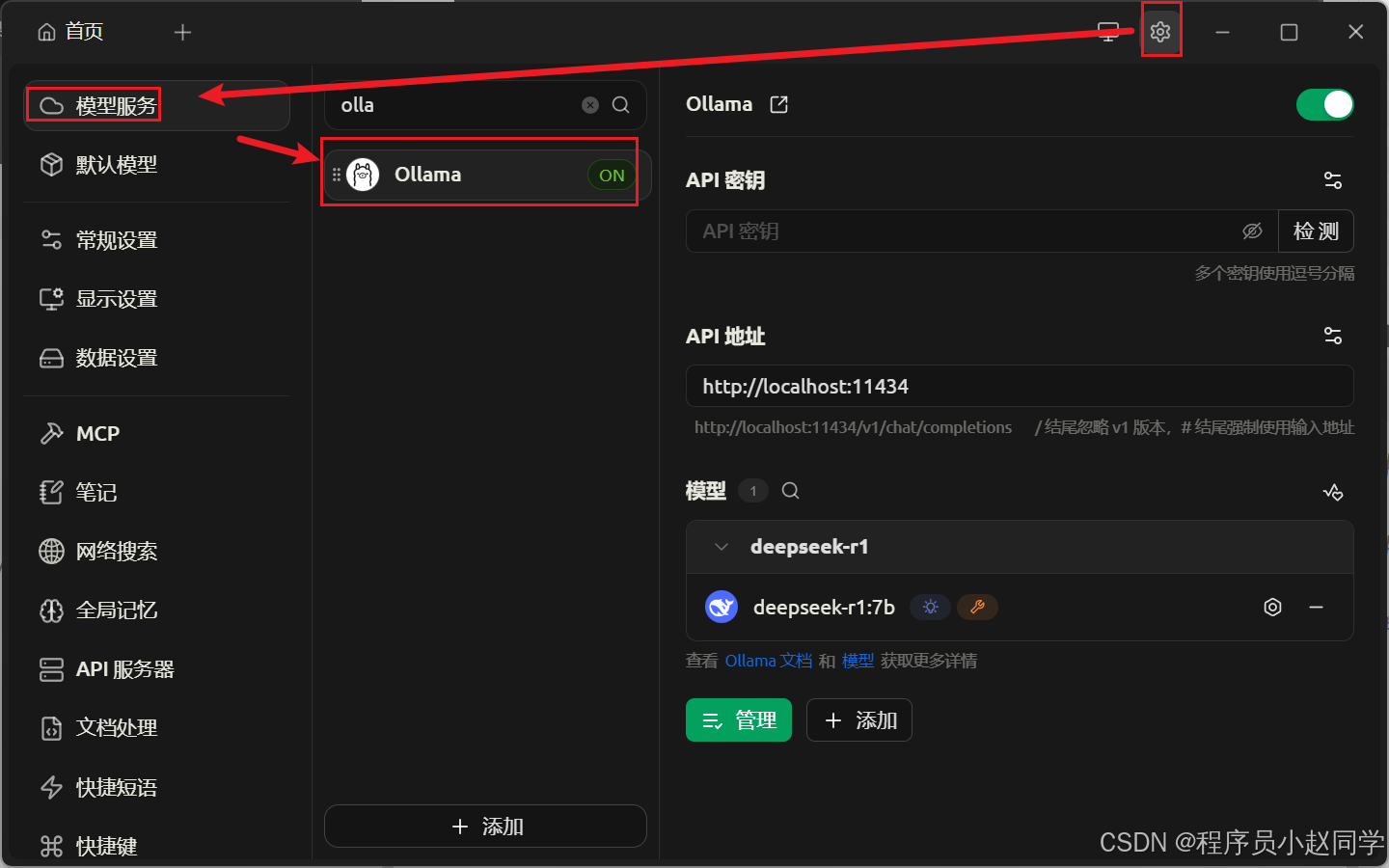

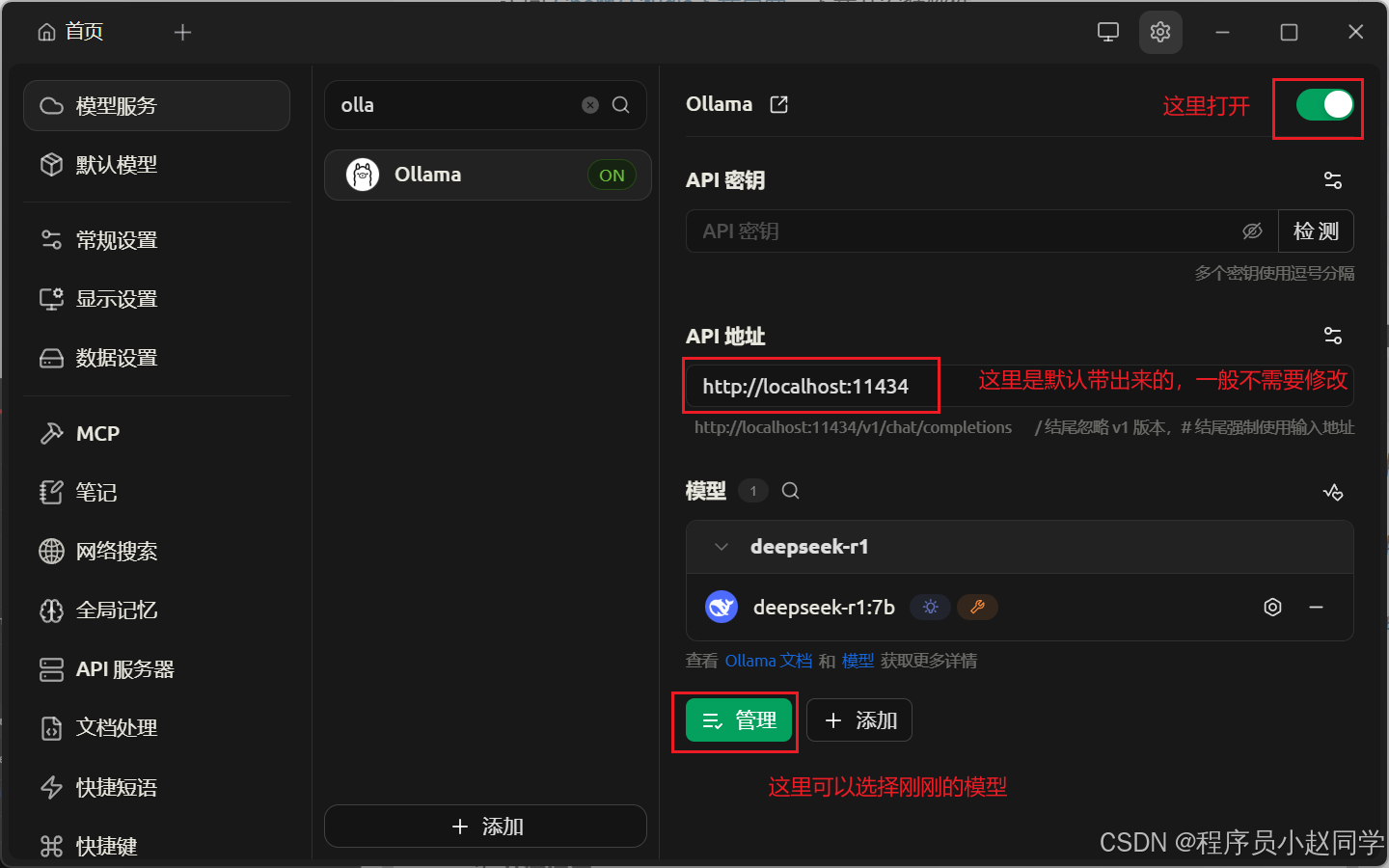

配置Ollama连接

- 打开Cherry Studio

- 点击左侧的设置(齿轮图标)

- 选择模型服务选项卡

- 点击列表中的Ollama

-

开始使用

配置完成后,回到聊天界面,选择:- 服务商:Ollama

- 模型:deepseek-r1:7b

现在你可以享受在美观的界面中与AI自由对话了!

常见问题解答

Q1: 安装过程中下载速度很慢怎么办?

A: 这是由于网络原因导致的,建议:

- 尝试在网络状况较好的时段下载

- 耐心等待,模型文件较大(1.5B版本约几百MB)

Q2: 运行模型时电脑卡顿怎么办?

A: 这可能是电脑配置不足,建议:

- 关闭其他占用内存的应用程序

- 尝试使用更小的模型版本(如1.5B)

- 增加电脑虚拟内存

Q3: 如何更新到最新版本的模型?

A: 在命令提示符中运行:

ollama pull deepseek-r1:7b

这会下载该模型的最新版本。

结语

通过本教程,你已经成功在本地部署了属于自己的AI助手!这不仅让你能够免费、私密地使用大模型,更为你打开了通向AI世界的大门。

现在,你可以:

✅ 无限次免费与AI对话

✅ 在断网环境下正常使用

✅ 完全保证对话隐私

✅ 随时探索其他AI模型

如果在操作过程中遇到任何问题,欢迎在评论区留言,我会尽力帮助大家解决!

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)