作为普通程序员,我们该如何学习大模型(LLM),学习路线和知识体系

本文系统介绍了学习AI大模型的完整路径:从基础概念(Transformer架构、自注意力机制)到数学编程基础(线性代数、Python/PyTorch),再到深度学习与NLP核心技术(词嵌入、序列建模)。重点讲解了Transformer架构原理及实践方法,包括预训练模型微调和部署优化。建议通过参与开源项目、跟踪前沿研究(ACL/NeurIPS论文)和实际应用开发来巩固知识。文章还提供了包括学习路线图

理解大模型的基本概念

大模型(Large Language Model, LLM)是基于深度学习的自然语言处理模型,能够理解和生成文本。其核心是Transformer架构,包含自注意力机制和并行计算能力。常见的LLM包括GPT、BERT、T5等。学习LLM前,需要掌握深度学习、自然语言处理(NLP)和分布式计算的基础知识。

掌握基础数学和编程技能

线性代数(矩阵运算、特征分解)、概率论(条件概率、贝叶斯定理)和微积分(梯度下降)是理解LLM的数学基础。编程方面需要熟悉Python,尤其是PyTorch或TensorFlow框架。

import torch

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("gpt2")

input_ids = torch.tensor([[1, 2, 3]]) # 示例输入

outputs = model(input_ids)

学习深度学习与NLP基础

从多层感知机(MLP)、卷积神经网络(CNN)和循环神经网络(RNN)入手,逐步扩展到Transformer架构。学习词嵌入(Word2Vec、GloVe)、序列建模(Seq2Seq)和注意力机制。

深入理解Transformer架构

Transformer的核心是多头自注意力机制和位置编码。公式如下:

[ \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V ]

掌握编码器-解码器结构、残差连接和层归一化等技术。

实践预训练与微调

学习如何使用Hugging Face库加载预训练模型,并进行下游任务微调。常见任务包括文本分类、机器翻译和问答系统。

from transformers import pipeline

classifier = pipeline("text-classification", model="bert-base-uncased")

result = classifier("This is a positive sentence.")

print(result)

研究大模型的优化与部署

了解模型量化、剪枝和知识蒸馏等技术,以降低计算资源需求。学习如何将模型部署到云服务(AWS、GCP)或边缘设备(ONNX格式)。

参与开源社区与项目

通过GitHub等平台参与LLM相关开源项目,如Hugging Face的Transformers库。复现论文实验,阅读最新研究(arXiv上的论文)。

持续关注前沿技术

订阅NLP领域的顶级会议(ACL、EMNLP、NeurIPS)和博客(OpenAI、DeepMind)。学习多模态模型、强化学习与LLM的结合等方向。

构建个人知识体系

整理学习笔记,撰写技术博客,分享实践经验。通过实际项目(如聊天机器人、文本生成工具)巩固知识。

通过以上步骤,普通程序员可以逐步掌握大模型的核心技术和应用方法,构建完整的知识体系。

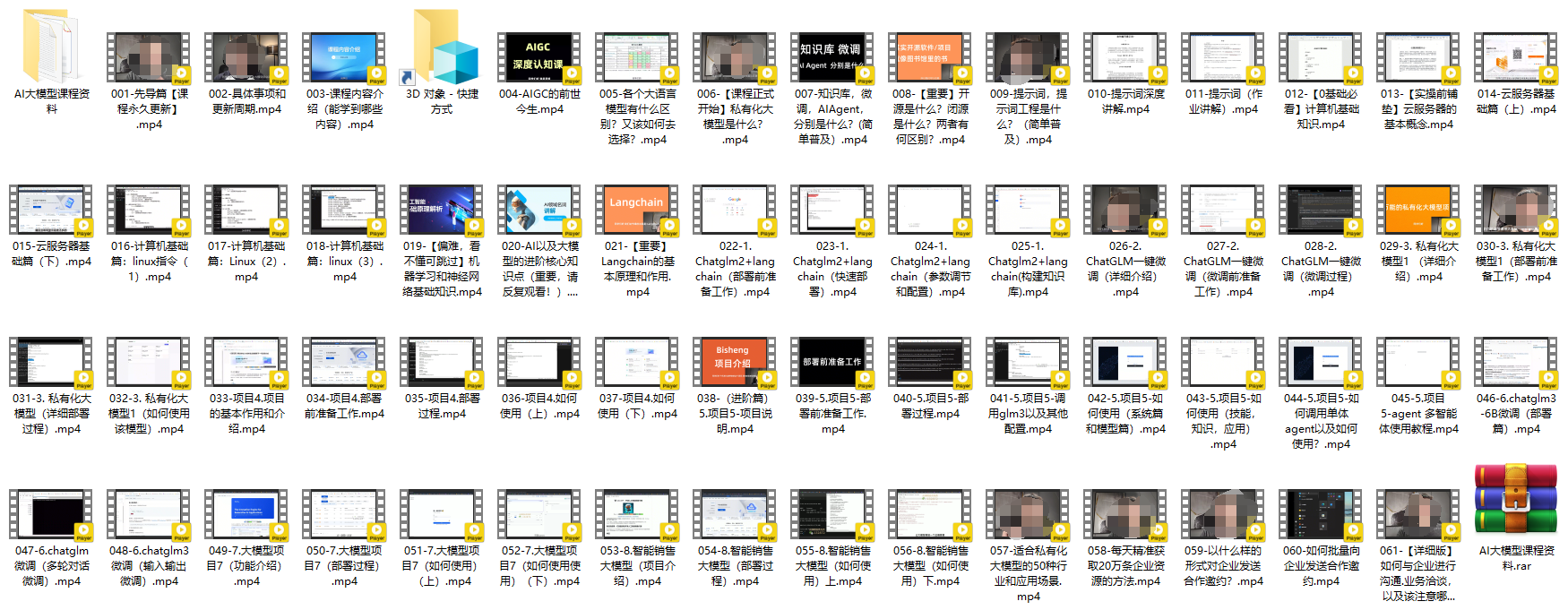

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

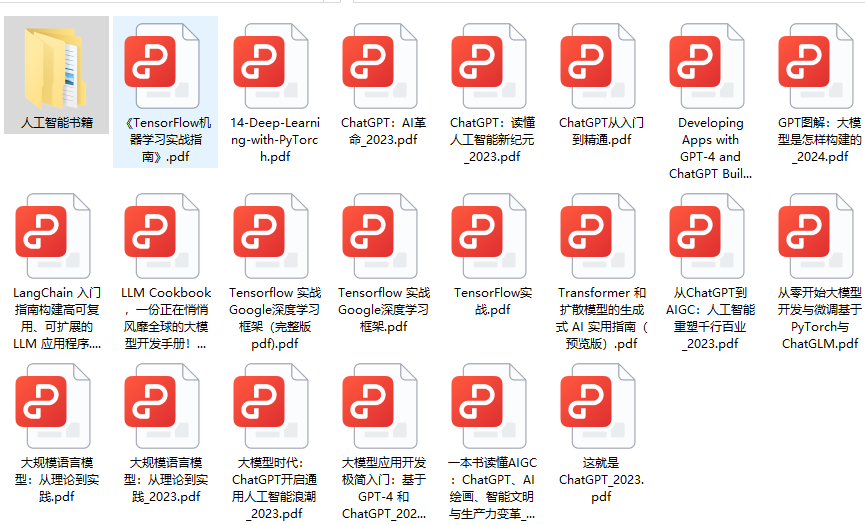

- AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

- AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)