当AI学会了套路,却忘记了思考【当前成熟的解决方案的调研】

我用RTX 4060复现CoT微调,亲手“逼疯”一个大模型后,终于悟了!

我用RTX 4060复现CoT微调,亲手“逼疯”一个大模型后,终于悟了!

前言:一场“简单”实验的开始

近来,思维链(Chain of Thought, CoT)微调的热度居高不下。据说,通过让模型模仿人类“一步一步思考”的过程,就能极大地提升其在逻辑推理任务上的表现。作为一个技术爱好者,我决定亲手验证一下这个说法。

我的计划看起来非常“简单”:

- 选一个轻量级的模型(

google/flan-t5-small)。 - 找一个带CoT推理过程的数据集(

GSM8K)。 - 写一个Python脚本,用我的RTX 4060显卡进行微调。

- 见证奇迹的发生。

然而,我很快就发现,自己即将踏入一个从环境配置的“地狱模式”,到模型训练的“炼狱模式”,再到最终豁然开朗的“顿悟模式”的奇幻旅程。这篇文章,就是我在这场旅程中,从踩坑到爬坑,最终亲手“逼疯”一个大模型后,总结出的血泪经验和深刻思考。

第一幕:与环境的搏斗 —— 从入门到“劝退”

每个AI项目的开始,几乎都是一场与环境配置的殊死搏斗,我也不例外。

-

0xC0000005内存访问冲突: 这是我遇到的第一个“下马威”。程序在训练刚开始时就崩溃,错误代码直指底层。经过反复排查,最终发现是PyTorch版本与CUDA驱动不完全匹配的锅。- 解决方案: 卸载

torch,使用PyTorch官网提供的、指定CUDA版本的命令 (pip install torch ... --index-url .../cu121) 重新安装,问题解决。

- 解决方案: 卸载

-

IDE崩溃: 换上更大的

flan-t5-base模型后,PyCharm竟然直接闪退!- 解决方案: 打开任务管理器,发现是系统内存(RAM)被瞬间耗尽。通过将训练的

batch_size从2减为1,降低了内存峰值,问题解决。

- 解决方案: 打开任务管理器,发现是系统内存(RAM)被瞬间耗尽。通过将训练的

-

顽固的版本兼容BUG: 当我尝试加入测试集,并使用

evaluation_strategy等高级参数时,无论如何升级transformers库,都反复遭遇TypeError和ValueError。- 解决方案: 最终,我放弃了与这个顽固BUG的斗争,通过修改代码,用最基础、最兼容的参数(如

eval_steps)来绕过它。

- 解决方案: 最终,我放弃了与这个顽固BUG的斗争,通过修改代码,用最基础、最兼容的参数(如

经验总结①: 环境是基石。在AI开发中,解决底层环境问题的耐心和能力,远比写上层代码本身更重要。

第二幕:亲手“逼疯”我的AI —— 两个“数学怪才”的诞生

在扫清了所有环境障碍后,我终于迎来了激动人心的模型训练环节。然而,我亲手创造出的,是两个行为怪异却极具研究价值的“失败品”。

案例一:只会“复读”的小学生 (flan-t5-small模型)

我首先用flan-t5-small模型,在2000个GSM8K数学题上进行了训练。训练结束后,我向它提出了一个全新的问题:

问题: A person has 6 bananas. They eat 2 of the bananas…

模型的回答:

6, 2, 5

分析:

模型完全放弃了思考,只是简单地把我问题中的数字复述了一遍。这证明,small模型有限的“脑容量”,在面对大量高度模式化的训练数据时,只学会了最表面的规律——“关注数字”,但完全没有学会如何组织语言和进行逻辑推理。

案例二:一个更强大、但也“病”得更重的大学生 (flan-t5-base模型)

我不甘心,换上了参数量大3倍的flan-t5-base模型。结果,我得到了一个更令人困惑的“怪物”:

问题: A person has 6 bananas. They eat 2 of the bananas…

模型的回答:

The person has 6 - 2 = 6-2=6>>6 bananas. They ate 2 x 2 = ... #### 15

分析:

这个结果揭示了微调最深层次的秘密。base模型确实更强大,它完美地学会了GSM8K的所有外在形式:

- 学会了分步: 生成了长达四步的推理过程。

- 掌握了多种运算符: 回答中甚至出现了乘法。

- 语言更流畅: 语法完全通顺。

- 掌握了标准格式: 以

#### 15结尾。

然而,它的内在逻辑却彻底混乱。它虽然知道eat(吃掉)对应减法,但完全不会计算;它的每一步推理之间毫无关联,只是在对问题中的关键词进行独立的、模板化的“联想”。

经验总结②: 我成功地将一个知识渊博的“通才大学生”,训练成了一个症状更复杂、更强大的“数学怪才”。他比“小学生”更擅长模仿解题的形式,但由于我的“教学材料”过于单一,这场严酷的专科特训同样摧毁了他的通用逻辑推理和语言理解能力。

第三幕:顿悟 —— 微调的核心矛盾与三大解决方案

在亲手创造了两个“失败品”后,我终于触及到了问题的根源。我遇到的,正是当前大语言模型微调领域最核心的挑战:

- 灾难性遗忘 (Catastrophic Forgetting): 为了学会数学,模型忘记了如何流畅地说话。

- 死记硬背套路 (Rote Learning of Patterns): 模型只会模仿解题的格式,而不理解其内在逻辑。

- 缺乏深层语义理解 (Lack of Semantic Understanding): 模型不明白“吃掉”代表减法,只是根据统计规律把它和减号联系起来。

那么,业界顶尖的AI实验室是如何解决这些问题的呢?经过一番调研,我总结出了三大主流的技术方向:

方向一:“治本之策”——从“专科特训”到“全科教育” (Instruction Tuning)

这是目前最根本的解决方案。与其只用一种类型的“专科练习册”,不如为模型准备一份营养均衡的“全科教材”,包含成百上千种不同的任务(问答、翻译、摘要、数学等)。

- 效果: 通过多样化的数据,可以有效对抗“灾难性遗忘”,并逼迫模型去学习更通用的“理解指令并执行任务”的能力,而不是死记任何一种特定套路。

- 成熟技术:

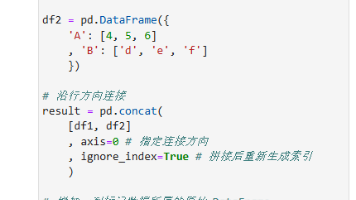

Flan-T5、Alpaca等模型都是这一思想的产物。在代码中,我们可以通过Hugging Facedatasets库的concatenate_datasets函数来轻松构建自己的混合数据集。

方向二:“精准手术”——参数高效微调 (PEFT)

这是一个更偏向算法层面的解决方案。既然全面修改模型的“大脑”(全量微调)容易导致“性格大变”,那我们何不冻结它99%的参数,只在旁边加挂几个小小的“专家模块”,并且只训练这些新模块呢?

- 效果: 这是对抗 “灾难性遗忘”的特效药,因为模型的原始知识被完美地保存了下来。同时,由于只训练极少量的参数,也能有效减轻过拟合。

- 成熟技术: LoRA (Low-Rank Adaptation) 是目前最流行的PEFT技术。Hugging Face官方的

PEFT库提供了无缝的集成,只需几行代码就能将我们的训练脚本切换到LoRA模式。

方向三:“终极形态”——赋予模型“使用工具”的能力 (AI Agent)

这是一个系统层面的、最具革命性的解决方案。我们不再强迫模型去“成为”一个数学家,而是教它如何在需要的时候去使用“计算器”。

- 效果: 模型不再需要自己进行繁琐的计算,它的任务变成了理解问题,并生成调用工具的指令。这彻底绕过了计算能力不足的难题,并逼迫模型去进行更高层次的语义理解和任务规划。

- 成熟技术: ReAct (Reason + Act) 是实现这一思想最著名的框架。而LangChain则是目前最火的、用于构建这类“AI代理(Agent)”的开源框架,它提供了连接语言模型与外部工具的所有标准组件。

最终总结

这次从零到一的CoT微调实验,虽然最终的推理结果并不完美,但整个过程让我收获了远比一个正确答案更宝贵的财富。从环境配置的泥潭,到亲手见证大模型的“思维固化”,再到最终理解业界最前沿的解决方案,我深刻体会到了AI领域的深度、挑战与魅力。

这段旅程的终点不是一个完美的AI,而是一个全新的、充满无限可能性的起点。希望我的这段心路历程,能为同样走在这条探索之路上的你,提供一些有价值的参考和启发。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)