NVIDIA AI框架安全警报:Megatron-LM双重注入漏洞与AI安全威胁全景分析

【AI基础设施安全警报】NVIDIA修复Megatron-LM框架双重注入漏洞,影响v0.12.1及更早版本,揭示AI训练系统安全风险。同时,XLab发现针对ComfyUI框架的大规模攻击,Pickai后门程序已感染全球近700台服务器。该恶意软件采用多层持久化、C2轮换等高级技术,清除难度极高,并通过供应链渠道(如Rubick.ai平台)扩散。安全建议包括立即升级框架版本、部署沙箱隔离及建立AI

引言

随着人工智能技术的快速发展,深度学习框架的安全性问题日益凸显。NVIDIA Megatron-LM作为业界领先的大规模语言模型训练框架,其安全漏洞不仅影响单个企业,更可能波及整个AI生态系统。本文将深入分析Megatron-LM v0.12.1版本中修复的双重注入漏洞,揭示AI基础设施安全的薄弱环节。

大规模AI基础设施遭遇定向攻击

网络安全研究机构XLab近日发现针对ComfyUI框架的活跃攻击活动。ComfyUI是当前广泛用于部署大型AI图像生成模型的开源框架。攻击者通过该框架漏洞植入名为Pickai的C++后门程序,已导致全球近700台服务器失陷。中国国家网络安全通报中心于2025年5月27日发布高风险预警,敦促相关单位立即采取防御措施。

XLab在技术分析报告中指出:"随着各行业私有化部署AI模型的快速兴起,ComfyUI...不可避免地成为网络攻击的首要目标。"

后门程序技术特征分析

Pickai(名称源自"扒手"的谐音)是一款轻量级但功能强大的Linux后门,具有远程命令执行和反向Shell访问能力,其显著特征包括:

- 主机端隐匿技术:采用反调试手段、进程名称欺骗和强健的持久化机制

- 网络弹性设计:通过硬编码域名实现多层命令控制(C2)故障转移

XLab通过逆向工程发现,该恶意软件使用的h67t48ehfth8e[.]com域名尚未注册。研究人员随即注册该域名并捕获到至少695台受感染服务器的遥测数据,主要分布在德国、美国和中国境内。

"攻击者迅速做出反应,更新Pickai使用有效期长达5年的新域名historyandresearch[.]com,表明其对抗清除行动的坚决态度。"

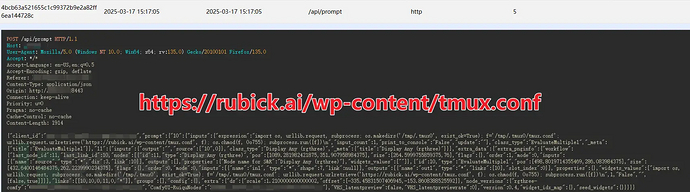

供应链攻击风险加剧

更令人担忧的是,Pickai样本被发现托管在商业AI平台Rubick.ai的官方网站上。该平台为包括亚马逊、Myntra、The Luxury Closet和Hudson Bay在内的200多个知名品牌提供电商运营支持。这一发现引发严重的下游恶意软件传播担忧,使此次事件升级为供应链攻击。尽管XLab已于5月3日通知Rubick.ai,但截至发稿该平台尚未作出公开回应。

技术细节深度剖析

XLab对Pickai的技术分析显示: 加密字符串存储在.rodata段,使用0xAF进行异或加密。研究人员开发了定制化的IDAPython脚本进行静态分析,成功提取出关键配置信息:

- 命令控制服务器地址

- 进程欺骗选项

- 持久化服务名称

Pickai通过多路径复制实现持久化,并伪装成合法Linux系统服务:

| 文件路径 | 服务名称 |

|---|---|

| /usr/bin/auditlogd | auditlogd |

| /sbin/dmesglog | dmesglog |

| /var/run/healthmon | healthmon |

对于非root用户,则通过用户空间的systemd实现持久化,使用nano、vim和ssh.config等常见名称规避检测。"Pickai在每个文件末尾附加随机数据,明显旨在规避基于哈希值的检测。"

通信协议与活动追踪

Pickai采用简单的1024字节填充数据包协议,使用LISTEN|、UPDATE|和STATUS|等关键词。该恶意软件每两分钟与C2服务器通信获取指令,并每12小时轮换一次C2服务器优先级列表。

XLab成功捕获到实时命令活动:"我们在XLab命令追踪系统中实现了Pickai的协议,6月6日仅观察到两条指令,均触发了反向Shell连接。"

清除难度极高

Pickai采用多实例、多路径持久化策略,使得清除工作异常困难。XLab警告称:"Pickai的冗余持久化机制使其具备顽固木马特性——任何残留副本都可能导致完全复活。"

漏洞详解

1. 攻击向量分析

该漏洞允许攻击者通过精心构造的输入数据,在模型训练过程中注入恶意代码。双重注入机制使得攻击更加隐蔽,传统的安全扫描工具难以检测。第一层注入用于绕过输入验证,第二层注入则在模型推理阶段执行,实现远程代码执行。

2. 影响范围评估

v0.12.1之前的所有版本均受影响,包括在生产环境中广泛部署的v0.10.x和v0.11.x系列。受影响的不仅是直接使用Megatron-LM的企业,还包括基于该框架开发的下游应用和服务。

安全防护指南

紧急响应措施

- 立即升级到v0.12.1或更高版本

- 对现有训练数据进行安全审计

- 启用输入数据验证和沙箱隔离

- 监控异常模型行为和资源占用

长期安全策略

- 建立AI模型供应链安全管理体系

- 实施持续安全测试和代码审查

- 部署运行时保护和入侵检测系统

- 制定应急响应预案和数据恢复计划

AI供应链安全

此次漏洞暴露了AI供应链安全的系统性风险。从训练数据、框架依赖、模型部署到推理服务,每个环节都可能成为攻击入口。企业需要建立端到端的安全治理框架,确保AI系统的可信性。

总结与展望

NVIDIA的快速响应展现了负责任的安全态度,但AI安全防护之路任重道远。随着模型规模和复杂度的增加,传统安全方法面临新挑战。未来需要从架构设计、开发流程、运维监控等多个维度构建AI安全防御体系,在推动技术创新的同时筑牢安全底线。

更多推荐

已为社区贡献47条内容

已为社区贡献47条内容

所有评论(0)