AI安全警报:主流AI平台隐私泄露与黑帽SEO攻击双重威胁深度分析

AI平台面临双重安全危机:一方面主流AI工具未经用户明确同意收集并共享个人数据,Meta、谷歌等平台甚至将敏感信息永久嵌入模型训练;另一方面网络罪犯利用AI热度通过黑帽SEO传播恶意软件。研究表明,用户难以从训练数据中删除已输入信息,企业机密也存在外泄风险。专家建议审慎输入敏感数据、核查隐私设置、使用安全工具,并呼吁加强监管提高透明度。

【AI安全深度报道】随着人工智能技术的快速普及,AI平台的安全和隐私问题日益凸显。近期,多项研究揭示了AI领域的两大安全威胁:主流AI平台在未经用户明确同意的情况下擅自共享个人信息,以及网络犯罪分子利用AI热度进行黑帽SEO攻击传播恶意软件。这两种威胁正在形成"数据泄露+恶意攻击"的双重危机,对用户隐私和网络安全构成严重挑战。本文将深入分析这些威胁的技术细节和应对策略。

AI平台隐私问题现状

最新调查显示,包括ChatGPT、Claude、Gemini等在内的主流AI平台,在处理用户数据时存在严重的透明度不足问题。这些平台往往通过复杂的隐私政策条款,在用户不知情的情况下:

- 收集敏感数据:包括对话内容、使用习惯、个人偏好等

- 共享给第三方:用于模型训练、商业分析或其他目的

- 缺乏控制机制:用户难以查看、修改或删除已提交的数据

- 跨平台追踪:通过API集成实现用户行为的跨平台监控

更令人担忧的是,即使用户选择"不共享数据"选项,一些平台仍会以"改进服务质量"为名继续收集和使用数据。这种做法严重侵犯了用户的知情权和选择权。

AI平台将用户数据锁定于模型训练环节

根据Incogni的研究报告,包括Meta、谷歌和微软在内的多家主流生成式AI和大语言模型(LLM)平台正在收集敏感数据并与不明第三方共享,导致用户对自身信息的存储、使用和共享方式既缺乏透明度,也几乎没有任何控制权。

谷歌Gemini、Meta AI、DeepSeek和Pi.ai等平台均未提供退出机制来阻止用户输入内容被用于AI模型训练。一旦输入个人或敏感数据,实际上无法从AI训练数据集中删除这些信息。尽管《通用数据保护条例》(GDPR)等法律赋予个人要求删除数据的权利,但如何从机器学习模型中实际移除信息仍不明确。因此,许多公司目前既无义务也缺乏技术能力来事后删除此类数据。用户的联系信息或商业机密可能在未经明确告知或同意的情况下,被永久嵌入模型训练数据中。

数据收集行为全景扫描

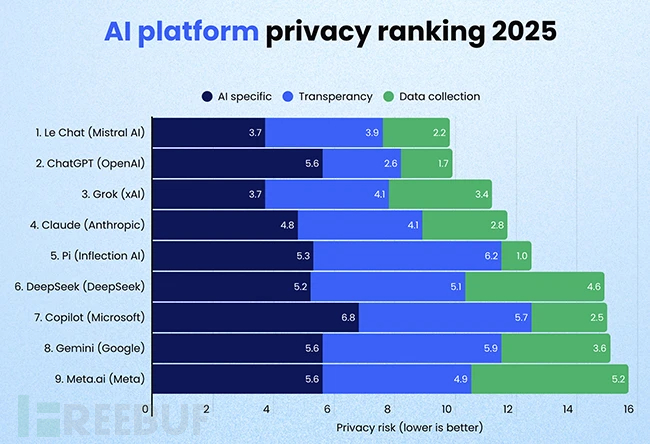

随着生成式AI日益融入日常生活,用户往往不清楚这些工具收集了哪些个人数据、如何使用以及最终流向何处。研究人员从三个维度分析了主流AI平台的数据实践:用户数据在模型训练中的使用情况、平台隐私政策的透明度、数据收集与第三方共享的范围。

- Meta.ai和Gemini会收集用户的精确定位数据和实体地址

- Claude根据其Google Play商店页面显示,会向第三方共享电子邮件、电话号码和应用交互数据

- Grok(xAI)可能将用户提供的照片和应用交互数据共享给第三方

- Meta.ai会与外部实体(包括研究合作伙伴和企业集团成员)共享姓名、电子邮件和电话号码

- 微软的隐私政策暗示用户输入内容可能被共享给涉及在线广告或使用微软广告技术的第三方

- Gemini、DeepSeek、Pi.ai和Meta.ai很可能未提供退出模型训练的选择权

- ChatGPT在说明哪些输入内容会用于模型训练方面最为透明,并制定了清晰的隐私政策

即便用户主动寻求解释,相关细节也往往隐藏在零散的帮助页面或用晦涩的法律术语书写。Incogni发现所有被分析的隐私政策都需要大学水平的阅读能力才能理解。

员工使用AI或致商业机密外泄

除个人隐私外,企业面临的风险更为严峻。员工常使用生成式AI工具协助起草内部报告或通讯,却未意识到这可能导致专有数据成为模型训练集的一部分。这种保护机制的缺失不仅使个人面临非自愿数据共享,还可能导致敏感商业数据在未来与其他用户的交互中被重复利用,从而引发隐私、合规和竞争风险。

"多数人以为只是在与可信助手对话,并未泄露联系信息或商业机密。"Incogni负责人Darius Belejevas指出,"实际情况更具侵入性,而企业并未让用户轻松理解数据的真实流向。用户有权知晓哪些数据被收集、谁能查看以及如何阻止。目前这些答案往往难以寻觅,甚至根本不存在。"

综合安全防护策略

保护AI平台隐私的实用技巧

- 审慎输入敏感信息:避免在AI对话中透露个人身份信息、财务数据、工作机密等

- 定期检查隐私设置:及时关闭不必要的数据收集选项

- 使用匿名模式:在不需要保存历史的情况下使用隐身/临时会话

- 选择开源替代:考虑使用本地部署的开源AI模型,完全掌控数据

- 阅读隐私政策:了解平台如何使用和共享你的数据

防范黑帽SEO攻击的关键措施

- 验证搜索结果:仔细核对域名,警惕拼写相似的钓鱼网站

- 使用官方渠道:通过官方网站或应用商店下载软件

- 启用安全工具:使用广告拦截器、反恶意软件扩展

- 保持系统更新:及时安装安全补丁,修复已知漏洞

- 提高安全意识:对"免费AI工具"、"破解版"等保持警惕

企业级防护建议

- 制定AI使用政策,规范员工使用AI工具的行为

- 部署数据防泄漏(DLP)系统,监控敏感信息外传

- 建立安全培训机制,提高员工对AI风险的认识

- 评估AI供应商的安全资质,选择合规的服务商

- 实施零信任架构,限制AI API的访问权限

总结:AI时代的安全挑战与应对

AI技术的快速发展为我们带来了前所未有的便利,但同时也引入了新的安全和隐私风险。从主流AI平台的数据收集实践,到网络犯罪分子利用AI热度进行攻击,这些威胁正在以多种形式影响着每一个用户。

关键要点:

- AI平台的隐私政策往往复杂且不透明,用户需要主动了解和保护自己的数据权利

- 黑帽SEO攻击利用用户对新技术的好奇心,通过污染搜索结果传播恶意软件

- 双重威胁(隐私泄露+恶意攻击)需要综合性的防护策略

- 技术防护和安全意识同样重要,缺一不可

展望未来,随着AI技术的进一步普及,相关的安全挑战只会越来越复杂。监管机构需要建立更严格的隐私保护法规,AI服务提供商需要提高透明度和责任意识,而用户也需要不断提升自己的安全防护能力。只有多方协同努力,才能构建一个既创新又安全的AI生态系统。

声明:本文旨在提升网络安全意识和隐私保护意识,所有信息仅供学习研究使用。

更多推荐

已为社区贡献47条内容

已为社区贡献47条内容

所有评论(0)