AI时代必备技能:深度解析流式输出与SSE实战

文章摘要: 2025年AI智能体爆发时代,流式输出技术成为前端开发的核心竞争力。本文解析流式输出的必要性:大模型Token逐生成特性、用户体验优化(降低等待焦虑),并重点介绍SSE(Server-Sent Events)技术实现方案。通过对比SSE与WebSocket,提供前端到后端的实战代码(模拟AI聊天逐字输出),涵盖生产级优化(错误重连、内存管理)及打字机动效等最佳实践。流式输出是AI产品实

引言

在2025年AI Agent大爆发的时代,流式输出已经成为前端开发者的必备技能。本文将从技术原理到实战应用,全面解析为什么流式输出是25年大厂必考题,以及如何用SSE技术打造丝滑的AI聊天体验。

🔥 为什么流式输出成为2025年必考题?

AI产品发展历程

- 2023年: ChatGPT引爆AI聊天机器人

- 2024年: 大模型推理能力突破

- 2025年: AI Agent年,智能体应用全面爆发

在这个AI产品快速迭代的时代,流式输出不仅仅是技术实现,更是用户体验的核心竞争力。

💡 为什么需要流式输出?

1. 大模型工作原理

AI Generated Content → Token逐个生成 → 实时返回

大语言模型(LLM)采用Token Transform机制:

- 每个token都需要推理时间

- 按token收费,成本可控

- 边生成边输出,提升响应速度

2. 用户体验的心理学

作为最懂用户心理的前端开发者,我们需要用"障眼法"让用户感受到:

"AI正在思考,我愿意等待这个过程"

相比于长时间等待后一次性返回结果,流式输出让用户:

- ✅ 感受到系统在响应

- ✅ 提前看到部分结果

- ✅ 降低等待焦虑

🛠️ 技术实现:从前端到后端

前端实现策略

前端可以通过多种方式实现流式效果:

- setInterval - 定时轮询

- 事件机制 - 监听message事件

- WebSocket - 双向通信

- SSE - 服务器推送(本文重点)

后端实现方案

后端需要突破HTTP请求-响应的限制:

- 传统HTTP:请求→处理→响应→关闭连接

- HTTP/2.0 Server Push:保持连接,服务器主动推送

📡 SSE (Server-Sent Events) 深度解析

什么是SSE?

Server-Sent Events是HTML5标准的一部分,专门用于服务器向客户端推送数据。

核心特点:

- 🔄 单向通信:服务器→客户端

- 🔗 长连接:基于HTTP,保持连接不断开

- 📱 原生支持:浏览器原生API,无需第三方库

- 🔁 自动重连:连接断开后自动重新连接

SSE vs WebSocket 对比

| 特性 | SSE | WebSocket |

|---|---|---|

| 通信方向 | 单向(服务器→客户端) | 双向 |

| 协议 | HTTP | WebSocket协议 |

| 复杂度 | 简单 | 相对复杂 |

| 重连机制 | 自动 | 需手动实现 |

| 适用场景 | 实时推送、流式输出 | 实时聊天、游戏 |

SSE消息格式

data: 这是消息内容\n\n

event: custom-event\n

data: {"type": "message", "content": "Hello"}\n\n

id: 123\n

data: 带ID的消息\n\n

重要规则:

- 每行以

\n结尾 - 消息以

\n\n结束 data:开头的是消息内容event:指定事件类型id:用于断线重连

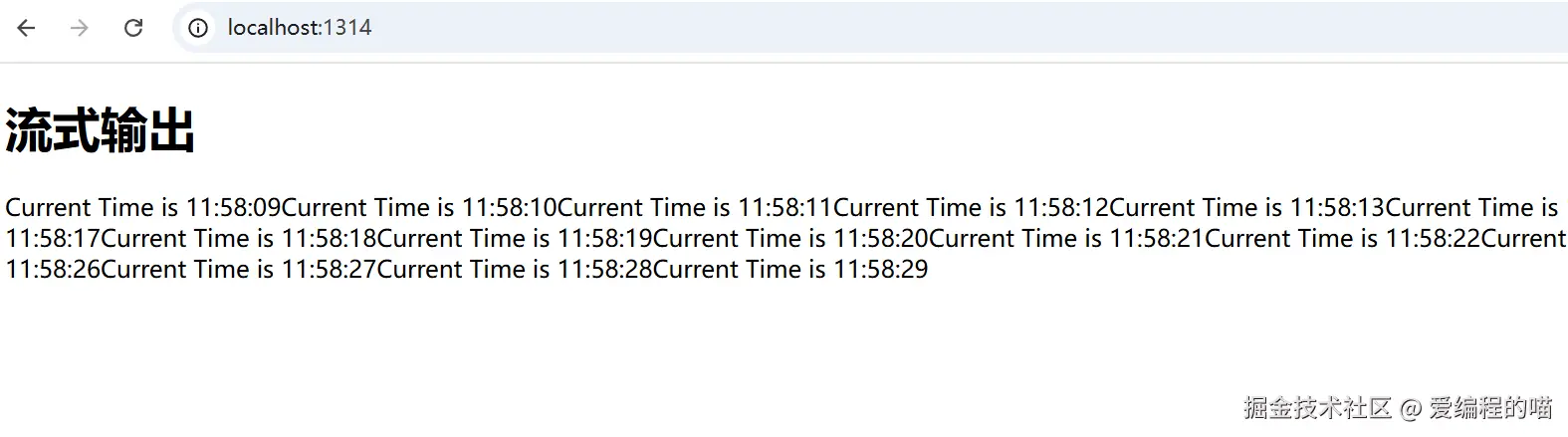

🚀 实战:打造AI聊天流式输出

项目初始化

npm init -y

npm i express

前端实现 (index.html)

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>LLM Chatbot</title>

</head>

<body>

<h1>流式输出</h1>

<div id="message"></div>

<script>

// 创建SSE连接

const source = new EventSource('/sse');

// 监听消息事件

source.onmessage = function(event){

const messages = document.getElementById('message');

messages.innerHTML += event.data;

}

// 错误处理

source.onerror = function(event) {

console.log('SSE连接错误:', event);

}

// 连接打开

source.onopen = function(event) {

console.log('SSE连接已建立');

}

</script>

</body>

</html>

后端实现 (index.js)

const express = require('express');

const app = express();

// 主页路由

app.get('/', (req, res) => {

console.log(__dirname);

res.sendFile(__dirname + '/index.html');

});

// SSE路由 - 核心实现

app.get('/sse', (req, res) => {

// 设置SSE响应头

res.set({

'Content-Type': 'text/event-stream', // 指定为事件流

'Cache-Control': 'no-cache', // 禁用缓存

'Connection': 'keep-alive', // 保持连接

'Access-Control-Allow-Origin': '*', // 允许跨域

'Access-Control-Allow-Headers': 'Cache-Control'

});

// 发送响应头

res.flushHeaders();

// 模拟AI流式输出

let count = 0;

const timer = setInterval(() => {

const message = `Current Time is ${new Date().toLocaleTimeString()}`;

// 发送SSE格式数据

res.write(`data: ${message}\n\n`);

count++;

// 模拟完成,关闭连接

if (count >= 10) {

clearInterval(timer);

res.write(`data: [DONE]\n\n`);

res.end();

}

}, 1000);

// 客户端断开连接时清理

req.on('close', () => {

clearInterval(timer);

console.log('客户端断开连接');

});

});

// 启动服务器

const http = require('http').Server(app);

http.listen(1314, () => {

console.log('🚀 Server is running on http://localhost:1314');

});

🎯 生产级优化建议

1. 错误处理与重连

// 前端重连逻辑

let source;

let reconnectCount = 0;

const maxReconnects = 5;

function createSSEConnection() {

source = new EventSource('/sse');

source.onopen = function() {

reconnectCount = 0;

console.log('SSE连接成功');

};

source.onerror = function() {

source.close();

if (reconnectCount < maxReconnects) {

setTimeout(() => {

reconnectCount++;

createSSEConnection();

}, 1000 * reconnectCount);

}

};

}

2. 后端性能优化

// 连接管理

const clients = new Set();

app.get('/sse', (req, res) => {

// ... 设置响应头

clients.add(res);

req.on('close', () => {

clients.delete(res);

});

});

// 广播消息

function broadcast(message) {

clients.forEach(client => {

try {

client.write(`data: ${message}\n\n`);

} catch (err) {

clients.delete(client);

}

});

}

3. 内存泄漏防护

// 设置连接超时

const TIMEOUT = 30 * 60 * 1000; // 30分钟

app.get('/sse', (req, res) => {

const timeout = setTimeout(() => {

res.end();

}, TIMEOUT);

req.on('close', () => {

clearTimeout(timeout);

});

});

🌟 AI聊天场景最佳实践

1. 打字机效果实现

// 前端实现打字机效果

source.onmessage = function(event) {

const messageDiv = document.getElementById('message');

const newChar = event.data;

if (newChar === '[DONE]') {

source.close();

return;

}

// 添加打字机动画

const span = document.createElement('span');

span.textContent = newChar;

span.style.opacity = '0';

messageDiv.appendChild(span);

// 淡入动画

setTimeout(() => {

span.style.transition = 'opacity 0.1s';

span.style.opacity = '1';

}, 10);

};

2. Token级别流式输出

// 后端模拟LLM token输出

app.get('/chat', (req, res) => {

res.set(sseHeaders);

res.flushHeaders();

const aiResponse = "我是你的AI助手,很高兴为您服务!";

let index = 0;

const sendToken = () => {

if (index < aiResponse.length) {

const char = aiResponse[index];

res.write(`data: ${char}\n\n`);

index++;

// 模拟模型推理延迟

setTimeout(sendToken, Math.random() * 100 + 50);

} else {

res.write(`data: [DONE]\n\n`);

res.end();

}

};

sendToken();

});

📊 性能监控与调优

关键指标监控

// 连接数监控

let connectionCount = 0;

app.get('/sse', (req, res) => {

connectionCount++;

console.log(`当前连接数: ${connectionCount}`);

req.on('close', () => {

connectionCount--;

console.log(`连接断开,剩余: ${connectionCount}`);

});

});

// 内存使用监控

setInterval(() => {

const memUsage = process.memoryUsage();

console.log(`内存使用: ${Math.round(memUsage.heapUsed / 1024 / 1024)}MB`);

}, 30000);

🎉 总结

流式输出技术在AI时代的重要性不言而喻:

- 技术价值:掌握SSE是前端开发者的核心竞争力

- 用户体验:提供近乎实时的交互反馈

- 产品差异化:在AI产品中脱颖而出的关键技术

未来展望

随着AI Agent的普及,流式输出将在以下场景大放异彩:

- 🤖 AI代码生成

- 📝 智能写作助手

- 🎨 创意内容生成

- 📊 实时数据分析

掌握了流式输出技术,你就拥有了在AI时代打造极致用户体验的能力!

零基础入门AI大模型

今天贴心为大家准备好了一系列AI大模型资源,包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

5.免费获取(扫下方二v码即可100%领取)

更多推荐

已为社区贡献131条内容

已为社区贡献131条内容

所有评论(0)