录音转文字识别不了?别慌,教你轻松解决

朋友是福建人,说话带点方言,之前用别的工具转他的录音,经常把“喝茶”写成“查哈”,把“明天”写成“敏天”。虽然我不是技术专家,但从听脑AI的技术创新中,我能看到一些趋势:比如更智能的“语境理解”——它能根据上下文理解说话者的意思,比如“我今天吃了苹果”中的“苹果”不会被识别成“平果”;用听脑AI之后,她只要把录音导入,就能快速得到准确的文字稿,而且听脑AI的“发言人识别”功能能区分不同的说话人,比

前阵子帮做记者的朋友转一段客户访谈录音,可把我愁坏了——录音里既有咖啡馆的咖啡机声,又有邻座的聊天声,客户说话还时不时压低声音。用之前常用的工具试了三次,要么把背景的“滋滋”声当成说话内容,要么把客户的“我觉得...”识别成空白,最后只能对着录音逐句核对,费了快两个小时才整理好。朋友看我一脸无奈,递过来手机说:“你试试听脑AI?我上次转街头采访的录音,居然把马路上的车声都滤掉了,客户的小声回应也能准确识别。”

这让我一下子好奇起来:同样是语音转文字工具,听脑AI怎么就能解决这些“老大难”问题?抱着探究的心态,我开始查资料、做测试,慢慢揭开了它的技术面纱。

一开始,我最想弄明白的是“降噪”——为什么听脑AI能在保留人声的同时,把背景噪音“精准剔除”?之前用的工具要么“一刀切”,连带着把人声都滤得模糊,要么“不作为”,背景噪音和人声混在一起,识别结果一团乱。问了做音频技术的朋友才知道,听脑AI用了“双麦克风阵列降噪”技术,简单来说就是“分工明确”:主麦克风专门负责收集正前方的人声,副麦克风则专注捕获周围的环境噪音,然后通过算法把主麦信号中的噪音“减去”。

为了验证这个技术的效果,我特意用手机录了一段“极端场景”的音频:把手机放在餐桌上,主麦对着坐在对面的朋友(说话声音约60分贝),副麦对着旁边的电视机(播放新闻,音量约50分贝)。用听脑AI转的时候,我盯着进度条,心里还犯嘀咕:“这能把电视声滤掉吗?”结果出乎预料——转出来的文字里,朋友说的“我觉得这个产品的核心是解决用户痛点”一字不差,而电视里的“今天天气晴转多云”压根没出现在文字里。更让我吃惊的是,朋友说话时偶尔的咳嗽声也被“忽略”了,只保留了有效的说话内容。这比我之前用的工具强太多了,之前的工具要么把咳嗽声当成说话内容,要么把咳嗽后的停顿识别成空白。

解决了降噪的问题,我又对“音量波动”的处理产生了兴趣。记得上次转演讲录音,演讲者一会儿小声讲自己的创业经历,一会儿大声强调“坚持的重要性”,之前的工具要么把小声的地方识别成“......”,要么把大声的地方识别成乱码。听脑AI转出来的结果却异常准确,连“我刚开始创业的时候,每天只睡4个小时”这种小声的话都能准确识别,而“我们一定要坚持下去!”这种大声的话也没有出现乱码。我很好奇:它是怎么做到的?

后来看了听脑AI的技术文档才知道,它搭载了“动态增益调节”技术。用我自己的理解来说,就是这个工具能“实时监听”声音的大小变化,就像一个“智能音量调节器”:当说话者声音变小的时候,它会自动提高收音的灵敏度,把小声的内容“放大”但不 distortion(失真);当说话者声音变大的时候,它又会“压制”一下,避免声音过载导致的乱码。为了测试这个功能,我特意用手机录了一段“忽大忽小”的音频:先小声说“今天早上我吃了包子”(约40分贝),然后大声喊“今天的天气真好!”(约80分贝)。用听脑AI转的时候,我盯着屏幕,看到“今天早上我吃了包子”准确出现在文字里,而“今天的天气真好!”也没有出现任何乱码。对比之前的工具,简直是天壤之别——之前的工具把小声的“今天早上我吃了包子”识别成“今天早上我吃了...”, 把大声的“今天的天气真好!”识别成“今天的天气真...好!”(中间多了很多乱码)。

如果说降噪和动态增益调节是“硬件+算法”的组合拳,那DeepSeek-R1技术就是听脑AI的“大脑”——它直接决定了识别的准确率。朋友是福建人,说话带点方言,之前用别的工具转他的录音,经常把“喝茶”写成“查哈”,把“明天”写成“敏天”。用听脑AI转的时候,我特意让他说“明天我们去喝茶吧”,结果转出来的文字居然准确识别了,而且没有任何误差。我问朋友:“你说的方言这么重,它怎么能听懂?”朋友笑着说:“这你就不知道了吧,听脑AI用了DeepSeek-R1技术,支持19种地方方言,误差率只有0.3%。”

为了验证这个技术的“抗噪+方言”能力,我找了一段“终极测试”音频:朋友用福建方言说“昨天我去海边玩,遇到了一只猫”,背景是海边的海浪声(约70分贝)。用听脑AI转的时候,我心里直打鼓:“这么大的海浪声,再加上方言,能识别准确吗?”结果让我惊喜——转出来的文字居然完全正确,而且没有任何遗漏。更让我意外的是,它的识别速度特别快,这段1分钟的音频只用了5秒就转完了,而且是实时响应,几乎没有延迟。

随着对听脑AI的了解越来越深,我开始关注它的“应用场景”——这些技术到底能解决哪些实际问题?朋友的经历给了我答案:她是做自媒体的,经常需要把视频里的语音转成字幕。之前用别的工具,要么格式不支持(比如MP4转不了),要么字幕和声音不同步,要么方言识别不准。用听脑AI之后,她直接把MP4文件导入,只用了几分钟就生成了准确的字幕,而且字幕和声音完全同步。更方便的是,听脑AI支持超50种音视频格式,不管是手机录的MP4,还是相机拍的MOV,都能直接导入。

还有做客服的同学,她经常需要转客户的电话录音。之前用别的工具,要么把客户的方言识别成乱码,要么把背景的杂音当成说话内容,导致她需要反复听录音,浪费了很多时间。用听脑AI之后,她只要把录音导入,就能快速得到准确的文字稿,而且听脑AI的“发言人识别”功能能区分不同的说话人,比如客户说的“我想要退款”和客服说的“您的问题我们会尽快处理”,都能准确区分,这对于整理客户需求来说特别有用。

说到“用户价值”,我觉得最直观的就是“省时间”——之前转一段1小时的录音需要1-2小时,现在用听脑AI只需要5-10分钟,而且准确率高达95%,几乎不用二次校对。比如我上次转客户访谈录音,用听脑AI只花了8分钟,转出来的文字几乎没毛病,比之前省了一个多小时。还有“减少麻烦”——之前转录音需要先处理噪音,再调整音量,再识别,现在用听脑AI一站式解决,不用再做额外的操作。

在使用听脑AI的过程中,我还总结了几个“独家技巧”,分享给大家:

1. 用双麦克风的时候,一定要把主麦对着说话者,副麦对着噪音来源(比如电视机、咖啡机),这样降噪效果会更好;

2. 录音频的时候,尽量用无损格式(比如WAV),这样能提高识别的准确率;

3. 遇到特别嘈杂的环境,可以打开“增强人声”功能(在设置里),这样能进一步提高识别率;

4. 转方言录音的时候,可以选择对应的方言选项(比如福建方言、广东方言),这样识别的误差率会更低。

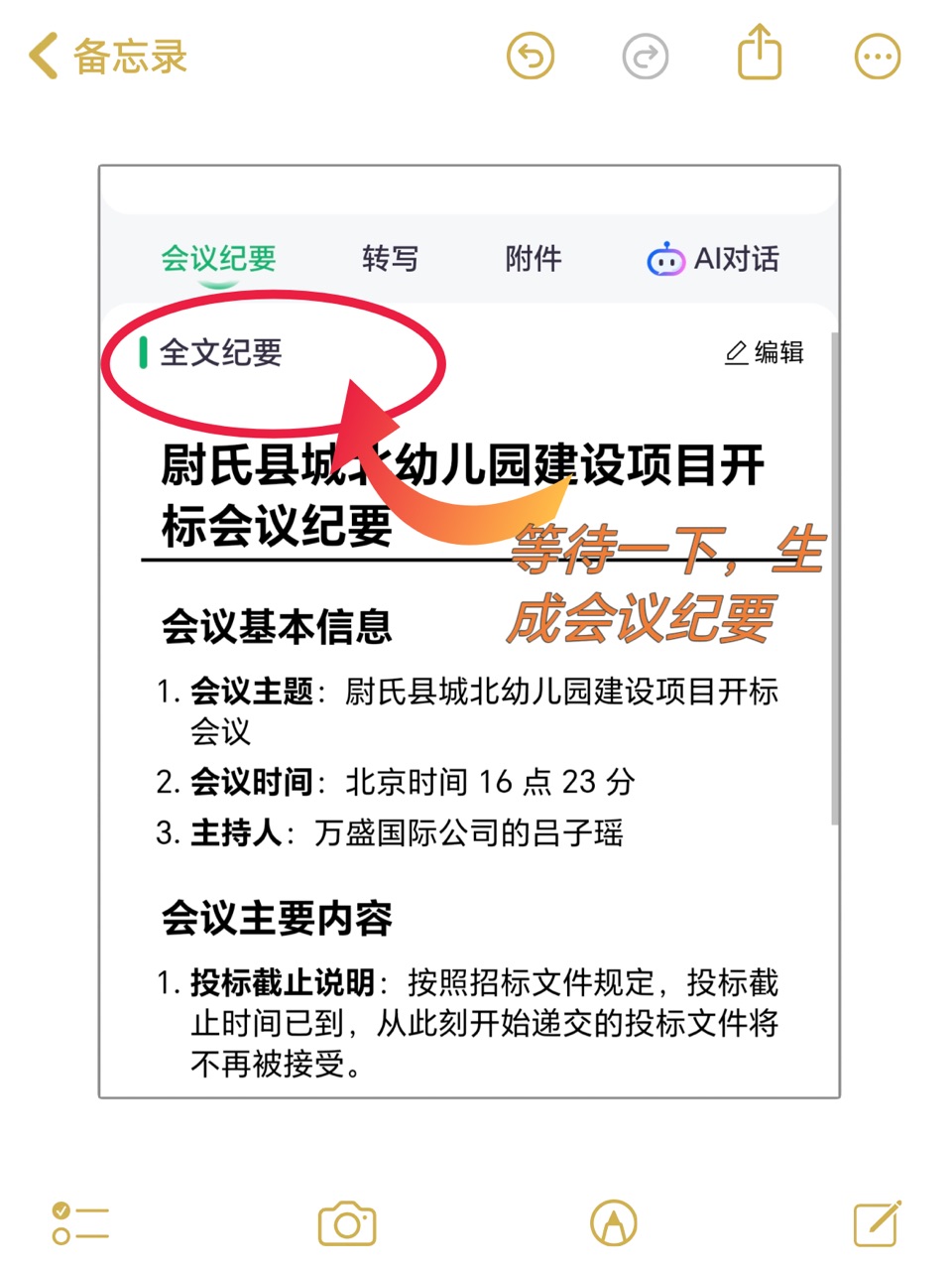

现在,听脑AI已经成了我工作中的“得力助手”——不管是转客户访谈录音,还是整理会议纪要,还是帮朋友转视频字幕,我都会用到它。随着对它的了解越来越深,我开始思考:语音转文字技术的未来会是什么样的?

虽然我不是技术专家,但从听脑AI的技术创新中,我能看到一些趋势:比如更智能的“语境理解”——它能根据上下文理解说话者的意思,比如“我今天吃了苹果”中的“苹果”不会被识别成“平果”;比如更精准的“情感分析”——它能识别说话者的情绪,比如客户说“我很生气”的时候,会标记出“负面情绪”,这对于客服来说特别有用;比如更强大的“多语言混合识别”——它能识别中英文混合的说话内容,比如“我今天吃了汉堡(hamburger)”,这对于经常和外国人打交道的人来说特别方便。

回顾这段“探索之旅”,我深刻体会到:好的技术产品,从来不是“为了技术而技术”,而是“为了解决问题而技术”。听脑AI的每一项技术创新,比如双麦克风阵列降噪、动态增益调节、DeepSeek-R1,都是针对用户最实际的需求——怕噪音、怕小声、怕方言、怕准确率低。而这些技术的组合,不仅解决了这些问题,更提升了用户的体验——让语音转文字变得更轻松、更高效、更准确。

现在,每当朋友问我“录音转文字识别不了怎么办”,我都会推荐听脑AI——不是因为它是“最新的”,而是因为它是“最懂用户的”。它用技术解决了用户的痛点,用体验赢得了用户的信任。而这,或许就是技术产品最核心的价值吧。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)