一文吃透大模型微调技术(附源码解释)

微调的本质是**在预训练模型基础上,使用特定任务数据集进行二次训练**,使模型参数适应新任务。其核心逻辑是:冻结预训练模型大部分参数(或全部参数),仅调整部分参数(或全部),以较小的计算成本让模型学习任务特性,而我们需要微调就要先了解整体微调的结构包含哪些部分,接下来我们就来认识一下

在大模型时代,预训练模型如GPT、LLaMA等已经具备强大的通用能力,但在特定领域(如医疗、法律、代码生成)的表现仍需进一步优化才能表现出更好的效果。那应该如何优化才能让模型朝着你满意的方向进行呢,人工智能在发展中优秀的工程师们早已探索出这一问题的答案,当然答案各有不同,但是现在应用最广泛的当属大模型微调技术,如果你不知道什么是微调,那么我想下面这篇微调入门概念将会给你独到的见解(大模型微调知识一文解析),接下来我们就来一起见识一下微调的代码魅力,本文将以Lora微调为例,详解微调的整体结构、代码实现、不同微调方式的差异及常见问题解决办法,请紧跟思路让我们揭开微调的面纱。

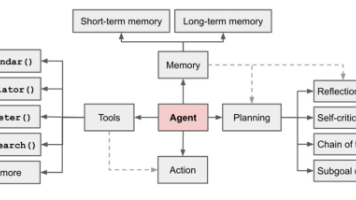

一、微调的整体结构说明

微调的本质是在预训练模型基础上,使用特定任务数据集进行二次训练,使模型参数适应新任务。其核心逻辑是:冻结预训练模型大部分参数(或全部参数),仅调整部分参数(或全部),以较小的计算成本让模型学习任务特性,而我们需要微调就要先了解整体微调的结构包含哪些部分,接下来我们就来认识一下。

1.1 微调代码的核心组成部分

无论采用哪种微调方式,代码框架都应该包含以下5个核心模块:

| 模块名称 | 功能说明 |

|---|---|

| 数据处理模块 | 加载原始数据、清洗、格式转换(如转为对话格式)、分词、构建数据集 |

| 模型加载模块 | 加载预训练模型、配置微调策略(如Lora、全量微调)、定义模型输出格式 |

| 训练配置模块 | 设置训练参数(batch size、学习率、epoch等)、优化器、学习率调度器 |

| 训练执行模块 | 定义训练循环(前向传播、损失计算、反向传播、参数更新)、日志记录 |

| 评估与保存模块 | 验证模型性能(如困惑度、准确率)、保存微调后的模型(或适配器参数) |

除此五个模块外剩下的代码就是根据你自己微调的模型与个人喜好或者个人写代码的习惯所添加的内容,并不是微调的必须要求。

1.2 微调代码框架示例

接下来我们以一个通用的微调代码框架(以PyTorch+Transformers为例)带你走进微调的世界:

# 1. 数据处理模块

from datasets import load_dataset

from transformers import AutoTokenizer

# 加载数据

dataset = load_dataset("json", data_files="train_data.jsonl")

# 加载分词器

tokenizer = AutoTokenizer.from_pretrained("base_model_path")

# 定义分词函数

def preprocess_function(examples):

# 处理文本为模型输入格式(如input_ids、labels)

return tokenizer(examples["text"], truncation=True, max_length=512)

# 应用分词

tokenized_dataset = dataset.map(preprocess_function, batched=True)

# 2. 模型加载模块

from transformers import AutoModelForCausalLM, TrainingArguments, Trainer

from peft import LoraConfig, get_peft_model # Lora相关

# 加载预训练模型(这一步需要加载自己所需要微调的模型,也可以直接在Hugging Face下载)

model = AutoModelForCausalLM.from_pretrained("base_model_path")

# 配置Lora(可选,全量微调无需此步)

lora_config = LoraConfig(

r=8, lora_alpha=32, target_modules=["q_proj", "v_proj"], lora_dropout=0.05

)

model = get_peft_model(model, lora_config) # 包装为Lora模型

# 3. 训练配置模块

training_args = TrainingArguments(

output_dir="./fine_tuned_model",

per_device_train_batch_size=4,

gradient_accumulation_steps=4,

learning_rate=2e-4,

num_train_epochs=3,

logging_steps=10,

save_steps=100

)

# 4. 训练执行模块

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

)

trainer.train() # 启动训练

# 5. 评估与保存模块

model.save_pretrained("final_model") # 保存模型(Lora仅保存适配器)

二、Lora微调代码各部分详解

接下来我们来看一下何为 Lora 微调? Lora(Low-Rank Adaptation)是一种参数高效微调方法,通过冻结预训练模型权重,仅训练低秩矩阵适配器,大幅降低计算成本。下面我们来基于transformers和peft库的Lora微调来做一个详细解析。

2.1 数据处理模块

数据处理的核心是将原始文本转换为模型可接受的输入格式(大体为 input_ids、attention_mask、labels(labels可有可无,如果无在参数中指定即可,具体看自己微调的数据而定))。以对话数据为例:

from datasets import load_dataset

from transformers import AutoTokenizer

# 1. 加载数据(一般为JSONL格式:每行一条对话数据)

dataset = load_dataset("json", data_files={"train": "train.jsonl", "test": "test.jsonl"})

# 2. 加载分词器(这里的分词器需与预训练模型匹配)

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-2-7b-chat-hf")

tokenizer.pad_token = tokenizer.eos_token # 设置填充符

# 3. 定义数据预处理函数(将对话转为模型输入)

def process_conversation(examples):

# 对话格式:"USER: {问题}\nASSISTANT: {回答}"

prompts = [

f"USER: {q}\nASSISTANT: {a}"

for q, a in zip(examples["question"], examples["answer"])

]

# 分词(返回input_ids、attention_mask)

inputs = tokenizer(

prompts,

truncation=True,

max_length=512,

padding="max_length",

return_tensors="pt"

)

# 设置labels(与input_ids相同,因为是生成式任务)

inputs["labels"] = inputs["input_ids"].clone()

return inputs

# 4. 应用预处理(批量处理,加速)

tokenized_data = dataset.map(

process_conversation,

batched=True,

remove_columns=dataset["train"].column_names # 移除原始列

)

关键说明:

- 分词时需指定

max_length和padding,确保输入长度一致; labels用于计算损失,生成任务中通常与input_ids相同(部分场景可mask用户输入)。

2.2 模型加载与Lora配置

Lora的核心是在模型的注意力层插入低秩适配器,仅训练这些适配器参数,所以大大减少了训练资源,接下来我们来看看在代码中如何体现:

from transformers import AutoModelForCausalLM

from peft import LoraConfig, get_peft_model, prepare_model_for_kbit_training

# 1. 加载预训练模型(4bit量化,减少显存占用)

model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-2-7b-chat-hf",

load_in_4bit=True, # 4bit量化

device_map="auto", # 自动分配设备

torch_dtype=torch.bfloat16 # 数据类型

)

# 准备模型(启用梯度检查点、禁用_dropout等)

model = prepare_model_for_kbit_training(model)

# 2. 配置Lora参数

lora_config = LoraConfig(

r=16, # 低秩矩阵维度(越大能力越强,计算成本越高)

lora_alpha=32, # 缩放因子(通常为r的2倍)

target_modules=[ # 目标层(不同模型层名不同,需根据模型结构调整)

"q_proj", "k_proj", "v_proj", "o_proj", # Llama的注意力层

"gate_proj", "up_proj", "down_proj" # Llama的FeedForward层

],

lora_dropout=0.05, # Dropout概率

bias="none", # 不训练偏置

task_type="CAUSAL_LM" # 任务类型(因果语言模型)

)

# 3. 将模型包装为Lora模型

model = get_peft_model(model, lora_config)

# 打印可训练参数比例(Lora通常仅占0.1%-1%)

model.print_trainable_parameters()

# 输出示例:"trainable params: 1,887,436,800 || all params: 6,707,005,440 || trainable%: 28.14"

关键说明:

target_modules需与模型结构匹配(如LLaMA的注意力层是q_proj,GPT-2是c_attn);- 4bit/8bit量化可大幅降低显存需求(7B模型从28GB降至4GB,大大减少训练所需资源,当然对于模型精度也有较大影响,会有较大的精度损失)。

2.3 训练配置与执行

训练配置决定了微调效果和效率,需根据硬件资源调整:

from transformers import TrainingArguments, Trainer, DataCollatorForLanguageModeling

# 1. 数据收集器(处理批量数据,生成mask等)

data_collator = DataCollatorForLanguageModeling(

tokenizer=tokenizer,

mlm=False # 因果语言模型无需掩码语言建模

)

# 2. 训练参数配置

training_args = TrainingArguments(

output_dir="./llama2-lora-finetune", # 模型保存路径

per_device_train_batch_size=4, # 单卡batch size(根据显存调整)

gradient_accumulation_steps=4, # 梯度累积步数(等效增大batch size)

learning_rate=2e-4, # 学习率(Lora通常比全量微调大10-100倍)

num_train_epochs=3, # 训练轮数(代表只训练三轮)

logging_steps=50, # 日志打印间隔(这里代表每五十步打印一次loss值)

save_steps=200, # 模型保存间隔

warmup_steps=100, # 学习率热身步数

fp16=True, # 启用混合精度训练(加速且省显存)

report_to="none" # 不使用wandb等日志工具

)

# 3. 初始化Trainer并启动训练

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_data["train"],

eval_dataset=tokenized_data["test"],

data_collator=data_collator

)

trainer.train()

关键说明:

gradient_accumulation_steps:显存不足时,可设为4(等效batch size=4×4=16);- 学习率:Lora微调时,因仅训练少量参数,学习率可设为

1e-4~3e-4(全量微调通常为1e-5,通常学习率以一个较小的数值开始最好)。

2.4 模型保存与推理

Lora微调仅保存适配器参数(体积很小,通常几MB到几十MB):

# 保存Lora适配器

model.save_pretrained("llama2-lora-adapter")

# 推理示例

from peft import PeftModel

# 加载底座模型

base_model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-2-7b-chat-hf",

device_map="auto"

)

# 加载Lora适配器

lora_model = PeftModel.from_pretrained(base_model, "llama2-lora-adapter")

# 生成文本

inputs = tokenizer("USER: 什么是Lora微调?\nASSISTANT:", return_tensors="pt").to("cuda")

outputs = lora_model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

三、其他微调与Lora微调的差异

除 Lora 外,常见的微调方式还有全量微调、Prefix Tuning、IA³等,它们在代码实现和适用场景上有显著差异。

3.1 全量微调(Full Fine-tuning)

代码差异:

无需peft库,直接训练所有参数,有条件的可以试试全量微调,全量微调所需要的资源量是庞大的,一般不建议如此:

# 全量微调模型加载(无Lora配置)

model = AutoModelForCausalLM.from_pretrained("base_model_path")

# 所有参数均可训练

model.train()

核心意义:

- 优点:因为是全量微调那有点肯定是理论上性能最优,可充分适配任务;

- 缺点:缺点也很明显计算成本极高(13B模型全量微调需至少100GB显存),易过拟合(数据量小时)。

- 适用场景:大模型(如70B)+ 大规模数据集(百万级以上)+ 充足算力。

3.2 Prefix Tuning

代码差异:

仅在输入前缀插入可训练参数,冻结模型主体:

from peft import PrefixTuningConfig, get_peft_model

# Prefix配置

prefix_config = PrefixTuningConfig(

task_type="CAUSAL_LM",

num_virtual_tokens=32 # 前缀token数量

)

model = get_peft_model(model, prefix_config)

核心意义:

- 优点:参数更少(仅需训练前缀token的嵌入),适用于序列生成任务;

- 缺点:性能通常弱于Lora,前缀长度需调参。

- 适用场景:文本生成(如摘要、翻译),尤其是小数据集场景。

3.3 Lora与其他方式的核心区别

| 维度 | Lora | 全量微调 | Prefix Tuning |

|---|---|---|---|

| 可训练参数占比 | 0.1%-1% | 100% | 0.01%-0.1% |

| 显存需求 | 低(7B模型需4-8GB) | 极高(7B模型需28GB+) | 极低(7B模型需2-4GB) |

| 训练速度 | 快 | 慢 | 最快 |

| 任务适应性 | 强(通用) | 强(但数据需求高) | 中等(偏生成) |

| 保存文件大小 | 小(MB级) | 大(GB级) | 极小(KB级) |

四、微调常见问题及解决办法

微调过程中常遇到显存不足、过拟合、训练不稳定等问题,以下是针对性解决方案:

4.1 显存不足(CUDA Out of Memory)

原因:模型过大、batch size设置不合理、未启用量化或混合精度。

解决办法:

- 启用量化:

load_in_4bit=True(4bit量化可节省75%显存); - 减小

per_device_train_batch_size(如从4→2),增大gradient_accumulation_steps(保持总batch不变); - 启用梯度检查点:

model.gradient_checkpointing_enable()(牺牲20%速度,节省40%显存); - 缩短序列长度:

max_length从1024→512(需确保数据完整性)。

4.2 过拟合(训练损失低,验证损失高)

原因:数据集过小、模型能力过强、训练轮数过多。

解决办法:

- 增加数据量:通过数据增强(如同义词替换、回译)扩充样本;

- 降低模型能力:减少Lora的

r值(如从32→16),或使用小模型; - 早停策略:

TrainingArguments(load_best_model_at_end=True, metric_for_best_model="eval_loss"); - 正则化:增加

lora_dropout(如从0.05→0.1),或使用权重衰减(weight_decay=0.01)。

4.3 训练速度慢(GPU利用率低)

原因:batch size过小、数据加载瓶颈、未启用加速技术。

解决办法:

- 增大

per_device_train_batch_size(在显存允许范围内); - 多进程数据加载:

dataset.map(..., num_proc=4)(利用多核CPU); - 启用Flash Attention:

model = AutoModelForCausalLM.from_pretrained(..., use_flash_attention_2=True)(速度提升2-3倍); - 关闭不必要的日志:

report_to="none",减少logging_steps。

4.4 模型不收敛(损失波动或不下降)

原因:学习率不合理、数据格式错误、梯度消失。

解决办法:

- 调整学习率:Lora建议

1e-4~3e-4,全量微调1e-5~5e-5; - 检查数据格式:确保

labels正确(如生成任务中不应包含pad_token的损失); - 启用梯度裁剪:

TrainingArguments(gradient_clip_val=1.0)(防止梯度爆炸); - 初始化问题:重新加载预训练模型,确保未意外修改底座参数。

总结

微调是大模型落地特定场景的关键技术,而Lora凭借参数效率高、训练成本低的优势,成为中小团队的首选方案。本文从整体结构、代码细节、方法对比和问题解决四个维度,详解了微调的实践路径。实际应用中,需根据数据规模、硬件资源和任务需求,选择合适的微调策略,并通过多次实验优化参数。

掌握微调技术后,你可以让通用大模型在垂直领域(如医疗诊断、金融分析)发挥出更专业的能力,为业务赋能。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)