手把手教你:用AI高效辅助做接口自动化

如何利用AI提升接口自动化测效率。文章指出传统测试存在三大痛点:用例设计耗时、脚本编写重复、维护成本高。最后介绍了多轮对话调教、工具集成、提示词库等进阶技巧,强调AI能帮助测试人员从执行者转变为设计者,实现价值跃迁。

大家好。今天,只谈一件能让你上班就用得上、效率立刻提升的实战技能:如何利用好AI,做接口自动化测试的方式。

一、传统接口测试的3大效率瓶颈

在引入AI之前,我们每个做接口的测试工程师,或多或少都面临着三大效率瓶颈:

-

用例设计耗时耗力:一个复杂的接口,要穷举各种正常、异常、边界值场景,往往需要半天甚至一天的时间,枯燥且容易遗漏。

-

脚本编写重复低效:大量的

request、assert、json解析代码,80%都是重复劳动,不仅占用了大量时间,还容易因代码编写错误而引入Bug。 -

技术债越积越多:项目快速迭代,接口文档更新不及时,导致自动化脚本维护成本增高,可能会最终成为“一次性资产”。

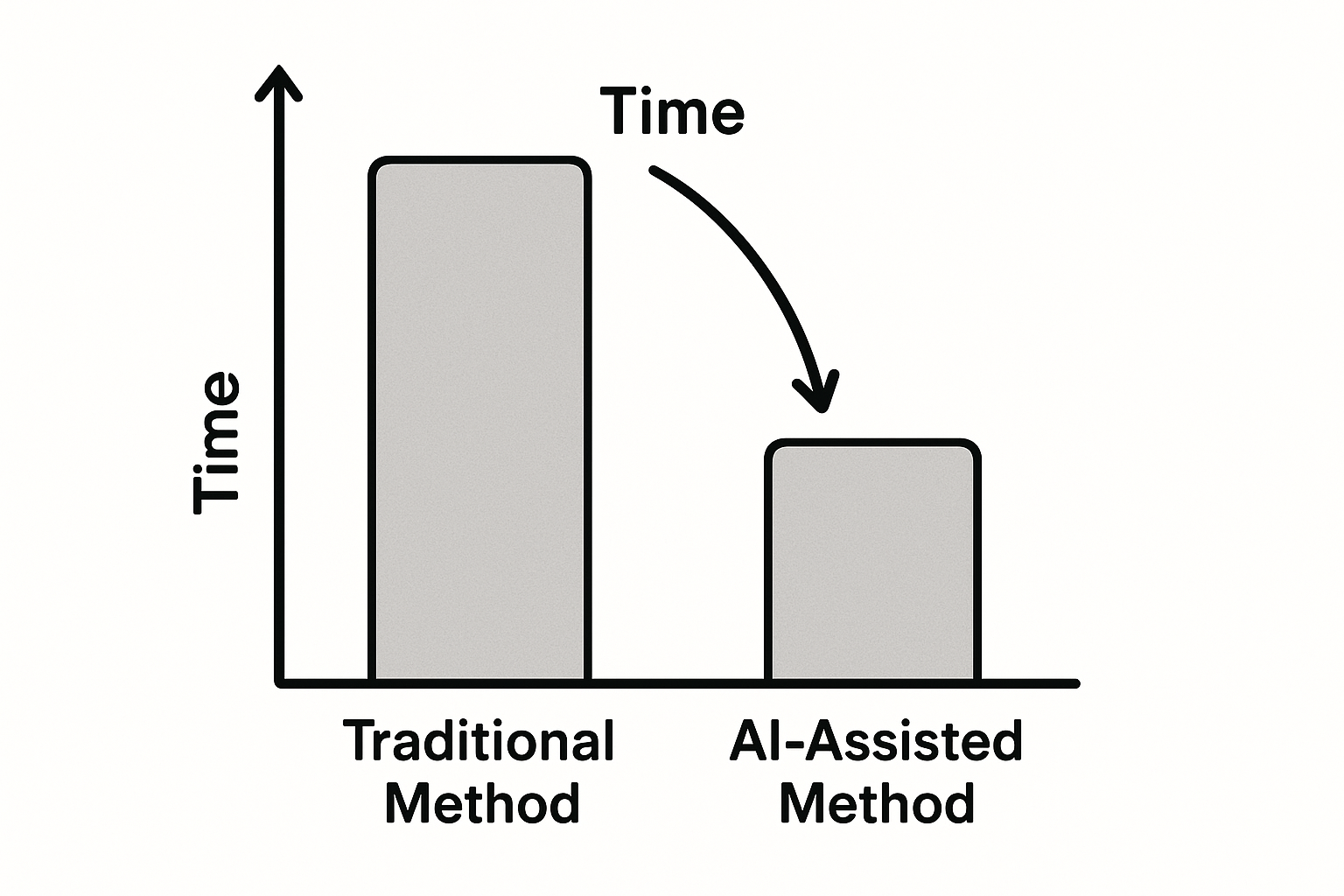

通过实践使用ChatGPT来辅助的话,接口自动化的整体效率平均提升了差不多70%,特别是用例设计和初步脚本编写环节,能节省近90%的时间。

二、从3天到半天的转变

在此之前,我想先分享一段我的真实经历,让你直观感受AI带来的冲击。

项目背景与困境

去年的时候,我接手了一个电商项目的订单中心微服务的后端接口升级。这个项目有超过50个核心接口,业务逻辑复杂,状态流转多。之前按照传统方式,我的任务计划是:

-

第一阶段(用例设计):根据原有的接口Api文档和PRD,为50个接口设计约800个测试用例,花费了5个工作日。

-

第二阶段(脚本编写):使用Python + Pytest + Requests框架,将这800个用例转化为自动化脚本做回归测试,花费了8个工作日。

家可以看到,整个过程不仅周期长,而且在编写测试用例的时候,我发现自己总是在“参数非空”、“格式错误”这类基础验证上花费了大量的时间,而对“多笔订单并发创建时,优惠券计算是否正确”这类深层业务逻辑的覆盖,反而自己思考得不够。

引入AI

项目提测后进行到第三天,我只完成了不到10个接口的用例编写,测试进度严重滞后。后来我就决定尝试一下用ChatGPT来辅助。我选择的第一个场景是“创建订单”这个最核心的接口。

我当时没有直接让它“写用例”,而是先投喂给它完整的、脱敏的API文档、关键的业务规则和数据校验逻辑。然后,我给它了第一个提示词:“请为上传的文档和相关内容设计一套完整的接口测试用例,覆盖功能、异常、边界和安全场景,并以表格形式输出。”

大概不到5分钟吧,它就生成了一份包含近50个测试点的用例表格,远超我花费半天的时间了。

改善效果

经过那次尝试,让我改变了原有的工作模式。到了整个项目的后期,我开始引入了AI辅助:

-

用例编写速度:从平均1小时/接口,提升到5分钟/接口。整个用例设计阶段,从原计划的5天,缩短到了半天。

-

测试覆盖率:AI补充了大量我个人容易忽略的异常场景(如特殊字符、Emoji表情、超长字符串等)。

-

缺陷发现率:在联调测试阶段,我们基于AI生成的异常用例,提前发现了3个由数据溢出和并发处理不当引发的P1级缺陷,这在以往的测试中是很难在早期发现的。

立即实践:回想一下你最近测试过的一个接口,你花了多长时间设计用例?试着把它的需求文档喂给ChatGPT,看看它需要多长时间。

三、核心问题与解决办法

当然,AI不是金枪银弹,它生成的用例和代码是并不能100%直接使用的。在实践中,总结了3个最常见的问题以及对应的解决办法。

问题1:AI生成用例不够准确,缺乏业务逻辑

具体表现:生成的用例大多是“参数级别”的,比如非空、类型、长度验证,但缺少对关键业务逻辑的验证场景。例如,它会验证订单金额不能为空,但不会验证“当用户等级为VIP时,订单金额是否自动打了9折”。

解决办法:

-

提示词优化:提供“业务上下文”,不要只给它API文档,要把“业务规则”作为最重要的信息喂给它。

【优化前提示词】

请为POST /orders接口写测试用例。请求体是{...}。【优化后提示词】

# 角色你是一名资深的电商业务测试专家。# 任务为“创建订单”接口(POST /orders)设计一份完整、详尽的接口测试用例,符合测试专家的用例评审的严格要求。# API定义请求体: {请求方式、请求头、请求地址...}响应体: {...}# 核心业务规则(最重要!)1. 用户等级为VIP(level=1)时,总价(totalPrice)享受9折优惠。2. 使用优惠券(couponId)时,需验证优惠券状态是否有效。3. 每个订单最多只能购买10件商品。# 输出要求1. 每条用例内容体现:用例名称测试目的测试内容测试步骤(输入及操作+预期结果及评价标准+实际结果)测试用例通过准则2. 页面凡涉及到点击的空间,一律用【】表示。3. 页面凡涉及到页面的表述,一律用“”表示。4. 请重点设计与核心业务规则相关的用例,并单独分组展示。#示例模版:用例名称:简洁描述测试用例的目的。测试步骤:详细描述测试的操作步骤。实际结果:描述每条测试用例通过标准的预期。

AI返回的具体结果,在之前文章有提到,就不在这里赘述了。

Louie,公众号:Pianoboi手把手教你:用AI高效辅助编写测试用例

2. 迭代优化:分步骤引导AI思考不要指望一步到位。先让它生成基础用例,再针对性地追问业务逻辑。

第一轮:“先为我生成覆盖所有参数基本验证的用例。”

第二轮:“很好,现在基于以上用例,为我补充‘VIP用户下单自动打9折’这个业务规则的测试用例,需要包含正向和反向场景。”

-

质量检查清单:拿到AI生成的用例后,用下面5个标准快速检查:

1. 是否覆盖了所有业务规则?

2. 关键字段的边界值(最大、最小、临界)是否已测试?

3. 核心业务流程“状态”是否都已验证?(如:用已过期的优惠券下单)

4. 是否考虑了并发操作的场景?

5. 负向用例的预期结果是否明确?(如:明确的错误码和错误信息)

问题2:生成的代码无法直接运行

具体表现:生成的Python/Java代码缺少依赖库、URL写死、没有配置文件,直接复制到本地IDE里一堆红线。

解决办法:

-

环境信息补充:在提示词中明确告知你的技术栈和框架。

# 技术栈与环境- 编程语言: Python 3.9- 测试框架: Pytest- HTTP库: Requests- 项目结构: 根目录下有config.ini文件用于存放base_url。请基于以上信息,为我生成可运行的Pytest测试代码。

代码调试标准流程:

-

-

第一步:依赖检查。将代码粘贴到IDE后,第一件事就是检查

import部分,安装所有缺失的库(pip install pytest requests)。 -

第二步:配置分离。将代码中写死的URL、账号密码等提取到配置文件中。

-

第三步:单步调试。运行代码,遇到第一个错误时,复制完整的错误信息,直接丢回给ChatGPT,并提问:“我的代码报了这个错,请帮我分析原因并修复它。” 90%的常见错误它都能解决。

常见错误快速修复技巧:

-

ConnectionError:大概率是URL不对或网络不通。检查你的base_url。 -

KeyError:访问JSON字典的键不存在。让AI帮你加上安全的.get()方法或try-except块。 -

AssertionError:断言失败。这是最有价值的错误,说明你可能发现了一个Bug!

-

问题3:测试数据隐私安全问题

具体表现:为了让AI理解业务,直接把包含用户手机号、身份证的真实API报文发给了ChatGPT。

解决方案:

小贴士:永远,永远不要将任何生产环境的敏感数据发送给任何公共的AI模型!

-

数据脱敏:这是最基本也是最重要的一步。

规则替换:将"phone": "13812345678"替换为"phone": "13800000000"

数据泛化:将"address": "北京市海淀区中关村大街1号"替换为"address": "某个模糊的地址"。

类型描述:直接告诉AI字段的类型和规则而不是给它真实数据。"idCard": "一个18位的中国身份证号码字符串"。

-

内网环境下的替代方案:如果你的公司安全策略极严,可以考虑部署内网私有化的大语言模型(如ChatGLM等),在保证安全的前提下享受AI带来的便利。

-

敏感信息处理原则:只提供“结构和规则”,不提供“内容”。AI需要知道

token是一个字符串,但不需要知道token的具体值。

立即实践:找一个你写过的接口测试脚本,检查一下里面有没有硬编码的敏感信息。试着用数据脱敏的方法,改写一个不包含任何真实数据的版本。

四、3个让效率再提升的技巧

当你熟练掌握了基础用法后,下面3个高级技巧,能让你真正从“使用者”转变为“掌握者”。

技巧1:用“多轮对话”把AI调教成专业人

AI使用者,基本都善于通过连续地追问,把一个泛泛的AI模型,在当前对话中“调教”成特定领域的专业人。

迭代优化流程:

-

设定角色:

你现在是一名XX领域的专家。 -

提供知识:

这是我们项目的背景和核心资料... -

下达任务:

请完成第一个任务... -

反馈与修正:

你做的很好,但A部分需要优化,请按照我的要求修改... -

深化任务:

现在,基于我们刚才优化的结果,进行下一步...

【实际对话示例】

我:“你现在是一名资深的支付系统测试专家。”

AI:“好的,我已经准备好了。请问有什么可以帮您?”

我:“这是我们支付网关的API文档(...省略...)。请先为‘创建支付订单’接口生成核心的成功场景用例。”

AI:“(...生成成功用例...)”

我:“非常棒。现在,请补充‘微信支付’渠道下的异常场景,特别是要考虑网络延迟和用户中途取消支付的情况。”

通过这种方式,AI的回答会越来越聚焦,越来越深入你的业务。

技巧2:结合现有工具(Postman/ApiFox)

AI不仅能写代码,还能生成工具的配置文件,实现无缝集成。

与Postman的整合:你可以直接让AI生成Postman Collection的JSON文件。

请将我们刚才讨论的所有“订单接口”的测试用例,生成一个Postman Collection v2.1.0格式的JSON。每个用例对应一个request。请在tests脚本中断言HTTP状态码为200。将AI返回的JSON内容保存为collection.json文件,直接导入Postman,一个包含所有请求和基础断言的测试集就创建好了!

ApiFox自动化脚本生成:ApiFox支持自定义脚本(JS),你可以让AI帮你完成。

请为ApiFox编写一段后置操作脚本(Javascript),功能是:从名为“登录接口”的响应JSON中,提取`data.token`字段,并设置为环境变量`global_token`。复制生成的JS代码,粘贴到ApiFox的后置操作中,动态关联轻松搞定。

技巧3:建立你的个人提示词库

高效的秘诀在于“复用”。不要每次都从零开始写提示词。

-

分类整理:将你的提示词按照任务类型进行分类,例如:

-

用例设计-功能模板.txt -

用例设计-性能模板.txt -

代码生成-Pytest模板.txt -

工具集成-Postman模板.txt

-

-

个性化定制:在模板中预留出“占位符”,比如

【在此处粘贴API文档】,【在此处填写核心业务规则】。每次使用时,只需要做填空题,极大提升了效率。

小贴士:一个好的提示词模板,是你最宝贵的个人数字资产。

五、AI能够带给我的成长与思考

最后,我想聊聊工具之外的东西。使用AI两年多,它带给我的绝不只是效率的提升。

从“执行者”到“设计者”的思维转变

过去,我80%的时间都在做“怎么实现”的执行工作。现在,AI帮我搞定了大部分执行细节,我终于有时间去思考“测什么更有价值”、“风险在哪里”这类维度的问题。我不再是一个“脚本小子”,而更像一个“测试架构师”。

工作价值的重塑

工作产出,不再是写了多少行代码,或是执行了多少用例。而是:

-

设计的测试策略,覆盖了多少核心风险?

-

通过AI辅助分析,提前发现了多少深层次的缺陷?

-

构建的这套“AI+自动化”流程,为团队节省了多少人力成本?

这,才是我们在AI时代不可替代的核心价值。

学习效率的提高

当需要测试一个我不熟悉的领域(比如GraphQL或gRPC接口)时,我不再需要花几天时间去啃文档。我的第一步是问AI:“请向一个有经验的测试工程师,解释GraphQL测试的核心要点,并给我一个使用Python测试它的最小可用示例。”

AI成为了我强大的学习引擎,让我进入任何一个新领域的速度都加快了不少。

拥抱AI,不是为了偷懒,而是为了让我们站得更高,看得更远。它将我们从重复的、低价值的劳动中解放出来,让我们能聚焦于创造、思考和架构,最终实现个人价值的跃迁。

希望今天的分享,能成为你开启AI辅助测试大门的那把钥匙。现在就去试试吧!

想了解更多AI干货,欢迎大家关注公众号:Pianoboi

#接口测试 #接口自动化 #AI接口测试 #AI #ChatGPT

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)