NVIDIA Chat with RTX安装使用以及设置离线启动

Chat with RTX 是一款演示应用程序,可让您个性化连接到您自己的内容(文档、笔记或其他数据)的 GPT 大型语言模型 (LLM)。利用检索增强生成 (RAG)、TensorRT-LLM 和 RTX 加速,您可以查询自定义聊天机器人以快速获得与上下文相关的答案。而且,由于它们都在您的 Windows RTX PC 或工作站上本地运行,因此您将获得快速且安全的结果。

1.NVIDIA Chat with RTX简介

1.1. 什么是Chat with RTX?

Chat with RTX 是一款演示应用程序,可让您个性化连接到您自己的内容(文档、笔记或其他数据)的 GPT 大型语言模型 (LLM)。利用检索增强生成 (RAG)、TensorRT-LLM 和 RTX 加速,您可以查询自定义聊天机器人以快速获得与上下文相关的答案。而且,由于它们都在您的 Windows RTX PC 或工作站上本地运行,因此您将获得快速且安全的结果。

1.2. Chat with RTX 的优势

数据本地处理:更加关注用户个人隐私

Chat with RTX 的一个重要优势是其本地处理功能。 通过直接在用户的 PC 上运行,在 AI 交互中提供前所未有的速度和响应能力。这种本地执行模型可确保敏感数据保留在用户设备的范围内,从而提供云上人工智能服务无法比拟的隐私和数据安全级别,这也很好的解决了数字时代对数据主权和个人隐私的担忧。

YouTube视频内容分析:视频资讯解析

Chat with RTX 分析和总结 YouTube 视频和文档内容的能力是史无前例的。它采用复杂的人工智能模型来消化大量信息,这种功能对于从新闻和学术界到法律研究和市场分析等各个领域的专业人士来说都是一个福音,使他们能够轻松和高效的筛选大型数据集和视频内容。

2.NVIDIA Chat with RTX下载安装

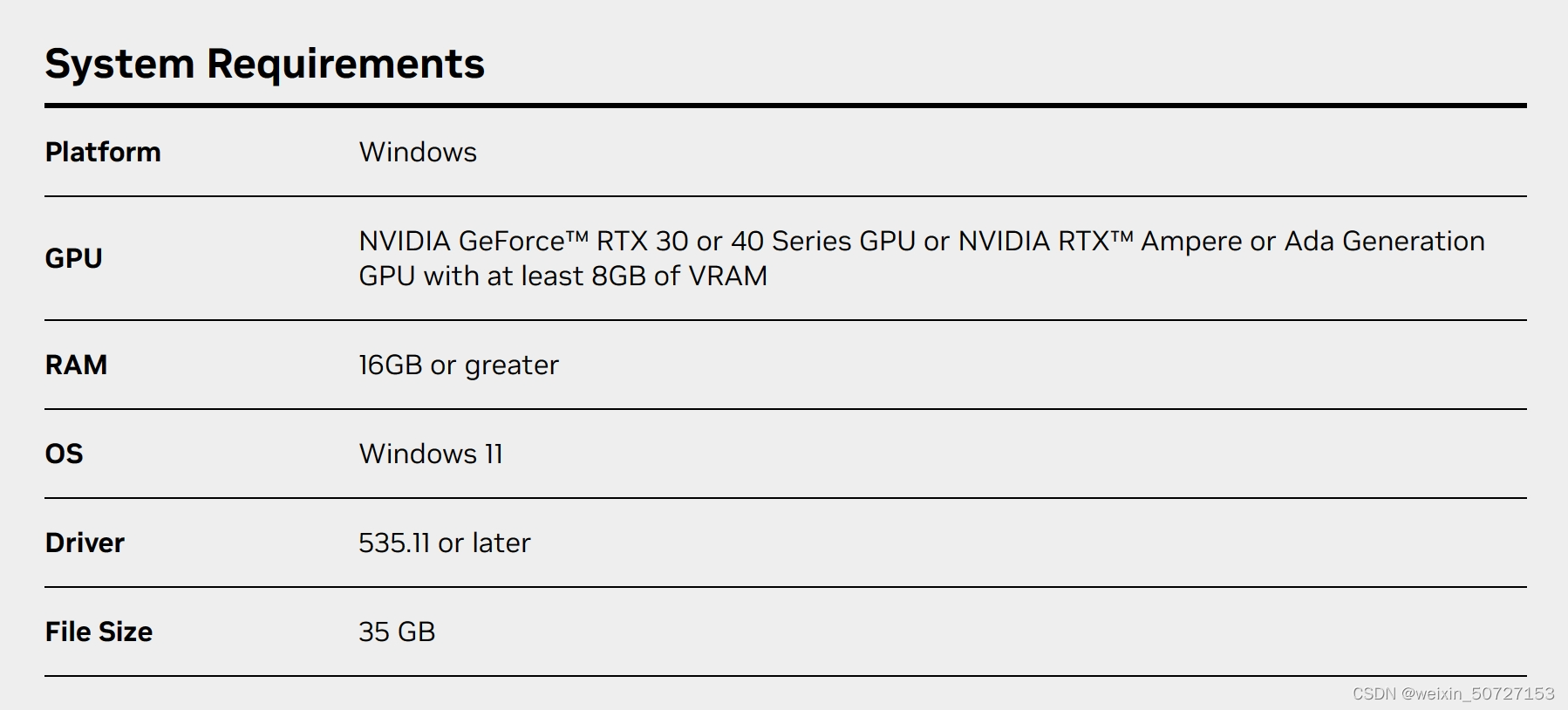

2.1. 硬件要求

Chat with RTX 被设计为一个本地化系统,占用内存较小,只要具有至少 8 GB 显存的 GeForce RTX 30 和 40 GPU 都能支持该应用程序。

2.2.文件下载

- 下载地址:Chat with RTX下载地址

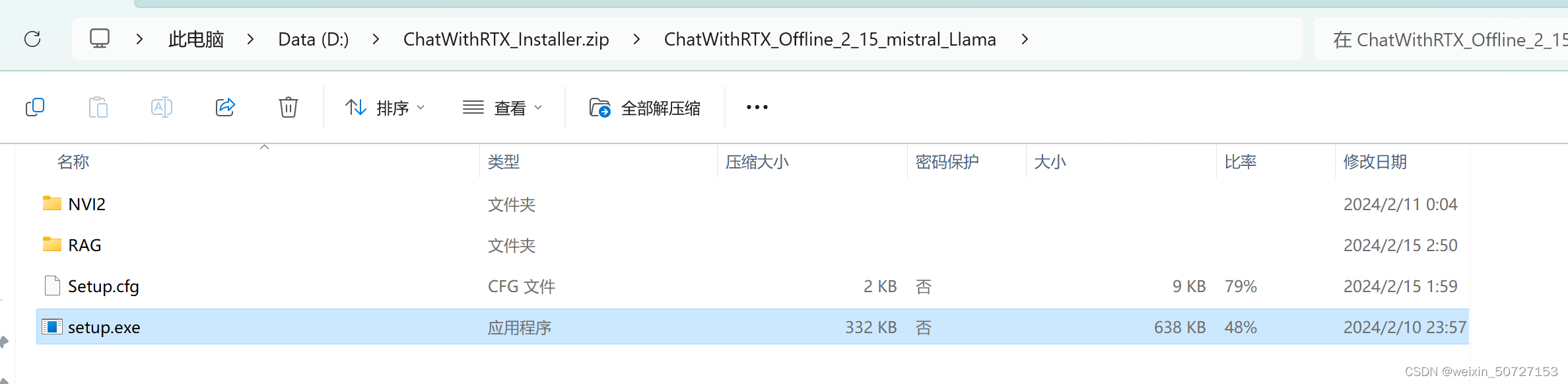

- 下载完成后解压如下图:

2.3.文件安装

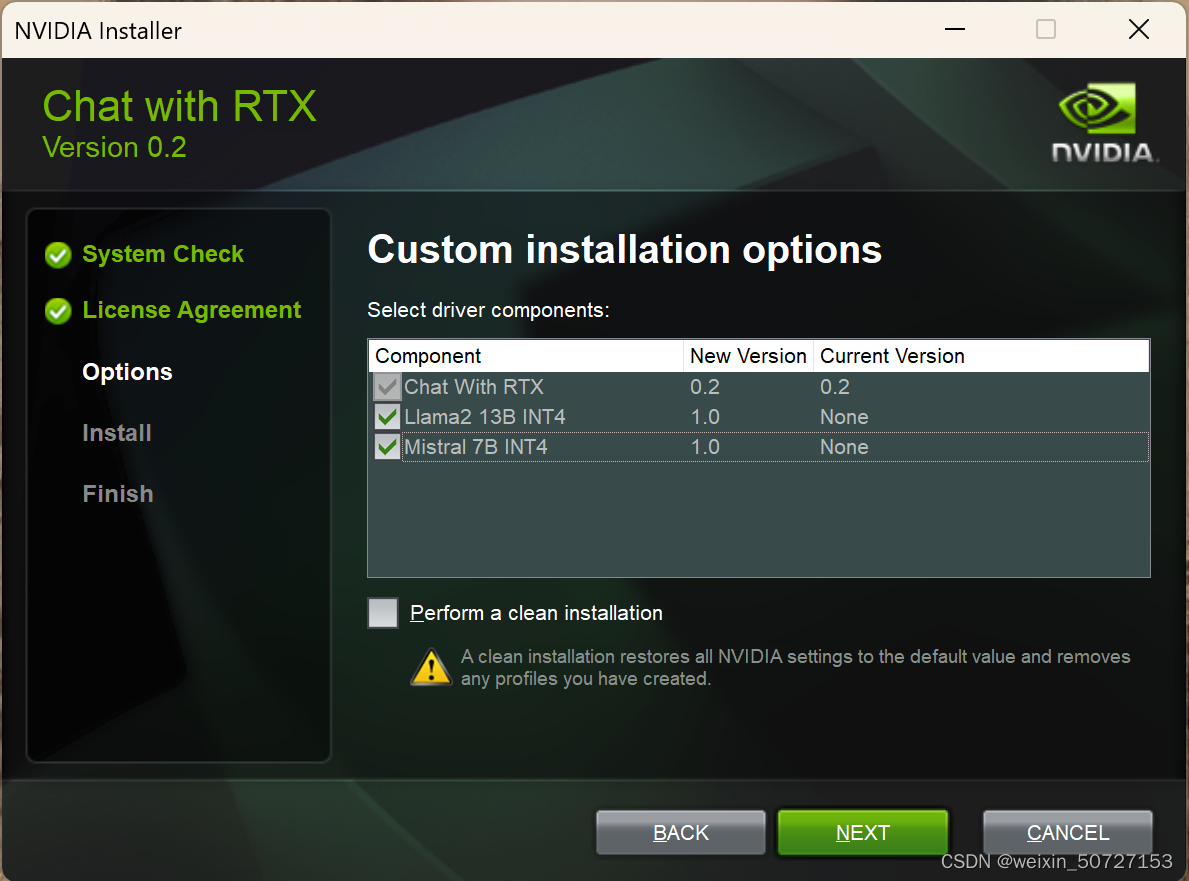

- 点击

setup.exe执行安装

-

选择默认的所有模型

-

按照默认选项一步步安装即可

-

安装完成后,双击桌面图标启动Chat with RTX

3.NVIDIA Chat with RTX使用演示

3.1. Folder Path:支持多种文件格式,包括文本、pdf、doc / docx 和 xml

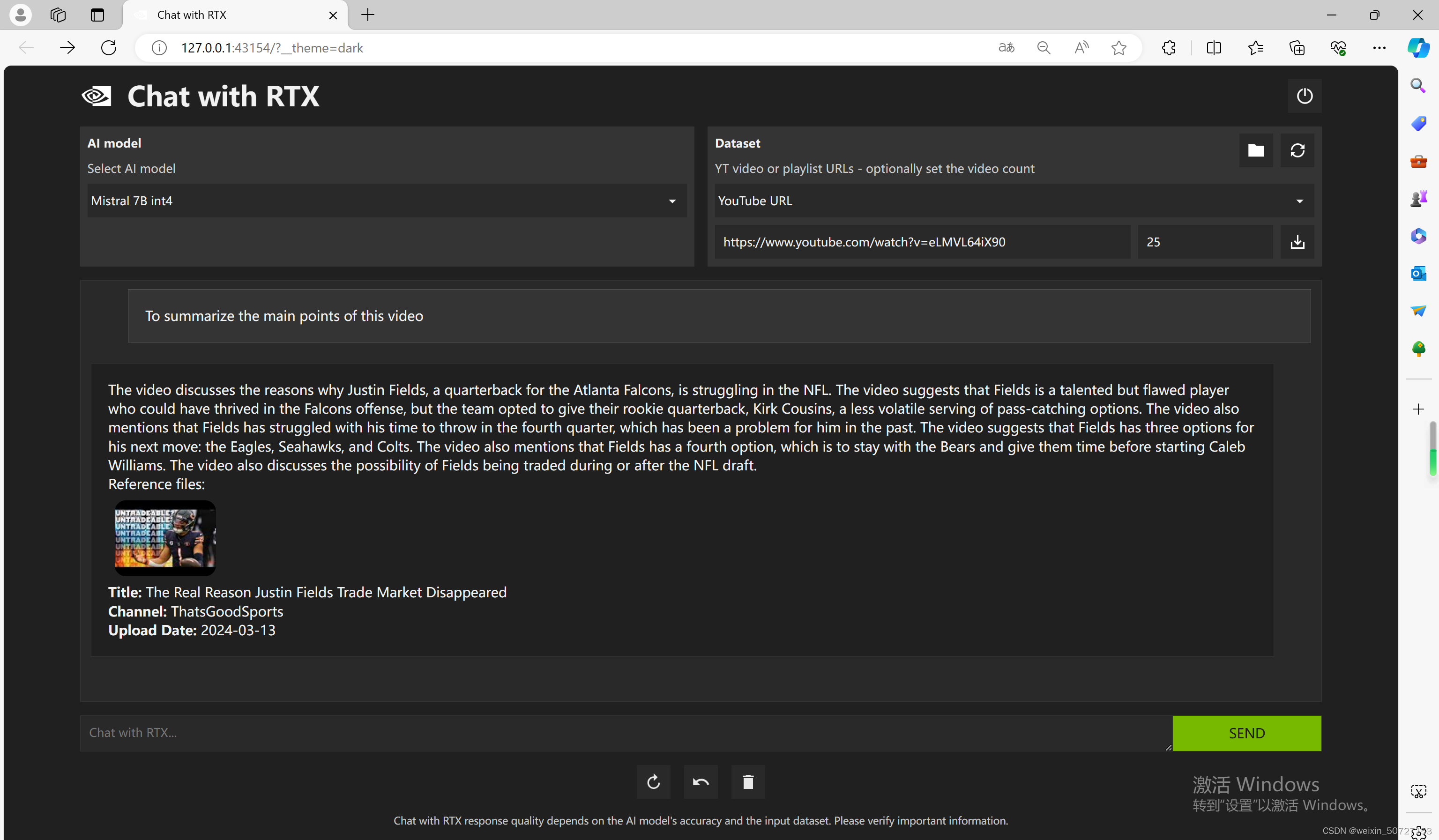

3.2. YouTube URL:提供 YouTube 播放列表的 URL,该应用程序将加载播放列表中视频的转录,使用户能够查询它们涵盖的内容。

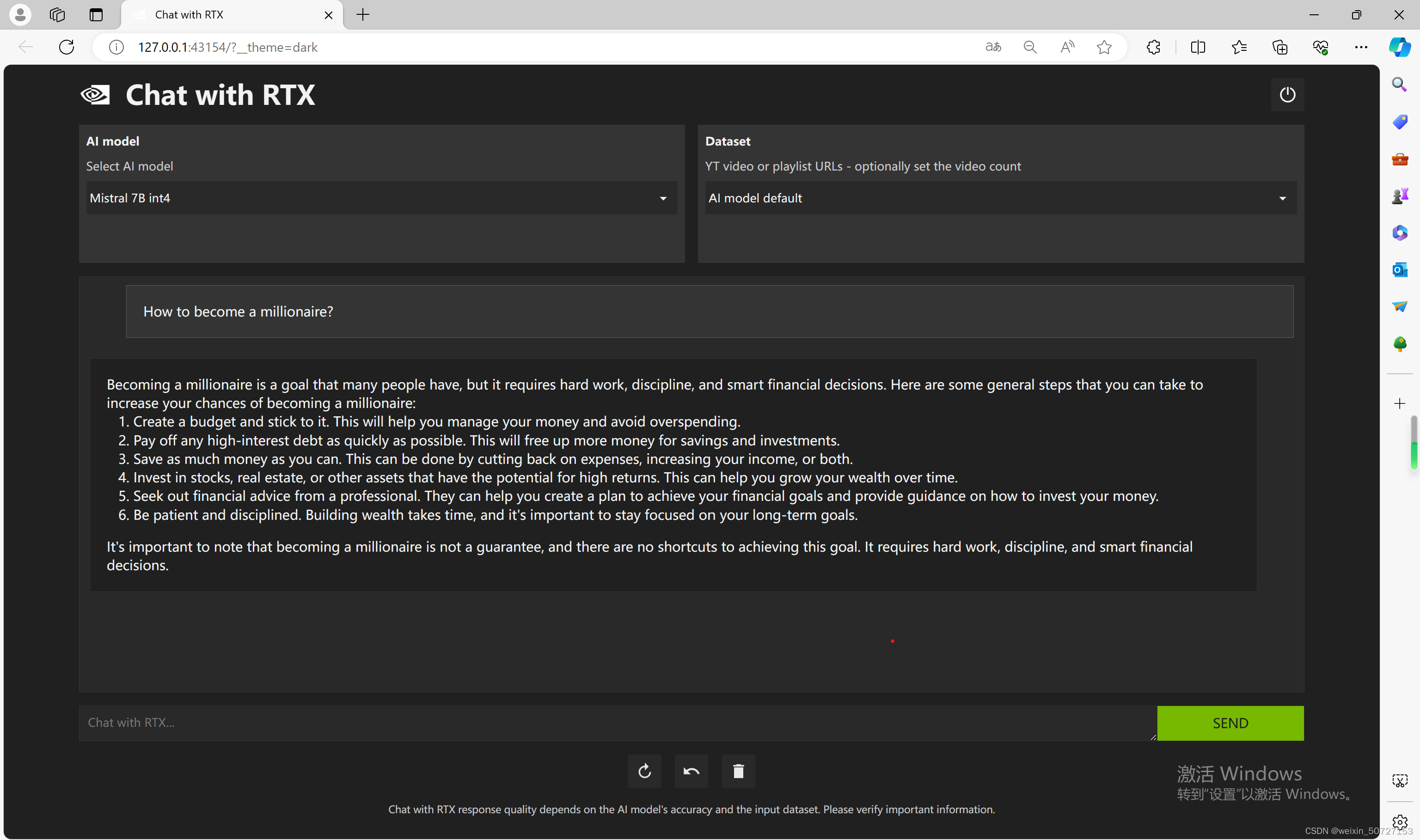

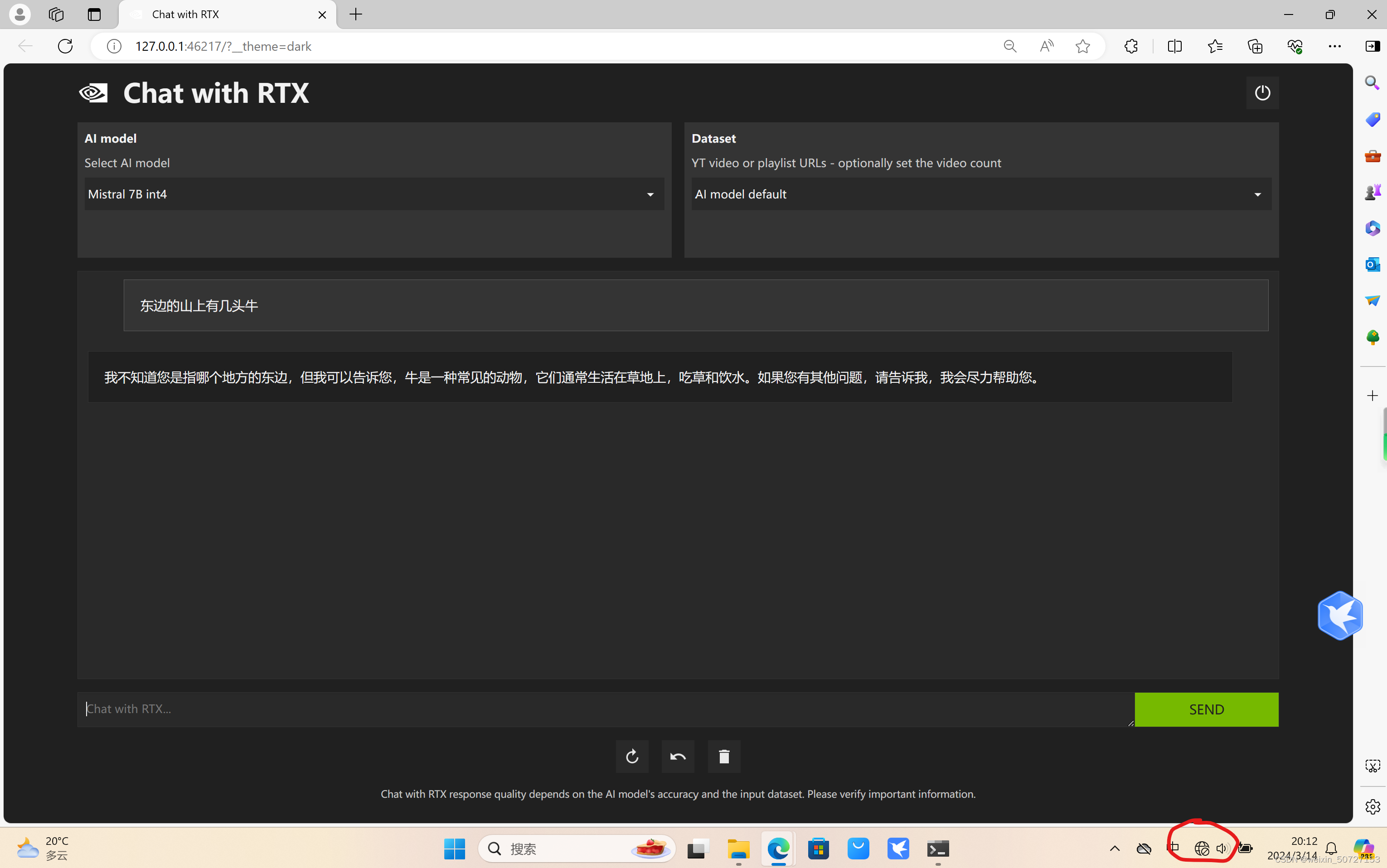

3.3. AI model default:使用安装的默认模型,进行本地会话问答

4.NVIDIA Chat with RTX离线运行

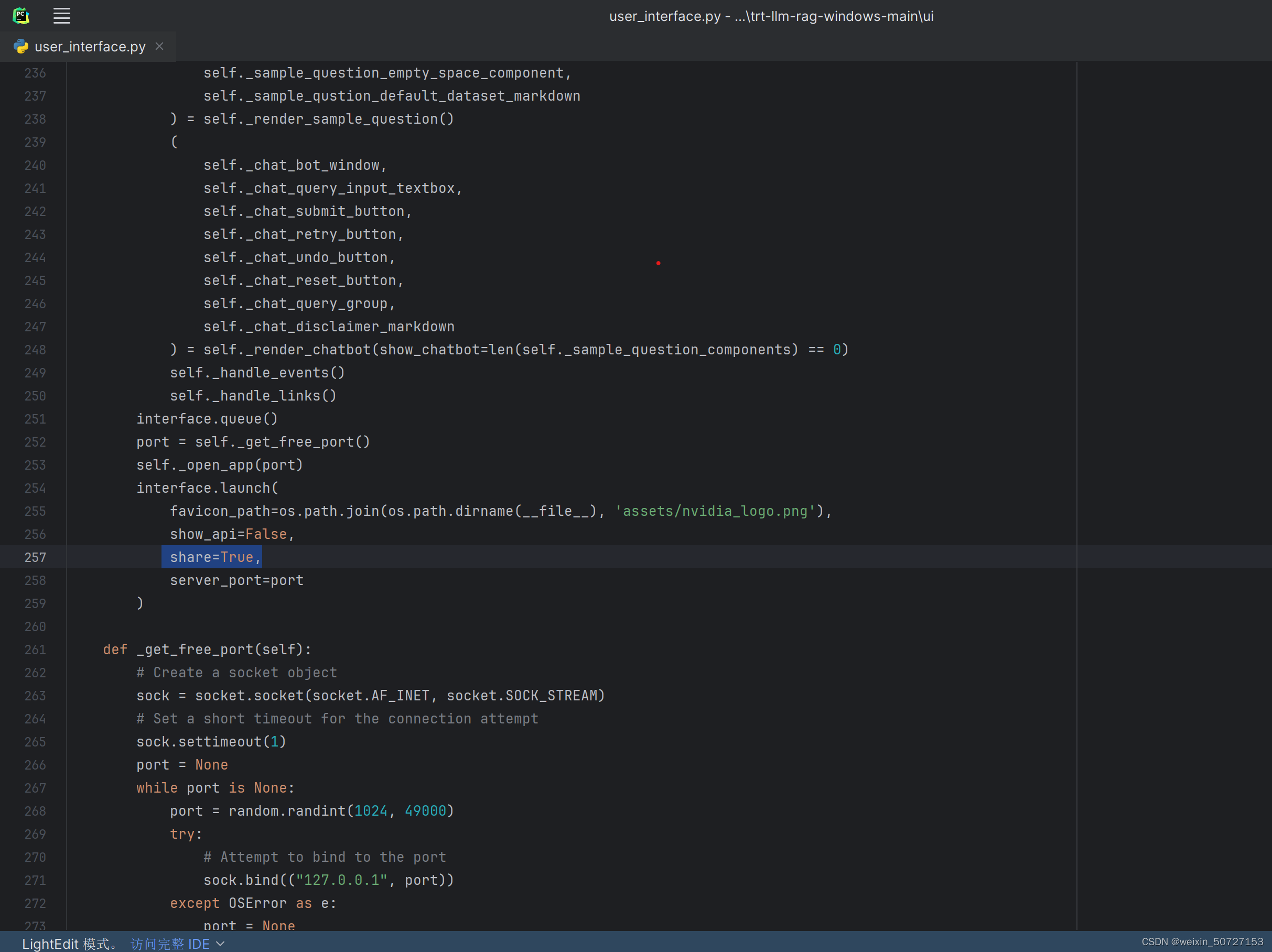

4.1 修改user_interface.py文件

打开文件安装目录(需要注意的是使用自己电脑的目录):

在C:\Users\SKU52\AppData\Local\NVIDIA\ChatWithRTX\RAG\trt-llm-rag-windows-main\ui路径下有一个user_interface.py文件, 直接打开, 并找到257行左右的位置,在interface.launch函数里加上share=True, 如下图所示:

在这里插入图片描述

4.2 下载UAE-Large-V1

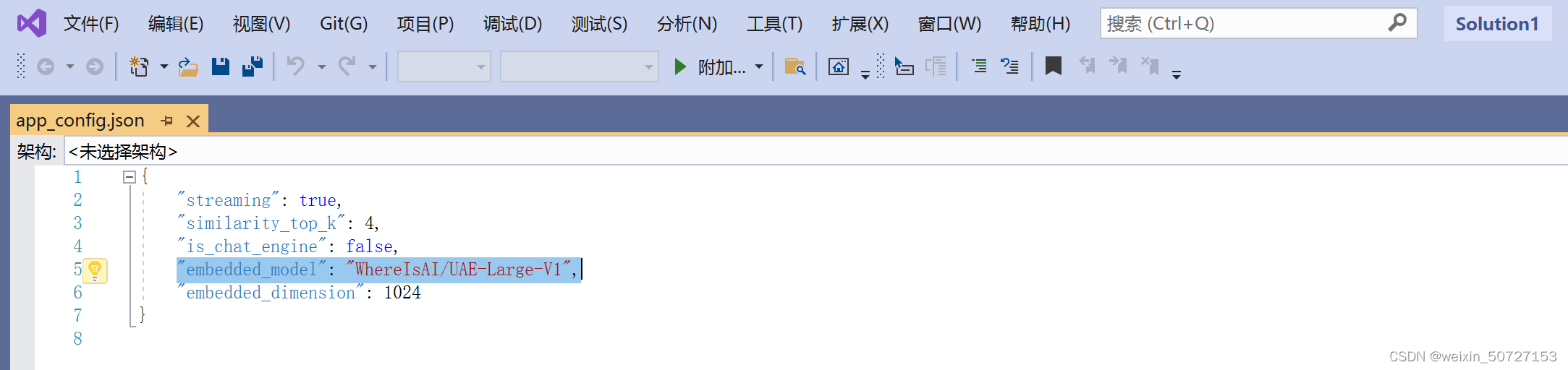

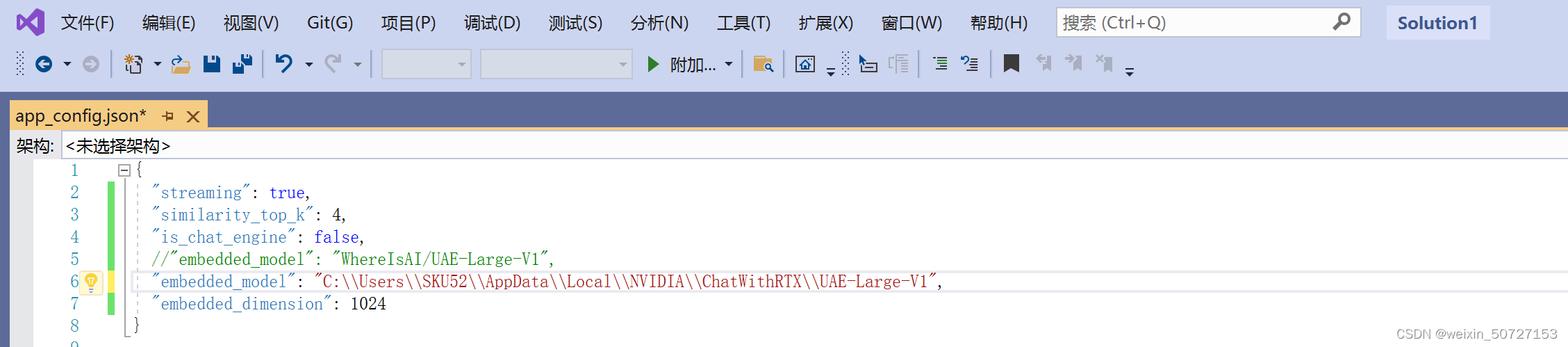

4.2.1 当启动Chat With RTX时候, 需要联网的原因应该是是它需要从huggingface上加载一个文件,详见配置文件:C:\Users\SKU52\AppData\Local\NVIDIA\ChatWithRTX\RAG\trt-llm-rag-windows-main\config\app_config.json

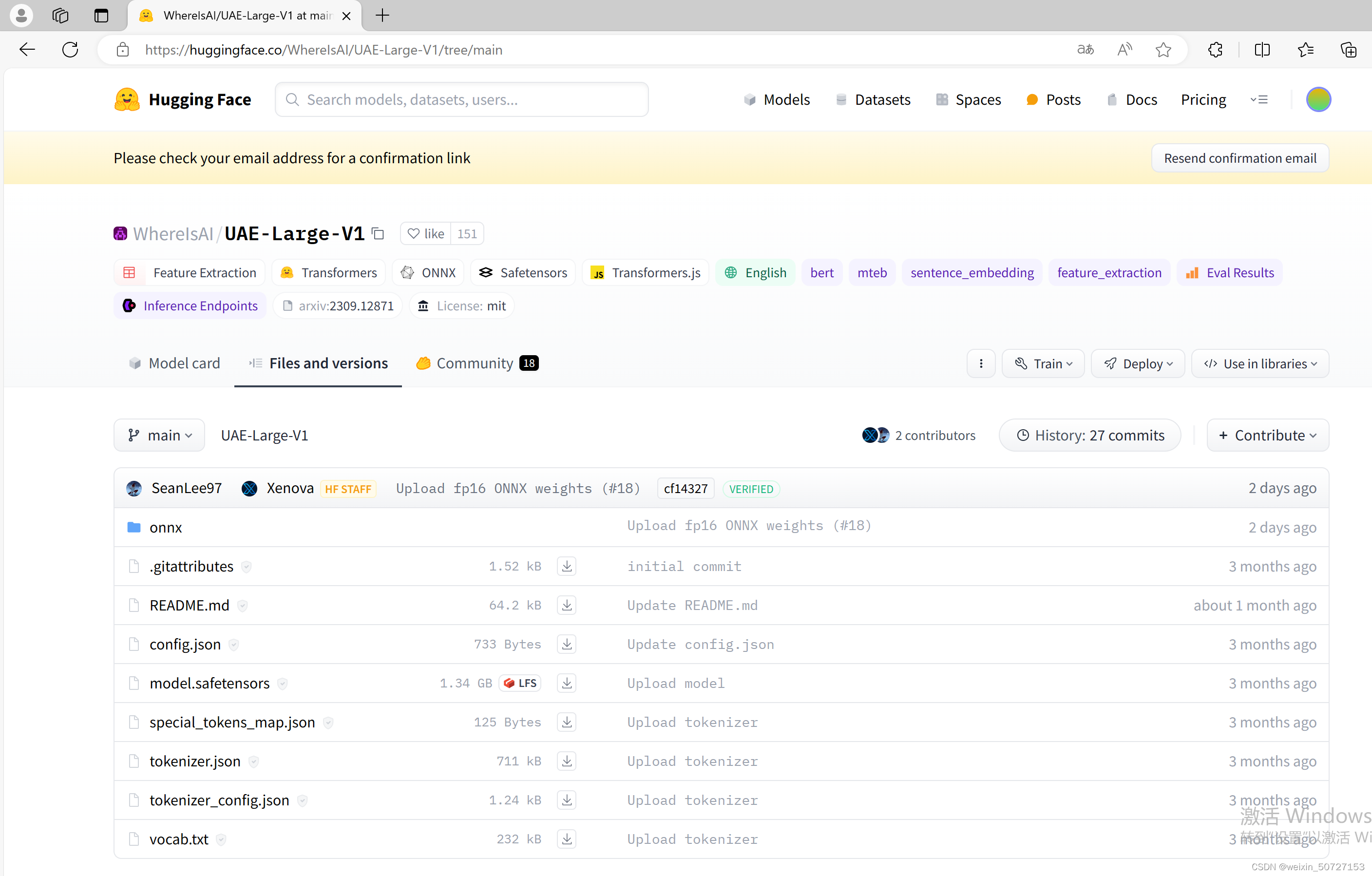

4.2.2 这里会去找"WhereIsAI/UAE-Large-V1"这个embedding模型,我们直接通过KeXue上网去Huggingface中下载即可(注意此目录下文简都要下载)

下载地址:UAE-Large-V1下载链接

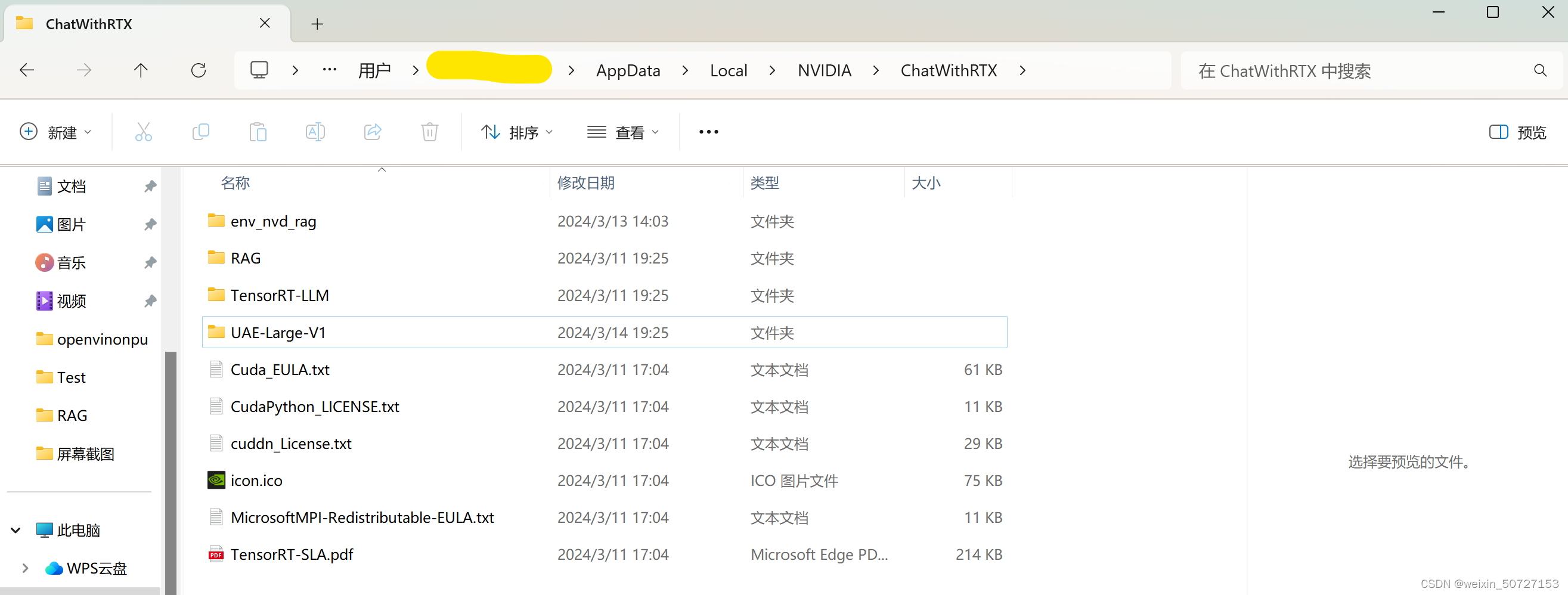

4.2.3 将下载好的UAE-Large-V1文件夹放到指定文件夹(为了管理方便,我将其放在了Chat with RTX安装目录下,如下图)

4.2.4 修改app_config.json文件,使用实际路径,记得路径分割符为 \\

4.2.5 保存以上修改,重新NVIDIA Chat with RTX,此时不联网就可以打开了,哈哈哈!

5.后记

5.1. 此模型下载后,默认会有两个模型, 一个是LLama2, 一个是Mistral,都是欧美模型,虽然支持中文,但使用英文做问答会更准确;如果要解决这个不足,可以去添加国内模型,如Baichuan、ChatGLM等

5.2. 该模型采用的是Llama-Index框架,不支持对同一个问题的多次深层追问

5.3. 该模型当前只具备推理能力,无学习能力

6. 参考链接:

1.NVIDIA Chat With RTX安装使用教程:https://blog.csdn.net/kunhe0512/article/details/136246239

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)